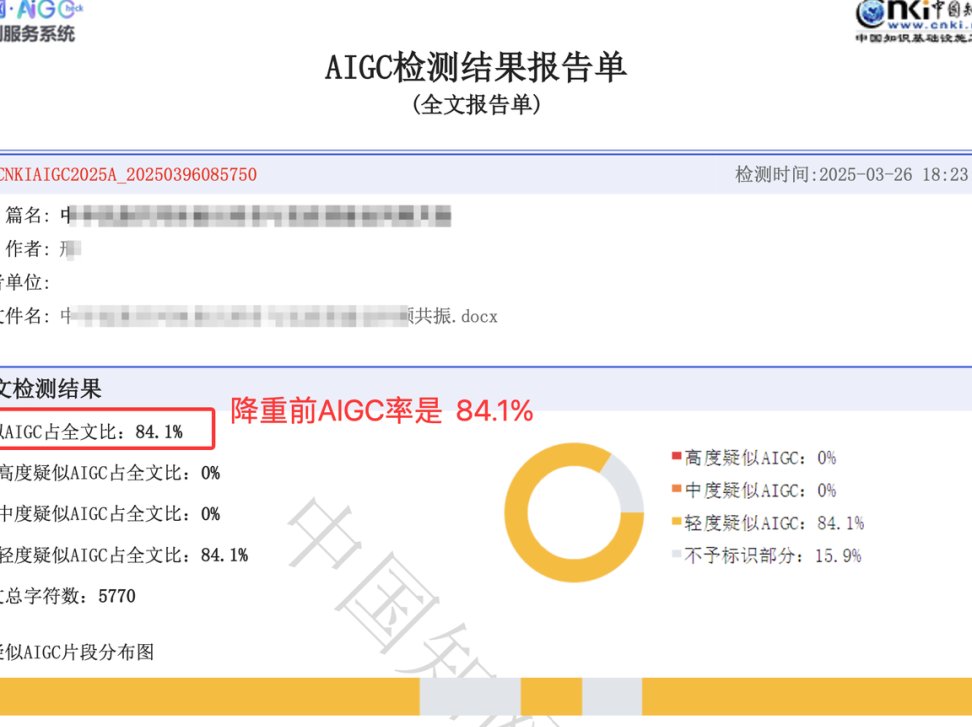

📌 AI 检测工具的底层逻辑到底是什么?

现在市面上的 AI 检测工具,原理大多是通过比对文本和已知 AI 模型生成内容的特征。它们会分析用词习惯、句式结构、逻辑连贯性,甚至是标点符号的使用频率。比如某款检测工具会统计 "因此" "然而" 这类连接词的出现比例,因为早期 GPT 模型很喜欢用这类词衔接句子。

但问题来了 —— 人类写作也有规律可循。职业作家往往有固定的句式偏好,学术论文里专业术语的密度也相对稳定。当这些人类特有的写作特征,和 AI 模型的生成特征重合时,误判就出现了。去年某高校的论文检测系统,就把一位历史系教授的手稿判定为 70% AI 生成,理由是 "长句比例过高,符合 GPT-3.5 的输出特征"。

更麻烦的是检测工具的数据库更新滞后。现在 AI 模型迭代速度太快,GPT-4 和 GPT-3 的写作风格已经有明显差异。但多数检测工具的比对样本,还停留在 2023 年甚至更早的 AI 生成内容。用旧标准衡量新内容,就像用旧地图找新路,不出错才怪。

🔍 那些被误判的人类创作者们

去年年底,某知名科技博主发过一条长文,吐槽自己的深度报道被平台判定为 AI 生成。他贴出的检测报告显示,文章中 "区块链" 和 "人工智能" 两个词的间隔分布,和某 AI 模型的训练数据高度相似。但熟悉他的读者都知道,这是他坚持了五年的写作习惯 —— 每 300 字必出现一次核心关键词。

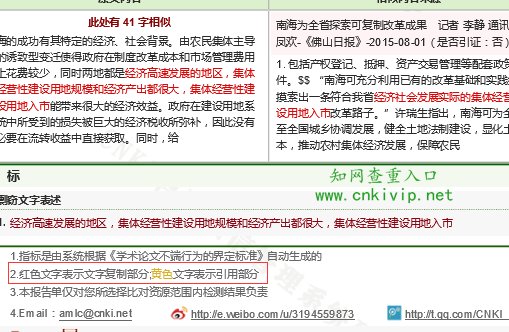

学术圈的误判案例更常见。某 985 高校的研究生告诉我,他们系里有位老师的专著,在知网的 AI 检测中通过率只有 62%。原因是这位老师习惯用 "首先分析... 其次论证... 最后总结" 的固定结构,而这种结构恰好和早期 AI 写作的逻辑模板高度重合。最后还是通过提交手写稿扫描件,才证明了原创性。

甚至连中学生都没能幸免。有家长在论坛发帖,说孩子的作文被老师怀疑是 AI 写的。作文里用了 "月光像碎银一样洒在地上" 这样的比喻,检测工具显示 "该比喻句式在 AI 生成内容中出现概率达 83%"。但实际上,这是孩子从课外读物里学来的写法,全班同学都用过类似的句子。

📝 语言结构相似性为什么会导致误判?

人类和 AI 在写作时,都会遵循语言本身的规律。比如中文里 "主谓宾" 的基本结构,英语里 "主系表" 的常见句式,这些都是语言自然演化形成的规则。AI 模型通过学习海量文本掌握了这些规则,人类则是通过教育和实践掌握的。当两者的表达方式撞车,检测工具就分不清谁是谁了。

专业领域的写作尤其容易出问题。法律文书必须用严谨的句式,医学论文需要精准的术语搭配,这些都是行业规范要求的。某检测工具曾把一份法院判决书判定为 AI 生成,理由是 "法律术语的使用密度异常均匀"。但稍有法律常识的人都知道,判决书的格式和用词必须保持一致,这是基本要求。

还有一种情况是写作风格的巧合。有些作家偏爱简洁的短句,比如海明威的风格;有些则擅长复杂的长句,比如福楼拜。当某位作家的风格,恰好和某款 AI 模型的训练目标相似,就很容易被误判。去年有位科幻作家的作品,被检测工具标为 "90% AI 概率",只因他习惯用 "在未来的某一天" 作为段落开头 —— 而这正是某款科幻写作 AI 的默认开场白。

💡 误判背后的行业隐忧

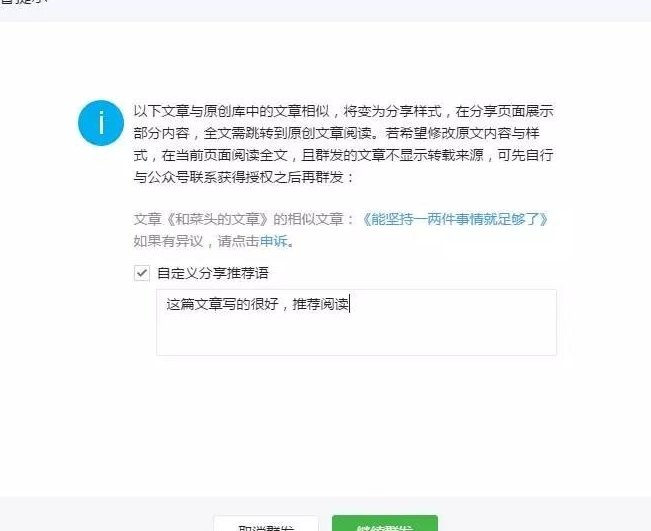

对内容平台来说,误判可能导致优质内容被埋没。现在很多自媒体平台都用 AI 检测作为内容审核的第一道关卡,一旦判定为 AI 生成,要么限流要么下架。某美食博主花了三个月走访各地小吃摊写出的系列报道,就因为 "描述性词汇的分布符合 AI 特征" 被平台限制传播。等他申诉成功,热度早就过去了。

对创作者而言,误判带来的是信任危机。一位出版社编辑告诉我,现在投稿时作者必须附上 AI 检测报告,通过率低于 90% 的直接退稿。但有位老作家的手稿,因为字迹潦草被扫描识别后,检测通过率只有 75%。出版社虽然最终相信了作者,但整个审核流程拖了整整两个月。

教育领域的误判影响更深远。越来越多的学校用 AI 检测工具筛查学生作业,一旦被判定为 AI 生成,可能会被认定为作弊。有位高中语文老师发现,班里写作最好的几个学生,检测通过率反而最低。深入研究后才发现,这些学生大量阅读经典名著,写作风格接近 AI 模型学习的 "优质文本" 特征,反而被当成了 AI 生成。

🔧 如何降低被误判的概率?

对普通创作者来说,最简单的办法是刻意打破一些 "AI 式" 的写作习惯。比如少用 "综上所述" "由此可见" 这类总结性短语,这些词在 AI 生成内容中出现的频率确实高于人类自然写作。可以换成更口语化的表达,比如 "这么看来" "说白了",既不影响意思,又能降低被误判的概率。

写作时加入一些个人化的细节也很有效。AI 模型擅长写通用内容,但对具体的个人经历描述往往不够生动。比如写旅行见闻,多加入 "那家小店的老板娘总爱在记账本上画笑脸" 这类细节,检测工具就很难把它归为 AI 生成 —— 因为这类个性化内容很难出现在训练数据里。

分段方式也有讲究。AI 生成的文本,段落长度往往比较均匀,这是算法追求 "最优分布" 的结果。人类写作则更随性,有时一句话就是一段,有时几百字才分段。有意识地调整段落长度,比如在情感表达强烈的地方单独成段,也能减少误判。

📈 未来的技术会走向何方?

现在已经有团队在研发更智能的检测技术。某 AI 公司推出的第二代检测工具,不仅分析文本特征,还会结合作者的历史作品建立个人风格模型。比如某位作者过去五年的文章里,"的" 字出现的频率一直维持在 3.2% 左右,突然某篇涨到 5% 就会被重点核查,而不是直接判定为 AI 生成。

跨模态验证可能是另一个突破方向。把文本和作者的创作过程结合起来分析,比如通过键盘输入记录判断打字节奏,通过修改痕迹分析思考过程。AI 生成的内容往往一气呵成,人类写作则会有大量修改。某写作平台已经开始测试这种技术,误判率据说降低了 60% 以上。

但技术再进步,也不可能完全消除误判。语言本身就在不断演化,AI 模型和人类写作的边界会越来越模糊。或许未来我们不需要纠结 "是不是 AI 写的",而是更关注 "写得好不好"。毕竟,判断一篇文章的价值,最终还是要看内容本身,而不是它的创作方式。