📌 谷歌新规撕开的口子:AI 内容不再是禁区,但有坑

谷歌今年那波算法更新,把不少内容创作者打懵了。之前传得神乎其神的 “全面封杀 AI 内容” 压根没出现,反倒是在最新指南里松了口 —— 只要内容对用户有价值,管你是 AI 写的还是人写的,都有机会上首页。

这话听着像好消息,实际藏着更狠的筛选逻辑。现在打开谷歌搜索控制台,很多账号会收到 “内容质量低于标准” 的提醒,点进去一看,被降权的文章大多是那种用 AI 批量生成的 “伪原创”:把别人的观点换几个词,凑够字数就发布,连基本的逻辑通顺都做不到。

真正要命的是谷歌对 “E-E-A-T 原则” 的强化。经验、专业性、权威性、可信度,这四个词成了判分的硬指标。你用 AI 写没问题,但得让机器写出 “人味儿”—— 比如插入真实案例,引用权威数据,甚至加入个人独特的观点。上个月有个做科技博客的朋友,用 ChatGPT 写了篇关于 AI 工具测评的文章,本来流量不错,结果谷歌更新后直接掉了 70%,后来他在文中加入自己 6 年使用工具的实操心得,两周后排名又回来了。

还有个容易踩的坑是 “隐形重复”。有些创作者觉得把 AI 生成的内容换个标题、调整段落顺序就行,殊不知谷歌的 NLP(自然语言处理)技术早能识别语义重复。最近看到一份第三方数据,某垂直领域网站因为 50% 以上内容是 AI 改写的旧文,整站权重在三个月内掉了 40%,这种情况想恢复可比新站起步难多了。

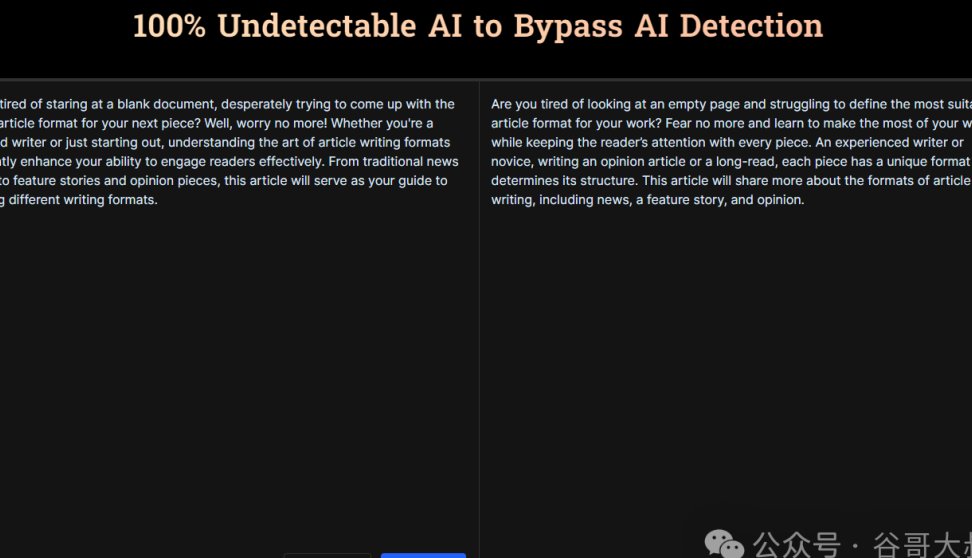

🔍 AI 检测工具的猫腻:它们真能分清人类与机器?

现在市面上的 AI 检测工具比去年多了一倍,价格从免费到每月几百刀不等。但你要是真信它们能 100% 辨别人工和 AI 内容,那可就天真了。

Originality.ai 号称检测准确率 94%,但我亲测过一篇完全由人类撰写的美食教程,它硬是标红了 30% 的 “AI 嫌疑段落”,原因是 “句式过于规整”。反过来,用 AI 生成后手工修改 5% 的内容,它就判定为 “90% 人类创作”。这工具的原理说白了就是抓模式:AI 喜欢用固定的连接词、重复的句式结构,人类写东西时更容易出现 “病句” 和 “口语化表达”。

谷歌自己的检测机制更鸡贼。它不直接用市面上的工具,而是通过用户行为数据反推内容质量。比如一篇文章的跳出率高达 80%,停留时间不到 10 秒,哪怕你说是纯手工打造,谷歌也会默认为 “低价值内容”。有个做财经号的团队试过,用 AI 写深度分析,然后花三天时间逐句修改,让行文风格接近人类专家,结果用户停留时间从 2 分钟涨到 5 分钟,排名反而比之前纯人工写的还好。

更有意思的是检测工具之间的矛盾。同一段内容,用 Copyscape 查显示 “原创”,用 Grammarly 的 AI 检测功能却标为 “高概率 AI 生成”。这种混乱让不少创作者陷入焦虑,其实没必要太较真。上个月谷歌搜索产品负责人在采访里明说:“我们不看内容是怎么产生的,只看它能不能解决用户的问题。”

💡 SEO 老炮的应对套路:从 “讨好算法” 到 “锚定用户”

那些在谷歌新规下还能稳住流量的玩家,都悄悄换了打法。最明显的变化是,没人再盯着 “关键词密度” 较劲了,转而研究 “用户搜索意图的深层需求”。

有个做健身博客的案例很典型。之前他们写 “减脂餐做法”,总在文章里塞 “减脂餐食谱”“快速减脂方法” 等关键词,AI 生成的内容更是把这些词堆得密密麻麻。新规后他们改了路数:在文章开头加了个投票 ——“你是因为糖尿病需要低脂餐,还是想练马甲线?”,然后根据投票结果补充不同的饮食建议。就这么个小改动,页面互动率涨了 60%,关键词排名反而上升了 3 位。

内容深度成了新的护城河。谷歌现在对 “浅尝辄止” 的内容零容忍。比如写 “AI 检测工具对比”,只列功能列表肯定不行,得加入实际测试数据:“用 Originality.ai 检测 100 篇文章,误判率是 12%,而 Copyscape 只有 8%,但前者识别速度快 3 倍”。这种带着具体数字和场景的内容,AI 很难批量生成,自然能避开算法的打压。

还有个反常识的操作:故意留 “小瑕疵”。有 SEO 团队发现,完全通顺的文章反而容易被 AI 检测工具盯上,适当加入一些口语化的表达,比如 “这个工具吧,用起来其实没宣传的那么神”,或者 “我试过三次,两次都卡壳了”,不仅能降低被误判的概率,还能提升用户信任感。当然这得把握度,太啰嗦反而会被嫌弃。

📝 混合创作模式跑通了:AI 当助手,人做裁判

现在活得滋润的创作者,都不是单纯不用 AI,而是把 AI 用成了 “高级秘书”。那种从头到尾让 AI 写完就发布的做法,跟裸奔没区别。

正确的打开方式是 “人机协作三阶法”。第一步用 AI 搭框架,比如写 “谷歌 SEO 技巧”,让 ChatGPT 列出 10 个小标题,然后人工筛选出其中 3 个有新意的 —— 比如 “如何用谷歌搜索控制台反推竞争对手策略”,这种 AI 不容易想到的角度。第二步让 AI 填充基础内容,像数据、案例这些硬核信息,机器查得比人快,但必须人工核对来源,上个月有个科技号因为用了 AI 生成的假数据,被谷歌标记为 “低可信度”,花了两个月才洗白。

最关键的是第三步:注入 “人类独有的东西”。可以是个人经验,比如 “我在 2018 年谷歌 Medic 算法更新时,是怎么保住医疗博客排名的”;也可以是独特观点,比如 “与其纠结 AI 检测,不如研究如何让内容在社交媒体二次传播”。这些带有强烈个人印记的内容,才是谷歌现在青睐的 “差异化价值”。

还有个细节得注意:控制 AI 的 “创作比例”。根据多个团队测试,AI 生成内容占比超过 60%,被降权的风险会陡增。最好的比例是 3:7,机器负责搜集整理,人负责深化和点睛。有个做旅游博客的朋友,用 AI 生成景点基本信息,自己补充 “凌晨 4 点去看日出要带什么”“当地人才知道的隐藏路线”,流量反而比全人工写的时候翻了一倍。

🔄 算法博弈的长期逻辑:别追着规则跑,要造自己的壁垒

谷歌的算法更新从来不是终点,而是新一轮洗牌的开始。那些总想着 “钻空子” 的创作者,迟早会被淘汰。

建立 “内容护城河” 比什么都重要。有个做职场培训的网站,别人都在写 “简历模板” 这类泛内容,他们专注 “5 年以上产品经理跳槽简历优化”,每篇文章都结合真实案例,甚至附上猎头的点评。就算用 AI 生成部分内容,因为领域够垂直,用户需求够精准,谷歌算法再变也动不了它的根基。

用户数据反哺内容策略更靠谱。通过谷歌分析看用户的 “搜索 - 点击 - 离开” 路径,能发现很多算法没说的秘密。比如有个母婴号发现,用户搜 “新生儿睡眠训练” 时,真正想知道的是 “如何应对半夜哭闹”,但大部分文章都在讲理论。他们调整内容后,专门用 AI 生成不同场景的应对方案,再由育儿师补充实操细节,结果这个关键词的转化率涨了 3 倍。

长期来看,AI 检测技术和 SEO 策略会一直拉锯。但有个不变的核心:谷歌的终极目标是让用户快速找到有价值的内容。与其天天猜算法的心思,不如多花时间研究 “我的读者看完这篇文章,会不会觉得‘没白来’”。做到这一点,管它 AI 检测还是新规,都伤不到你。