现在做模型训练的人越来越多,但有个坑很多人第一次踩的时候都反应不过来 —— 你辛辛苦苦收集的训练数据里,可能混了大量 AI 生成的 “垃圾”。这些数据看起来跟真的一样,标注也齐全,可一旦喂给模型,结果往往是精度断崖式下跌,甚至训练出的模型会产生完全离谱的输出。这不是危言耸听,去年某大厂的图像识别模型就是因为用了包含 30% AI 生成图的数据集,导致实际应用时把猫识别成狗的概率飙升到 27%,最后整个项目回炉重造,光人力成本就亏了七位数。

📌 先搞清楚:AI 生成数据到底藏着哪些陷阱?

最常见的是 “逻辑闭环陷阱”。AI 生成数据时,本质上是在模仿已有数据的规律,比如你用一万篇科技论文训练出的文本生成模型,它产出的新论文看起来术语准确、结构完整,但仔细看会发现,里面的实验数据推导过程存在隐蔽的逻辑循环 —— 前面用 A 推导 B,后面又用 B 证明 A,人类审稿可能要花半小时才能发现,模型却会把这种错误当成 “正确模式” 学进去。

还有 “分布偏移陷阱”。真实数据的分布往往是不均匀的,比如用户评论里正面评价占 60%,负面占 30%,中性 10%。但 AI 生成时如果没有严格控制比例,很可能生成的负面评论只占 10%,而且用词极端化。用这种数据训练情感分析模型,上线后面对真实用户的负面反馈,识别准确率能跌一半。

更麻烦的是 “特征污染陷阱”。有些 AI 生成工具会在数据里留下独特的 “指纹”,比如某款文本生成器总爱用 “综上所述” 作为段落结尾,某图像生成工具在暗部会留下特定的噪点模式。模型训练时会把这些无关特征当成重要信号,导致模型只能识别 “AI 生成的数据”,对真实数据反而不敏感。

🔍 数据过滤助手的核心价值:不是 “打假”,是 “适配”

很多人以为数据过滤就是把 AI 生成的全删掉,这其实是误区。优质的 AI 生成数据在特定场景下是有用的,比如稀缺领域的补充数据。数据过滤助手真正的作用,是帮你判断 “这些数据是否适合当前的训练目标”。

它能做到人类做不到的事情:用毫秒级速度扫描百万级数据,同时分析三个维度 —— 数据的生成熵值(AI 生成数据的熵值通常比真实数据低 15%-30%)、特征一致性(真实数据的特征波动更自然)、逻辑自洽度(通过知识图谱验证数据内部逻辑)。某自动驾驶公司用了过滤助手后,发现原本准备的 50 万张道路图像里,有 12 万张是 AI 生成的,其中 8 万张因为路灯位置和影子方向矛盾被直接剔除,剩下 4 万张经过修正后才纳入训练,最终模型的障碍物识别准确率提升了 19%。

更关键的是,它能标注 “可修复数据”。比如一段 AI 生成的用户对话,虽然整体逻辑有问题,但其中 50% 的句子符合真实表达习惯,过滤助手会把这些句子提取出来,标记需要人工补充上下文,比直接全删节省 60% 的数据成本。

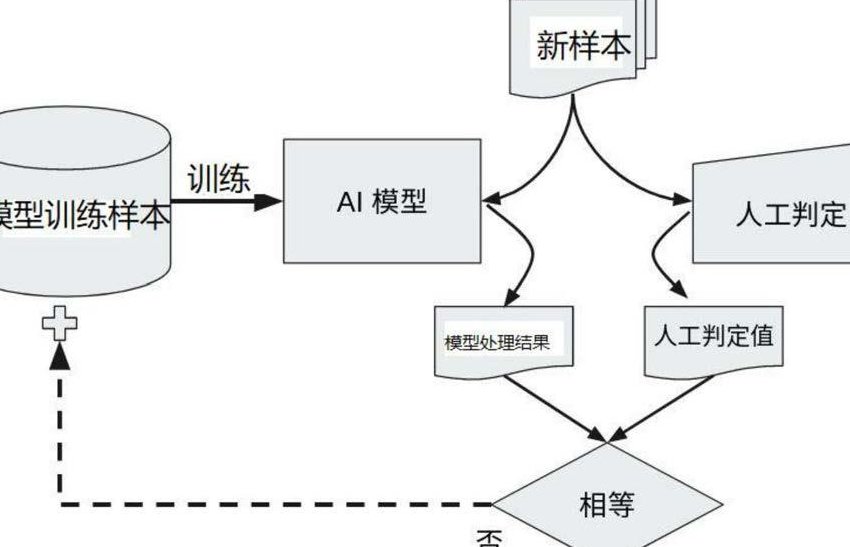

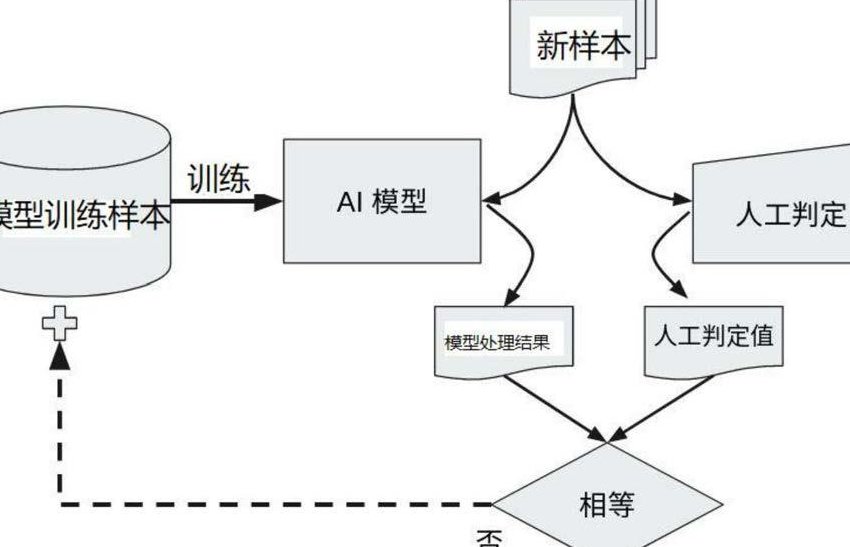

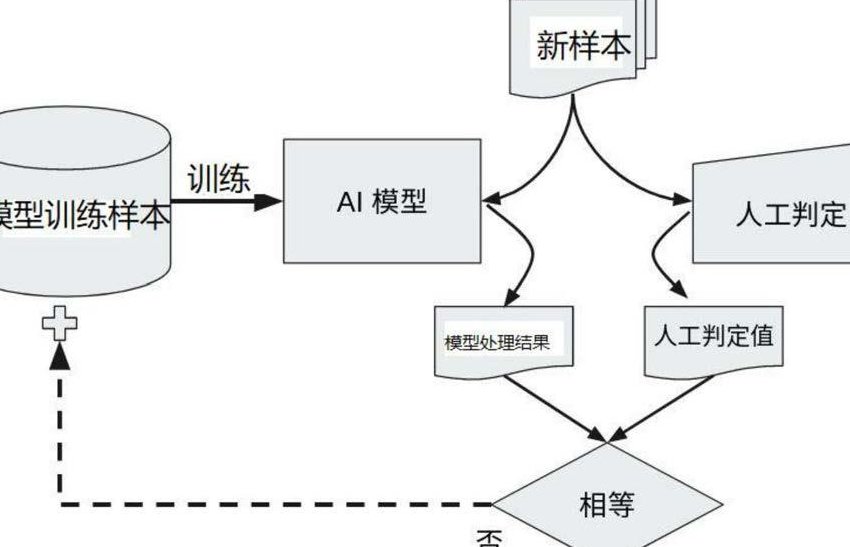

⚙️ 看懂工作逻辑:为什么人类筛不出来的,机器能筛?

数据过滤助手的底层逻辑不是简单比对 “AI 生成特征库”,而是建立 “真实数据基线”。它会先学习你提供的少量优质真实数据(最少 500 条),提取出这些数据的统计学特征 —— 比如文本的平均句长波动范围、图像的像素分布规律、表格数据的异常值出现概率等。

然后用这个基线去对比待检测数据。举个例子,真实的医疗诊断文本中,“高血压” 和 “糖尿病” 同时出现的概率是 32%,但某 AI 生成器产出的文本里这个概率高达 78%,明显偏离基线,就会被标记为高风险。

它还能识别 “隐形重复”。人类很容易发现完全相同的数据,但 AI 生成的 “近义词替换重复” 很难察觉。比如 “用户点击了首页按钮” 和 “访客按下了主页按键”,看起来不同,实则语义重复。过滤助手通过语义向量计算,能把这种重复率控制在 3% 以内,而人工筛查的平均漏检率是 21%。

📝 实操时要注意这几点,不然等于白用

首先,必须用自己领域的真实数据做基线训练。别图省事用公开数据集的基线,比如做金融风控模型,就一定要用自己平台的真实交易数据训练过滤助手。某消费金融公司试过用公开的信贷数据集做基线,结果过滤后的训练数据里,仍有 17% 的 AI 生成数据 —— 因为不同平台的用户借贷表述习惯差异太大。

其次,设置动态阈值。不同场景对数据纯净度要求不同,图像生成模型可能允许 5% 的 AI 数据混入,但自动驾驶的决策数据必须是 100% 真实。过滤助手的阈值建议每周调整一次,随着真实数据积累增多,基线会更精准。

另外,别忽略元数据检查。很多人只看数据内容,其实 AI 生成数据的元数据藏着马脚 —— 比如图片的 EXIF 信息里,相机型号可能是虚构的;文本的创建时间戳,可能集中在某几个小时(真实数据的时间分布更分散)。过滤助手的元数据校验模块,能多拦截 15% 的漏网之鱼。

💡 这些隐藏优势,用过的人才知道

它能帮你发现数据收集流程的漏洞。比如连续三周检测出某渠道的数据源有大量 AI 生成数据,那很可能是这个渠道的爬虫被反爬机制诱导,爬取了 AI 生成的干扰数据,及时止损比后面返工强。

还能降低标注成本。过滤后的真实数据,标注效率会提升 40%—— 因为 AI 生成数据往往存在标注模糊的问题,比如一段 AI 生成的用户反馈,既像好评又像差评,人工标注时纠结半天还容易出错。

更重要的是,为模型可解释性打下基础。用纯净数据训练的模型,出错时能追溯到具体的真实案例,而混了 AI 数据的模型,错误原因往往是 “学了错误的模式”,根本说不清。

🚨 最后说个行业案例,警钟长鸣

某智能家居公司做语音控制模型时,因为赶进度没过滤数据,直接用了包含 20% AI 生成语音的数据集训练。上线后用户说 “打开客厅灯”,模型经常误触发 “关闭卧室窗帘”。后来用过滤助手重新处理数据,发现那些 AI 生成的语音里,“客厅” 和 “卧室” 的发音特征被错误关联了 —— 这就是典型的 AI 数据陷阱导致的模型错乱。重新训练花了两个月,错过当年的销售旺季,损失超千万。

现在模型训练卷得厉害,大家都在拼算法、拼算力,却往往忽略数据这个根基。数据过滤助手不是可有可无的工具,而是模型训练前的必做步骤。花一天时间过滤数据,能帮你省下后面数周的返工时间,这笔账很划算。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】