📊

数据质量是模型的生命线,别等训练崩了才后悔做模型训练的人,十有八九都踩过数据的坑。见过一个团队,花三个月训练的图像识别模型,到测试阶段才发现训练数据里混进了 20% 的错误标注 —— 把 "猫" 标成 "狗",把 "汽车" 标成 "自行车"。最后模型准确率卡在 60% 死活上不去,只能推倒重来。这事儿说出来都让人觉得可惜,但更可惜的是,这种问题本可以避免。

数据质量的影响远比想象中更致命。举个简单的例子,假设你要训练一个金融风控模型,数据里混进了 10% 的异常交易样本却没过滤,模型很可能会把正常交易误判为风险,直接导致用户流失。更麻烦的是,数据问题具有隐蔽性,很多时候模型效果差,你可能会先怀疑算法、参数或架构,绕一大圈才发现根源在数据。

现在行业里有个共识:模型性能的上限,其实是由训练数据的质量决定的。就算你用最先进的大模型架构,喂进去的是一堆充满噪声、重复或错误的数据,也很难训出好结果。而 AI 数据审核工具,就是在数据进入模型前筑起的第一道防线。

🔍

AI 数据审核工具到底能解决什么问题?有人觉得,人工审核数据不也行吗?确实行,但要看规模。当你的数据集达到百万级、千万级,人工审核的成本会陡增,而且人眼很容易疲劳,漏检率会直线上升。这时候 AI 数据审核工具的价值就体现出来了。

它能精准揪出数据里的 "老鼠屎"。比如文本数据里的重复内容 —— 同一篇文章被多次收录,只是改了几个词;图像数据里的模糊样本 —— 分辨率低于模型要求,根本提取不出有效特征;表格数据里的逻辑错误 ——"年龄" 字段出现负数,"收入" 字段和 "消费记录" 完全不匹配。这些问题,AI 工具能在几小时内完成全量检测,而人工可能需要几周。

更重要的是,它能发现人眼难辨的深层问题。比如自然语言处理任务中,某些文本看似正常,实则包含大量偏见性表述。用这种数据训练出来的模型,很可能会在实际应用中产生歧视性输出。AI 审核工具能通过语义分析,识别出这些隐藏的风险点,这可不是靠人工抽样能解决的。

📝

用 AI 审核工具的正确姿势,这几步不能省先明确审核目标。不同的模型任务,对数据的要求天差地别。训练推荐系统,要重点审核用户行为数据的时效性和完整性;训练医疗影像模型,得把数据标注的精确性放在第一位。所以在启动审核前,一定要根据模型的应用场景,列出核心的数据指标。比如电商推荐模型,可能需要关注 "用户点击记录的时间戳完整性"" 商品分类标签的一致性 " 等。

接着是设置合理的阈值。工具能检测出数据的各种指标,但最终哪些数据该保留、哪些该剔除,需要你根据实际情况定标准。比如文本重复率,完全零重复不现实,但超过 30% 就可能影响模型的泛化能力。这时候就得设置一个 "重复率>20% 即标记" 的阈值,让工具帮你筛选出可疑样本。

然后必须做人工复核。AI 工具不是万能的,尤其是在处理复杂语义或专业领域数据时,可能会出现误判。比如在法律文书数据审核中,工具可能会把一些专业术语误判为无效信息。这时候就需要领域专家对标记出的问题数据进行二次检查,避免误删有价值的样本。

最后别忘记录审核日志。每次审核的参数设置、问题数据类型、处理方式,都要详细记录下来。这些数据能帮你总结经验,下次再处理类似数据集时,就能快速调整审核策略,提高效率。

⚠️

这些坑千万别踩,多少人栽在这上面别迷信 "全自动"。有些团队图省事,直接让工具按默认参数跑完审核,然后就把过滤后的数据拿去训练。结果呢?要么过滤得太狠,把很多有价值的边缘数据删掉了,导致模型欠拟合;要么过滤得太松,漏了很多噪声数据,模型还是出问题。记住,工具是辅助,人的判断永远是核心。

别忽视数据分布的审核。很多人只关注数据的准确性,却忘了检查数据分布是否合理。比如训练一个识别 "四季花卉" 的模型,结果数据里 70% 都是夏季花卉,冬季花卉只占 5%。这种情况下,就算每个样本都准确无误,模型也会对冬季花卉的识别能力很差。AI 审核工具里一般都有数据分布分析功能,一定要用起来,确保数据在各个类别、维度上的分布符合实际场景。

别跳过小样本的审核。有些团队觉得,少量的问题数据对模型影响不大,没必要花时间处理。这种想法大错特错。模型训练就像盖房子,哪怕只有几块劣质砖,也可能导致整个结构不稳定。曾经见过一个语音识别模型,因为训练数据里混进了 1% 的低质量录音,结果在实际使用中,只要用户说话声音稍小,识别准确率就暴跌。

🔬

不同场景下的工具选择,别盲目跟风通用场景可以选开箱即用的工具。像针对文本、图像、表格的基础审核需求,市面上很多工具都能满足。比如百度的 EasyData、阿里的 DataWorks,内置了常见的数据质量检测模块,不需要太多定制化操作,适合中小团队快速上手。

专业领域得用垂直工具。医疗、金融这些领域的数据有特殊要求,通用工具可能 hold 不住。比如医疗数据审核,需要识别 DICOM 格式的影像是否符合诊断标准,这时候就得用像 3D Slicer 这种带医疗数据校验功能的专业工具。金融领域则要关注数据的合规性,工具得能检测出是否包含敏感信息,比如身份证号、银行卡号的脱敏是否彻底。

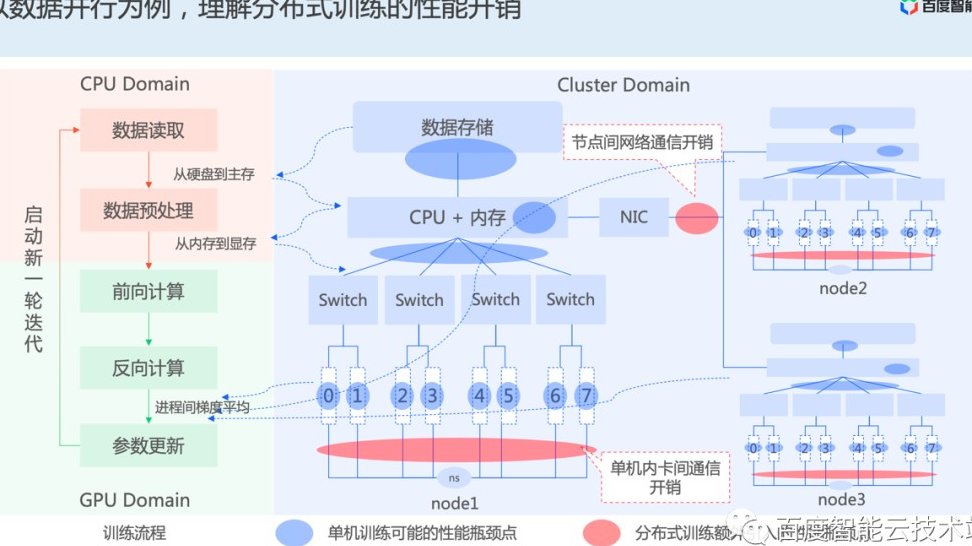

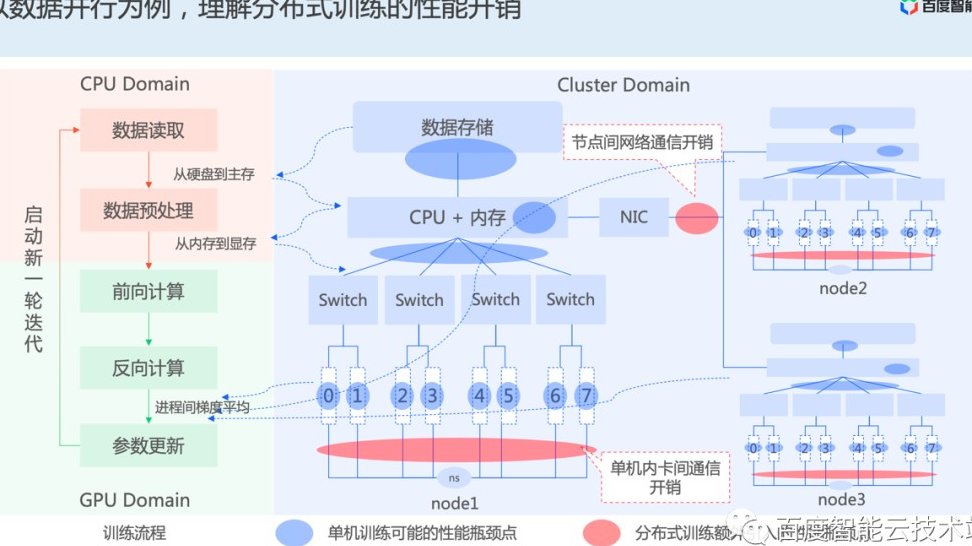

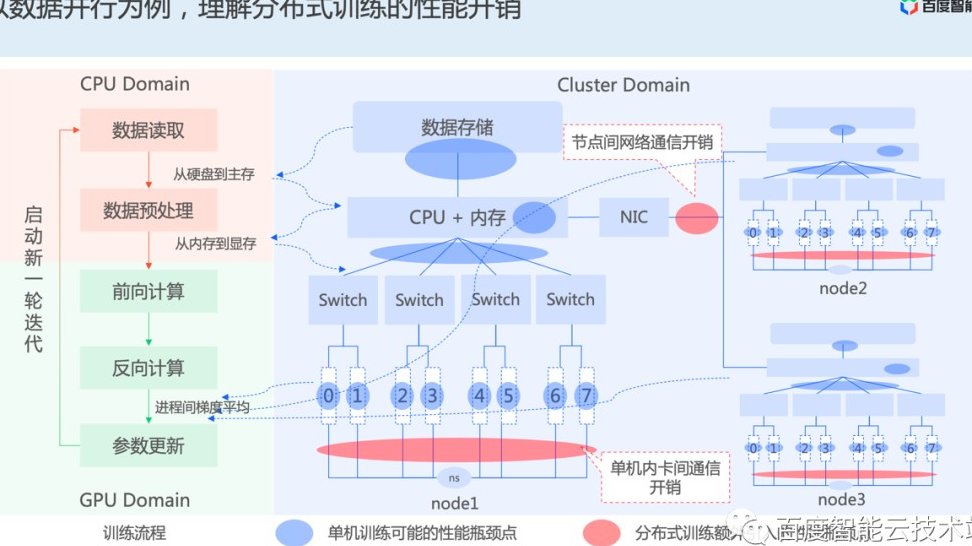

大模型训练建议用分布式审核工具。当数据量达到 TB 级甚至 PB 级,普通工具的处理速度会跟不上。这时候就得用支持分布式计算的工具,比如基于 Spark 架构的数据审核平台,能把数据拆分到多个节点并行处理,大大提高效率。

🚀

未来趋势:AI 审核工具会越来越 "聪明"现在的 AI 数据审核工具,已经开始向 "主动预防" 进化。以前是数据来了才审核,以后可能在数据收集阶段就介入 —— 比如爬虫工具在抓取数据时,就同步进行初步筛选,把明显不合格的数据直接过滤掉,从源头减少垃圾数据的产生。

另外,工具会越来越懂业务。通过和业务系统对接,审核工具能自动学习不同场景下的数据标准。比如电商平台的工具,会记住 "促销期间的用户行为数据和日常数据有哪些差异",不需要人工反复调整参数。

更重要的是,审核会和模型训练形成闭环。工具发现的数据问题,会自动反馈给训练系统,帮助调整模型的学习策略。比如发现某类样本经常出错,模型就会自动增加对这类样本的关注度。这种闭环能力,会让整个模型训练流程越来越高效。

说到底,用 AI 数据审核工具过滤数据,不是额外的负担,而是能帮你少走弯路的捷径。与其在模型训练失败后花几倍时间返工,不如一开始就把数据这关把好。现在行业竞争这么激烈,谁能在数据质量上领先一步,谁就能在模型性能上拉开差距。别再等了,下次训练模型前,先打开你的数据审核工具吧。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库