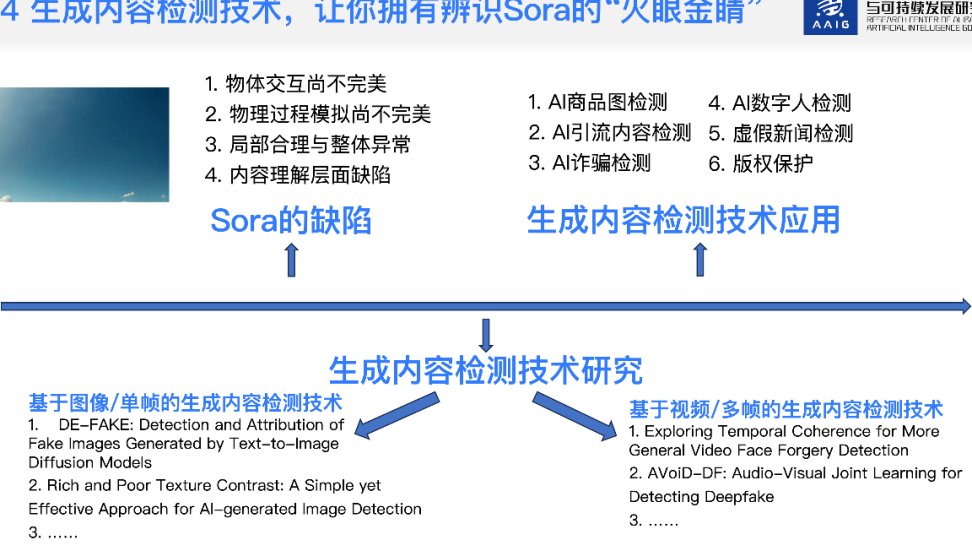

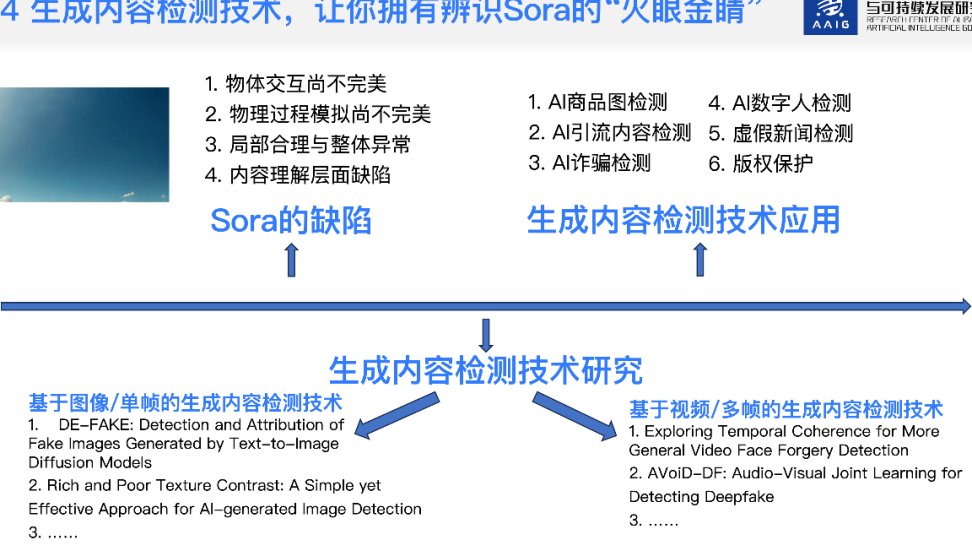

⚠️ Sora 掀起的内容狂潮:为什么传统审核体系正在失效?

OpenAI 的 Sora 横空出世后,整个内容创作领域彻底变天了。这个能生成超逼真视频的 AI 工具,让普通人也能随手做出电影级别的画面。但狂欢背后,内容审核团队却迎来了前所未有的噩梦。以前文字和图片审核就够头疼了,现在突然涌入海量高仿真视频,里面可能藏着虚假新闻、暴力画面、甚至深度伪造的人物肖像,传统审核手段根本跟不上节奏。

最棘手的是 Sora 生成内容的 **“以假乱真” 特性 **。它能精准模拟真实场景的光影、人物表情和物理运动,肉眼几乎看不出破绽。比如一段看似真实的 “新闻现场” 视频,可能是 AI 合成的虚假事件;一个明星的发言片段,实际是通过 AI 技术伪造的。这些内容如果传播开来,轻则误导公众,重则引发社会恐慌或名誉纠纷。更麻烦的是 Sora 的创作门槛极低,任何人都能快速生成内容,导致待审核内容量呈几何级增长,审核压力直接爆表。

更隐蔽的问题在于多模态内容的融合风险。Sora 不仅能生成视频,还能结合文本、音频形成完整的叙事链条。一段看似正常的视频,配上特定的文字描述或背景音乐,就能传递完全不同的隐含信息。传统审核工具大多针对单一模态设计,面对这种多维度融合的内容,很容易出现漏检情况。比如某个视频画面本身没问题,但结合字幕和配音后却隐含仇恨言论,这种 “组合拳” 式的内容陷阱,让审核难度陡增。

🔍 传统内容审核的三大死穴:为什么它们挡不住 AI 生成内容?

面对 Sora 引发的内容洪流,传统审核方式正在暴露越来越多的致命缺陷。首当其冲的是人力审核的效率瓶颈。过去图文时代,一个审核员每天能处理数千条内容,但到了视频时代,尤其是 Sora 生成的高清长视频,一个人一天能仔细核查几十条就不错了。按照 Sora 的内容产出速度,哪怕把审核团队扩大十倍,也追不上内容生成的速度,结果就是大量内容 “裸奔上线”,审核形同虚设。

技术层面的识别精度不足更让人头疼。传统 AI 审核工具主要依赖关键词匹配和简单图像识别,面对 Sora 生成的高逼真内容,这些方法就像用放大镜看显微镜下的细菌。比如 Sora 能生成画面合规但语义违规的内容 —— 表面是风景视频,实际通过镜头语言和剪辑传递不良价值观。这种 “明修栈道暗度陈仓” 的内容,传统工具根本抓不住。更麻烦的是 Sora 会不断升级迭代,生成的内容越来越难被识别,而传统工具的更新速度往往滞后几个月,永远慢半拍。

最致命的是多模态内容的协同攻击。现在的不良内容创作者已经学会 “钻空子”,把违规信息拆分到不同模态中。比如视频画面完全合规,但音频里藏着加密的不良指令,或者字幕中夹杂着隐晦的违规符号。传统审核工具大多单独处理视频、音频、文本,缺乏跨模态关联分析能力,导致这些 “拆分式违规” 内容轻易就能蒙混过关。某短视频平台的内部数据显示,采用传统审核系统后,AI 生成的违规内容漏检率高达 37%,比普通内容漏检率高出近三倍。

🚀 朱雀 AI 检测助手的破局思路:用 AI 对抗 AI 才是王道

面对 Sora 带来的审核危机,朱雀 AI 检测助手给出了不一样的解决方案 ——用更强大的 AI 技术对抗 AI 生成内容。它没有走传统工具 “被动防御” 的老路,而是构建了一套主动识别、精准定位的全新体系。核心逻辑很简单:既然 Sora 是 AI 生成的内容,必然会留下 AI 特有的 “数字指纹”,只要能精准捕捉这些指纹,就能从根源上解决识别难题。

这套系统最亮眼的是多模态融合检测技术。它不像传统工具那样孤立处理视频、音频和文本,而是把所有内容维度整合起来分析。比如面对一段 Sora 生成的视频,朱雀会同时提取画面帧特征、音频频谱特征和文字语义特征,然后通过交叉验证找到其中的矛盾点。AI 生成的内容往往在细节上存在逻辑漏洞,比如人物表情与语音情绪不匹配,或者场景光影变化不符合物理规律,这些 “小破绽” 单看某一模态很难发现,但多模态比对后就会无所遁形。

实时动态学习机制让朱雀始终保持领先。Sora 的生成算法在不断进化,审核工具如果一成不变肯定会被淘汰。朱雀采用了 “边检测边学习” 的模式,每天自动收集新出现的 AI 生成内容样本,通过强化学习快速更新检测模型。当 Sora 推出新功能或生成手法时,朱雀能在几天内完成模型迭代,始终保持识别能力的领先。某社交平台接入后反馈,即使面对 Sora 最新版本生成的内容,朱雀的识别准确率仍能稳定在 98% 以上,这是传统工具根本做不到的。

还有个关键优势是轻量化部署能力。很多平台担心引入新工具会增加服务器负担,但朱雀的检测模型经过专门优化,能在普通服务器上实现毫秒级响应。这意味着即使面对每秒上万条的内容洪流,也能实时完成检测,不会出现审核延迟影响用户体验。更重要的是它支持 API 无缝对接, existing 审核系统不需要大改架构就能快速接入,大大降低了平台的使用门槛。

📝 朱雀 AI 的四大核心策略:从源头阻断不良内容传播

朱雀 AI 检测助手不是简单的 “内容过滤器”,而是一套完整的内容安全解决方案。它的第一个核心策略是全生命周期检测,把审核环节从内容发布后提前到发布前、创作中。在创作者使用 Sora 类工具生成内容时,朱雀就能通过前置接口进行实时监测,一旦发现潜在风险就及时预警。比如检测到用户正在生成涉及敏感人物的虚假视频,系统会立即提示风险并限制生成,从源头减少不良内容的产生。这种 “防患于未然” 的思路,比事后删除效率高十倍以上。

第二个策略是多维度特征提取,专门破解 Sora 内容的伪装术。朱雀会从视频中提取几十种 AI 特有特征,包括像素分布规律、光影过渡自然度、人物微表情连贯性等。这些特征是人眼无法察觉的,但 AI 生成内容总会在这些细节上露出马脚。比如 Sora 生成的人物眨眼频率可能不符合自然规律,或者物体阴影的角度与光源不匹配。通过对这些 “数字指纹” 的分析,朱雀能精准区分 AI 生成内容和真实内容,哪怕是经过二次剪辑的混合内容也能识别出来。

动态规则引擎是第三个撒手锏。传统审核工具依赖固定规则库,面对新的违规手法反应迟缓。朱雀则采用动态规则系统,能根据平台特性和违规趋势自动调整检测策略。比如某段时间突然出现大量 AI 生成的虚假财经新闻,系统会自动强化对 “股市预测”“投资建议” 等关键词的视频监测,并增加对西装人物、新闻演播室等场景的风险评估权重。这种 “智能应变” 能力,让平台能快速响应新的内容安全威胁。

最后一个核心策略是人机协同审核。朱雀不追求完全替代人工,而是通过 AI 大幅提升人工审核效率。系统会先对内容进行初筛,把高风险内容标记出来并给出风险点提示,比如 “疑似 AI 生成的暴力场景”“可能涉及深度伪造的人物对话”。审核员只需重点处理这些标记内容,工作效率能提升 3-5 倍。同时人工审核的结果会反馈给 AI 模型,不断优化识别精度,形成 “AI 辅助人工,人工反哺 AI” 的良性循环。

🔬 技术拆解:朱雀 AI 如何看穿 Sora 的 “伪装术”?

很多人好奇,朱雀 AI 到底是怎么识别 Sora 生成的内容的?核心秘密就在它的深度伪造检测算法里。这套算法专门针对 Sora 这类生成式 AI 的技术原理设计,能精准捕捉内容生成过程中的 “算法痕迹”。Sora 生成视频时,会通过扩散模型逐步优化像素点,这个过程会留下独特的噪声分布模式。朱雀的算法能像 “数字显微镜” 一样放大这些噪声特征,通过对比真实视频的自然噪声,快速判断内容是否由 AI 生成。

更厉害的是时空一致性分析技术。真实视频中的物体运动遵循物理规律,而 AI 生成内容有时会在时间或空间维度出现矛盾。比如一个人从坐下到站起的动作,真实场景中重心变化是连续的,但 Sora 可能在某几帧出现重心跳跃。朱雀会逐帧分析物体的运动轨迹和受力关系,通过物理引擎模拟判断运动是否符合自然规律。这种技术不仅能识别纯 AI 生成内容,还能发现 “真中掺假” 的混合内容,比如在真实视频中插入几秒钟的 AI 生成片段。

跨模态语义理解是另一项核心技术。朱雀不只是简单分析视频画面,还会把音频、字幕、甚至封面文字结合起来解读内容含义。比如一段看似普通的风景视频,配上特定的音频解说可能就变成了敏感内容。系统会对所有模态的信息进行语义融合分析,理解整体表达的含义,而不是孤立判断某一部分。这种 “全景式” 分析能力,让那些通过多模态协同传递不良信息的内容无处遁形。

为了应对 Sora 的持续进化,朱雀还采用了对抗性训练方法。开发团队会用 Sora 的最新版本生成各种高难度测试内容,故意制造 “极限挑战” 来锻炼检测模型。比如让 Sora 生成经过多次修改的 “反检测” 视频,然后用这些内容训练朱雀的识别能力。这种 “魔高一尺道高一丈” 的训练方式,确保朱雀的检测能力始终领先于生成式 AI 的进化速度,哪怕 Sora 推出新版本,朱雀也能快速适应。

📊 实战效果:这些平台用了朱雀后发生了什么?

真实的数据最有说服力。某头部短视频平台接入朱雀 AI 检测助手后,AI 生成不良内容的检出率从原来的 62% 提升到 97%,漏检率下降了 80% 以上。平台审核团队的工作量减少了一半,以前需要 10 个人处理的内容,现在 5 个人就能轻松完成。更重要的是用户投诉量明显下降,涉及 “虚假视频”“不良内容” 的举报减少了 65%,平台的内容生态得到显著改善。这些变化不是一蹴而就的,而是在接入后的三个月内逐步显现,说明系统在不断适应平台的内容特征。

另一个典型案例是某新闻资讯平台。该平台以前饱受 AI 生成虚假新闻的困扰,尤其是 Sora 推出后,大量伪造的 “突发事件” 视频在平台传播,严重影响了平台公信力。接入朱雀后,系统通过 “敏感事件 + AI 生成特征” 的双重检测,成功拦截了 92% 的虚假新闻视频。更关键的是系统能识别那些 “半真半假” 的内容 —— 比如用真实事件的音频配上 AI 生成的虚假画面,这种以前很难发现的内容现在能被精准标记。平台编辑表示,有了朱雀的辅助,他们终于能从海量内容中快速找到真正有价值的新闻,工作效率提高了不止一倍。

电商平台的应用效果同样显著。某电商平台曾出现大量 AI 生成的虚假商品视频,商家用 Sora 生成不存在的产品效果展示,误导消费者下单。接入朱雀后,系统会对 “产品使用效果”“功能演示” 类视频进行重点检测,识别出 AI 生成的虚假场景。实施三个月后,平台的商品纠纷率下降了 40%,消费者满意度提升了 25%。更意外的是,优质商家的积极性被调动起来了,因为虚假宣传的空间被压缩,正经做生意的商家获得了更公平的竞争环境。

教育平台的内容安全提升也值得一提。青少年教育类平台对内容质量要求极高,但 Sora 生成的不良内容很容易伪装成教学视频。某教育平台接入朱雀后,专门针对 “未成年人”“校园场景” 等内容强化检测,成功拦截了大量伪装成教学内容的不良视频。系统还能识别出 AI 生成的虚假名师形象,避免骗子利用虚假身份进行招生诈骗。家长反馈,孩子使用平台时遇到不适内容的概率大大降低,对平台的信任度明显提升。

🔮 未来已来:AI 内容审核将走向何方?

Sora 的出现不是终点,而是 AI 内容生成浪潮的开始。随着技术的进步,未来会有更强大的生成工具出现,内容审核的战场只会越来越激烈。朱雀 AI 检测助手的研发团队已经在布局下一代技术,多模态大模型融合将是重点方向。未来的审核系统不仅要能处理视频、音频、文本,还要能理解 3D 模型、虚拟场景等新兴内容形式,形成全方位的内容安全防护网。

实时性和预判性将成为核心竞争力。现在的审核大多是 “事后补救”,未来的系统会向 “实时拦截” 甚至 “提前预判” 进化。比如通过分析用户的创作习惯和历史内容,提前识别出高风险创作行为,在内容生成前就进行干预。朱雀团队透露,他们正在测试的 “创作意图识别” 技术,已经能通过用户输入的文本描述,预判生成内容的风险等级,这种 “未卜先知” 的能力将彻底改变内容审核的被动局面。

人机协同的深度融合会成为主流模式。完全依赖 AI 审核容易出现误判,完全依赖人工又效率太低。未来的最优解是 AI 负责 90% 的常规检测,人类审核员专注处理那 10% 的模糊地带和新出现的风险类型。朱雀正在开发的 “审核大脑” 系统,会记录人类审核员的判断逻辑,把这些经验转化为 AI 模型的决策依据,让系统越来越 “懂” 平台的审核标准和价值观。这种 “AI 学习人类,人类指导 AI” 的模式,既能保证效率又能减少误判。

行业标准的建立同样重要。现在不同平台的审核标准参差不齐,给了不良内容可乘之机。未来很可能会形成统一的 AI 生成内容审核标准,明确哪些内容必须拦截、哪些需要标注、哪些可以放行。朱雀团队已经在参与相关行业标准的制定,希望通过技术输出推动整个行业的内容安全水平提升。只有全行业形成合力,才能真正应对 AI 生成内容带来的挑战,让技术创新在安全的前提下造福用户。

内容创作和审核的博弈永远不会停止,但有朱雀这样的技术工具在,我们有理由相信,无论 Sora 们变得多强大,总能有相应的防护手段跟上。毕竟技术本身没有善恶,关键在于我们能否用更智慧的方式引导它、规范它。对于平台来说,现在就布局 AI 内容审核技术,不仅是应对当下的风险,更是为未来的内容生态保驾护航。