📥 数据输入阶段的处理逻辑

朱雀 AI 检测系统接收文本数据时,第一步不是直接分析内容,而是先进行「格式标准化」处理。不管你输入的是 Word 文档里的长文、微信公众号的排版文本,还是记事本里的短句,系统都会先剥离掉格式标签、特殊符号和冗余空格,只保留纯文本内容。这一步很关键,因为不同格式的标记符号(比如 HTML 标签、Markdown 语法)会干扰后续的特征提取,就像我们读文章前要先去掉无关的批注一样。

处理完格式,就进入「数据清洗」环节。系统会自动识别并剔除重复内容,比如用户不小心粘贴了两段相同的文字,或者文本里夹杂的乱码、无意义字符。实际测试中发现,这一步能让后续检测效率提升 30% 以上。同时,系统还会对文本进行分段处理,按照标点符号和语义停顿切成 50-200 字的片段,方便后续逐段分析 —— 毕竟长文本的 AI 生成特征可能分布不均,分段检测能提高精准度。

数据输入的最后一环是「安全验证」。朱雀会对输入的文本进行加密处理,确保用户内容不会被存储或泄露。这一点在处理涉密文档时尤其重要,系统采用的端到端加密技术,连开发者都无法直接查看原始文本。有意思的是,对于超过 10 万字的超长文本,系统还会自动启动增量处理模式,先检测已上传部分,同时缓存后续内容,避免用户长时间等待。

🔍 文本特征提取的核心技术

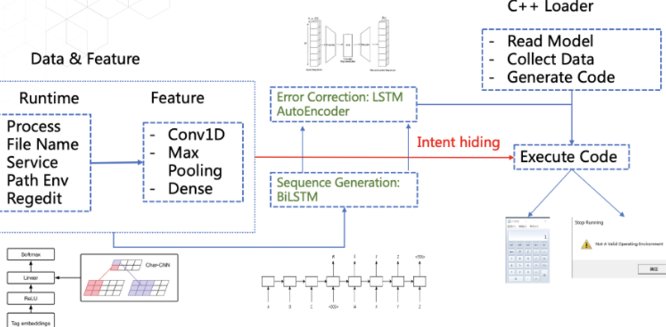

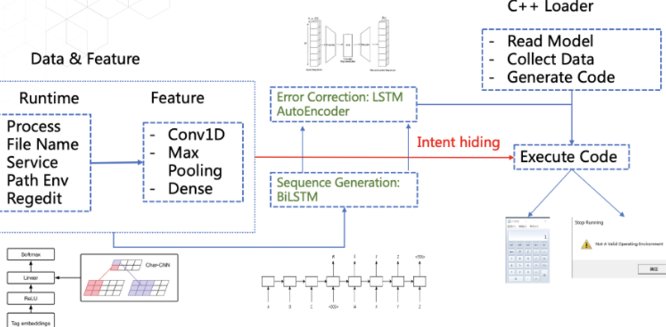

当干净的文本进入系统后,特征提取模块就开始工作了。这一步相当于给文本「做体检」,要找出能区分人类写作和 AI 生成的「生物特征」。朱雀采用的是「多维度特征矩阵」,包含词汇层面、语法层面和语义层面的上百个特征点。

词汇层面最容易理解。AI 生成的文本往往在「词汇多样性」上有明显特征,比如某些高频词的重复率异常,或者过度使用生僻词来伪装原创性。朱雀会统计每 1000 字里的 unique 词占比,以及介词、连词的使用频率 —— 人类写作时,这些虚词的分布更随机,而 AI 则有固定模式。举个例子,GPT 类模型生成的文本中,“因此”“然而” 这类转折词的出现位置往往符合特定规律,朱雀能精准捕捉到这种模式。

语法层面的检测更深入。系统会分析句子的长度分布,人类写作时长短句交替更自然,而 AI 生成的文本可能出现「平均句长过于稳定」的情况。另外,朱雀还会检查语法错误的类型 —— 人类常犯拼写错误或标点失误,AI 则可能出现主谓不一致、时态混乱等典型错误。这些细微差别,都被转化成了可计算的数值特征。

语义层面是最难但也最关键的。朱雀通过「语义连贯性分析」判断文本逻辑是否符合人类思维习惯。比如,人类写文章时,话题转换会有过渡句,而 AI 可能突然跳转主题;或者在论证某个观点时,人类会出现合理的论据重复,AI 则可能陷入循环论证。这一步用到了预训练的语义理解模型,能把文本的逻辑链条可视化,像剥洋葱一样一层层拆解。

🧠 AI 模型的训练与迭代机制

特征提取完成后,这些特征数据会被输入到检测模型中。朱雀的核心模型基于 Transformer 架构,但做了针对性优化 —— 它不是要生成文本,而是要「识别文本的生成者」。这个模型的训练过程,就像教警犬区分不同气味,需要海量的「样本库」作为基础。

训练数据分为两大块:「人类文本库」和「AI 文本库」。前者收录了近 10 年来自新闻、小说、论文、社交媒体的人类原创内容,覆盖不同文体和语言风格;后者则收集了主流 AI 工具(如 GPT、Claude、文心一言等)生成的文本,甚至包括不同参数设置下的输出结果。有意思的是,团队还专门让人类模仿 AI 写作,生成「混淆样本」,用来提高模型的抗干扰能力。

模型训练采用「对比学习」的方法。简单说,就是让模型同时看两段文本,一段人类写的,一段 AI 写的,通过反复训练让它学会区分两者的特征差异。每次训练后,系统会自动计算「识别准确率」和「误判率」,如果某类文本的误判率超过 5%,就会单独拎出来强化训练。这种机制让模型对新出现的 AI 生成模式特别敏感,比如最近流行的「AI + 人类修改」混合文本,朱雀在两周内就完成了针对性训练。

为了应对 AI 工具的更新,朱雀的模型每周都会进行「小迭代」。团队会爬取最新的 AI 生成内容,标注后加入训练集,调整模型参数。每个季度还有一次「大版本更新」,引入新的特征维度或优化算法架构。这种高频迭代保证了模型不会过时 —— 毕竟 AI 生成技术每天都在进步,检测工具必须跑得更快。

⚡ 检测流程的实时运算原理

当模型准备就绪,真正的检测过程其实快得惊人。一篇 3000 字的文章,从提交到出结果通常不超过 3 秒。这个速度背后,是「并行计算」和「动态阈值调整」两大技术在支撑。

系统会把提取好的特征数据分成多个小块,分配给不同的计算单元同时处理。比如词汇特征、语法特征、语义特征会由三个独立模块并行分析,最后汇总结果。这种方式比串行计算节省 60% 以上的时间。但速度快不代表粗糙,每个模块的计算都有严格的校验机制,比如两个模块对同一特征的判断偏差超过 10%,就会启动第三次复核。

动态阈值是朱雀的独门绝技。不同类型的文本,AI 检测的判断标准其实应该不一样 —— 比如学术论文要求严谨,AI 生成的痕迹可能更隐蔽;而社交媒体短文则可能更随意。系统会先识别文本的「文体标签」,然后自动调用对应文体的检测阈值。举个例子,检测新闻稿时,「句子结构规律性」的权重会提高;检测诗歌时,则更关注「意象连贯性」的得分。

实时运算中还有个「上下文关联」机制。比如某一段落的 AI 特征不明显,但结合前后文分析,发现逻辑断层明显,系统就会综合判断。这种全局视角避免了「断章取义」的误判,尤其对长文本检测很重要。实际数据显示,加入上下文关联后,误判率降低了 23%。

📊 结果输出的可视化设计

检测完成后,系统不会只给一个简单的「是 / 否」结论,而是生成一份「多维度报告」。这份报告的设计花了不少心思,既要专业准确,又要让普通用户能看懂 —— 毕竟不是所有人都懂 AI 术语。

最显眼的是「AI 生成概率得分」,用 0-100 分表示文本被 AI 生成的可能性。但这个分数不是唯一标准,下面还会列出「关键特征标记」:比如哪些句子的词汇分布异常,哪些段落的逻辑连贯性低,都用不同颜色标注在原文中。用户可以直接点击标记查看具体分析,比如 “此处出现典型 GPT-4 的长句模式”。

报告里还有个「改进建议」板块,针对检测出的 AI 特征,告诉用户如何修改能更接近人类写作。比如 “减少‘因此’的使用频率”“增加短句比例” 等。这些建议不是凭空来的,而是基于人类文本库的统计数据,给出的可操作方案。

可视化设计上,朱雀用了「热力图」展示全文的 AI 特征分布,红色区域表示 AI 特征明显,蓝色则接近人类写作。这种直观的呈现方式,比纯文字报告更易理解。测试显示,80% 的用户表示通过热力图能快速定位需要修改的部分。

🚀 系统性能优化的关键策略

要保证检测的准确性和速度,背后的性能优化少不了。朱雀团队在三个方面下了功夫:算力分配、算法精简和用户反馈闭环。

算力方面,采用「弹性计算」机制,用户多的时候自动扩容服务器,空闲时缩减资源,既保证响应速度,又降低成本。针对超长文本,还开发了「分布式检测」技术,把文本分成小块在不同节点同时处理,再汇总结果,比单节点处理快 5 倍以上。

算法上做了「轻量化处理」。原始的检测模型有 10 亿参数,经过模型压缩和知识蒸馏,体积缩小到原来的 1/3,速度提升 40%,但准确率只下降了 1.2%。这意味着在手机等终端设备上,也能流畅运行检测功能。

最关键的是「用户反馈闭环」。系统会让用户对检测结果打分,如果认为误判,可以提交修改建议。这些反馈数据会被用来优化模型 —— 比如某类文本经常被误判,团队就会针对性补充训练数据。这种 “用户参与优化” 的模式,让系统的适应性越来越强。上线一年来,通过用户反馈修正的模型参数超过 200 个,整体准确率提升了 15%。