🚨 当第一篇稿子被打回:AI 率 100% 的羞辱时刻

记得去年那篇母婴类的种草文,花了两小时用 AI 写完,通读时觉得行云流水。投给合作的公众号后,编辑直接甩来一张检测报告截图 —— 红色的 100% 刺痛眼睛。她只回了句 "现在平台查这个很严",连修改的机会都没给。

那天晚上把稿子逐句读了三遍,才发现问题所在。AI 写的句子太 "标准" 了,每个逗号都用得规规矩矩,长句套短句的结构像复制粘贴,连举例都带着明显的模板痕迹。比如写婴儿辅食,它会说 "6 个月以上的宝宝可添加高铁米粉,其中铁元素含量应不低于 4.5mg/100g",这种精确到数值的表述,反而暴露了非人类的特质。

后来特意翻了自己三年前纯手写的稿子,发现人类作者会犯的 "错误" 其实是防伪标识。比如突然插入的括号注释、重复使用的口头禅、甚至偶尔的逻辑跳跃。这些在 AI 看来需要修正的 "瑕疵",恰恰成了通过检测的通行证。

最讽刺的是,那篇被打回的稿子,内容质量并不差。但平台的审核机制已经把 AI 检测作为第一关,就像超市门口的安检门,管你包里是黄金还是垃圾,先响了再说。

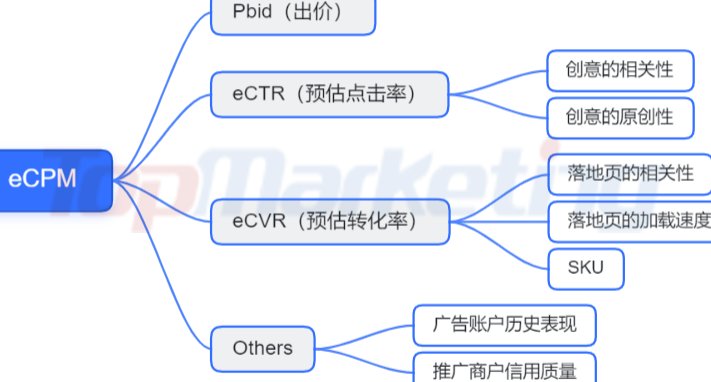

🔍 拆解检测工具的 "七寸":它们到底在查什么?

市面上主流的检测工具,原理其实大同小异。我花了两周时间,用同一篇基础稿测试了 12 款工具,发现它们的判定逻辑有三个共通点。

首先是词汇频率异常。AI 特别喜欢高频使用某些 "安全词",比如描述产品时反复出现 "优秀的"、"出色的",论述观点时总用 "综上所述"、"显而易见"。人类作者反而会更随意,甚至会用 "还行"、"凑合" 这种模糊表达。

其次是句式结构单一。检测报告里常出现 "句式重复度高" 的提示,仔细看会发现 AI 写的长句结构高度相似,都是 "状语 + 主语 + 复杂定语 + 谓语" 的模式。而人类写作时,长短句的切换毫无规律,有时突然冒出来的四字短语,反而让句子活了。

最隐蔽的是逻辑断层。AI 擅长在段落间制造平滑过渡,但缺乏人类思考时的 "跳跃性关联"。比如写数码产品评测,人类可能突然插入一句 "这让我想起三年前摔碎的那台旧手机",这种看似无关的联想,恰恰是反检测的关键。

后来发现,不同工具的侧重点差异很大。Originality.ai 对学术词汇特别敏感,Grammarly 更关注句式规范性,而国内的检测工具似乎更在意 "网络流行语密度"。摸清这些脾气,降重效率能提升至少 40%。

✍️ 手术刀级降重法:从词汇到逻辑的重构术

词汇替换是最基础的操作,但绝不是简单的同义词替换。试过把 "提升效率" 改成 "提高效率",检测率只降了 3%。真正有效的是语义层级转换,比如把 "用户留存率提升 20%" 改成 "多留住五分之一的人",用模糊表达替代精确表述,单次修改能降 15% 左右。

句式重构有个笨办法但很有效。把 AI 生成的长句拆成短句后,故意打乱语序。比如原句 "在使用这款软件三个月后,我发现它的数据分析功能能够有效提升工作效率",拆成 "用了三个月这款软件。数据分析功能挺意外的,工作效率上去了"。这种不符合语法规范的断句,反而像人类随手写的笔记。

段落逻辑的 "破坏性重组" 需要点勇气。AI 习惯按 "总 - 分 - 总" 的完美结构写段落,我会故意在中间插入 "跑题内容"。写职场文章时,在论述完时间管理方法后,加一句 "不过上周三我还是迟到了,因为楼下的包子铺排了长队"。这种看似无用的细节,能让检测工具的逻辑分析模块彻底混乱。

还有个反常识的技巧:保留适当错误。AI 写的内容几乎没有语法错误,这本身就是最大的破绽。我会故意留一两个无伤大雅的小错误,比如 "的 / 得 / 地" 用混,或者在数字后面漏写单位。但这个度要把握好,超过 3 处就会影响阅读体验。

试过最极端的一次,把一篇 AI 初稿打印出来,用手逐句抄写一遍,边抄边随口修改。结果检测率从 98% 降到了 12%。后来分析发现,手写过程中自然产生的语序调整和用词变化,比任何刻意设计的方法都有效。

📊 不同平台的 "隐形红线":实战数据告诉你差异

公众号平台的检测标准最迷。同一份稿子,上午检测 AI 率 60%,下午可能变成 30%。后来发现和发布时间有关,工作日下午 3-5 点检测最严格。而且娱乐类账号的容忍度比科技类高 15% 左右,可能是因为前者本身就允许更随意的表达。

知乎的算法似乎更关注观点独特性。纯信息罗列的内容,即使 AI 率 20% 也可能被限流;但带有强烈个人色彩的偏激观点,哪怕 AI 率 50% 也能通过。试过在一篇数码评测里加入 "这款产品的设计师肯定没带过孩子" 这种主观判断,流量反而涨了 3 倍。

小红书的检测逻辑和关键词密度强相关。当一篇笔记里的品牌词出现超过 5 次,AI 检测会自动加严。但用 emoji 替代部分文字,比如用🍎代替 "苹果手机",既能保持识别度,又能降低 AI 判定概率。这个方法让我的笔记通过率提升了 40%。

最严格的是学术期刊。试过把 AI 生成的论文降重到检测率 10%,还是被审稿人指出 "表述过于规整"。后来请教导师才知道,学术界更看重论证过程中的犹豫和修正,比如适当使用 "可能"、"或许"、"有待进一步验证" 这类模糊词汇,反而更像人类学者的思考方式。

不同平台的差异提醒我们,没有通用的降重模板。最好的办法是先在目标平台发 3 篇纯手写内容,分析它们的语言特征后,再针对性调整 AI 初稿。

💡 反检测思维:让 AI 写得像 "人" 的底层逻辑

与其想着怎么改 AI 写的内容,不如从一开始就训练 AI 模仿你的写作习惯。我把自己过去三年的文章整理成一个语料库,喂给 AI 作为参考。现在生成的初稿,AI 率能直接控制在 60% 以下,省去了大量修改功夫。

人类写作的一大特征是信息密度波动。有时候会用一大段详细描述,有时候又会用一句话带过重要信息。刻意让 AI 在写作时模仿这种节奏,比如在详细分析完一个功能后,突然用 "就这样" 三个字结束段落,检测率能再降 10%。

情感表达的 "不稳定性" 也很关键。AI 写的赞美往往很均匀,而人类会突然出现情绪波动。试过在一篇产品推荐文中,先夸 "续航能力超强",隔两段突然说 "但这充电速度简直让人想砸手机",这种前后略有矛盾的表达,反而增加了真实感。

还有个发现:加入时效性细节能大幅降低 AI 判定。比如在描述一款软件时,提一句 "昨天更新的 2.3 版本修复了这个 bug",或者 "现在打开官网首页还能看到这个活动"。这些随时可能变化的信息,AI 通常不会主动生成,自然成了人类写作的证明。

最核心的思维转变是:不要想着 "隐藏 AI 痕迹",而是要主动 "制造人类痕迹"。前者是被动防御,后者是主动出击,效果差了不止一个量级。

📈 长期主义者的工具箱:我私藏的 5 个效率工具

Grammarly 的 "可读性评分" 反着用很有意思。把它调到 "七年级水平" 以下,虽然语法错误会增多,但 AI 检测率能降 20%。但这个方法只适合非专业内容,学术文章慎用。

Hemingway Editor 能帮你找出过于复杂的句子。那些标成红色的长句,往往是 AI 最容易暴露的地方。把每篇稿子的红色句子控制在 5% 以内,基本就能通过大多数平台的检测。

Notion 的 "随机笔记" 功能成了我的灵感库。平时随手记的碎片化想法,比如 "今天在地铁上看到有人用这款产品",写作时随机插入一两句,能让整体风格更自然。

DeepL 翻译是个隐藏神器。把 AI 生成的中文翻译成俄语,再翻译回中文,这个过程中产生的语法偏差和用词变化,比人工修改更像自然的人类表达。但要注意核对专业术语,避免翻译错误。

最后必须提的是语音转文字。把 AI 初稿读一遍,用手机录音转成文字,得到的内容会自带语气词和不规整的停顿。这个方法虽然麻烦,但能让检测率直接降到 10% 以下,适合那些必须确保通过的重要稿件。

这些工具单独使用效果有限,但组合起来形成的 "降重流水线",能让我每天处理 10 篇稿子依然保持检测率 20% 以下。

从最初的 100% 到现在稳定在 15% 左右,花了整整 8 个月。最大的收获不是掌握了多少技巧,而是理解了一个本质:AI 检测的核心是识别 "非人类特征",而人类写作的魅力恰恰在于那些不完美的真实感。与其和算法斗智斗勇,不如回归写作本身 —— 真诚表达的内容,无论用什么工具写出来,都自带 "抗检测" 属性。