现在刷社交媒体,是不是经常看到一张超美的插画,下意识就会想 —— 这是 AI 画的吧?

没错,AI 绘画工具这两年简直是井喷式发展。Midjourney V6 能画出以假乱真的人像,Stable Diffusion 的写实风格连摄影圈都开始警惕,更别说 DALL・E 3 那种跟文本贴合到可怕的生成能力。但问题来了,这些 AI 捣鼓出来的图,真的能被看出来吗?

答案是肯定的,但也没那么简单。不是所有 AI 图都有明显破绽,而且随着模型迭代,旧的识别方法很快就会失效。今天就来好好拆解一下,AI 绘画的那些 "马脚" 到底藏在哪里,普通人怎么练出火眼金睛,专业工具又是怎么工作的。

🎨 AI 绘画的 "完美缺陷":肉眼能捕捉的细节破绽

很多人觉得 AI 画的图 "太完美",反而不真实。这话只对了一半。实际上 AI 的缺陷往往藏在那些需要人类常识判断的细节里,尤其是复杂场景中的元素互动。

先看手部和脚部。这几乎是 AI 绘画的祖传难题。就算是最新的模型,也经常会画出 6 根手指、关节扭曲的手掌,或者脚趾黏连在一起的脚。人类画师就算画得再潦草,也不会犯这种违背生理结构的错误。为什么?因为 AI 学的是图像特征,而不是 "手有 5 根手指" 这个常识。它会把训练数据里的手部特征混合,但遇到复杂姿势时就容易混乱。

再看纹理一致性。比如画一件毛衣,AI 可能在袖口用了一种针织纹理,到了衣摆突然变成另一种,而且过渡非常生硬。人类画师会保持纹理的连贯性,AI 却经常在细节上 "失忆"。同样的问题还出现在头发丝、布料褶皱这些需要全局协调的地方。

还有光影逻辑。AI 很擅长画单光源的简单场景,但多光源环境就容易露馅。比如画一个人站在窗边,阳光从左边照进来,影子却出现在右边;或者脸上的高光和环境光完全不匹配。人类对光影的理解是基于三维空间感的,AI 则是在二维图像上模拟光影效果,遇到复杂情况就会逻辑断裂。

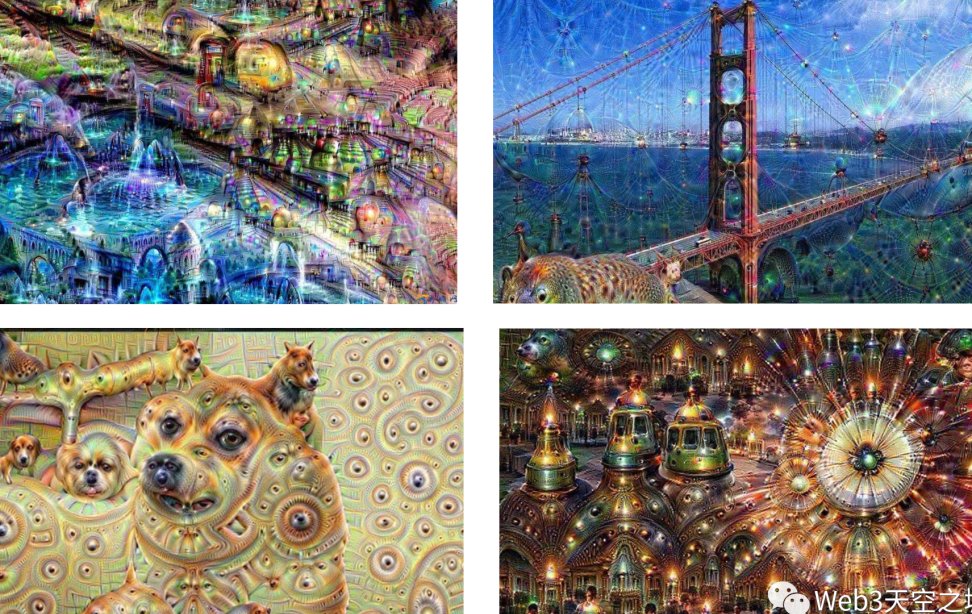

最有意思的是 **"无意义细节"**。放大 AI 画的背景,经常能看到模糊的文字变成乱码,远处的树叶变成奇怪的色块组合,或者墙壁上的花纹毫无规律地重复。这些地方人类画师要么会简化处理,要么会画得有逻辑,AI 却会为了 "填充内容" 而生成看似复杂实则无意义的图案。

🔍 专业识别工具的原理:不是靠 "看",是靠 "算"

光靠肉眼不够用的时候,就得请专业工具出场了。但这些工具的工作原理,跟我们用眼睛看细节完全不是一回事。

目前主流的 AI 图像检测器,比如 Hugging Face 的 AI Image Detector、Sensity AI,还有微软研究的 Detection Tool,核心逻辑都是分析图像的数字特征。AI 生成的图像在像素分布、频率域特征上,跟人类创作的图有本质区别。

举个例子,人类画的图在高频信息(比如锐利的边缘、精细的纹理)上分布更自然,而 AI 生成的图为了避免 "噪声",会不自觉地平滑高频信号。专业工具通过傅里叶变换分析图像的频率成分,就能发现这种异常。就像听音乐,人类演奏的曲子有细微的节奏波动,而电子合成的音乐总是过于 "完美"。

还有一种方法是检测图像中的 "模型指纹"。每个 AI 绘画模型在训练时,都会留下独特的数学特征。比如 Stable Diffusion 生成的图像,在特定像素位置会有重复出现的微弱模式,这就像模型的 "签名"。识别工具通过比对这些指纹库,就能判断图像来自哪个模型。

但这些工具也有局限。如果把 AI 生成的图用 PS 修改过,或者转换了几次格式,很多数字特征就会被破坏,检测准确率会大幅下降。而且新的 AI 模型会专门针对这些检测方法做优化,比如 Midjourney V6 就宣称减少了高频信号的异常分布,让检测器很难识别。

📊 不同 AI 模型的 "画风指纹":各有各的破绽

不是所有 AI 生成的图都一个样。Midjourney、Stable Diffusion、DALL・E 这几个主流模型,生成的图像在特征上有明显区别,熟悉这些特点能让识别准确率提升不少。

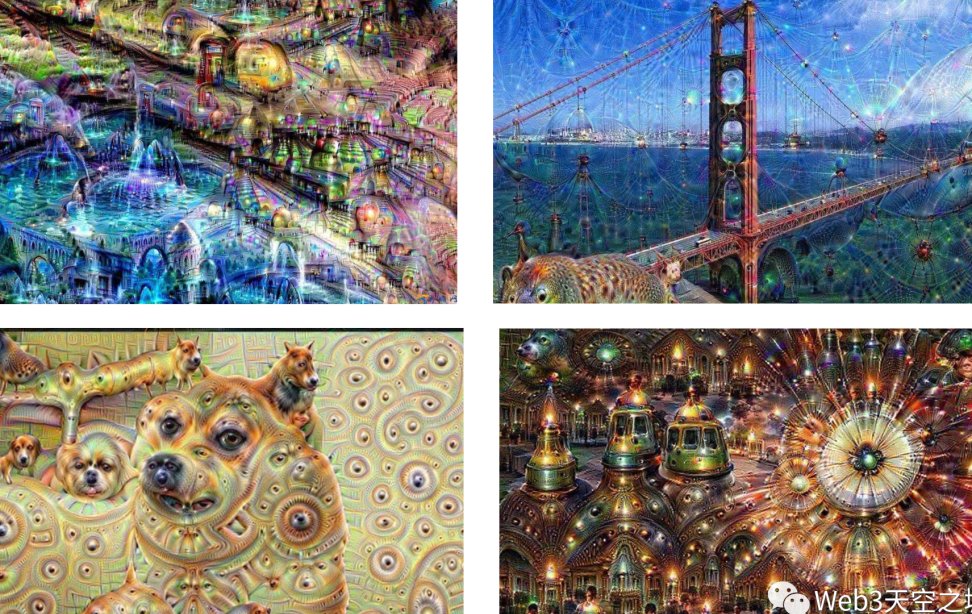

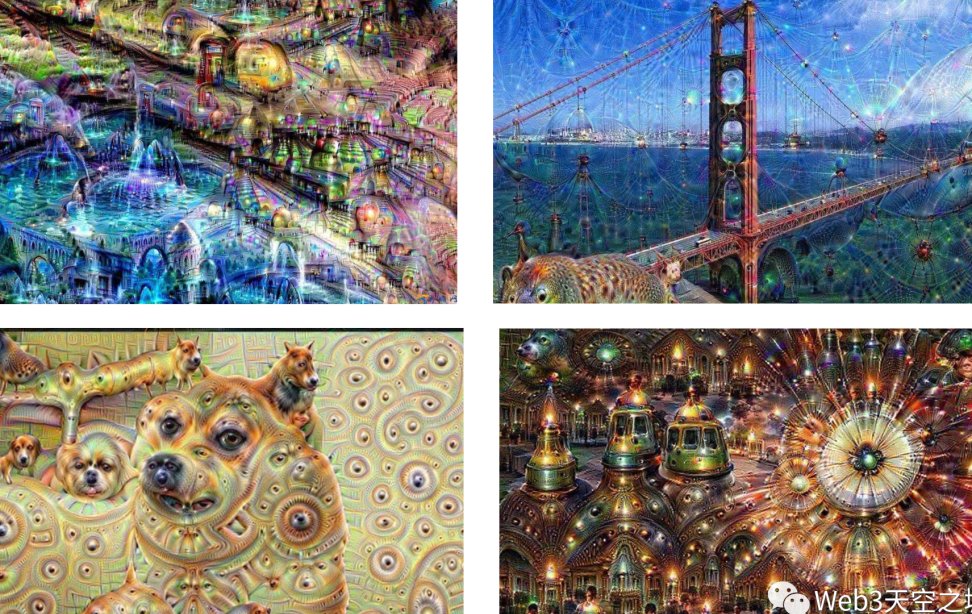

Midjourney 的早期版本(V3、V4)很容易辨认,因为它的色彩饱和度偏高,人物皮肤经常有塑料感,而且画出来的场景总带着一种 "梦幻滤镜"。到了 V5 之后,这些特点减弱了,但依然能看出对细节的过度渲染—— 比如眼睛里的反光过于复杂,或者衣服上的花纹密集到不自然。

Stable Diffusion 因为开源特性,被魔改出了无数版本,但核心特征还是存在:生成的图像边缘容易发虚,尤其是在物体和背景的交界处。而且它对文字的处理特别差,画出来的招牌、书本上的文字几乎都是乱码。不过这个问题正在被修复,最新的 ControlNet 插件已经能生成相对正常的文字了。

DALL・E 3 最大的特点是跟文本描述的贴合度极高,但也因此容易在逻辑上出问题。比如你让它画 "一只站在键盘上的猫,爪子放在空格键上",它可能会画出猫爪和键盘比例失调,或者空格键的位置明显不对的图。因为它太专注于满足文本的每个细节,反而忽略了整体合理性。

还有一类专门生成写实照片的模型,比如 RealVis、Deliberate,它们的破绽往往在光照的全局一致性上。比如生成室内照片时,天花板的灯光照在地板上的光斑形状,可能跟光源的形状完全不匹配;或者窗户透进来的光线颜色,跟室外环境不搭。

🚫 识别技术的 "道高一尺魔高一丈":对抗与升级

AI 绘画模型和识别技术,就像在玩一场永不停歇的猫鼠游戏。这边刚发现一个识别特征,那边的模型更新就把这个特征改掉了。

2023 年的时候,很多检测器靠 "眼睛里的异常反光" 识别 AI 人像。结果几个月后,Midjourney 就优化了眼部渲染算法,现在生成的眼睛细节连眼科医生都挑不出大错。

还有人发现,AI 生成的图像在特定颜色通道(比如绿色通道)的像素分布有规律。这个发现被写成论文发表后,不到半年,主流 AI 绘画工具就都调整了颜色处理逻辑。

更有意思的是 **"对抗性生成"**。现在已经有研究团队开发出专门的算法,能在不影响图像观感的前提下,修改 AI 生成图的数字特征,让所有检测器都失效。这种技术一旦普及,以后可能连专业工具都分不清真假了。

反过来,识别技术也在升级。最新的检测器开始用多模态分析,不光看图像本身,还会结合生成时的元数据(比如 EXIF 信息里的模型参数)、甚至分析图像的创作过程(如果有记录的话)。有些工具还会让 AI 自己 "反思"—— 用同一个模型尝试复现图像的细节,如果复现难度异常低,就可能是 AI 生成的。

💡 普通人的实用识别技巧:3 个简单方法

不是每个人都需要专业工具,掌握这几个小技巧,日常分辨 AI 图够用了。

放大看细节。把图片放大到 100%,看头发、手指、布料这些细节。AI 图放大后,细节会变得模糊或混乱,而人类画的图要么保持清晰,要么有明确的简化处理。特别是发丝,AI 经常会画出像面条一样缠绕的奇怪形状。

检查文字和符号。如果图中有文字(招牌、书本、衣服上的印花),AI 生成的大概率是乱码或无意义的组合。人类不会在这种地方犯低级错误,就算写得潦草也能看出是正经文字。

看场景逻辑。比如画一群人,注意他们的互动是否自然 —— 有人的手可能悬在半空没碰到东西,或者两个人的视线完全不匹配。AI 擅长画单个物体,但处理多个元素的互动时经常出问题。

当然,这些方法也在慢慢失效。现在已经有 AI 能生成基本正常的手部,文字识别能力也在提升。但至少在目前,结合这几点,判断准确率能达到 80% 以上。

最后想说,识别 AI 绘画不是为了 "抵制" 它,而是为了更好地理解这项技术。AI 生成的图像有自己的美学特点,也有难以克服的局限。知道怎么分辨,才能在这个 AI 创作越来越普及的时代,更清醒地看待我们看到的每一张图片 —— 不管是人画的还是机器画的,重要的是它传递的信息和价值,不是吗?

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】