📌 GAN 生成图片藏不住的「小尾巴」

玩过 AI 绘图的人可能都发现过,那些看起来天衣无缝的图片里,总藏着些「说不上来的怪」。其实这就是 GAN 留下的痕迹,只是普通人未必能精准捕捉。

纹理一致性是个重灾区。GAN 生成的皮肤纹理常常像打了模糊滤镜,远看没问题,放大了就会发现毛孔排列毫无规律,甚至出现像素跳跃。头发更是重灾区,要么像一团缠绕的钢丝,要么边缘出现不该有的杂色像素。还有物体边缘,比如玻璃杯的轮廓,GAN 很容易在转角处出现「犹豫」,线条忽粗忽细,或者和背景融合得莫名其妙。

光照逻辑混乱也很常见。一张室内照片里,人物脸上的高光方向和窗户位置完全对不上;或者阴影里突然冒出一块亮斑,找不到光源。这是因为 GAN 虽然能学光影效果,却理解不了物理规律,只能靠海量数据「猜」,遇到复杂场景就露馅。

还有些更隐蔽的痕迹。比如重复图案,GAN 喜欢在背景里偷偷复制粘贴,比如墙壁上的花纹、草地的色块,仔细看会发现有规律性的重复。元数据里的「小异常」也能说明问题,有些生成工具会在图片信息里留下特定标识,或者完全没有拍摄设备信息 —— 正常照片可不会这样。

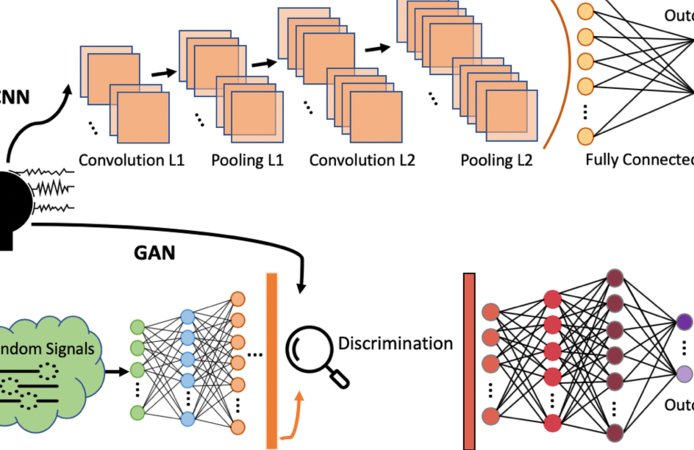

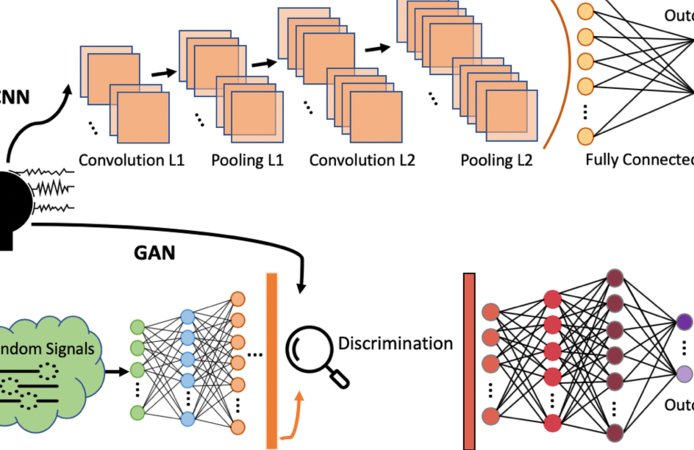

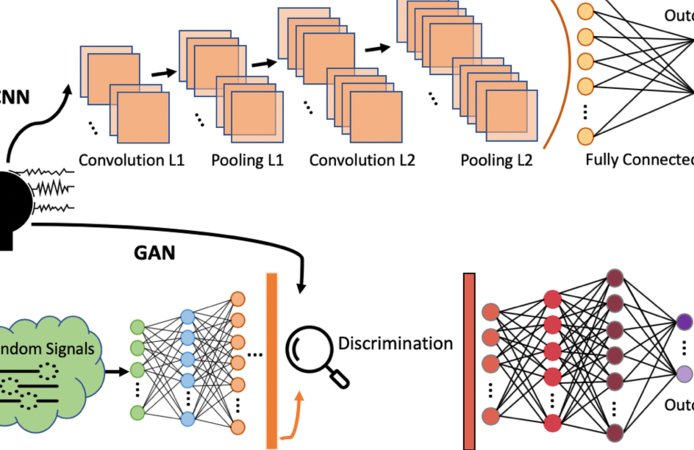

🔍 检测技术的「三板斧」与致命短板

现在检测 GAN 生成图片,主流思路就三个方向,但没一个能包打天下。

像素级分析是最传统的方法。通过算法扫描图片的像素分布,找那些不符合自然规律的地方。比如 GAN 生成的图片在高频信息(细节纹理)上往往有缺失,或者某个颜色通道的数值异常。但问题是,现在的 GAN 模型迭代太快,去年能识别的像素特征,今年就可能被修复。而且一旦图片经过压缩、裁剪,这些像素痕迹很容易被破坏,检测准确率立马跳水。

元数据和 EXIF 信息检查更简单直接。正常照片会记录相机型号、快门速度、GPS 定位这些信息,AI 生成的图片要么这些信息空白,要么带有生成工具的「数字水印」。但这招太容易被破解了 —— 稍微懂点技术的人,用工具修改一下元数据,就能让 AI 生成的图片看起来像用某款单反拍的。现在网上流传的很多 AI 假照片,早就学会了「伪造身份」。

深度学习检测模型是这两年的新宠。用大量 GAN 生成图和真实图训练 AI,让它自己学会区分两者。比如 Google 的 Fake Image Detector,还有斯坦福大学开发的检测模型,准确率一度能达到 90% 以上。可尴尬的是,GAN 和检测模型就像「矛和盾」,检测模型刚升级,新的 GAN 生成技术就针对性优化。去年有研究显示,只要在生成图片时加入微小的噪声干扰,就能让主流检测模型的准确率降到 50% 以下,跟瞎猜没区别。

🛠️ 主流检测工具实战对比:谁在「裸泳」?

市面上吹得神乎其神的检测工具,实际用起来差距大得离谱。

Forensically 是最早火起来的免费工具,靠分析图片的噪声模式和像素一致性判断真伪。优点是操作简单,上传图片就能出结果。但实测发现,它对早期 GAN 模型(比如 DCGAN)生成的图片识别率还行,遇到 Stable Diffusion、Midjourney 这类新模型,经常把真图误判成假图,尤其是风景照,错得一塌糊涂。

Hive AI 的检测工具主打商业化,宣称支持多模型识别,还能标出生成痕迹的具体位置。在电商平台和新闻机构用得不少。但它的短板是对低分辨率图片无能为力,低于 500x500 像素的图片,检测结果基本不可信。而且收费不便宜,中小公司很难负担长期使用成本。

还有些学术圈的工具,比如 UC Berkeley 开发的 GAN Detector,准确率确实高,但需要用户懂代码,普通用户根本玩不转。而且这些工具更新太慢,实验室里的研究成果转化到实际应用,往往滞后半年以上,等它能识别的漏洞,早就被 GAN 模型修复了。

更麻烦的是,所有工具都扛不住「二次加工」。一张 AI 生成的图片,用手机微信传一遍,自动压缩后再检测,大部分工具都会失效。或者稍微调个亮度、加个滤镜,检测准确率立马掉 30% 以上。

⚔️ 反制技术:GAN 的「自我进化」与检测方的被动挨打

现在的情况是,检测技术刚往前挪一步,反制手段就立马跟上,完全是被动防守。

最直接的反制就是「修复痕迹」。GAN 模型在生成图片后,会自动运行「修复算法」,专门针对已知的检测特征优化。比如发现检测工具对头发边缘敏感,就重点训练头发生成模块;知道像素分布有规律会被识别,就故意加入随机噪声打乱分布。现在新出的模型,生成图片后还会模拟相机的光学特性,比如加入镜头畸变、传感器噪声,让图片看起来更「真实」。

「混合生成」也是常用手段。把 AI 生成的部分和真实图片拼接,比如用 GAN 生成人物,再把人物合成到真实的风景照里。这种半真半假的图片,检测工具很难判断 —— 识别出人物是生成的,但背景是真实的,最终结果就会模棱两可。

还有更狠的,直接攻击检测工具本身。通过对抗样本技术,在 AI 生成的图片里加入人眼看不到的微小扰动,这些扰动不会影响图片观感,却能让检测模型彻底失效。去年就有研究团队演示过,用这种方法能让主流检测工具的准确率从 95% 降到 10% 以下。

检测方的应对就很狼狈了。只能不断收集新的生成样本,重新训练模型。但这个过程至少需要几周时间,而 GAN 模型的更新速度是以天计算的。这种「追着跑」的模式,注定了检测技术永远慢半拍。

🌐 实际场景里的「暗战」:从新闻到司法的棘手难题

别以为这只是技术圈的事,现实里早就打得不可开交了。

新闻行业是重灾区。去年有个国际新闻网站用 AI 生成了一张战争场景图,画面里的士兵表情僵硬,武器细节模糊,但因为场景够震撼,被几十家媒体转发。等发现是假的时,谣言已经传遍全网。现在很多媒体编辑部都被逼着用检测工具,但误判率太高 —— 有次把一张真实的灾区照片当成 AI 生成的,差点耽误了新闻发布。

电商平台更头疼。商家用 GAN 生成虚假的产品图,比如把普通衣服 P 成大牌质感,把小作坊环境改成无菌车间。这些图片经过多次处理,检测工具很难识别。消费者收到货发现货不对板,平台维权都找不到依据 —— 毕竟图片真假难辨。

司法领域的挑战更大。去年有个诈骗案,嫌疑人用 AI 生成受害者的「不雅照」敲诈勒索。警方抓到人了,却因为没法 100% 证明照片是生成的,差点定不了罪。现在法庭上对 AI 生成图片的认定标准还一片混乱,不同检测工具给出的结果可能完全相反,法官都不知道该信哪个。

社交媒体的审核更是防不胜防。每天上传的图片数以亿计,不可能一张张用高精度工具检测。只能靠低精度的快速筛查,漏网之鱼太多。有些用户故意把 AI 生成图和真实图混着发,系统根本分辨不出来。

🚀 未来的「破局点」在哪里?

别指望有一劳永逸的解决方案,这场攻防战会一直持续下去,但几个方向可能会改变战局。

多模态检测或许是条出路。光看图片本身不够,结合文字描述、发布场景来判断。比如一张声称「野生华南虎」的照片,结合当地是否有华南虎栖息地、拍摄者的身份信息,再配合图像检测,可信度就高多了。现在已经有团队在开发这种跨模态模型,准确率比单一图像检测提升了 30% 以上。

区块链存证可能从源头解决问题。让每一张真实照片在拍摄时就上链存证,记录拍摄设备、时间、地点等信息,无法篡改。AI 生成的图片没有这些存证,一查就露馅。但这需要整个行业统一标准,相机厂商、社交平台、检测工具都得配合,短期内很难实现。

监管层面的介入必不可少。现在对 AI 生成内容的标识还没有强制规定,有些工具会自动加水印,有些则完全不标。如果要求所有 AI 生成图片必须嵌入不可见的数字水印,检测难度会大大降低。欧盟已经在推进相关立法,国内也有这方面的讨论,这可能是最快见效的办法。

技术圈还有个更激进的想法:用 GAN 对抗 GAN。训练专门识别最新 GAN 模型的「对抗检测器」,让检测模型和生成模型同步进化。但这需要海量的计算资源,只有大公司玩得起,中小企业根本跟不上。

说到底,这场战争的核心不是技术优劣,而是「信息不对称」的博弈。只要普通人还分不清 AI 生成和真实图片的区别,就总会有人钻空子。或许未来最有效的办法,是让公众的识别能力也同步提升 —— 就像现在大家知道 PS 能修图一样,慢慢学会用批判性眼光看待网上的图片。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】