现在打开社交媒体、论坛或者投稿平台,你刷到的文字内容里,可能有三成以上都是大模型生成的。不是说 AI 写的东西不好,而是很多时候我们需要知道内容的 "真实身份"—— 比如老师要判断学生作业是不是自己写的,编辑要确认投稿有没有用 AI 凑数,甚至做内容创作的同行,也得知道竞争对手是不是在用 AI 批量产文。

但问题来了,怎么才能快速分辨一段文字是不是 AI 写的?靠感觉?我试过,上次把自己写的文案当成 AI 生成的,闹了笑话。问同行,他们要么说用付费工具,要么就是凭经验猜。直到前阵子发现一个免费工具,测了几十段文字后,准确率确实比我肉眼判断高多了。

🕵️为什么一定要检测 AI 生成内容?这几个场景太常见了

先说说检测这事儿到底有多重要。上个月帮朋友审核一个自媒体账号的内容,对方说全是原创,结果用工具一测,十篇里有八篇 AI 生成概率超过 90%。后来才知道,他们是用 AI 写初稿,改几个词就发,平台早就标记了这种账号,流量一直上不去。

学术场景更不用多说。现在大学论文查重系统已经开始对接 AI 检测功能,有学生用 ChatGPT 写课程作业,被老师发现后直接打回重写。不是说不能用 AI 辅助,但完全照搬就踩了红线。

还有职场里,领导让写一份市场分析报告,有人图省事用 AI 生成后直接交,结果里面的数据引用错误都没发现。这种时候,如果能提前用工具测一下,至少能知道哪些部分需要重点核对修改。

最关键的是内容版权问题。很多平台现在明确规定,AI 生成内容需要标注,不标注就可能被判定为违规。万一不小心用了没标注的 AI 内容,账号可能被限流,得不偿失。

🔍常见的检测方法有哪些?别再只靠 "读着顺不顺" 了

之前听人说,AI 写的东西 "太完美",没有错别字,逻辑太顺畅,这就是特征。但现在大模型升级太快,故意加几个错别字、用点口语化表达,普通人根本看不出来。

试过几个付费工具,比如 Originality.ai,准确率确实高,但按月收费,最低也要 15 美元,对偶尔用一次的人来说不划算。还有些浏览器插件,要么检测速度慢,要么经常误判 —— 把一段很规整的手写文案当成 AI 生成的。

也问过做 NLP 的朋友,他们说可以看 "语义跳跃度"。人类写作经常会有突然的想法插入,比如写着产品特点,突然加一句用户反馈的例子;但 AI 更倾向于按逻辑线性推进,很少有这种 "意外转折"。但这方法太主观,没经验的人根本掌握不了。

直到发现 "GPTZero" 这个工具,免费版就能满足日常检测需求,而且最近更新后,对国内大模型生成的内容也能识别,比如文心一言、讯飞星火这些写的文字,检测准确率比之前高了不少。

🆓推荐工具:GPTZero 怎么用?三步就能出结果

先说下这个工具的背景,是美国普林斯顿大学的一个团队开发的,初衷就是帮老师检测学生作业。现在免费版支持单次检测 1000 字以内的文本,对大部分场景来说够用了。

第一步,打开官网(gptzero.me),不用注册登录,直接在首页就能看到输入框。注意别进错山寨网站,正规网站域名很简单,就是 "gptzero.me",页面设计也很简洁,没有乱七八糟的广告。

第二步,把要检测的文字复制粘贴进去。我试过粘贴 Word 里的内容,带格式的话会自动去掉,不影响检测结果。如果是 PDF 里的文字,最好先转成纯文本再粘贴,避免格式干扰。

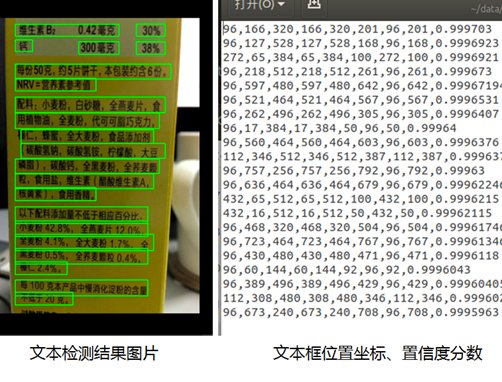

第三步,点 "Get Results" 按钮,等个三五秒就出结果。页面会显示两个核心数据:"Overall AI Probability"(整体 AI 生成概率)和 "Sentence Breakdown"(逐句分析)。概率超过 70% 的话,基本就能判定是 AI 生成的;如果在 30%-70% 之间,可能是人类写的但用了 AI 润色;低于 30%,大概率是纯手写。

有次测了一段自己写的游记,里面有不少口语化的短句,比如 "那天雨下得特别大,伞根本没用,头发全湿了",检测结果显示 AI 概率只有 12%。但把这段文字用 ChatGPT 润色后再测,概率直接升到 89%——AI 把 "头发全湿了" 改成 "发丝被雨水浸透,贴在脸颊上",虽然更优美,但也暴露了特征。

📊检测结果怎么看?这几个指标别忽略

很多人只看整体概率,其实逐句分析更有价值。比如一段文字整体 AI 概率 60%,但逐句看的话,可能前半段全是 AI 生成,后半段是人类补充的。这种情况大概率是先用 AI 写初稿,再手动修改了部分内容。

注意看 "Confidence"(置信度)。如果某个句子后面标着 "High",说明工具对这个判断很有把握;标 "Medium" 的话,可能需要结合上下文再分析。我遇到过一次,一段描写景色的文字,因为用词太规整,被标为 "High AI Probability",但其实是一位作家朋友写的 —— 只能说,现在人类写的东西太工整,也会被误判。

还有个隐藏功能,点 "Advanced Analysis" 能看到 "Perplexity"(困惑度)和 "Burstiness"(突发性)。简单说,困惑度越低,说明 AI 越容易生成这样的句子;突发性越高,越可能是人类写作 —— 因为人类思维跳跃更大,AI 则更平稳。

⚠️这些情况会影响检测 accuracy,一定要注意

不是所有文字都能准确检测。比如少于 50 字的内容,工具经常会提示 "Insufficient Text",因为样本太少,特征不明显。这种时候要么找更长的文本,要么结合其他方法判断。

如果文字是翻译过来的,检测准确率会下降。试过把一段英文 AI 生成内容翻译成中文再检测,AI 概率从 92% 降到了 65%。因为翻译过程中会改变句式结构,掩盖原本的 AI 特征。

还有用了 "AI 降重" 工具处理过的文字,也可能让检测结果不准。现在有些工具专门帮人修改 AI 生成的内容,让它更像人类写的,这种情况下,建议多换几个检测工具交叉验证。

另外要注意,不同大模型生成的文字,检测难度不一样。比如 GPT-4 生成的内容,比 GPT-3.5 更难被识别;国内的一些大模型,因为训练数据更偏向中文,用国外的检测工具可能准确率低一些。这种时候可以试试国内的检测工具,比如 "智谱 AI 检测",虽然免费额度少,但对中文内容更敏感。

📌最后说句实在话:工具是辅助,判断力更重要

用了两个月检测工具,最大的感受是:它能帮你省 80% 的判断时间,但不能完全代替人的思考。有次检测一篇公众号文章,AI 概率 95%,但仔细看内容,里面有很多作者个人经历的细节,后来才知道,作者是用 AI 整理自己的口述内容 —— 这种情况,工具只能告诉你 "文字像 AI 生成",但背后的创作过程还得靠人去了解。

说到底,检测不是为了排斥 AI,而是为了更合理地使用它。就像计算器发明后,我们还是要学算术,但不影响用计算器提高效率。重要的是搞清楚 "哪些是 AI 做的","哪些需要人来把控",这才是检测工具真正的价值。

如果你也经常需要处理文字内容,不妨存一下 GPTZero 这个工具,偶尔测一测,至少能避免很多不必要的麻烦。当然,也别太依赖,毕竟最好的检测标准,永远是 "这段文字有没有真实的思考和情感"—— 机器能模仿文字,却很难模仿真正的表达欲。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 -