📌 大模型文本检测到底在 "检测" 什么?

很多人第一次听到 "大模型文本检测",都会觉得这是个很玄乎的技术活。其实说白了,它就是让机器当 "文字侦探",分辨一段文字是出自人类之手,还是 AI 大模型的杰作。

你可能会问,这有什么难的?人写的和机器写的,读起来不都差不多吗?还真不是。就像每个人说话有自己的口头禅,AI 生成的文字也藏着独特的 "语言指纹"。这些指纹可能是重复出现的句式,可能是过于完美的逻辑结构,也可能是某些特定词汇的高频使用。

举个简单例子。人类写东西时,偶尔会用 "嗯"" 这个 ""其实" 这类口语化的词,甚至会出现少量重复或不影响理解的小错误。但 AI 生成的文本往往更 "规矩",句子之间衔接得过于平滑,反而少了点人情味。大模型文本检测,就是要抓住这些细微的差别。

现在这个技术用得可不少。学校老师用它查学生作业是不是 AI 写的,媒体编辑用它核实投稿来源,企业 HR 筛选简历时也会扫一眼,就连自媒体平台都靠它判断内容原创性。说白了,不是要跟 AI 对着干,而是想搞清楚文字背后的 "真实身份"。

🔍 AI 检测的底层逻辑:像查字典一样比对特征

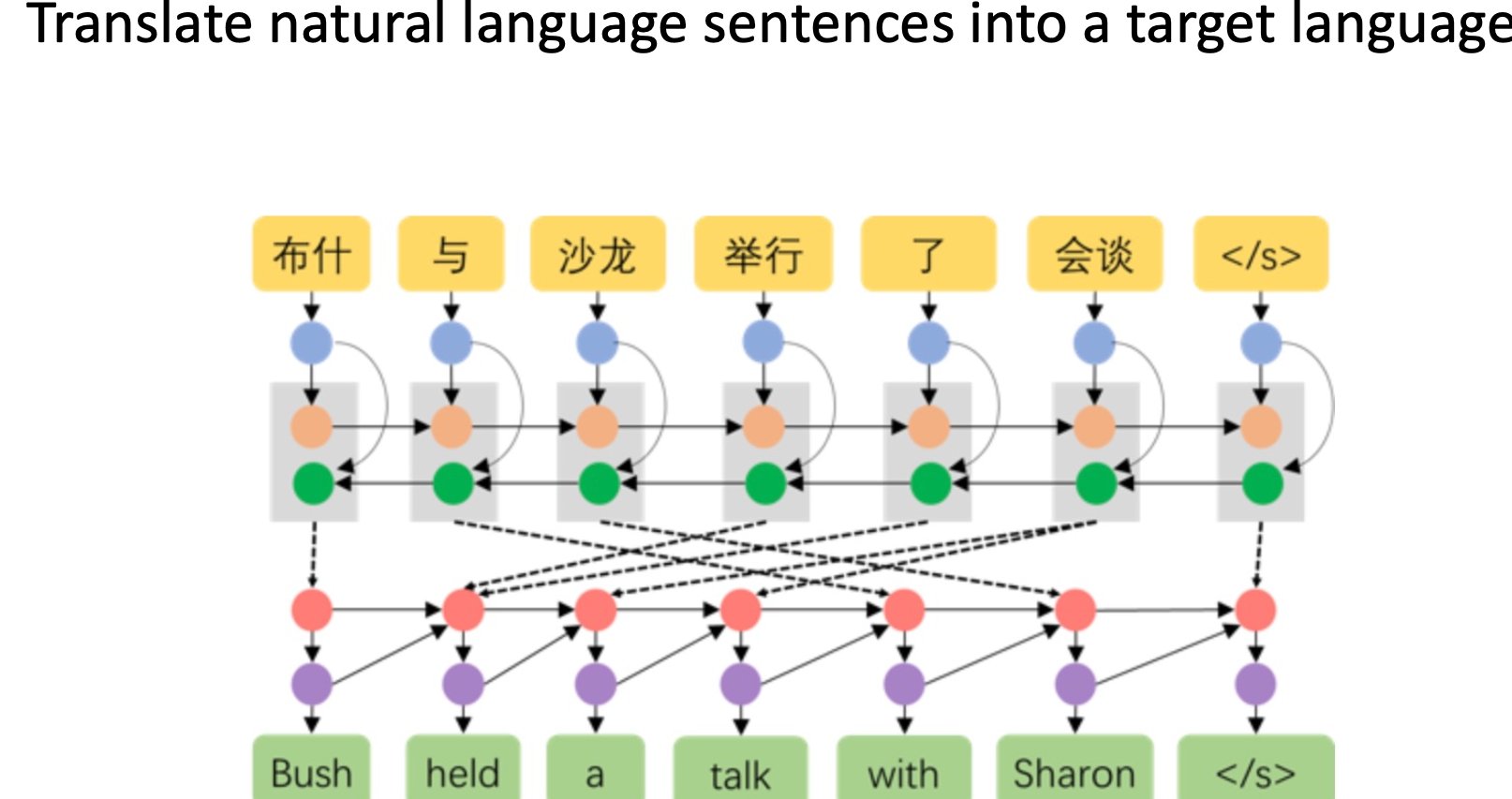

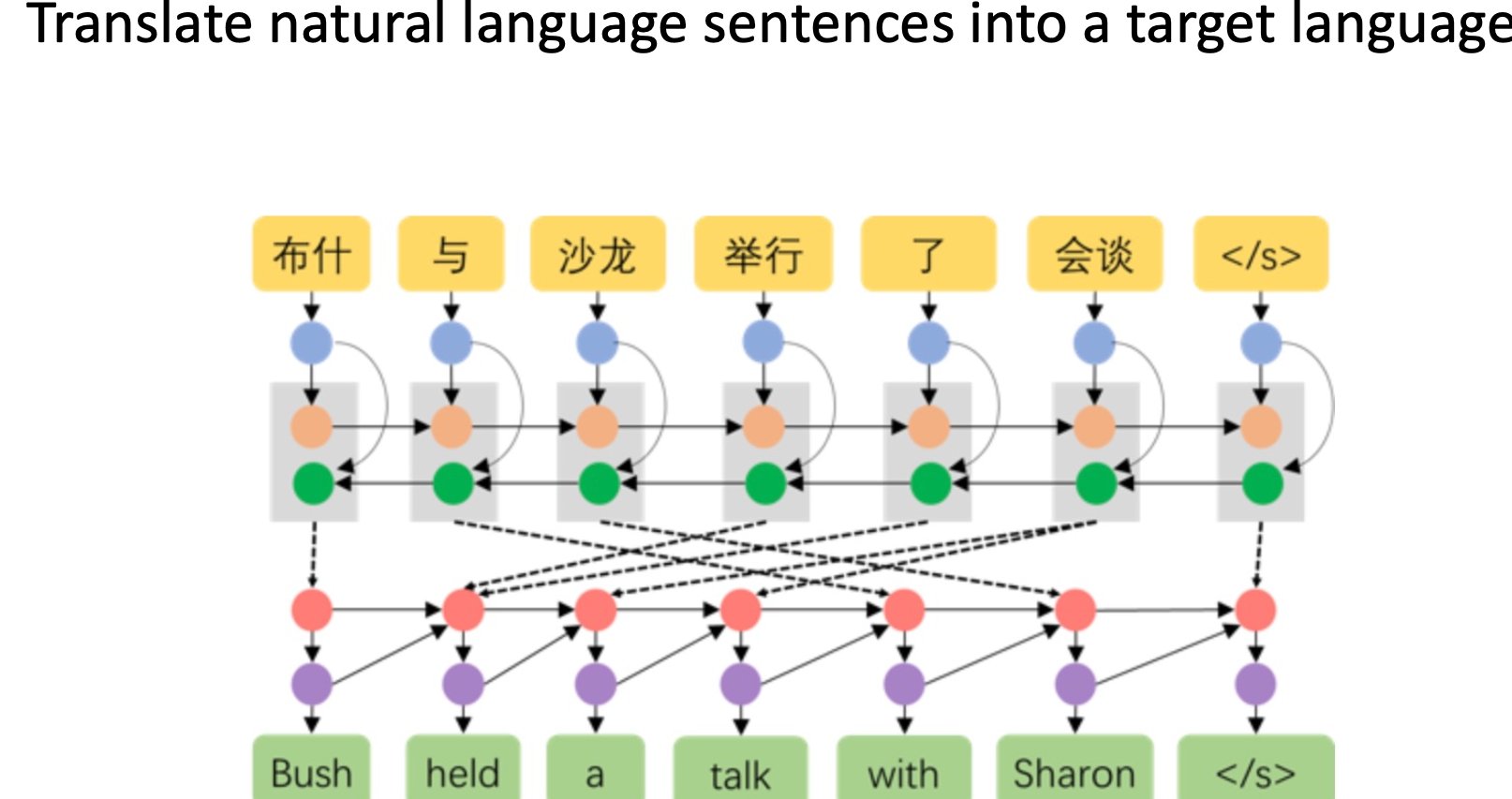

要理解 AI 检测原理,不用先学编程。你可以把它想象成我们查字典的过程 —— 先建立一个 "特征库",再拿待检测文本去比对。

这个 "特征库" 里存的是什么?主要是两类东西:人类写作的典型特征,和 AI 生成的典型特征。比如人类写议论文时,观点可能来回摇摆,会用 "我认为"" 可能 ""不过" 这类表达不确定性的词;而 AI 写的往往观点更集中,语气更肯定。这些差异都会被转化成数据,存到特征库里。

检测的时候,系统会给文本做 "全身扫描"。先拆分成句子、词语,甚至是标点符号的使用习惯,然后逐个和特征库比对。如果某段文字里,AI 特征出现的频率超过了设定的阈值,就会被标记为 "可能是 AI 生成"。

有意思的是,不同检测工具的特征库长得不一样。有的侧重语法结构分析,有的擅长捕捉语义逻辑,还有的专门盯标点符号的使用规律。就像不同的侦探有不同的破案风格,有的看现场痕迹,有的查人际关系。

你可能会好奇,这些特征库是怎么建起来的?其实就是用大量样本 "训练" 出来的。工程师会给系统喂成千上万篇已知来源的文本 —— 明确是人类写的,或者明确是 AI 写的,让系统自己总结规律。样本越多,特征库就越完善,检测 accuracy 也就越高。

但这里有个小问题:AI 模型一直在升级,生成的文本越来越像人类写的。这就好比小偷在不断换手法,侦探也得跟着更新知识库。所以检测工具也得定期 "进修",更新特征库,不然就可能跟不上 AI 的进化速度。

🚀 主流检测工具的 "独门绝技":各有各的看家本领

市面上的 AI 检测工具不少,功能看着差不多,实则各有侧重。了解它们的特点,非技术人员也能选对工具。

先说说 GPTZero。这个工具火了挺久,特点是对长文本的检测特别准。它主要看两个指标:"困惑度" 和 "burstiness"。困惑度低,说明文本对 AI 模型来说很 "好懂"(可能就是它自己生成的);burstiness 低,说明句子长度变化小,这也是 AI 文本的常见特征。老师查论文时爱用它,因为论文通常篇幅长,特征更明显。

Originality.ai 则更擅长短文本检测。比如社交媒体上的帖子、短评论,它能从寥寥数语中抓特征。它的秘诀是结合了语义分析,不只是看表面的词语,还会分析上下文逻辑。很多自媒体运营者喜欢用它,毕竟短视频文案、朋友圈文案都不算长。

还有 Copyscape 这类老牌工具,虽然不是专门针对 AI 检测的,但它的 "全网比对" 功能很实用。如果某段文字和网上已有的 AI 生成内容高度相似,也能间接说明问题。企业做内容审核时,常把它和专门的 AI 检测工具搭配着用。

值得注意的是,没有哪款工具能做到 100% 准确。有时候,特别严谨的人类作者写出的文字,可能被误判为 AI 生成;而故意模仿人类语气的 AI 文本,也可能蒙混过关。所以专业人士通常会交叉使用 2-3 款工具,综合判断结果。

💡 非技术人员的实用判断法:靠 "直觉" 也能识别 AI 文本

不用工具,普通人也能通过几个小技巧,初步判断文本是不是 AI 生成的。这些方法虽然不绝对,但准确率不低。

先看 "冗余度"。AI 生成的文本常常有点 "凑字数" 的嫌疑。比如描述一个场景,人类可能会聚焦 1-2 个细节,而 AI 可能会把相关元素都罗列一遍,显得面面俱到却缺乏重点。你读的时候如果觉得 "说得都对,但有点啰嗦",就得留个心眼。

再看 "观点的独特性"。人类写作时,很容易带出个人经历或小众视角。比如写 "旅行体验",可能会提到某个不起眼的小餐馆;而 AI 更倾向于描述大众熟知的景点和体验。如果一篇文章的观点都很 "安全",很少有个性化表达,大概率是 AI 的手笔。

还有个小窍门:看 "错误率"。人类写东西难免有笔误、重复,或者逻辑上的小跳跃。AI 生成的文本则很少出错,甚至有点 "完美过头"。特别是在专业领域,比如法律条文、技术说明,如果通篇没有任何表述瑕疵,反而不太正常。

你还可以故意挑刺。比如在文本中找一个观点,顺着往下追问,看逻辑能不能一直保持顺畅。人类写的东西,即使有漏洞,也能看出思考的轨迹;而 AI 生成的,可能在某个节点突然 "卡壳",或者开始重复前面的内容。

这些方法不用记公式,多对比几篇已知来源的文本,慢慢就能培养出 "语感"。就像我们听口音能大概判断一个人来自哪里,读多了也能感觉出文字的 "出身"。

⚠️ AI 检测的灰色地带:不是所有 "AI 生成" 都该被否定

聊到 AI 检测,有个误区得澄清:不是所有 AI 生成的文本都 "有问题"。技术本身是中性的,关键看怎么用。

现在很多创作者会用 AI 做辅助:比如让 AI 列提纲,自己补充细节;或者用 AI 生成初稿,再大幅修改。这种 "人机协作" 的文本,到底算人类创作还是 AI 生成?目前的检测工具还很难界定。有些平台已经开始调整规则,不单纯禁止 AI 生成内容,而是要求创作者主动标注。

还有个更复杂的情况:不同语言的检测标准不一样。中文 AI 生成的文本,和英文 AI 生成的文本,特征有很大差异。现在很多检测工具是基于英文语料训练的,用来检测中文文本,准确率会打折扣。这也是为什么中文内容平台,往往会结合人工审核,而不是完全依赖机器。

更值得思考的是 "检测目的"。学校用 AI 检测,是为了保证学生真正掌握知识;媒体用,是为了维护内容真实性;但如果用在过度监控、限制创作自由的地方,就可能违背技术初衷。作为使用者,我们得想清楚:检测的目的是为了什么?是为了划清界限,还是为了更好地引导合理使用?

技术一直在进步,未来可能会出现 "反检测" 的 AI—— 专门生成能骗过检测工具的文本。到时候,检测与反检测的博弈还会升级。但对普通人来说,保持开放心态更重要:既了解 AI 的能力边界,也不排斥技术带来的便利。

📝 入门者的行动指南:从 "知道" 到 "会用"

学了这么多,该怎么上手实践?给非技术人员几个简单的行动步骤,看完就能用。

第一步,选两款工具练手。推荐先试试 GPTZero 和Writer.com的 AI Content Detector,都是免费版就能满足基础需求。找几篇自己写的文章,再找几篇明确是 AI 生成的(比如用 ChatGPT 直接生成的短文),对比检测结果,看看特征差异在哪里。

第二步,建立自己的 "对比库"。平时看到好文章,顺手存下来,标记清楚来源 —— 是人类原创、AI 生成,还是人机协作。积累多了,翻一翻就能直观感受到差异。这个方法虽然原始,但比记理论有效得多。

第三步,试着 "反向操作"。用 AI 生成一段文本,然后自己逐句修改,每改一次就去检测,看结果怎么变化。你会发现,有时候只需要加几个口语化的词,或者故意留个小瑕疵,就能让检测结果从 "AI 生成" 变成 "大概率人类创作"。这个过程能帮你更直观理解哪些特征最影响检测结果。

第四步,关注行业动态。AI 检测技术更新很快,订阅几个科技媒体的简讯,比如 The Verge 的 AI 专栏,或者国内的 "机器之心" 公众号,不用深读,看标题和摘要就行,知道最近出了什么新工具、有什么新发现。

最后提醒一句:别追求 "100% 准确"。就连专业人士也做不到。对非技术人员来说,能通过检测工具和自己的判断,提高对文本来源的敏感度,就已经足够了。技术是辅助,不是标准答案。