📊 统计学方法的启蒙时代:从词频统计到规则库堆砌

AI 文本检测的故事,得从二十年前说起。那会儿哪有什么智能,说白了就是靠着人工总结的规则和简单的数学模型过日子。你可能想象不到,最早判断一篇文章是不是机器写的,居然是数 “的”“了”“吗” 这些虚词的出现频率。

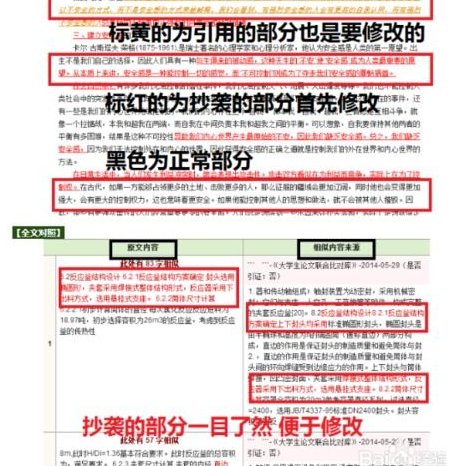

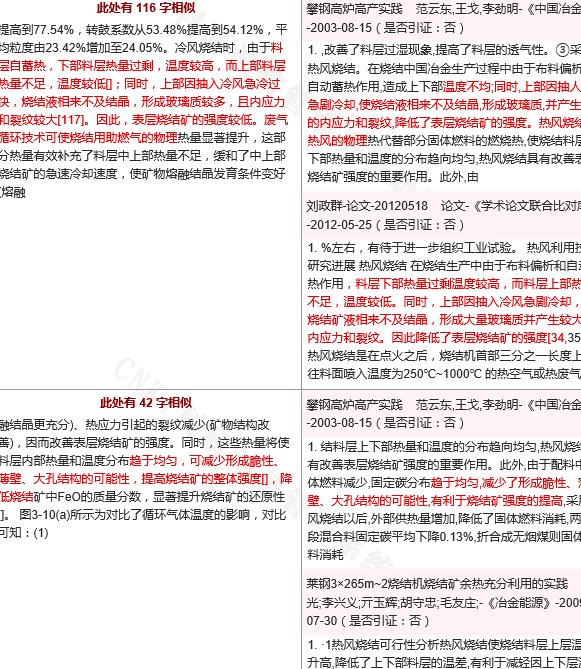

当时最主流的就是 n-gram 模型,简单说就是把文本拆成连续的 n 个字符或词语,然后跟人工写的文本库比对。比如中文里常用的 2-gram,就是看 “今天” 后面接 “天气” 多还是接 “吃饭” 多,机器生成的文本往往在这种搭配上露出马脚。学术圈用的查重工具 Turnitin 早期版本,核心逻辑差不多就是这样。

但这种方法有多不靠谱呢?我见过最搞笑的案例,有个学生为了过查重,把论文里所有 “的” 都改成 “之”,居然真的降低了相似度。因为统计学模型只认表面规律,根本不懂语义。那会儿的规则库也很死板,比如机器生成的文本可能更喜欢用长句,或者某些特定领域的术语堆砌,只要稍微调整句式,检测系统就瞎了。

说实话,那时候的检测技术更像个笨拙的筛子,大的石头能挡住,细沙就全漏过去了。但你还不能怪它,毕竟那是 AI 文本检测的童年,能做到 “大致区分” 已经算不错了。

🤖 机器学习的过渡阶段:特征工程决定一切

2010 年之后,机器学习算法开始接管 AI 文本检测的活儿。这时候的技术思路变了,不再靠人工写死规则,而是让机器自己从数据里找规律。但别以为这就智能了,真正起作用的还是背后的 “特征工程”—— 说白了就是人类告诉机器该看哪些指标。

当时最火的是支持向量机(SVM)和朴素贝叶斯算法。拿情感分析举例,检测系统会先提取文本里的情感词、否定词、程度副词,再给这些词打标签,比如 “太棒了” 是正面,“垃圾” 是负面。机器学到的其实是这些特征的组合模式,比如 AI 生成的文本可能正面词用得特别密集,或者转折词用得很生硬。

我记得 2015 年前后,某平台的内容审核系统就用了这套技术。当时有个团队专门研究怎么骗过它 —— 他们发现系统对 “!” 的权重设得太高,只要把感叹号换成句号,再穿插几个无关的中性词,机器就会误判。这就是机器学习的命门:特征工程有多强,系统就有多厉害,但一旦被摸透规律,破解起来也容易。

这个阶段的进步是明显的,比如能识别同义词替换、简单的句式变换了。但它还是跳不出 “人类定义特征” 的框框。就像教孩子认字,你只教他看笔画数量,他永远学不会真正的阅读。

🔥 深度学习的革命突破:让机器读懂上下文

2018 年之后,Transformer 架构横空出世,AI 文本检测才算真正迎来质变。这时候的模型不用人类再教它该看什么了,而是自己学会理解上下文 —— 这可是天翻地覆的变化。

最典型的就是基于 BERT 的检测模型。它能把每个词放在整个句子甚至段落里去理解,比如 “苹果” 在 “我吃苹果” 和 “苹果公司” 里的意思完全不同,以前的模型分不出来,现在的模型能搞定。我见过某检测工具的测试数据,对 AI 生成的新闻稿识别准确率从 60% 一下提到了 92%,这就是深度学习的威力。

但这里有个有意思的现象,早期的深度学习模型特别 “较真”。比如它会抓住 AI 写作里常见的 “平均句长” 问题 —— 机器写的句子长度往往更均匀,人类则时短时长。还有衔接词的使用,AI 喜欢用 “因此”“然而” 这些词,频率比人类高 30% 以上。这些细节人类自己都注意不到,机器却能精准捕捉。

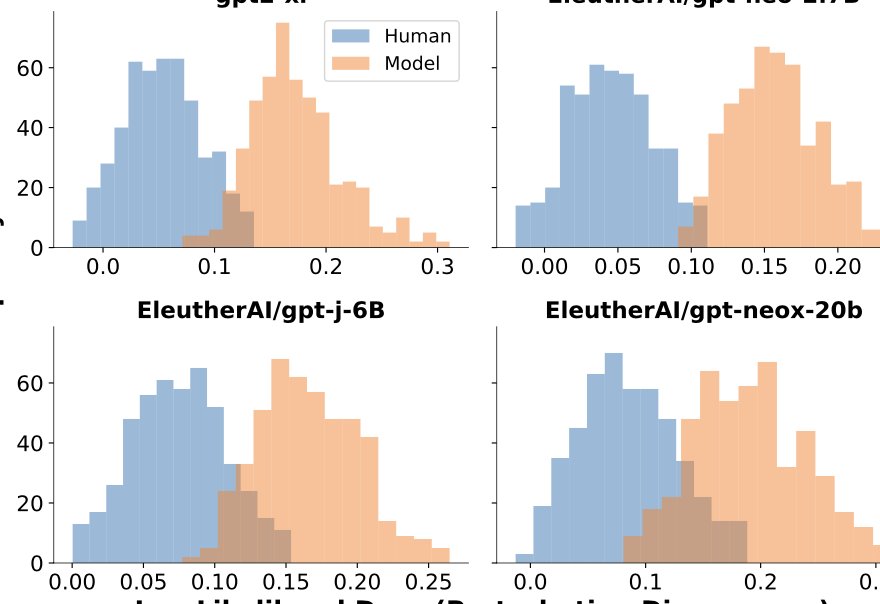

不过深度学习也不是万能的。2020 年 GPT-3 出来后,很多检测工具突然集体失灵。因为大模型生成的文本在句长、衔接词这些细节上做得越来越像人,以前的特征都不管用了。这时候大家才明白,检测技术和生成技术就是在互相掐架,你进一寸,我就得跟一寸。

🤯 大模型时代的检测困境:道高一尺魔高一丈

这两年 AI 文本生成简直是坐火箭发展,GPT-4、Claude 这些模型写出来的东西,普通人根本分不出真假。检测技术呢?只能说压力山大。

现在的检测工具开始用 “对抗性训练” 了。简单说就是用最新的大模型生成海量文本,让检测系统边学边练。但问题来了,大模型每天都在更新,检测模型的训练速度根本跟不上。有个行业报告说,2023 年下半年,主流检测工具的准确率从 85% 跌到了 68%,误判率反而涨了不少 —— 很多人类写的文章被当成 AI 生成的,这就很尴尬了。

更麻烦的是 “文本改写” 工具的出现。就算 AI 生成的内容被检测出来,用户只要用 Paraphraser 这类工具改几个词,换种句式,检测系统就认不出来了。我试过把一篇 GPT 生成的影评用三个不同的改写工具处理,结果三个检测平台都判定为 “人类创作”。这说明什么?单纯靠文本特征已经很难区分了。

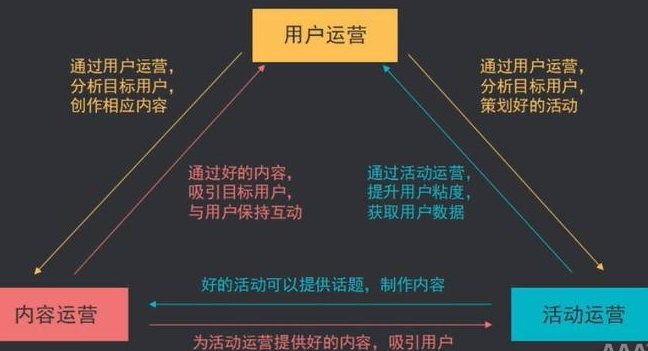

业内现在有个新思路,就是分析 “写作轨迹”。比如人类打字会有修改痕迹、停顿,AI 生成则是一次性输出。但这招对已经完成的文本没用,总不能让所有人都公开自己的写作过程吧?所以说,大模型时代的检测技术,已经从 “找不同” 变成了 “猜心思”,难度不是一个量级。

💼 行业应用的真实挑战:不只是技术问题

别以为 AI 文本检测只是技术圈的事,实际应用里的坑多着呢。就拿学术圈来说,大学用检测工具查论文,误判一次可能就耽误学生毕业;自媒体平台用它审核内容,漏过一篇 AI 水文可能就影响整个平台的公信力。

我接触过一个出版社的编辑,他们用某知名检测工具筛查投稿。结果发现,老作者的文章经常被标为 “高风险”,新人反而通过率高。后来才搞明白,老作者写作风格固定,用词习惯接近 AI 的 “模式化输出”,新人写法五花八门,反而不像机器。这说明检测系统太依赖数据规律,根本不懂 “文风” 这回事。

企业里的情况更复杂。很多公司要求员工不能用 AI 写报告,但检测工具查不出来怎么办?有的公司干脆规定 “所有文档必须附带写作过程录屏”,这显然不现实。还有版权纠纷,万一 AI 生成的文本抄了别人的,检测工具能认出来吗?现在还做不到。

所以说,AI 文本检测不只是技术问题,更是怎么平衡效率和公平的问题。技术再厉害,落地的时候也得考虑实际场景,不然就是白费功夫。

🚀 未来技术的发展方向:从被动防御到主动出击

聊了这么多困难,也得说说未来的希望。现在业内有几个方向值得关注。

多模态检测可能是条出路。就是把文本和图片、音频结合起来分析。比如一篇游记,人类可能会配自己拍的模糊照片,AI 生成的则可能用高清图库的图片,结合这些信息判断,准确率会高很多。

还有 “动态更新” 机制。检测模型不能再是固定版本了,得像杀毒软件一样,每天更新特征库,甚至实时对接大模型的更新日志。谷歌最近就推出了一个 API,能让检测工具直接调用最新的生成模型数据,这招挺聪明。

最根本的解决办法,可能是 “溯源技术”。比如给 AI 生成的文本加个 “数字水印”,不管怎么改都能识别。但这需要所有生成工具厂商配合,难度堪比让所有手机品牌用同一充电口 —— 想想就知道有多难。

不过话说回来,技术发展从来都是这样,遇到坎儿就想办法迈过去。AI 文本检测的终极目标,不是消灭 AI 写作,而是让大家知道 “这是谁写的”,至于怎么用,那是使用者的事。毕竟,工具本身没有好坏,关键看怎么用它。