🔍AI 生成内容识别技术的伦理困境

AI 生成内容识别技术在快速发展的同时,首先撞进我们视野的就是隐私侵犯的问题。为了提高识别准确率,不少识别工具需要收集海量的文本、图像等数据进行训练。这些数据里,难免会混入个人隐私信息,比如私人邮件、社交媒体上的私密分享等。就拿某款文本识别工具来说,它在训练过程中抓取了大量网络上的个人博客内容,其中一些博主从未同意自己的文字被用于商业用途的技术训练。这种 “拿来主义” 式的数据收集,表面上是为了提升技术,实际上却踩过了隐私保护的红线。

更让人担忧的是,有些识别技术为了深入分析内容特征,会对用户的创作习惯、思维模式进行深度挖掘。这就好比有人在你写作时站在旁边,不仅看你写了什么,还默默记下你什么时候换行、喜欢用哪些词汇、甚至是思考时的停顿习惯。这种过度挖掘,让用户在创作时毫无安全感可言,生怕自己的 “创作 DNA” 被滥用。

算法歧视也是绕不开的伦理难题。识别 AI 生成内容的算法,是基于已有的数据模型建立的。如果训练数据本身就带有偏见,那算法自然会 “继承” 这种偏见。比如,某些识别工具对特定风格的写作内容特别 “敏感”,会把一些小众创作者的真实作品误判为 AI 生成。有位科幻作家就遇到过这种情况,他的作品风格独特,充满了奇思妙想,却被某平台的识别系统多次标记为 AI 生成,理由是 “不符合常规人类的写作逻辑”。这种因为算法偏见导致的误判,不仅打击了创作者的积极性,还可能让一些有潜力的独特作品被埋没。

而且,不同语言、文化背景下的内容,在被识别时也可能受到不公平对待。目前很多主流的识别技术,都是以英语内容为主要训练样本,对于中文等其他语言的识别精准度相对较低,还容易出现文化误读。这就导致非英语创作者的作品,被误判为 AI 生成的概率更高,在全球内容交流的大环境下,这种算法歧视无疑会加剧文化传播的不平等。

⚔️技术发展与内容真实性的冲突

技术的飞速进步,让 AI 生成内容的质量越来越高,几乎能以假乱真。这就给识别技术带来了巨大压力,为了跟上 AI 生成内容的 “进化” 速度,识别技术不得不加速迭代。可问题是,技术迭代往往只看重 “能不能识别”,却很少考虑 “该怎么合理识别”。就像一场没有终点的追逐赛,AI 生成技术往前跑一步,识别技术就必须紧追不舍,在这个过程中,内容真实性的判断标准被不断拉扯,变得越来越模糊。

有些识别技术为了追求高识别率,采用了 “宁可错杀一千,不可放过一个” 的策略。这种极端的做法,虽然能把大部分 AI 生成内容拦在门外,却也让不少真实的优质内容无辜躺枪。某学术期刊就曾因为使用了过于严苛的识别系统,导致多篇原创性极高的论文被拒稿,理由是 “部分段落的逻辑连贯性疑似 AI 生成”。这些论文的作者耗费了大量时间和精力进行研究创作,却因为识别技术的 “一刀切” 而错失发表机会,实在令人惋惜。

反过来,过度依赖技术手段来判断内容真实性,也会让人们逐渐丧失独立思考和辨别能力。现在很多人看到标有 “AI 生成” 标签的内容,就下意识地否定其价值;看到 “经识别为人类创作” 的标识,就全盘接受。这种对技术的盲目信任,会让我们慢慢变成技术的 “傀儡”,失去对内容本身的判断和思考。长此以往,内容市场可能会陷入一种 “技术说了算” 的怪圈,而不是基于内容的真实价值来评判。

技术发展还带来了新的 “造假” 与 “反造假” 博弈,进一步冲击着内容真实性的底线。有些不法分子为了让 AI 生成内容绕过识别系统,会研究识别技术的漏洞,对 AI 生成内容进行 “伪装” 处理。比如,在文本中故意加入一些语法错误、调整句子的节奏,让其看起来更像人类创作。而识别技术为了应对这种 “伪装”,又会不断升级识别维度,甚至会分析内容中的错误模式。这种无休止的博弈,让内容本身的真实性越来越不重要,重要的是能否通过技术的 “检验”,这显然违背了内容创作的初衷。

⚖️寻求平衡的可能路径

建立明确的行业伦理规范是第一步。行业内应该共同制定 AI 生成内容识别的伦理准则,明确数据收集的边界、算法使用的规范以及误判后的补救措施。就像交通规则一样,只有大家都遵守,才能保证整个行业有序运行。比如,规定识别技术在收集数据时必须获得用户的明确授权,对于涉及个人隐私的数据,必须进行脱敏处理;在算法设计上,要进行多维度的公平性测试,避免出现偏见;当出现误判时,要建立快速的申诉和纠错通道,减少对创作者的影响。

已经有一些行业组织开始尝试这样做了。某国际内容创作者协会联合技术公司、学术机构制定了《AI 内容识别伦理指南》,里面详细规定了数据使用的 “红线” 和算法公平性的评估标准。这种由多方参与制定的规范,既考虑了技术发展的需求,又兼顾了创作者的权益,值得推广。

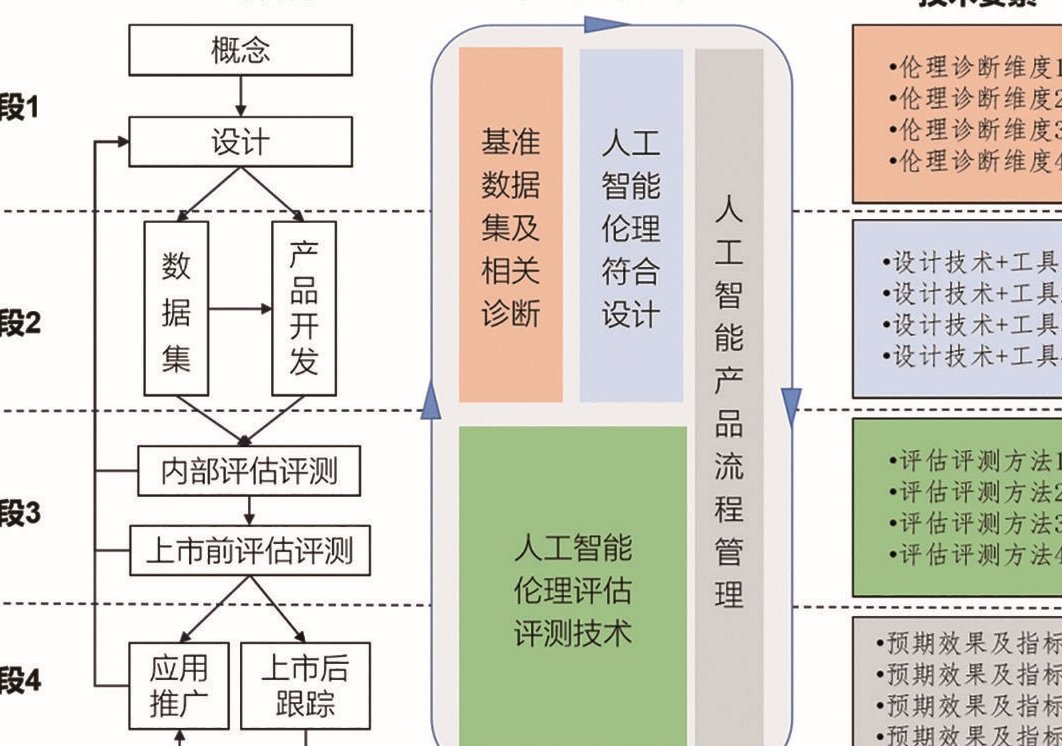

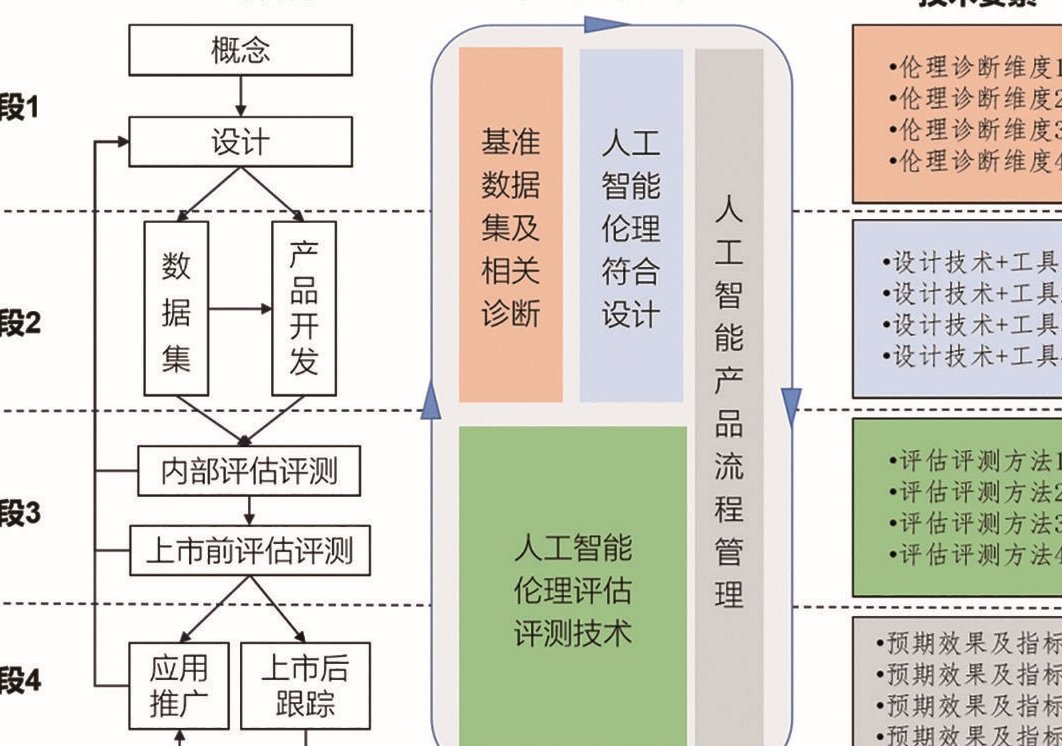

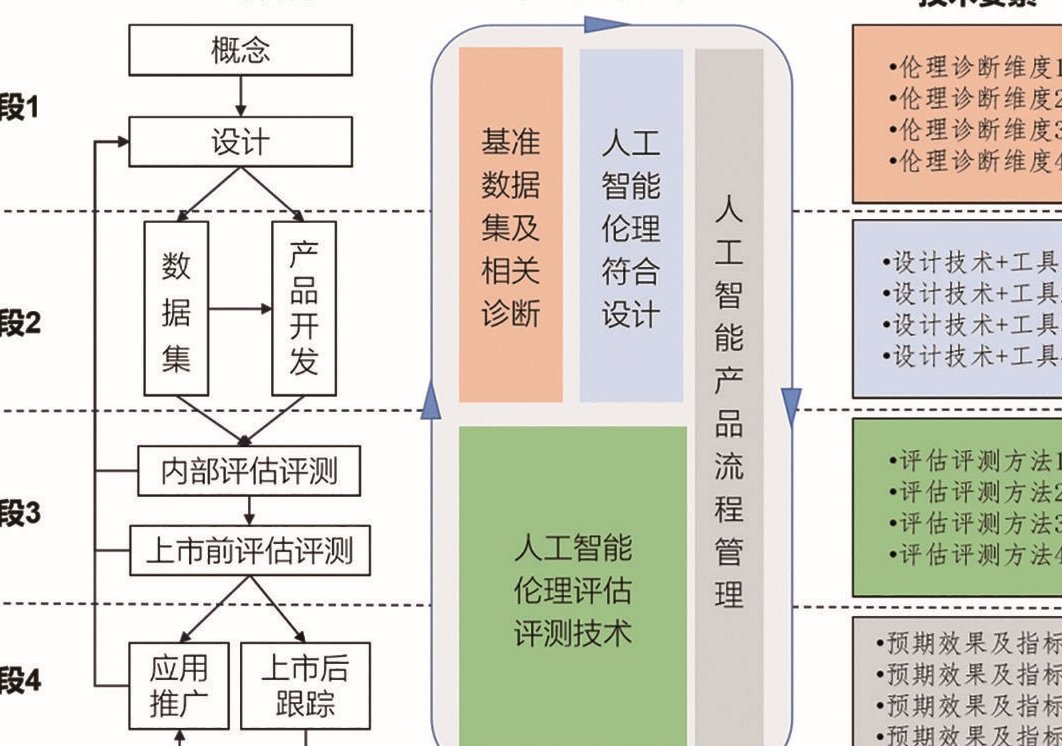

加强技术研发的伦理引导也很关键。技术本身是中性的,关键在于怎么用。在研发 AI 生成内容识别技术时,不能只盯着技术指标,还要把伦理因素纳入研发的全过程。比如,在技术设计阶段,就邀请伦理学家、社会学家参与讨论,评估可能出现的伦理风险;在技术测试阶段,不仅测试识别准确率,还要测试算法的公平性、对隐私的保护程度。

一些科技公司已经开始行动。某知名 AI 公司在研发新的识别技术时,专门成立了伦理审查小组,对技术的每个环节进行伦理评估。当发现识别技术可能会过度收集用户数据时,及时调整了技术方案,改用更轻量化的数据处理方式。这种将伦理考量融入技术研发的做法,能从源头减少伦理问题的出现。

提高公众的媒介素养也必不可少。就算识别技术再先进,伦理规范再完善,最终还是需要公众具备辨别 AI 生成内容的基本能力。可以通过学校教育、媒体宣传等方式,普及 AI 生成内容的特征和识别方法,让公众明白技术识别不是万能的,自己的独立判断同样重要。比如,教大家如何通过内容的逻辑连贯性、情感表达的真实性等方面,初步判断内容是否为 AI 生成。

一些平台也在做这方面的尝试。某内容平台推出了 “AI 内容识别科普专栏”,用通俗易懂的语言讲解 AI 生成内容的原理和识别技巧,还会分享一些典型的案例,让用户在实践中提升辨别能力。这种做法不仅能减少公众对技术的过度依赖,还能形成对 AI 生成内容的社会监督,从多个层面维护内容的真实性。

促进技术研发与人文关怀的融合也很重要。技术研发者应该多倾听创作者的声音,了解他们的需求和担忧,让技术更好地服务于内容创作,而不是成为束缚。比如,识别技术可以增加 “人性化” 的设置,允许创作者标注自己的创作风格,减少因为风格独特而被误判的概率;在识别结果的呈现上,不仅给出判断,还说明判断的依据,让创作者明白为什么会被识别,以便进行调整。

有一款文本识别工具就做得不错。它在给出识别结果的同时,会详细列出判断的依据,比如 “该文本中某类词汇的使用频率与 AI 生成模型高度相似”“句子结构的复杂度符合 AI 生成特征” 等。如果创作者对结果有异议,可以针对这些依据进行申诉,工具会根据申诉内容重新评估。这种透明化的操作,既保证了技术的严谨性,又体现了对创作者的尊重。

🚀未来展望:在伦理框架下推动行业发展

未来的 AI 生成内容识别技术,应该是 “有温度” 的技术。它不仅能准确识别 AI 生成内容,还能尊重创作者的权益、保护用户的隐私。随着技术的进步,我们可能会看到更智能的识别系统,它能根据不同的应用场景调整识别策略。比如,在新闻领域,对 AI 生成内容的识别会更严格,因为新闻的真实性至关重要;而在文学创作领域,识别系统会更宽容,给创作者更多的发挥空间。

技术与内容真实性的平衡,最终会体现在用户的信任上。当用户相信识别技术不会侵犯自己的权益,相信通过识别技术能筛选出真实有价值的内容时,整个行业才能健康发展。这需要技术研发者、内容平台、创作者和公众共同努力,形成一种良性互动的生态。技术研发者不断优化技术,兼顾效率与伦理;内容平台合理使用识别技术,不滥用权力;创作者坚守诚信原则,不刻意造假;公众保持理性判断,不盲从技术结果。

我们有理由相信,在伦理框架的指引下,AI 生成内容识别技术会成为内容创作的 “助力” 而不是 “阻力”。它能帮助我们过滤掉低质、虚假的 AI 生成内容,让优质的真实内容得到更多关注;同时,也能规范 AI 生成内容的使用,让其在合理的范围内发挥作用,比如辅助创作者进行资料整理、灵感激发等。这样,技术发展和内容真实性就能实现真正的和谐共存,推动整个内容行业迈向新的高度。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】