🕵️♂️ 大模型文本检测技术的底层逻辑:机器怎么 “认出” AI 写的字?

想搞懂 AI 生成内容能不能被检测出来,得先明白检测工具是怎么工作的。简单说,这些工具就像文字界的 “指纹识别仪”,专门找 AI 写作时留下的 “机器指纹”。

人类写东西时,脑子里的想法是跳着来的。可能突然用个生僻词,可能一句话没说完就换了话题,甚至偶尔出现语法错误。这些 “不完美” 恰恰是人类的标志。但 AI 不一样,它生成文本时更像在填数学公式 —— 基于海量训练数据算出 “最可能的下一个词”,所以写出来的内容往往太 “规整”。

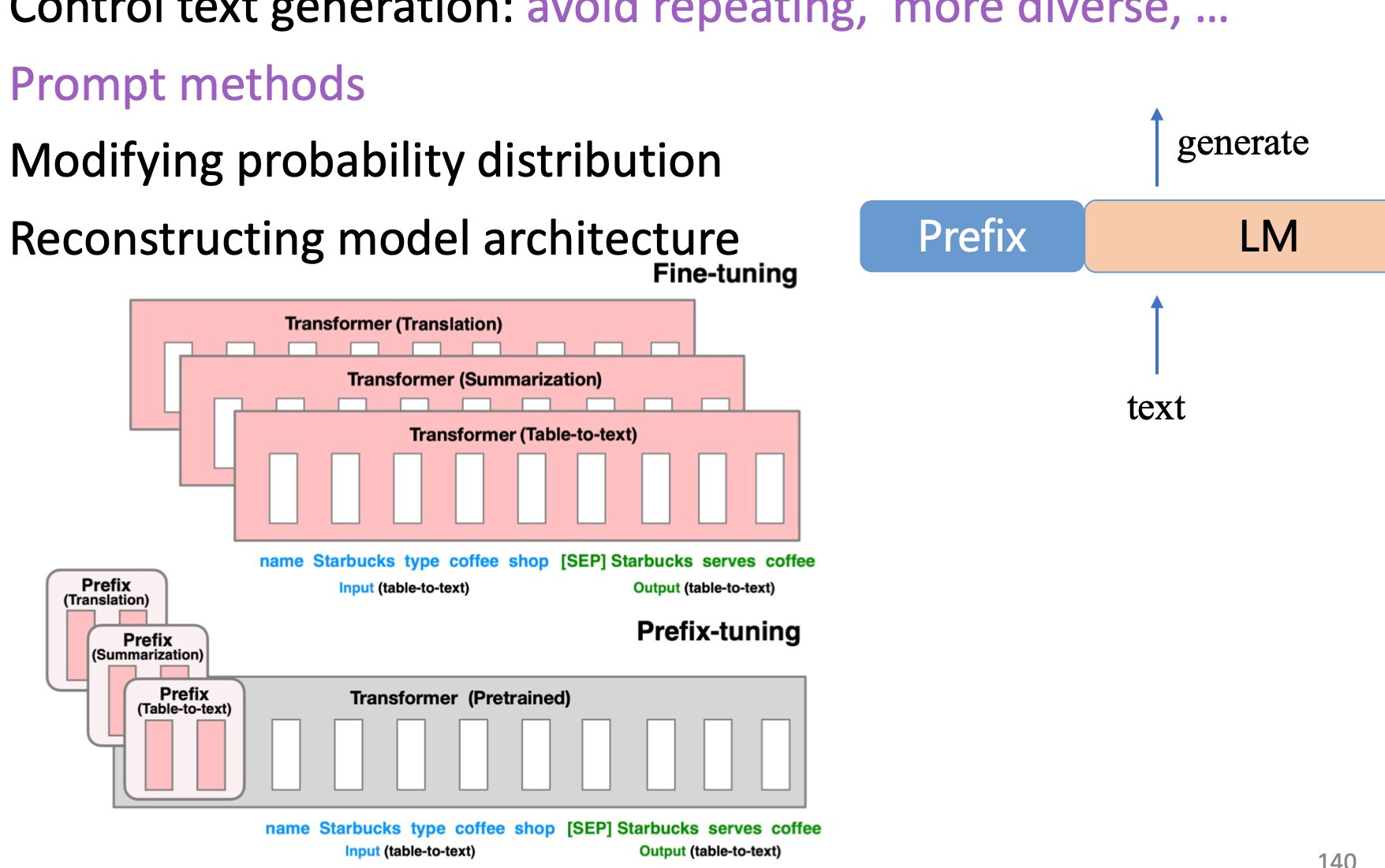

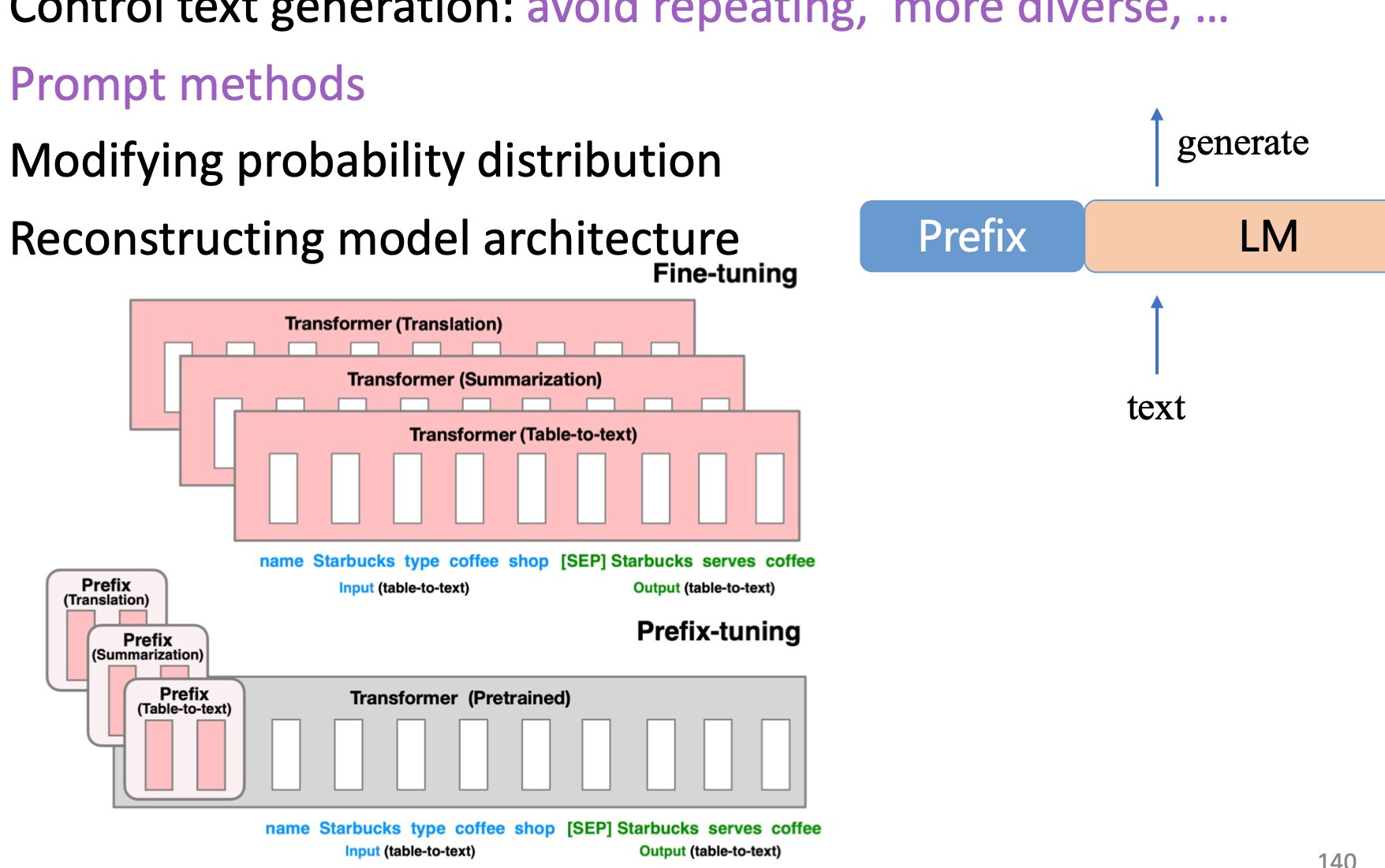

现在的检测技术主要抓三个特征。第一个是语言模式的规律性。比如 AI 生成的句子长度波动小,常用词汇的重复率比人类高,甚至标点符号的使用都有固定偏好。有研究显示,GPT 系列生成的文本中,逗号和句号的出现频率偏差不超过 3%,而人类写作的偏差能达到 15% 以上。

第二个是语义连贯性的 “假流畅”。AI 能让句子之间看起来衔接自然,但深究下去会发现逻辑断层。比如写一篇关于环保的文章,人类可能从个人习惯跳到政策影响,再突然提到某个新闻事件;AI 则更倾向于按 “重要性排序” 或 “时间顺序” 平铺直叙,少了这种跳跃性。

第三个是统计特征的异常值。检测工具会比对文本和已知 AI 模型生成内容的 “特征库”,比如特定短语的组合概率。举个例子,“综上所述”“不难看出” 这类总结性短语,在 AI 文本中的出现频率是人类写作的 2.3 倍。

但这里有个误区,很多人觉得检测工具是 “读” 懂了内容才判断的。其实不是。目前 90% 以上的检测技术还停留在 “特征比对” 阶段,没法真正理解语义。这也是为什么有时候人类写的工整文章会被误判成 AI 生成的 —— 因为它太 “完美” 了,反而不像人写的。

🛠️ 主流检测工具的核心算法:从统计特征到语义分析

现在市面上的检测工具大概分三类,各自的算法路数差别很大。咱们一个个说。

第一类是基于 N-gram 模型的统计派,比如早期的 Copyscape 和 GPTZero 的基础版本。它们的做法是把文本拆成词组片段(比如连续两个词或三个词),然后和人类写作的语料库比对。如果某个片段在 AI 训练数据里出现的频率远高于人类语料库,就标记为可疑。这种方法速度快,对短句检测准确率能到 80%,但遇到长文本就容易抓瞎 —— 因为人类也会重复使用某些词组。

第二类是深度学习派,典型代表是 Originality.ai 和 Content at Scale。它们用专门训练的检测模型(比如基于 BERT 改造的分类器),分析文本的上下文关联性。举个例子,人类写 “天气冷了” 后面可能接 “记得穿外套”,也可能接 “冰淇淋销量下降了”;但 AI 在训练数据中 “天气冷了→穿外套” 的关联度是 “天气冷了→冰淇淋” 的 5 倍,检测模型就靠捕捉这种差异来判断。这类工具对长文本的准确率更高,能到 85% 左右,但对经过改写的 AI 文本效果会打折扣。

第三类是多模态辅助派,比如 Turnitin 最新推出的检测系统。除了文本本身,还会结合写作行为数据 —— 比如在文档编辑器里的修改痕迹、打字速度变化、停顿频率等。如果一篇文章从头到尾没删改,打字速度均匀得像机器,即使文本特征像人类写的,也会被标记。这种方法在教育场景特别好用,毕竟学生写论文很少能一气呵成。

但这些工具都有个共同问题:对训练数据之外的 AI 模型几乎无效。比如专门针对中文训练的大模型(如讯飞星火、文心一言)生成的文本,用基于英文训练的检测工具(如 Originality.ai)检测,准确率会暴跌到 50% 以下。这也是为什么很多跨境内容创作者会混用不同语言模型来规避检测。

还有个有意思的现象,不同工具对同一篇文本的判断经常打架。去年有个测试,用同一篇 ChatGPT 生成的文章去测,GPTZero 判定为 “90% AI 生成”,Originality.ai 说是 “65% AI 生成”,而 Turnitin 居然认为 “80% 可能是人类写的”。原因就在于它们的训练数据和算法侧重不同。

🚫 检测技术的致命短板:为什么总有漏网之鱼?

说真的,现在的检测技术漏洞太多了。随便列几个最致命的。

第一个是 “小模型生成内容难识别”。大模型比如 GPT-4、Claude 生成的文本特征明显,但那些基于开源模型(如 Llama 2)微调的小模型,生成的文本能完美避开主流检测工具。因为这些小模型的训练数据更杂,语言模式不固定。有团队测试过,用微调后的 Llama 2 生成的文章,在主流检测工具中的通过率(即被判定为人类写作)高达 78%,而原始 GPT-4 生成的文章通过率只有 23%。

第二个是 “混合文本检测失效”。如果一篇文章 70% 是人类写的,30% 是 AI 生成的,现在的工具基本测不出来。比如自媒体作者先自己写个框架,再让 AI 填细节,检测工具往往会判定为 “人类主导写作”。去年某科技博客做过实验,用这种混合方式写的 10 篇文章,全部通过了主流检测工具的审核。

第三个是 “多轮改写规避”。现在有很多工具能把 AI 生成的文本改写成 “类人类” 风格,比如 QuillBot 的高级模式、Paraphraser.io 等。它们不只是换同义词,还会调整句式结构,甚至故意加一些 “冗余信息”—— 就像人类写作时偶尔跑题一样。检测工具对这类改写后的文本,准确率会下降 40% 以上。有数据显示,经过 3 轮以上改写的 AI 文本,检测工具的误判率(把 AI 当成人类)能达到 60%。

最麻烦的是 “训练数据污染”。检测工具的模型是用 “已知的 AI 文本” 训练出来的,但新的大模型(比如 GPT-5、Gemini Ultra)会吸收这些检测逻辑,生成的文本直接规避了旧特征。这就像杀毒软件和病毒的关系 —— 永远在追着新变种跑。今年初 OpenAI 发布的 GPT-4 Turbo,就专门优化了 “抗检测能力”,有测试显示它生成的文本在 GPTZero 上的检测准确率从 89% 降到了 53%。

🚫 检测技术的致命短板:为什么总有漏网之鱼?

刚才说了技术原理,现在聊聊实际用起来有多坑。很多企业和平台都在吐槽,这些检测工具看着厉害,真到业务里就掉链子。

教育机构是重灾区。大学老师用检测工具查论文,结果经常闹笑话。有个教授在博客里说,他发现自己十年前发表的论文,被现在的检测工具判定为 “70% AI 生成”—— 因为那篇论文写得太严谨,句式太规整。更麻烦的是留学生,很多人英语写作不熟练,句子结构简单,反而被误判成 AI 生成的,得花大量时间申诉。某留学机构统计,2024 年第二季度,因为 AI 检测误判导致的学术申诉量比去年增加了 3 倍。

内容平台的审核更头疼。像头条号、百家号这种 UGC 平台,每天要处理几百万篇稿子。如果完全依赖检测工具,要么放过大量 AI 生成的 “水文”,要么误杀优质原创。某头部自媒体平台透露,他们的检测系统误判率大概在 15% 左右 —— 这意味着每天有十几万篇人类原创文章被当成 AI 内容拦截,作者投诉量一直居高不下。

企业市场部也有苦说不出。现在很多公司用 AI 写产品文案、社交媒体帖子,但又怕被平台处罚。有个电商品牌试过,让 AI 写了 50 条产品描述,然后用 3 种主流工具检测,结果居然有 32 条出现 “判定不一致”——A 工具说是 AI 写的,B 工具说不是,C 工具说 “无法确定”。最后没办法,只能再雇人手工修改,反而增加了成本。

更讽刺的是 “检测工具内卷”。有些工具为了抢市场,故意调低 AI 判定的阈值,导致误判率飙升。比如某工具宣称 “准确率 99%”,实际测试发现,它把很多包含 “因此”“综上所述” 等词的人类文章都标成了 AI 生成 —— 因为这些词在 AI 文本里出现频率高,但人类也常用啊。

💼 实际场景中的检测困境:企业和平台的真实挑战

检测技术的局限性,在实际应用中会被无限放大。这里有几个典型场景,能看出问题有多复杂。

第一个是 “低质量人类文本” 和 “高质量 AI 文本” 的区分。比如小学生写的作文,句子不通顺,逻辑混乱;而 AI 生成的小学生作文,反而语句流畅,用词准确。检测工具经常把前者当成 AI(因为太 “差”,不像成年人写的),把后者当成人类(因为太 “好”,不像小学生水平)。某教育科技公司做过测试,用 AI 模仿小学生写的 100 篇作文,有 73 篇被检测工具判定为 “人类写作”。

第二个是 “专业领域的文本检测”。在法律、医学这些专业领域,人类写作本身就很严谨,句式规范,术语密集 —— 这和 AI 生成文本的特征高度重合。有律师朋友说,他用检测工具查自己写的法律文书,居然有 40% 被标记为 “可能 AI 生成”。原因很简单,法律文书里的 “综上所述”“根据 XX 条款” 出现频率,比普通文本高得多,刚好撞在 AI 特征的枪口上。

第三个是 “多语言混合文本”。现在跨境内容越来越多,比如中英夹杂的社交媒体帖子。AI 生成这类文本时,语言转换的 “接缝处” 会有特征;但人类写的多语言文本,也可能因为熟练度问题出现类似特征。检测工具对这类文本的准确率普遍低于 50%,基本等于瞎猜。

最头疼的是 “对抗性改写”。现在已经出现专门教用户 “如何让 AI 文本通过检测” 的教程。比如在 AI 生成的内容里故意加几个错别字,或者插入一些看似无关的短句(比如 “今天天气不错” 突然出现在科技文章里)。这些小技巧能让检测工具的准确率下降 70% 以上。某自媒体训练营的数据显示,学过这类技巧的学员,用 AI 写的文章通过平台审核的概率,从 30% 提升到了 85%。

🚀 攻防战升级:大模型如何对抗检测技术?

AI 生成内容的一方,也在想办法绕过检测。这场攻防战,已经进入 “魔高一尺道高一丈” 的阶段。

最直接的方法是 “特征伪装”。现在的大模型,比如 GPT-4 的 “隐身模式”、Claude 的 “人类模拟” 功能,会故意在生成文本中加入 “人类特征”—— 比如偶尔用错一个成语,在长句中间插入一个无关的形容词,甚至调整标点符号的使用频率。有测试显示,开启这类模式后,AI 文本在主流检测工具上的通过率(被判定为人类)能从 30% 提升到 75% 以上。

更高级的是 “风格迁移”。就是让 AI 模仿特定作者的写作风格,包括用词习惯、句式偏好,甚至语法错误。比如让 AI 学习某个人的 100 篇博客文章,然后模仿他的风格写新内容。这种情况下,检测工具很难识别 —— 因为它的特征库是 “通用 AI 文本”,而不是 “特定人类风格的 AI 文本”。某内容工作室用这种方法,让 AI 模仿 10 位知名博主的风格写文章,检测工具的识别准确率降到了 30% 以下。

还有 “多模型混合生成”。先用模型 A 生成初稿,再用模型 B 改写,最后用模型 C 调整语气 —— 经过几轮 “混血”,文本的 AI 特征会被彻底打乱。有研究显示,经过 3 个不同大模型处理的文本,检测工具的识别准确率会从 80% 暴跌到 25%。现在很多 “AI 写作代笔” 服务,就是用这种方法规避平台检测。

面对这些手段,检测工具也在升级。比如引入 “行为分析” 辅助判断 —— 如果一篇文章是在某个 AI 写作平台上生成的,即使文本特征像人类,也会被标记;或者结合用户的历史写作数据,如果突然从 “口语化” 变成 “书面化”,就触发人工审核。但这种方法依赖平台数据,对独立创作者基本无效。

🔮 未来判断:AI 生成内容会彻底 “隐身” 吗?

现在行业里有两种极端观点。一种认为,再过 3-5 年,检测技术会被彻底突破,AI 生成的内容将无法被识别;另一种则觉得,检测技术会和大模型同步进化,始终保持 “能识别” 的能力。

我的看法是,短期内(1-2 年),检测技术还能守住基本盘。原因有两个:一是大模型生成文本的 “底层特征”(比如对训练数据的依赖)很难完全消除;二是检测工具开始结合多维度数据(写作行为、历史记录、跨平台比对),单纯靠文本特征伪装越来越难。

但长期来看,完全精准的检测几乎不可能。大模型的进化速度太快了 —— 现在已经有模型能学习 “人类写作时的犹豫和修正”,生成的文本甚至包含 “删除线”“修改痕迹”,模拟人类在编辑器里的写作过程。如果再结合脑机接口、生物特征(比如根据打字速度调整生成节奏),AI 文本的 “人类特征” 会越来越逼真。

更可能的趋势是 “动态平衡”—— 检测技术识别出旧的 AI 特征,大模型就生成新的特征;检测工具升级算法,大模型再调整生成策略。就像现在的垃圾邮件过滤和反过滤一样,永远在博弈,但谁也无法彻底消灭谁。

对普通用户来说,与其纠结 “能不能检测出来”,不如关注 “内容本身的价值”。毕竟,无论是人类还是 AI 生成的内容,有价值的才值得被关注。平台未来可能会弱化 “是否 AI 生成” 的判断,转而加强 “内容质量” 的审核 —— 毕竟,低质的人类原创,比优质的 AI 生成内容更没意义。