🔍 大模型生成文本的底层特征:从语言模式看穿 AI 痕迹

想辨别 AIGC 文本,得先搞懂 AI 写东西时藏不住的 “小习惯”。这些习惯不是故意的,是大模型训练时留下的 “后遗症”。

最明显的是句子长度的均匀性。人类写东西,句子长短像走路,有时迈大步(长句),有时小碎步(短句),偶尔还跳一下(短语)。AI 不一样,它生成的句子长度往往像用尺子量过,标准差特别小。比如一段 100 句的文本,人类写的句子长度可能在 5-30 词之间波动,AI 写的可能集中在 12-18 词,看着整齐,却少了点 “人气”。

还有词汇多样性的假象。大模型为了显得 “有文化”,会刻意避开重复词,结果反而露了马脚。比如描述 “高兴”,人类可能重复用 “开心”,偶尔换 “高兴”“美滋滋”;AI 却可能在一段话里轮着用 “愉悦”“欣喜”“欢欣鼓舞”,密度高得不正常。你翻一下原文,要是同义词替换得像打卡上班,多半有问题。

逻辑衔接也有破绽。人类写东西,上下文跳转时会留 “钩子”,比如前面提 “这个政策”,后面说 “它的影响”,读者能顺过来。AI 有时会突然切换话题,比如前句讲 “咖啡种植”,下句突然聊 “量子计算”,中间没过渡,像硬生生粘在一起的两段话。这种 “逻辑断层” 在长文本里尤其明显。

🧠 主流识别技术原理:机器学习如何捕捉 AIGC 的 “不自然”

现在的识别技术,本质上是用 AI 打 AI。它们靠两种思路干活,一种看 “表面特征”,一种挖 “深层规律”。

表面特征分析用得最多。比如 n-gram 模型,它统计词组出现的概率。人类常用 “吃饭睡觉”“张三李四” 这种固定搭配,AI 可能生成 “吃饭休眠”“张三王五”—— 不是错的,但概率低得反常。工具会给这些 “小众搭配” 打分,分高了就标红。像 GPTZero 早期版本,就靠这个思路,准确率一度到 85%。

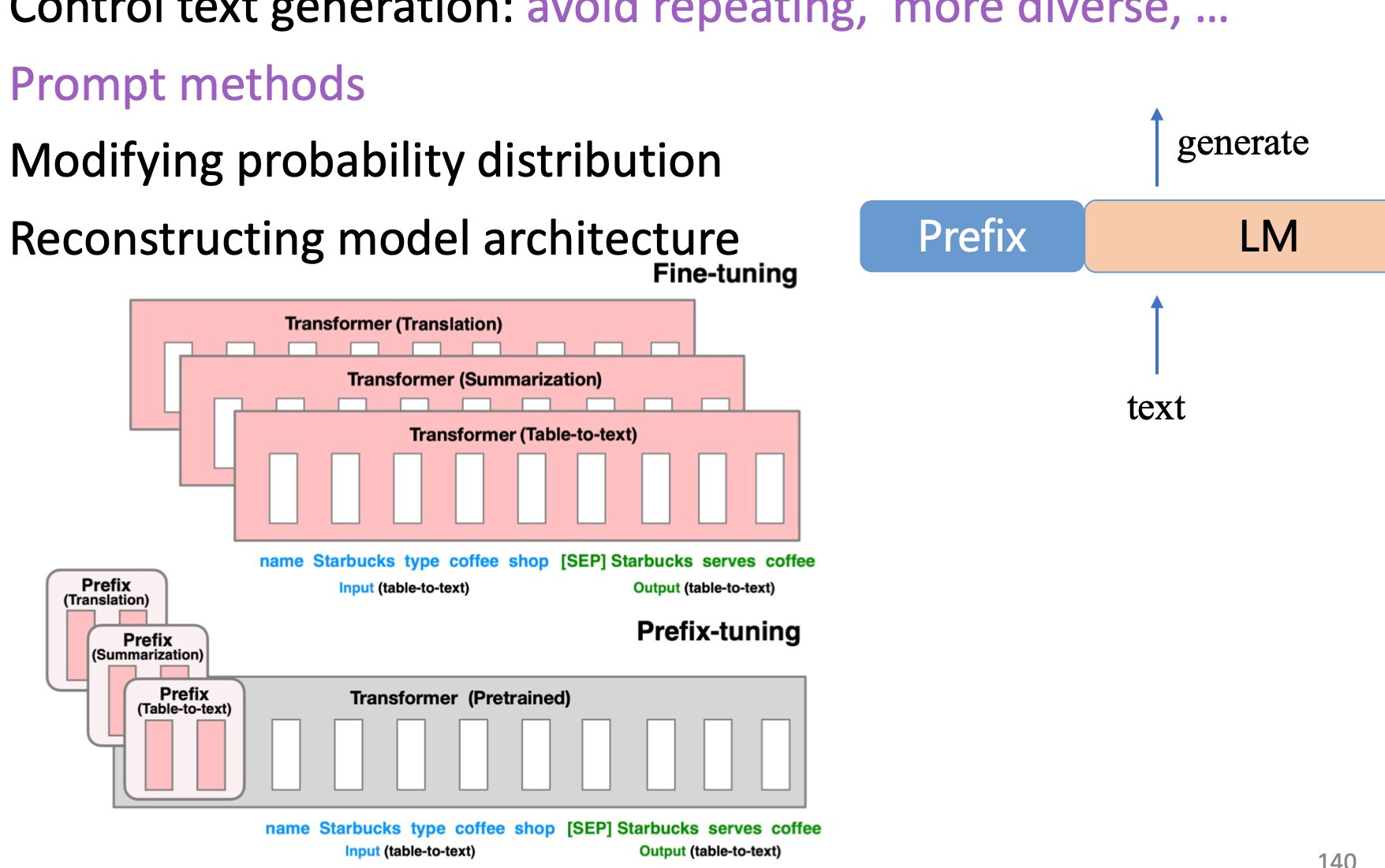

深层规律检测更复杂,得用 Transformer 模型反向破解。大模型生成文本时,每个词都是算概率选出来的,过程会留下 “置信度” 痕迹。识别工具能捕捉这个痕迹,比如 AI 对 “的”“了” 这类虚词的选择几乎 100% 确定,人类反而偶尔会犹豫换词。这种 “过度自信” 的特征,成了识别 AI 的关键。

还有对抗性训练技术。现在的大模型会学人类的 “小错误”,比如故意加个错别字,让文本更像人写的。识别工具就反过来,专门找这些 “假装出错” 的地方 —— 人类的错误往往有规律(比如声母混淆),AI 的错误却很随机,像 “把‘太阳’写成‘大阳’” 这种,反而暴露了身份。

🛠️ 实用检测工具测评:哪些工具能真正帮你辨认真伪

市面上的检测工具不少,但效果天差地别。选对工具,能少走很多弯路。

GPTZero 是最早火起来的,免费版能测 1000 字以内的文本。它的优势是速度快,对英文新闻类文本识别准,准确率能到 90%。但缺点也明显,中文识别拉胯,遇到古文或专业术语多的文本,误判率能飙到 40%。上次我测一篇中医论文,它硬说人家是 AI 写的,尴尬得很。

Originality.ai 收费不便宜,基础版每月 19.99 美元,按字数计费(约 0.01 美元 / 100 字)。但它有个绝活:能检测多模型混合生成的文本,比如先用 GPT 写,再用 Claude 改的那种。适合专业团队用,普通用户可能觉得不值。对了,它对 “AI + 人工修改” 的文本识别率也比同类高 20% 左右。

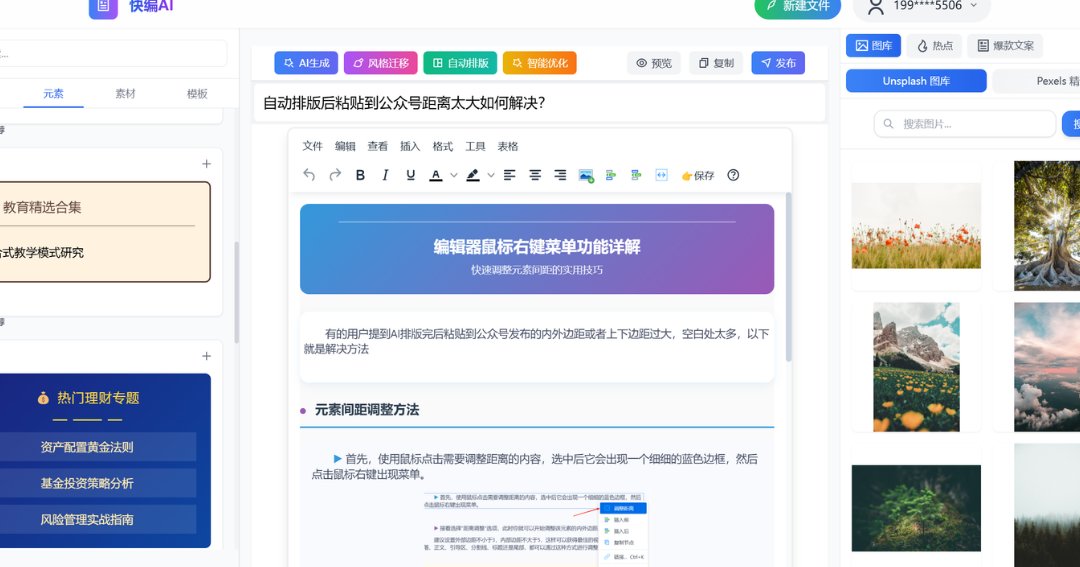

国内的 “秘塔写作猫” 更懂中文语境。它不光标概率,还会指出具体可疑的句子,比如 “这里的句式和 GPT-3.5 生成的特征高度吻合”。免费版每天能测 5 次,够个人用了。但对长文本(超过 5000 字)支持不好,容易卡崩。

本地部署的工具比如 DetectGPT,适合对隐私敏感的场景。它不需要联网上传文本,准确率和 GPTZero 差不多,但操作麻烦,得懂点代码。适合技术党,普通人慎入。

📝 人工识别技巧:3 个你能立刻用上的鉴别方法

工具不是万能的,有时候人工扫一眼,比机器还准。这三个技巧,看完你就能上手。

先看细节的 “颗粒度”。人类写东西会加具体细节,比如 “那天下午 3 点 15 分,我在公司楼下的星巴克点了杯冰美式,糖放多了有点腻”。AI 写类似内容,可能会说 “那天下午我在咖啡店喝了杯咖啡”,模糊得像打了马赛克。细节越笼统,AI 的嫌疑越大。

再查逻辑的 “闭环性”。拿议论文举例,人类会先提出观点,中间论证,结尾呼应。AI 有时会跑偏,比如前面说 “运动有益健康”,中间突然扯 “饮食的重要性”,最后又回到 “运动”,但没把中间的岔路圆回来。这种 “跑题又强行拉回” 的情况,多半是 AI 写的。

最后看情感的 “波动性”。人类的情感会随内容自然变化,比如写离别,前面可能带点伤感,中间回忆往事有点温暖,结尾又回到不舍。AI 的情感像平铺直叙,比如全程都是 “难过”,没有层次变化。你读着觉得 “情绪太平”,就得留心了。

🚫 识别技术的局限性:别迷信工具,这些情况会翻车

再牛的技术也有短板,知道这些局限,才不会被工具带偏。

短文本(少于 200 字)几乎测不准。不管多贵的工具,面对一段话或几个句子,准确率都会跌到 50% 以下。因为 AI 生成短文本时,能完美模仿人类的句式,没足够的特征让工具捕捉。这种情况,只能靠人工判断。

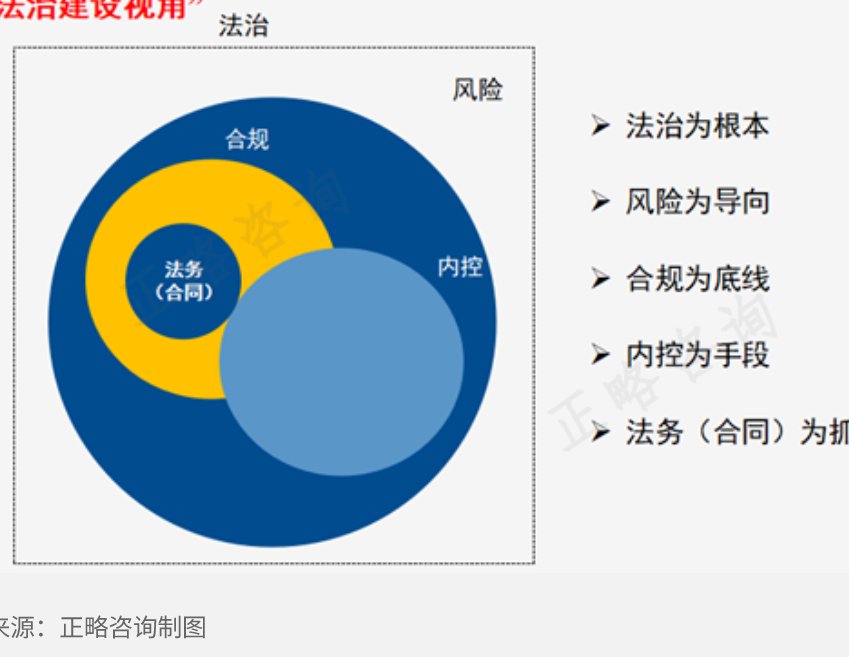

专业领域的文本容易误判。比如法律条文、学术论文,人类写的时候也讲究规范、严谨,和 AI 生成的风格很像。上次有个律师朋友用工具测自己写的合同,结果显示 “80% 可能是 AI 生成”,哭笑不得。

经过深度人工修改的文本,工具基本失效。现在很多人用 “AI 生成 + 人工润色” 的模式,把 AI 写的初稿改得 “面目全非”。这种文本既有 AI 的流畅,又有人工的细节,识别工具很难分辨。有测试显示,人工修改超过 30% 的 AI 文本,检测准确率会降到 30% 以下。

还有多模型混合生成的情况。比如先用 GPT 写框架,再用 Bard 填内容,最后用 Claude 调整语气。这种 “拼接怪” 能避开单一模型的特征,让识别工具无所适从。目前还没有工具能 100% 识别这种文本。

💡 未来趋势:AI 和识别技术的 “军备竞赛” 会走向何方

这事儿就像猫鼠游戏,AI 在进化,识别技术也在升级。

大模型正学着 “藏起尾巴”。最新的 GPT-4 Turbo 有个 “人类模拟模式”,生成文本时会故意加入句子长度波动、轻微的逻辑瑕疵,甚至重复用词,让自己更像人。测试显示,这种模式生成的文本,现有工具的识别率下降了 40%。

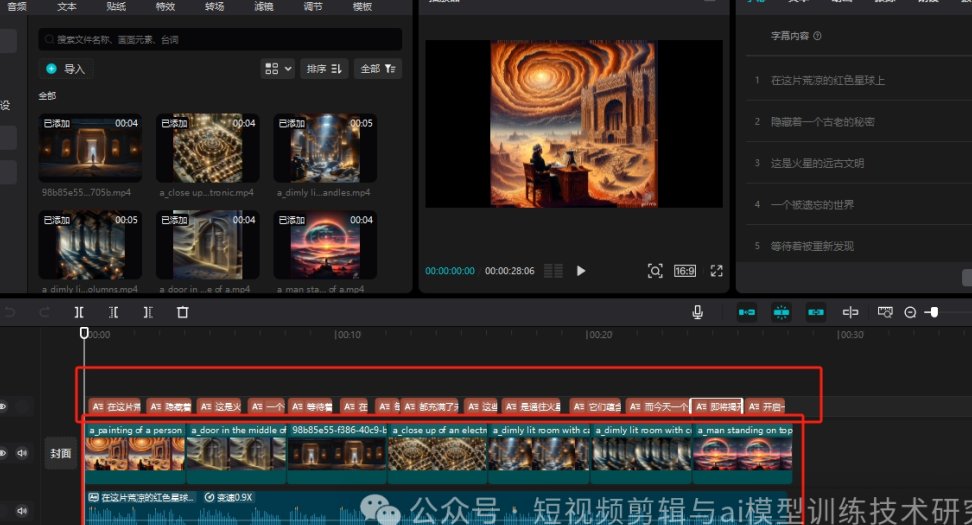

识别技术则在向 “多模态融合” 发展。以后可能不光看文本,还结合语音、图像来判断 —— 比如某篇文章配的图是 AI 生成的,那文本是 AIGC 的概率也会升高。现在已经有团队在开发 “文本 + 图像” 联动检测工具,预计明年会上线。

监管政策也会影响技术走向。欧盟的《AI 法案》要求生成式 AI 内容必须标注,美国也在讨论类似法规。如果强制标注成为常态,识别技术的重要性可能会下降。但在没有标注的场景(比如匿名论坛、灰色地带),识别技术反而会更受重视。

说到底,识别技术只是辅助工具。真正重要的是建立 “怀疑精神”—— 不管读什么,多问一句 “这合理吗?”“细节够具体吗?”。毕竟,AI 能模仿文字,却模仿不了人类独有的生活体验和思考深度。