📝 大模型文本的独特语言特征

大模型生成的文本,哪怕伪装得再好,总会在语言特征上留下 “数字指纹”。这些特征不是单一存在的,而是像拼图一样组合在一起,成为检测技术的重要依据。

词汇选择上,大模型往往表现出 “过度规范” 的倾向。人类写作时偶尔会用俚语、方言或者生僻词,甚至出现用词不当的情况。大模型不一样,它更倾向于使用通用词汇和标准表达,很少冒险用小众说法。比如描述 “高兴”,人类可能说 “乐开花”“美滋滋”,大模型则更爱用 “非常高兴”“感到愉悦” 这种四平八稳的表达。这种词汇偏好不是绝对的,但在大量文本对比中会呈现明显规律。

句式结构有明显的模式化倾向。人类写作时,句子长短交错很自然,有时候会突然用个短句强调,有时候又会用长句铺陈细节。大模型生成的句子,长度分布相对集中,很少有极端的长短句出现。更关键的是,它的句式变化性差,比如在议论文中,可能反复出现 “首先... 其次... 最后...” 的结构,或者过度依赖 “虽然... 但是...” 这类转折句式,显得有些机械。

逻辑连贯性上存在 “伪流畅” 现象。大模型能让句子之间衔接得很顺畅,读起来似乎没毛病。但深入分析会发现,它的逻辑链条有时是 “表面连贯” 而非 “深层合理”。比如在论述一个复杂问题时,可能前半部分讲的是 A 观点,中间突然转到 B 观点,最后又回到 A 观点,整体逻辑跳脱,但因为句子衔接自然,乍读之下很难发现问题。人类写作的逻辑跳跃往往有明确的过渡或解释,不会这么 “悄无声息”。

🔍 特征提取技术:从文本到可计算数据

要检测大模型文本,第一步是把文本转化成计算机能理解的特征数据。这一步很关键,特征提取的质量直接决定后续检测的准确性。

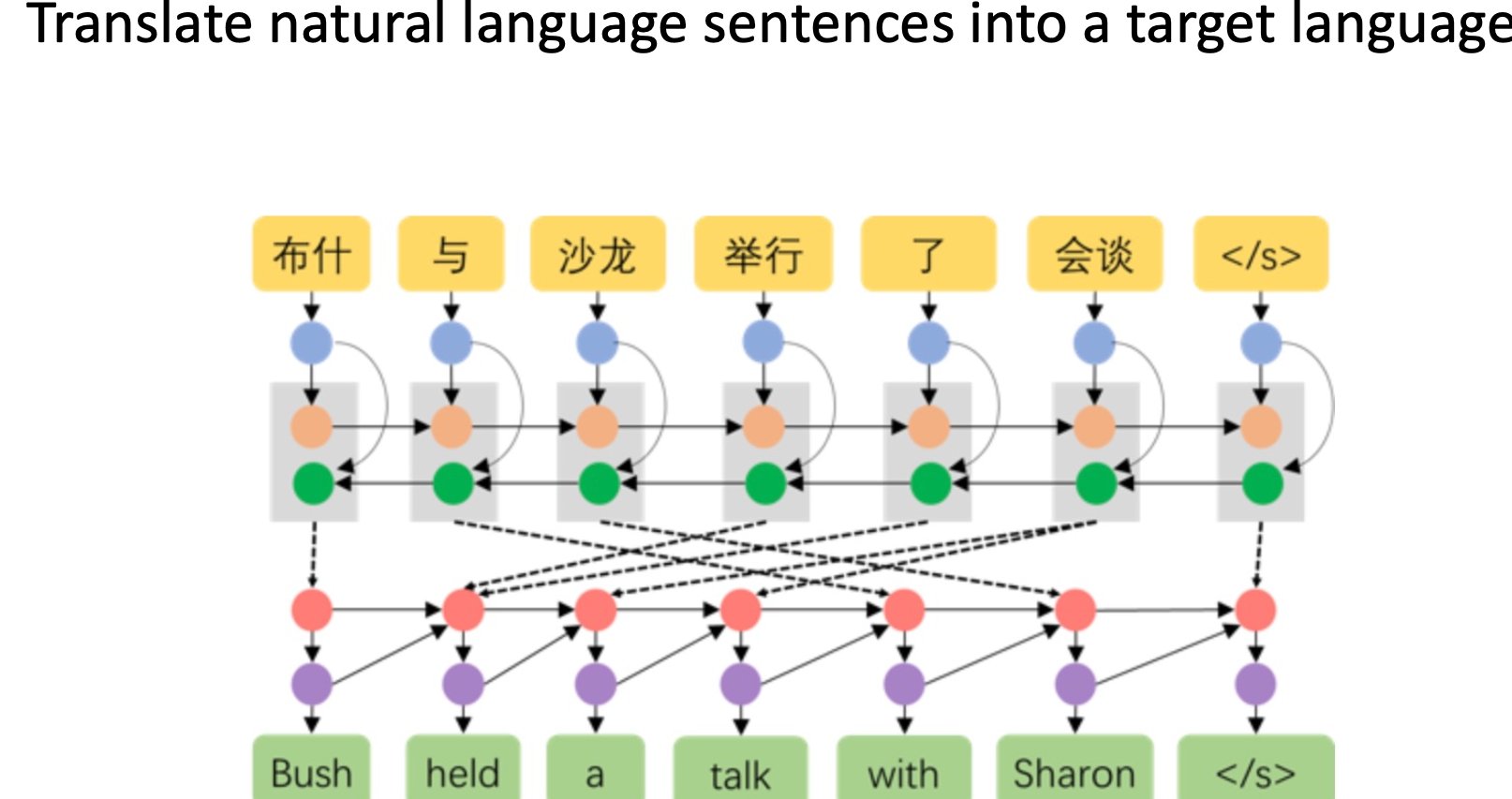

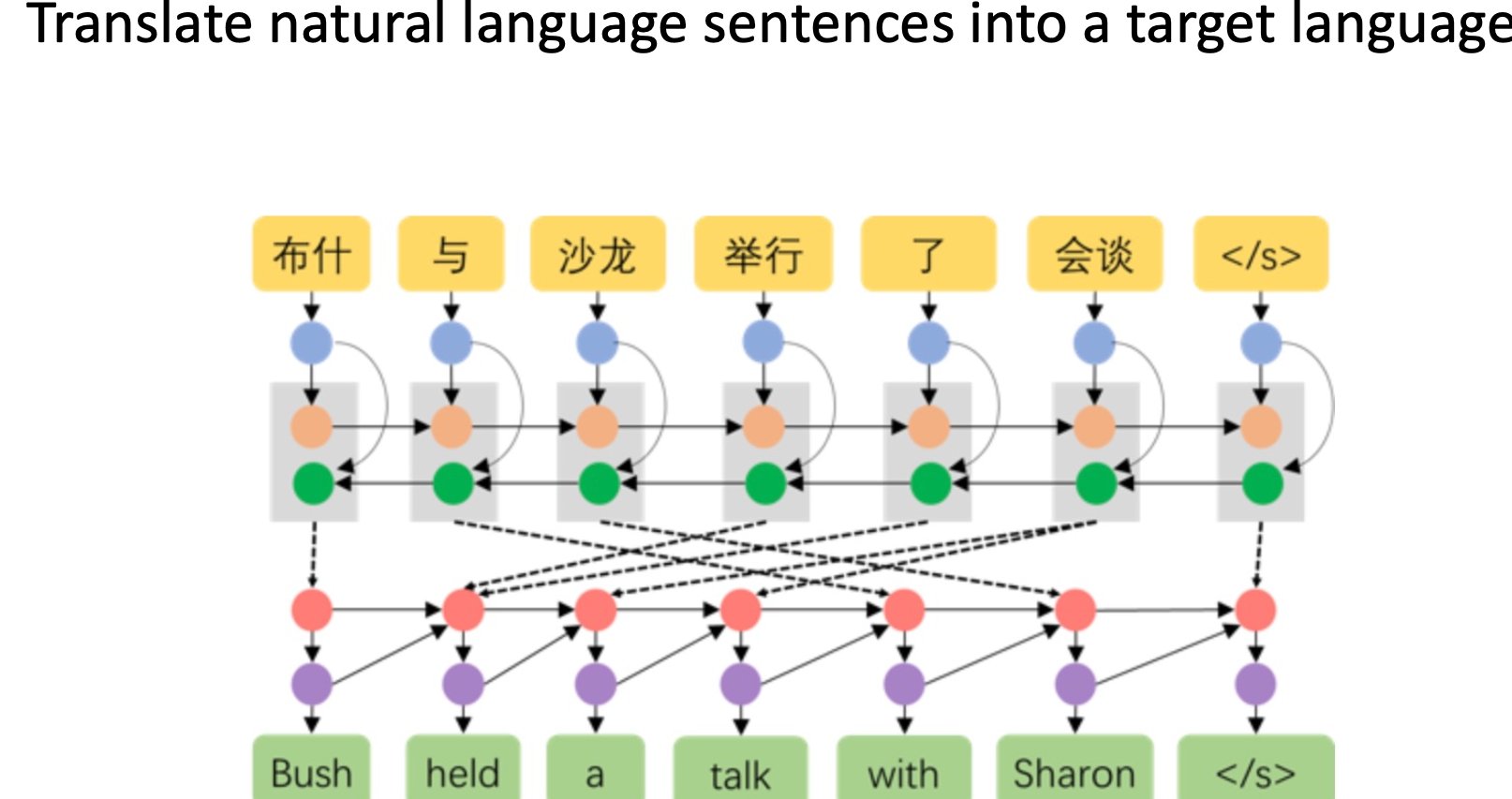

词向量与语义特征提取是基础操作。通过 Word2Vec、BERT 这类模型,把文本中的词语转化成高维向量。大模型生成的文本,其词向量分布和人类写作有细微差别。比如在情感词的使用上,人类可能会混合使用强度不同的情感词,而大模型在同一语境下使用的情感词向量往往更集中,缺乏自然的波动。这种差异肉眼看不出来,但通过向量计算能清晰呈现。

统计特征分析不能忽视。包括词长分布、句长分布、标点使用频率等基础统计数据。有研究发现,大模型生成的文本中,逗号和句号的使用比例相对固定,而人类写作会根据表达需求灵活调整。另外,大模型对生僻词的使用频率通常低于人类,尤其是在长文本中,这种差异会更明显。这些统计特征单独看意义不大,但组合起来就能形成有效的检测维度。

上下文关联性特征是进阶方向。通过分析文本中不同部分的关联强度,能发现大模型的 “破绽”。比如在一篇文章中,前面提到的人物、事件,在后面再次出现时,人类写作会自然保持一致性,大模型则可能出现细微的不一致。这种不一致不是明显的错误,而是像 “记忆模糊” 一样,比如前面说 “张三在上海工作”,后面可能写成 “张三在杭州出差”,前后矛盾但又不影响单句通顺。通过计算上下文实体的一致性得分,能有效捕捉这类特征。

🧮 主流分类算法的原理与实战表现

有了特征数据,接下来就靠分类算法进行判断。不同的算法各有优劣,在实际应用中往往需要组合使用。

支持向量机(SVM) 是传统机器学习中的 “老将”。它的原理是在特征空间中找到一个最优超平面,把不同类别的数据分开。在大模型文本检测中,SVM 适合处理统计特征和简单的语义特征。优点是训练速度快,对小规模数据集效果稳定。但它的缺点也很明显,面对高维的 Transformer 特征时,性能会大幅下降,而且很难捕捉文本中的深层语义关联。现在单独用 SVM 做检测的已经不多,更多是作为辅助算法配合其他模型使用。

随机森林凭借抗过拟合能力占据一席之地。它由多个决策树组成,通过投票方式决定最终分类结果。在处理词频、句长等结构化特征时,随机森林表现出色。它能自动筛选重要特征,比如发现 “特定连词的使用频率” 比 “平均句长” 更能区分人机文本。实际应用中,随机森林的优势在于鲁棒性强,对噪声数据不敏感,适合处理网络上质量参差不齐的文本数据。但它在处理长文本的语义特征时,不如深度学习模型灵活。

深度学习模型是当前的主流选择。其中,基于 Transformer 的模型表现最突出,比如用 BERT 做特征提取,再加上一个分类头,就能构建出效果不错的检测模型。这类模型的优势是能捕捉文本的深层语义,哪怕大模型文本在表面特征上模仿得很好,深层的语义模式差异也能被捕捉到。比如 GPT-4 生成的文本,在语义连贯性上已经很接近人类,但通过对比预训练语料中的语义分布,深度学习模型还是能发现它的 “数字基因”。不过深度学习模型的问题是需要大量标注数据,而且计算成本高,对硬件要求也高。

集成学习正在成为趋势。把多种算法的结果进行融合,比如让 SVM、随机森林和深度学习模型各自给出判断,再通过加权投票得出最终结果。这种方式能弥补单一算法的短板,比如用深度学习捕捉语义特征,用随机森林处理统计特征,两者结合后,检测准确率能提升 5%-10%。在实际场景中,主流检测工具几乎都采用了集成学习策略,毕竟面对不断进化的大模型,单一算法很容易被突破。

🚧 检测技术面临的现实挑战

大模型在不断进化,检测技术也面临着越来越多的挑战,这些问题不是靠简单优化算法就能解决的。

对抗性攻击让检测失效成为可能。有些用户会故意修改大模型生成的文本,比如替换同义词、调整句式、插入错别字,以此躲避检测。这种 “小改动” 对人类阅读影响不大,但会严重干扰检测模型的判断。比如把 “非常高兴” 改成 “贼开心”,把长句拆成几个短句,就能让很多基础检测工具误判。更高级的对抗攻击甚至会针对特定检测模型的弱点进行优化,就像 “量身定制” 一样绕过检测。

模型迭代速度不匹配是长期难题。大模型的更新速度非常快,从 GPT-3 到 GPT-4,再到各种微调模型,每一代都在优化语言生成能力。检测模型的更新往往滞后,因为需要收集新模型生成的文本数据,重新训练算法。这种时间差导致很多检测工具刚上线不久,就因为大模型升级而准确率下降。比如某个检测工具针对 GPT-3.5 优化得很好,但面对 GPT-4 生成的文本,准确率可能下降 20% 以上。

多语言检测难度倍增。在中文、英文等主流语言上,检测技术相对成熟,但在小语种或者混合语言文本上,表现就差很多。大模型在多语言生成上的能力提升很快,比如能同时用中文和日文写文章,而检测模型在处理这类文本时,特征提取会遇到很大困难。不同语言的语法规则、词汇特征差异很大,很难用一套模型覆盖所有语言场景。

🔮 未来技术发展的几个关键方向

大模型文本检测不会是一劳永逸的工作,技术发展必然会朝着更智能、更灵活的方向前进。

动态自适应学习将成为核心能力。未来的检测系统需要像 “活的有机体” 一样,能实时学习新出现的大模型特征。比如通过在线学习算法,不断吸收新的文本数据,自动更新模型参数,不需要人工干预就能适应大模型的升级。这种技术的关键是解决 “灾难性遗忘” 问题,也就是在学习新知识时,不会忘记之前掌握的特征。目前基于增量学习的方案已经有了初步进展,未来几年可能会成为主流。

多模态融合检测能提升鲁棒性。单纯依靠文本特征容易被对抗攻击突破,如果结合图像、音频等其他模态的信息,能大幅提升检测准确率。比如在社交媒体上,一段文本搭配的图片、视频,它们的相关性可以辅助判断文本是否为大模型生成。人类在创作时,文本和其他模态内容的关联性更强,而大模型在多模态协同上还存在短板。这种跨模态的特征融合,可能是对抗高级伪装的有效手段。

可解释性研究将越来越重要。现在很多检测模型是 “黑箱” 操作,只能给出 “是 / 否” 的判断,无法解释为什么。这在很多场景下不够用,比如学术论文检测,需要明确指出哪些部分可能是大模型生成的,以及判断依据是什么。未来的检测技术不仅要能准确判断,还要能给出详细的特征分析报告,让用户明白判断的逻辑。这就需要在模型设计时就考虑可解释性,比如使用注意力机制可视化技术,展示模型关注的文本特征。

大模型文本检测技术的发展,本质上是一场 “猫鼠游戏”。大模型在模仿人类写作,检测技术在寻找模仿的破绽。这场博弈不会有终点,但每一次技术进步,都会推动人工智能与人类创作的边界更加清晰。对普通用户来说,了解这些技术原理,既能更好地使用大模型工具,也能提高对文本内容的辨别能力,这可能比技术本身更有意义。