选 AI 文本相似度检测工具,先搞懂这 3 个核心问题

现在 AIGC 内容满天飞,不管是写公众号、做学术论文,还是企业文案,谁都怕撞上重复率过高的坑。但市面上的检测工具多如牛毛,价格从免费到年费几千块不等,功能更是吹得天花乱坠。到底该怎么挑?其实不用被花哨的宣传带偏,抓住几个关键点就行。

首先得明确自己的核心需求。是学生党查论文查重?还是自媒体工作室批量检测稿件?或者是企业要搭建内容风控系统?不同场景对工具的要求天差地别。比如论文查重可能更在意学术库的覆盖度,自媒体则更看重对网络热文和 AI 生成内容的识别能力。

其次得搞懂检测原理的差异。有些工具只做简单的文字比对,跟早期的复制粘贴检测没区别;真正的 AI 驱动工具会分析语义、逻辑结构甚至文风特征。这两种在检测精度上差着量级,比如同样一段改写过的文字,前者可能判为原创,后者却能揪出深层的相似度。

最后千万别忽视隐性成本。很多免费工具看着香,实际限制多到抓狂 —— 要么每天只能查 500 字,要么导出报告要付费,更坑的是把你的文本偷偷存进自家数据库。这些都得提前摸清楚,不然用着用着就掉坑里了。

🔍 看检测能力:这 3 个指标决定工具好坏

判断一款工具好不好用,先看它能不能准确识别「改头换面」的重复内容。现在的 AIGC 内容早就不是简单复制粘贴了,会换同义词、调语序、改句式,甚至用 AI 重写。这时候普通的字符比对工具就彻底歇菜,必须得看语义层面的检测能力。

怎么测试?拿一段自己写的文字,用 AI 工具改写后再检测。真正靠谱的工具能标出语义重复的部分,还会给出相似来源和重复概率。我试过把一篇文章用 5 种不同的 AI 工具改写,某知名检测平台居然能识别出其中 4 种改写版本与原文的关联性,这种深度分析才真的有用。

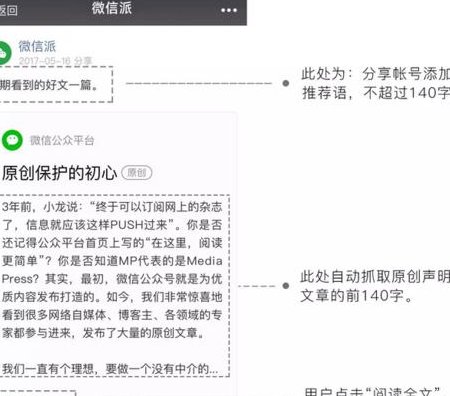

再看数据库覆盖范围。学术场景要重点看是否收录了知网、万方这些核心库;自媒体则要关注是否覆盖微信公众号、头条、知乎等平台的内容。有个小技巧,找几篇冷门但确定存在的文章去检测,能快速看出数据库的真实覆盖能力。

速度和批量处理能力也很关键。如果每天要处理几十上百篇稿件,单篇检测再准也没用。企业级工具通常支持 API 接口,可以对接自家系统实现自动化检测,这对内容团队来说能省不少事。但要注意,速度快往往意味着精度可能打折扣,需要在两者间找平衡。

💻 主流工具横向对比:别被营销话术忽悠

市面上呼声最高的几款工具,实际表现差距不小。先说说知网 CNKI 的相似度检测,学术圈公认权威,但对非学术内容的检测很一般,而且价格贵到离谱,一篇 1 万字的文章要几十块,普通用户根本扛不住。更麻烦的是它只对机构开放,个人很难直接使用。

Turnitin 在国际学术领域名气大,对英文内容的检测确实强,但中文数据库覆盖不足,而且最近频繁爆出误判问题。有朋友的论文里引用了几句古诗词,居然被标为重复,申诉了半个月才解决,太耽误事。

自媒体常用的「原创度检测工具」里,5118 和爱站算是老牌子。5118 的优势是能实时抓取全网内容,对刚发布的爆款文识别很快,但偶尔会把正常引用标为重复。爱站的检测速度更快,批量处理能力强,不过深度分析功能比较弱,适合快速筛查但不适合精细校对。

新兴的 AI 驱动工具里,CopyLeaks 和 Originality.ai 值得关注。这两款都专门针对 AIGC 内容优化过,能识别 ChatGPT、Claude 等生成的文本。CopyLeaks 支持 20 多种语言,适合多语种内容团队;Originality.ai 的亮点是能区分人类改写和 AI 改写,但价格偏高,按字数收费,长期用成本不低。

⚠️ 避坑指南:这些宣传话术听听就好

「100% 精准检测」绝对是最大的谎言。任何检测工具都有误差率,能做到 90% 以上就已经很不错了。尤其是面对精心改写的内容,AI 也会犯迷糊。我见过最夸张的是某工具宣传「零误判」,结果把用户原创的比喻句标为抄袭,因为和十年前某篇博客的句式相似。

「免费永久使用」背后往往藏着陷阱。要么限制极多,要么偷偷收集你的文本数据。有款工具表面上免费,实际会把检测过的内容纳入自己的数据库,结果导致用户后续再检测自己的文章时,反而被判定为重复 —— 等于自己抄了自己。

「支持所有格式」也要打个问号。很多工具宣称支持 PDF、Word、PPT 等格式,但实际检测时会忽略图片里的文字,或者对复杂排版的文档识别错乱。测试时最好拿带公式、表格的文档试试,能看出真本事。

「秒级响应」得看检测长度。检测 100 字当然快,要是检测 10 万字还能保持速度才是真厉害。有些工具为了显得快,会牺牲检测深度,只做表层比对,这种「快」不如不要。

🎯 不同场景的工具选择策略

学生党查论文,首选学校指定的检测系统,因为最终提交还是以这个为准。初稿可以用 PaperPass、维普这些性价比高的工具先自查,这两款的学术库比较全,价格比知网便宜一半以上。但要注意,不同系统的算法不同,检测结果只能参考不能完全当真。

自媒体团队日常审稿,5118+Grammarly 组合比较实用。先用 5118 快速检测全网重复率,再用 Grammarly 检查改写后的流畅度。如果预算充足,加个 Originality.ai 专门筛查 AI 生成内容,现在很多平台对纯 AI 文限流,这点不能忽视。

企业内容风控的话,建议直接上 API 接口版工具。CopyLeaks 和 PlagScan 都有企业级方案,能自定义检测规则,比如设置允许的重复阈值、指定需要排除的来源(比如自家已发布的内容)。这种方案初期 setup 麻烦点,但长期看效率最高,还能避免数据泄露风险。

多语种内容检测比较特殊,英文为主选 Turnitin,小语种可以试试 Unicheck,支持 27 种语言,对日韩、欧洲小语种的识别准确率比主流工具高。但要注意,非拉丁语系的检测精度普遍偏低,最好人工再复核一遍。

💡 实用技巧:让检测结果更靠谱

检测前先做预处理能提高准确率。把文档里的固定格式内容(比如标题、作者名、参考文献)暂时删掉,这些部分很容易被误判为重复。表格和公式也建议单独处理,很多工具对这类内容的识别效果不好。

同一份文本用 2-3 款工具交叉检测更保险。不同工具的算法和数据库各有侧重,可能这款漏检的部分那款能查出来。我通常会先用一款快速筛查,再用另一款深度检测,最后人工核对标红部分 —— 毕竟机器再智能,也比不上人类对语义的理解。

注意区分「合理引用」和「恶意抄袭」。大部分工具会把引用内容也算作重复,这时候需要手动设置引用阈值。一般来说,单篇引用不超过 3%,整体引用不超过 10% 是比较安全的范围,但具体还要看平台要求。

定期更新检测工具也很有必要。AI 生成内容的技术在进化,检测工具也得跟着升级。去年还很灵的工具,今年可能就跟不上 AI 改写的步伐了。建议每季度测试下新出的工具,说不定能发现更好用的选择。

说到底,AI 文本相似度检测工具只是辅助,真正判断内容是否「原创」还是得靠人。工具能帮你找出可疑部分,但最终决定权在你手里。选对工具很重要,但更重要的是理解工具的局限性,别把检测结果当成唯一标准。

希望这些建议能帮你避开坑,找到适合自己的检测工具。毕竟在这个 AIGC 泛滥的时代,既能保护自己的原创权益,又能避免无意中侵权,才是最稳妥的做法。