📌 AI 文本相似度检测,本质是 “数字比对游戏”

咱们聊 AI 文本相似度检测,别被 “AI” 俩字唬住。它本质上就是把两段文字变成计算机能看懂的数字,再算这些数字像不像的过程。你可能觉得它在 “读” 文字,其实不是 —— 它根本不理解文字的意思,只负责计算 “数字特征” 的重合度。

早期的检测工具比如知网的早期版本,主要盯着 “字面重复”。比如你抄了一段文字,改几个词,它可能就查不出来。但现在的 AI 检测不一样了,它能挖到更深的层面。就像你换了件衣服,但熟人还是能认出你 ——AI 现在就有这本事,哪怕你改了些词,它也能看出两段文字 “骨子里” 很像。

这也是为什么很多人改了半天,查重率还是下不来。因为你只改了 “表面”,没动 “内核”。想降重,得先明白 AI 是怎么 “看” 文字的,不然都是瞎忙活。

🔍 第一步:把文字变成 “可计算的数字”—— 词向量的魔力

AI 处理文字的第一步,是把咱们说的话、写的字,变成一堆数字。这一步叫 “词向量转换”,是整个检测的基础。

你想啊,计算机只认 0 和 1,哪懂 “开心” 和 “高兴” 的区别?所以工程师就想了个办法:给每个词分配一组数字(比如一个 100 维的数组),这组数字就像词的 “特征码”。两个意思相近的词,特征码会很像。比如 “优秀” 和 “出色”,它们的数字数组会高度重合;而 “天空” 和 “苹果”,数字数组就差很远。

早期用的是 “one-hot 编码”,简单说就是给每个词编个独有的号码,比如 “猫” 是 1,“狗” 是 2。但这种方法有个大问题:它看不出 “猫” 和 “狗” 都是动物,数字上毫无关联。现在早就不用了。

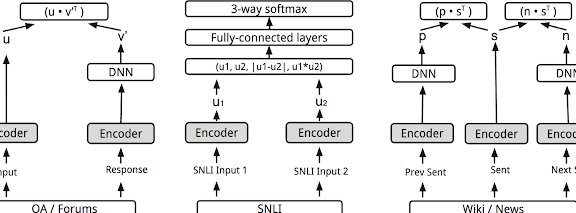

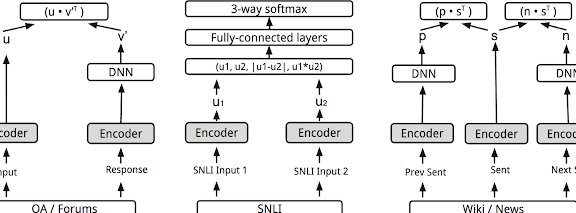

现在主流的是 “Word2Vec”“GloVe” 这些模型。它们会根据词在句子里的 “邻居” 来给数字。比如 “他喝了杯咖啡” 和 “她点了杯拿铁”,“咖啡” 和 “拿铁” 经常出现在类似的语境里,所以它们的词向量就很接近。这一步,AI 就有了点 “理解” 词义的意思 —— 虽然是通过数字算出来的。

这也是为什么你单纯把 “好” 改成 “优秀”,有时候没用。因为它们的词向量太像了,AI 一算就知道这俩词差不多,两段文字的相似度还是高。

🔍 第二步:穿透字面看本质 —— 语义层面的深度比对

光看单个词还不够。有时候两段话用词完全不一样,但意思一模一样。比如 “我吃完饭去散步” 和 “餐后我会外出溜达”,词差不少,但语义高度重合。现在的 AI 检测,早就能抓到这种情况了。

这就要说到 “语义分析” 技术。它不盯着单个词,而是看整个句子甚至段落的意思。怎么做到的?靠 “上下文理解”。就像人说话,同样一个 “意思”,在不同句子里含义可能不同。AI 会结合前后文,给每个词在具体语境里的 “真实含义” 打分。

举个例子,“这个苹果很甜” 和 “这家公司很有前景”,两个 “很” 的词向量一样,但结合上下文,AI 能算出它们在句子里的作用和含义完全不同。而 “他跑得飞快” 和 “他速度惊人”,虽然 “飞快” 和 “速度惊人” 词不一样,但 AI 通过上下文分析,能判断出它们表达的是同一个意思。

现在更厉害的是 “BERT” 这类预训练模型。它能做到 “双向理解”。比如一句话 “我看到银行旁边有棵树”,它能根据 “旁边有棵树” 判断这里的 “银行” 是建筑,不是 “存钱的机构”。这种能力让 AI 能穿透文字表面,直抵语义核心。

所以啊,那种只改几个词,句子结构和整体意思不变的降重方法,在现在的 AI 检测面前基本失效。它就像个经验丰富的老师,学生换种说法抄作业,老师一眼就能看出来。

🔍 第三步:打分靠算法 —— 常用的相似度计算逻辑

把文字变成数字,又分析了语义,接下来就是算 “相似度” 了。这一步靠的是各种算法,算出一个 0-100% 的分数,就是咱们常说的 “查重率”。

最常用的是 “余弦相似度”。你可以把两段文字的词向量想象成两个箭头,箭头的方向和长度代表它们的特征。余弦相似度就是算这两个箭头之间的夹角 —— 夹角越小,方向越接近,相似度越高;夹角 90 度,基本没关系;夹角 180 度,意思完全相反。

比如两段文字主题都是 “人工智能发展”,它们的词向量箭头方向会很接近,余弦值可能在 0.8 以上,查重率就高。如果一段讲 “AI”,一段讲 “做饭”,余弦值可能就 0.2 以下,查重率低。

还有 “欧氏距离” 算法,简单说就是算两个数字数组之间的 “直线距离”。距离越近,相似度越高。不过在文本检测里,余弦相似度用得更多,因为它更能反映 “方向” 上的相似,而不是 “数值大小”。

现在的 AI 检测还会结合 “n-gram 模型”,就是看连续几个词的组合。比如 “机器学习算法” 这个短语,如果你改成 “机器算法学习”,n-gram 模型一比对,就知道这俩短语高度相似,因为组成的词和顺序变化不大。

这些算法不是单独用的,是组合起来用。比如先用词向量转换,再用 BERT 做语义分析,最后用余弦相似度和 n-gram 综合打分。这就是为什么现在的查重结果越来越准,想蒙混过关越来越难。

💡 吃透原理才能降重:针对性破解的 4 个核心策略

知道了 AI 怎么检测,降重就有方向了。别再傻乎乎地替换几个词就完事,得对着它的 “软肋” 下手。

第一个策略:在 “词向量” 上做文章,但要换 “内核”。不是换同义词,而是换 “语义相关但词向量差异大” 的表达。比如 “提高效率”,别换成 “提升效率”(这俩词向量太像),可以换成 “让做事速度变快”。后者和原句意思相近,但用词组合完全不同,词向量差异大,AI 很难判定相似。

第二个策略:打乱 “语义结构”,但保意思。AI 看语义是看整体逻辑,你可以调整句子的 “骨架”。比如原句 “在互联网行业,数据分析是运营的核心,能帮助团队找到用户需求”,可以改成 “运营想在互联网行业抓住用户需求,离不开数据分析 —— 这可是核心手段”。意思没变,但句子结构、词的顺序都变了,语义分析时的 “特征码” 就不一样了。

第三个策略:给文本加 “个性化特征”。AI 对 “共性内容” 敏感,对 “个性化内容” 不敏感。比如写一篇关于 “AI 降重” 的文章,别人都在说 “要改句子”,你可以加一句 “我上次帮一个学生改论文,他光把长句拆成短句,查重率就降了 15%”。这种带个人经历、具体案例的内容,AI 很难在其他文本里找到高度相似的,自然相似度就低。

第四个策略:反制 “n-gram 模型”。它不是看连续的词吗?你就打破这种连续性。比如 “人工智能技术的发展给医疗行业带来了变革”,可以改成 “医疗行业正因为人工智能的进步,发生着不小的变化”。把 “人工智能技术的发展” 拆成 “人工智能的进步”,把 “带来了变革” 改成 “发生着不小的变化”,连续的词组合被打破,n-gram 就很难匹配上。

记住,降重不是 “改得面目全非”,而是 “在保持原意的前提下,让 AI 的数字比对结果变低”。这就像玩捉迷藏,你知道猎人怎么找你,才能藏得更隐蔽。

📝 避坑提醒:这些降重方法早已被 AI “识破”

别用那些过时的套路了,AI 早就盯上它们了。

最没用的就是 “同义词替换 + 语序颠倒”。比如把 “今天天气很好” 改成 “今日气象极佳”,或者 “很好,今天的天气”。现在的词向量和语义分析一眼就能看穿,这种改法查重率基本降不下来,还显得生硬。

还有 “增减虚词”。加个 “的”“了”,或者删个 “吗”“呢”,对 AI 来说等于没改。这些词的词向量本身就没什么特征,增减不影响整体的数字比对结果。

更傻的是 “中英文混杂” 或者 “乱加符号”。比如 “数据分析(data analysis)很重要”,或者 “数据 #分析很重要”。AI 会自动过滤这些干扰项,该相似还是相似,反而让文章读起来别扭。

还有人觉得 “用深度学习模型生成的内容不会被查”,这是错的。现在的 AI 检测已经能识别 “AI 生成文本” 的特征(比如句式单一、缺乏个性化表达),你用 AI 生成再直接用,可能比抄别人的还容易被标红。

说到底,降重的核心是 “理解 AI 的检测逻辑,用人类的创造性对抗机器的计算性”。机器再厉害,也是按规则办事;而人能灵活调整,加入独特的思考和表达 —— 这才是降重的终极武器。