🧩 到底什么是 AI 文本相似度算法?

简单说,AI 文本相似度算法就是让机器判断两段文字像不像的技术。你可能觉得 “像不像” 是很主观的事,但在机器眼里,这全靠数据和公式说话。

比如 “我吃了苹果” 和 “苹果被我吃了”,人类一眼就知道是一个意思。机器怎么判断?它会拆解文字里的关键信息 ——“我”“吃”“苹果” 这三个核心元素都在,只是语序换了,算法就会给出较高的相似度评分。

但如果是 “我吃了苹果” 和 “我买了香蕉”,核心元素差异太大,相似度评分就会很低。这种判断能力,正是现在论文查重、内容原创检测、智能客服回复匹配的核心技术支撑。

有意思的是,早期的算法只会机械比对词语重复率,现在的 AI 已经能理解语境了。就像 “这部手机很流畅” 和 “这台设备运行不卡顿”,以前的系统可能认为不相似,现在的算法却能发现它们在描述同一个意思。

🔍 主流算法原理:从 “看字” 到 “懂意” 的进化

TF-IDF 算法 算是老资格了。它的思路很直接:先统计每个词在文本中出现的频率(TF),再计算这个词在所有文本中出现的稀有程度(IDF)。稀有词的权重更高。

比如 “人工智能” 这个词在某篇文章里频繁出现,同时在其他文章里很少见,那它就会成为判断相似度的关键。但这种方法有个明显缺点 —— 完全不管词语顺序和语义,“我爱你” 和 “你爱我” 在它眼里几乎一模一样。

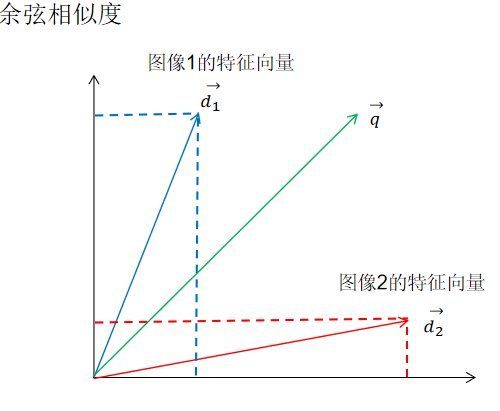

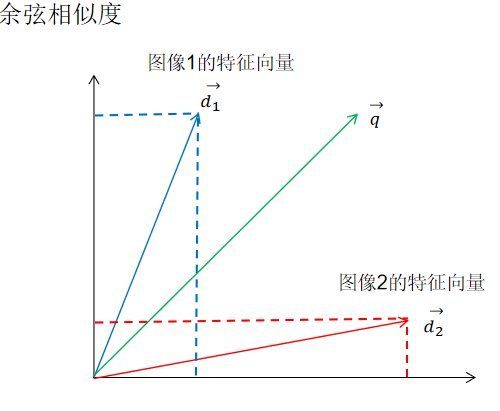

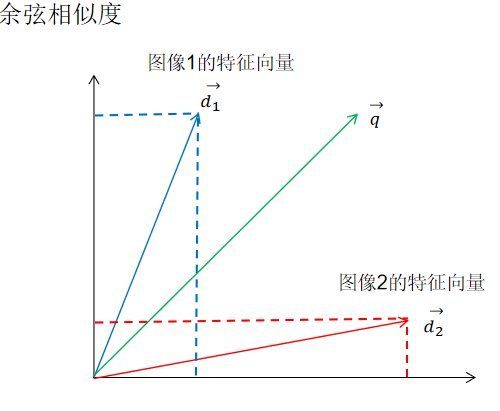

Word2Vec 算法 解决了这个问题。它会把每个词转换成一串数字(向量),意思相近的词,向量位置也靠得近。比如 “医生” 和 “大夫” 的向量几乎重叠,“医院” 和 “诊所” 的向量也离得不远。

这种方法能捕捉到同义词关系,但还是处理不了复杂语境。“他打了篮球” 和 “他打了人” 里的 “打”,向量是一样的,算法分不清动作的差异。

现在最火的BERT 算法 才算真正摸到了语义理解的门槛。它能结合上下文判断词义,就像人类读书时会联系前后文一样。同样是 “苹果”,在 “我吃了苹果” 和 “苹果发布了新手机” 里,BERT 能识别出一个是水果,一个是品牌。

这种能力让它在处理歧义、语序变化、句式转换时特别厉害。这也是为什么现在高端查重系统都在用基于 BERT 的改进算法。

📌 实际应用:这些场景都靠它 “把关”

学术论文查重 是大家最熟悉的应用。知网、维普这些系统背后,就是文本相似度算法在工作。它们会把你的论文和数据库里的文献做比对,标出重复率高的段落。

现在的查重系统越来越聪明了。以前改几个词就能蒙混过关,现在算法能识别 “同义词替换” 的小把戏。比如把 “重要” 改成 “关键”,把 “研究表明” 换成 “调查显示”,这些操作在先进算法面前几乎无效。

自媒体内容原创检测 也离不开它。平台用算法比对你的文章和全网内容,判断是不是洗稿、拼凑。那些把几篇文章的段落打乱重组的 “伪原创”,很容易被揪出来。

有趣的是,不同平台的算法松紧度不一样。头条号对相似度的容忍度就比公众号高一些,因为它更看重信息传播效率。

智能客服系统 也在用这项技术。当你输入问题时,系统会快速比对你的表述和预设答案库,找出最相似的回复。现在的客服能听懂 “这东西怎么退” 和 “我想把这个货退掉” 是一个意思,就是算法进步的功劳。

✏️ 降重技巧:顺着算法的 “脾气” 来

知道了算法的原理,降重就能有的放矢。最有效的方法是改写逻辑结构。比如把 “因为 A 所以 B” 改成 “B 的出现源于 A”,既保留原意,又改变了句式和逻辑表达顺序。

BERT 算法虽然厉害,但对长句的拆解能力有限。可以把长句拆成短句,再调整分句顺序。“在过去的十年里,随着科技的发展,人们的生活方式发生了巨大变化”,可以改成 “科技在这十年里不断进步。它带来的,是人们生活方式的彻底改变”。

替换专业术语的表述方式 也很管用。比如 “机器学习” 可以说成 “让计算机自主学习的技术”,“区块链” 可以描述成 “一种去中心化的分布式记账系统”。算法对这种 “解释性替换” 的敏感度很低。

很多人不知道,改变段落重心 效果更好。比如原文重点讲 “算法的优点”,改写时可以侧重 “算法在实际应用中的表现”,虽然核心信息有重叠,但侧重点不同,相似度会大幅下降。

要记住,降重不是简单的文字游戏。算法越先进,越能识别 “为了改而改” 的痕迹。最好的办法是真正理解原文,用自己的话重新组织表达。

🚫 这些降重误区,算法一眼就能看穿

同义词替换过头 是最常见的错误。有人把 “今天天气很好” 改成 “今日气象十分优良”,读起来生硬不说,算法很容易发现这种刻意修改。现在的系统会分析语句通顺度,不通顺的改写反而会被重点标记。

打乱语序 早就不管用了。以前的算法吃这一套,但 BERT 之类的先进系统能识别 “主谓宾” 的核心结构。“我在公园跑步” 改成 “跑步,我在公园”,在人类看来很奇怪,算法也能看出这是刻意改写。

增减修饰词 效果越来越差。在 “人工智能发展很快” 里加一堆形容词变成 “先进的人工智能技术在近年来发展得异常迅速”,看似变化很大,算法还是能抓住 “人工智能”“发展快” 这两个核心信息。

最傻的是段落调换。把第一章和第二章互换位置,这种小把戏在整篇文章的相似度比对面前毫无意义。算法会从全局角度分析,不会被局部位置变化迷惑。

🔮 未来趋势:算法会越来越 “懂” 文字

现在的算法已经能处理大部分文本相似度问题,但还有提升空间。比如识别 “反讽”“隐喻” 这些修辞手法,目前的系统还很吃力。“你可真聪明” 这句话,如果是反话,算法暂时还分辨不出来。

下一代系统可能会加入情感分析维度。同样意思的话,用积极语气和消极语气说出来,相似度评分可能会不一样。这对客服系统特别有用,能更精准地匹配用户情绪。

跨语言比对 也是重要方向。以后可能实现中文和英文文本的直接相似度判断,这对国际学术查重、跨国内容监测意义重大。

对我们普通人来说,了解这些趋势很重要。未来的降重不会再是 “钻算法空子”,而是真正提升内容原创质量。毕竟,算法再先进,也替代不了人类独特的思考和表达。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】