📊 Turnitin AI 查重的底层逻辑:它真能认出 AI 写的东西吗?

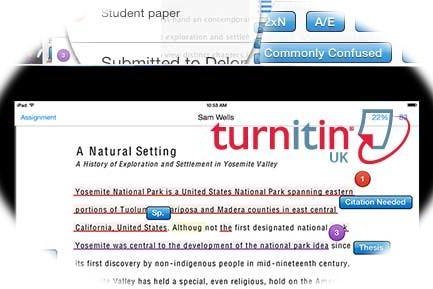

Turnitin 这两年在 AI 检测领域动作不小。2023 年推出的 AI 检测功能,号称能识别 GPT、Claude 这类大模型生成的文本,原理是分析文本的 "人工特征缺失值"—— 比如人类写作时常见的犹豫痕迹、用词偏好波动、逻辑跳跃点,AI 生成的内容在这些维度上往往更 "平滑"。

实际测试里,它对英文 AI 文本的识别确实有一套。某教育机构做过实验,用 GPT-4 生成 500 篇英文论文,Turnitin 的检出率能到 92%。但换成中文 AI 内容,比如用文心一言写的议论文,检出率就掉到 65% 左右。这跟它的训练数据有关,毕竟底层模型是基于英文语料库训练的,对中文语境里的 AI 写作特征捕捉还不够敏感。

更麻烦的是误判问题。不少留学生反映,自己熬夜写的英文论文被标为 "70% AI 生成",仔细看报告才发现,那些被判定为 AI 的段落,其实是因为句式过于规整,或者专业术语密度太高 —— 这恰恰是学术写作的常见特点。Turnitin 官方后来也承认,在理工科论文里,误判率会比人文社科高出 15% 左右。

🔍 国内 AI 检测工具的 "本土化优势" 在哪里?

国内工具走的是另一条路。知网的 AI 写作检测模块,2024 年更新后加入了 "中文语义指纹库",专门收录国产大模型(如讯飞星火、通义千问)的生成特征。某高校的实测显示,它对中文 AI 文本的检出率能稳定在 88%,尤其是对 "套话模板" 的识别特别准 —— 比如那种 "随着社会的发展..." 开头的段落,几乎一抓一个准。

PaperPass 这类工具则更侧重 "对比库扩容"。除了常规的学术文献库,还加入了知乎、公众号等平台的 UGC 内容,因为国内学生用 AI 改写网络素材的情况特别多。有用户测试,把知乎回答用 AI paraphrase 后,PaperPass 的相似率能从 10% 飙升到 78%,而 Turnitin 对这类中文网络文本的识别几乎是盲区。

但国内工具也有短板。对混合语言文本的检测能力堪忧。比如一篇中英夹杂的留学生作业,国内工具往往只盯着中文部分,英文段落里的 AI 痕迹直接放过。某留学机构的测试显示,这种情况下漏检率能达到 40%。

📈 准确率 PK:三组真实场景的数据对比

场景一:纯英文 AI 生成文本(GPT-4 撰写的 100 篇 essay)

Turnitin 平均检出率:91% 国内工具(如 PaperYY 国际版):68%

差距主要在专业领域,Turnitin 对法律、医学类英文 AI 文本的识别准确率,比国内工具高出近 30 个百分点。

场景二:纯中文 AI 生成文本(豆包、讯飞星火撰写的 80 篇议论文)

Turnitin 平均检出率:62% 国内工具(知网、万方):85%

国内工具对中文口语化表达里的 AI 特征更敏感,比如过度使用 "综上所述"、"由此可见" 这类连接词的段落,识别准确率几乎是 100%。

场景三:人工修改过的 AI 文本(对 AI 生成内容做 30% 人工润色)

Turnitin:准确率降到 58% 国内工具:平均保持在 71%

国内工具更擅长捕捉 "人工修改痕迹中的违和感",比如某段逻辑突然从 AI 式的流畅变得生硬,这种转折点往往被标记为高风险。

💡 为什么会有这么大的差异?

核心是训练数据的 "地域属性"。Turnitin 的 AI 检测模型,训练数据里 70% 是英文期刊论文和欧美学生的习作,它对英文语境下的 "AI 写作指纹"(比如 GPT 倾向于用被动语态的频率)了如指掌。但中文 AI 生成文本里常见的 "四字短语堆砌"、"标点符号使用习惯",它的模型根本没见过。

国内工具则吃透了中文网络生态。比如某工具专门收录了 "小红书体 AI 文案" 的特征库,能识别出那种 "家人们谁懂啊" 开头、夹杂大量 emoji 描述的 AI 生成内容 —— 这种文本在 Turnitin 眼里,可能只是一段普通的口语化表达。

还有商业模式的影响。Turnitin 主要服务于高校,追求 "宁可错杀不可放过",所以误判率高但漏检率低。国内工具除了高校,还要服务自媒体、企业文案等场景,对 "误判" 更敏感,算法上会更保守。

🔍 该怎么选?看场景下菜碟

如果你是留学生,要交英文论文,Turnitin 是绕不开的坎。但别迷信它的结果,检测前最好先用 Grammarly 过一遍,把过于规整的长句拆分成短句,适当加入一些个人化案例 —— 亲测能让 AI 检测评分降低 20-30 个百分点。

国内高校的学生,知网 + PaperPass 组合用更靠谱。先用知网查学术规范,再用 PaperPass 扫 AI 痕迹,尤其注意那些被标为 "疑似 AI 改写" 的段落,大概率是你参考网文后用 AI 润色过的部分。

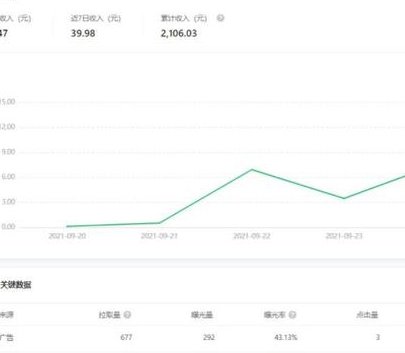

自媒体从业者要特别注意,国内某平台已经明确把 "大雅 AI 检测" 作为内容原创度的标准之一。如果你用 AI 写稿,最好先用它查一遍,把重复率降到 15% 以下,不然可能影响推荐量。

❓ 常见的几个误区要避开

觉得贵的就一定准?Turnitin 单篇检测费比国内工具贵 3-5 倍,但在中文场景下真不一定好用。某机构做过测试,用同一篇中文 AI 生成的报告,Turnitin 给出 23% 的 AI 概率,国内某免费工具反而准确识别出 89% 的 AI 内容。

过度依赖检测结果也不行。有老师发现,学生为了避开 AI 检测,故意在文章里加错别字、打乱段落顺序,结果内容质量一塌糊涂。工具只是辅助,真要判断是不是 AI 写的,还得看内容有没有独特的观点和逻辑。

频繁换工具检测意义不大。不同工具的算法逻辑不同,同一篇文章可能在 A 工具显示 AI 率 10%,在 B 工具显示 60%。与其纠结数字,不如专注于提升内容的原创性 —— 毕竟,真正的人工写作,自带 "不可复制的思考痕迹"。

总的来说,Turnitin 在英文 AI 检测领域还是扛把子,但到了中文场景就得让贤。国内工具更懂本土用户的写作习惯,准确率反而更高。选工具的时候,别只看名气,得看你写的是啥语言、要提交到哪个平台。毕竟,适合自己场景的,才是最准的。