📝 什么是 AI 伪原创?先搞懂基础逻辑

很多人以为 AI 伪原创就是简单替换同义词,这想法可太天真了。实际上这项技术是通过人工智能算法对现有文本进行重组、改写或全新生成,最终产出看似原创但核心信息源自原始内容的文本。它和传统意义上的抄袭不一样,更像是 "智能转述"—— 既保留关键信息,又在表达方式、句式结构甚至段落逻辑上做出改变。

举个例子,一篇讲 "夏季防晒技巧" 的文章,经过 AI 伪原创处理后,可能会把 "涂抹防晒霜前要清洁皮肤" 改成 "在使用防晒产品之前,建议先对肌肤进行彻底清洁",不仅换了说法,还调整了句式长度。更高级的伪原创系统甚至能重新排列段落顺序,比如把 "选择 SPF30 + 的产品" 放到开头,而不是原来的中间位置,但整体防晒知识体系不会被打乱。

这种技术的核心价值在于解决内容生产效率问题。现在互联网对内容需求量太大了,自媒体、电商平台、企业官网每天都需要大量文字素材。如果全靠人工原创,成本高得吓人。AI 伪原创就成了折中方案 —— 既满足了 "新内容" 的需求,又不用从零开始创作。

🧠 核心技术原理:AI 是怎么 "读懂" 文字的?

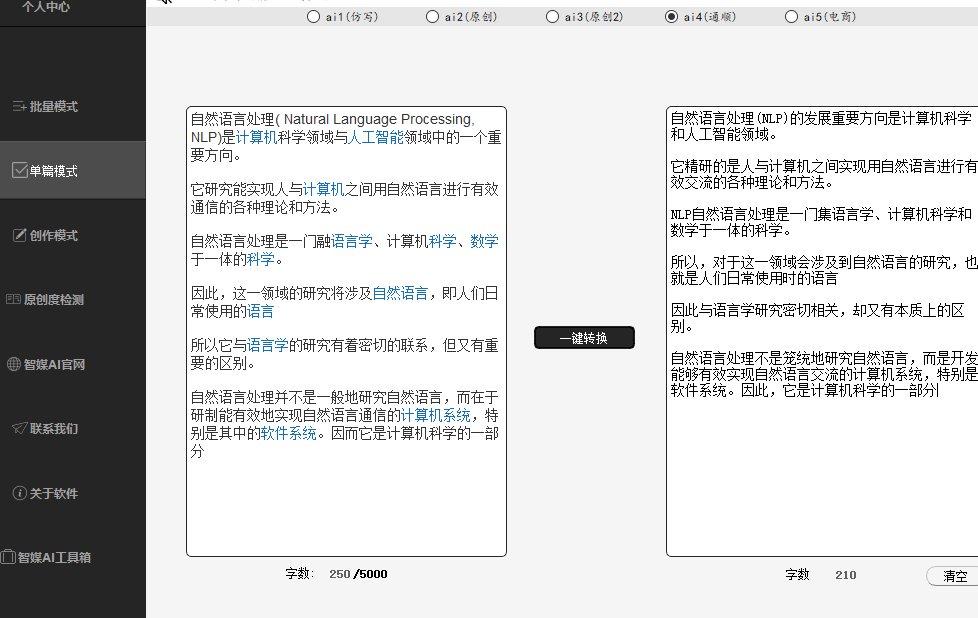

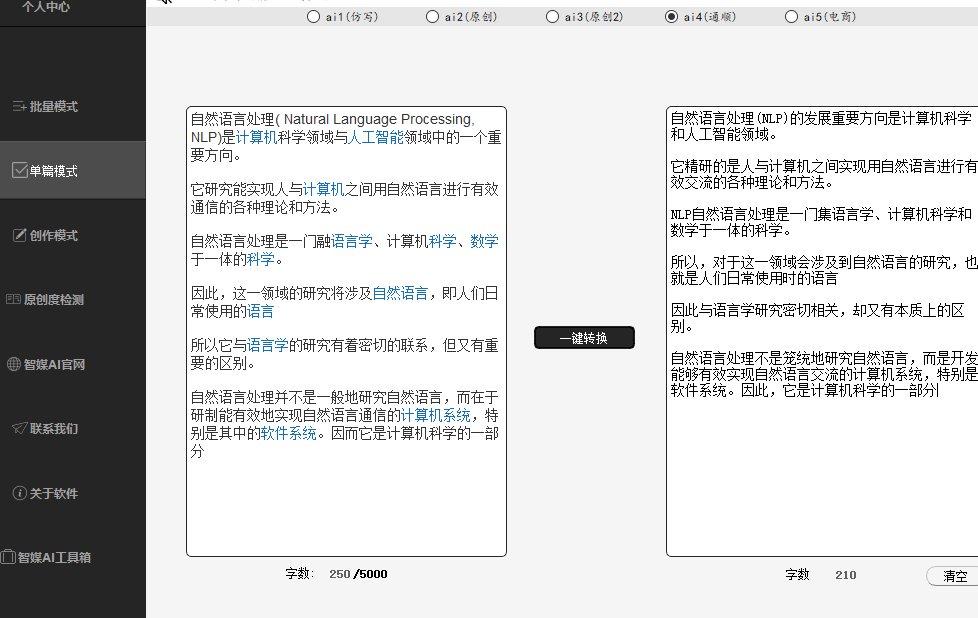

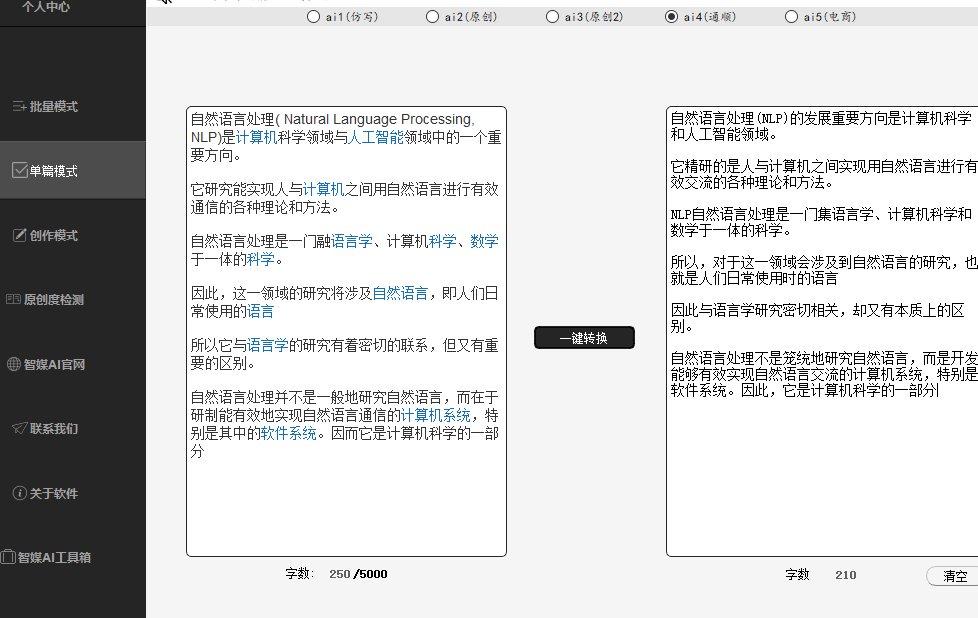

要搞懂 AI 伪原创的工作原理,得先了解两个关键技术:自然语言处理(NLP)和深度学习模型。这俩是 AI 能 "理解" 并改写文字的基础。

自然语言处理就像给 AI 装了个 "语言解码器"。它能让机器识别文字中的词汇、语法和语义关系。比如看到 "苹果" 这个词,系统会判断在当前语境中是指水果还是科技公司。这种语境识别能力很重要,要是连意思都搞混了,改写出来的内容肯定驴唇不对马嘴。

深度学习模型则像是 AI 的 "大脑",目前主流的是 Transformer 架构(比如 GPT 系列就用这个)。它的工作原理有点像人类学习语言 —— 通过分析海量文本数据,总结出语言规律。举个例子,系统看过几十万次 "因为... 所以..." 的句式后,就会明白这是因果关系,改写时可能换成 "由于... 因此...",但不会破坏逻辑。

还有个关键技术叫 "词向量",简单说就是把文字变成机器能理解的数字。每个词都会被转化成一串数字,相似意思的词数字串也相近。比如 "高兴" 和 "开心" 的数字串差异很小,AI 在改写时就能根据这个特性找到合适的替换词,而不是瞎换。

这些技术结合起来,就让 AI 伪原创能做到 "既变又不变"—— 变的是表达方式,不变的是核心信息。它不是简单替换,而是基于对文本的理解进行再创作。

🔄 实现路径:从文本输入到输出的全过程

AI 伪原创的工作流程其实挺复杂,不是一输入就马上出结果。一般要经过三个主要阶段,每个阶段都有不同的技术处理。

首先是数据预处理。系统会先给原始文本 "做体检",比如拆分句子、识别关键词和核心观点。就像人改写文章前要先通读理解一样,AI 也需要这个步骤。它会给重要信息标上 "权重",比如一篇产品测评里,"价格"、"性能" 这些词的权重就比 "今天天气不错" 高得多,确保改写时不会丢了重点。

然后是文本生成 / 改写阶段。这一步有两种常见方式:一种是 "同义句转换",适合轻度改写,主要改句式和用词;另一种是 "深度重组",会调整段落结构,甚至用不同逻辑重新组织内容。比如把说明文改成记叙文风格,或者把总分结构改成分总结构。

最后是质量校验。高级系统会自己检查改写后的文本是否通顺,逻辑是否连贯,有没有出现常识错误。比如不能把 "手机充电时不要打电话" 改成 "打电话时必须给手机充电",这就完全反了。有些工具还会检测查重率,确保输出内容和原文的重复度低于一定阈值,通常是 30% 以下。

整个过程快的话几秒钟,慢的可能要几十秒,主要看文本长度和系统算力。现在的技术已经能做到改写后的文本读起来很自然,不仔细对比原文,很难发现是伪原创。

🛠️ 主流工具的技术差异:为什么有的改得好有的像废话?

用过几款 AI 伪原创工具的人可能会发现,效果差得有点多。有的改完读起来流畅自然,有的却像机器翻译出错,这背后是技术路线的差异。

最基础的工具用的是 "规则库 + 同义词表" 的简单方法。就像查字典替换一样,把 "优秀" 换成 "杰出","快速" 换成 "迅速"。这种方法成本低,但缺点明显 —— 经常出现搭配不当,比如把 "打羽毛球" 改成 "击羽毛球",虽然意思对,但读着别扭。而且改不了句式,查重率也降不下来。

中级工具会加入语法分析器,能调整句式结构。比如把主动句改成被动句,"我吃了苹果" 变成 "苹果被我吃了"。还能拆分长句或合并短句,让文本结构更多样。这类工具改出来的内容通顺度提高不少,但还是会有逻辑断层,尤其是处理长文本时,前后文衔接容易出问题。

高端工具则用大语言模型,比如基于 GPT、BERT 这些模型开发的。它们的优势是 "理解语境",能根据上下文选择最合适的表达方式。比如同样是 "发烧" 这个词,在医疗文章里可能改成 "体温升高",在日常对话里可能改成 "发烧了不舒服"。这种工具还能保持风格一致,要正式就一直正式,要口语化就全程口语化。

还有个关键差异是 "训练数据"。用优质、多样的数据训练出来的模型,改写能力更强。比如专门用新闻稿训练的工具,改新闻类文本就特别顺手,但改小说可能就差点意思。所以选工具时要看它的专长领域,别指望一个工具包打天下。

📊 应用场景:哪些地方在用 AI 伪原创?

AI 伪原创技术现在用得挺广,不止是自媒体作者在靠它 "偷懒"。很多行业都在悄悄用,只是形式不一样。

内容创作领域用得最多。比如自媒体矩阵运营,同一个选题要发在十几个账号上,总不能写十几遍原创。用伪原创工具改出不同版本,既能覆盖更多平台,又不会因为重复内容被限流。电商平台的商品描述也常用,同一款产品,不同店铺用不同的文案,能避免平台判定重复铺货。

SEO 优化是另一个大场景。搜索引擎不喜欢重复内容,相同的文章发多了会降权。SEO 从业者就用伪原创生成多个版本,发布在不同的网站或专栏,用相似内容抢占多个关键词排名。比如围绕 "北京旅游攻略",改出 "去北京玩怎么规划路线"、"北京旅游必去景点推荐" 等不同标题和内容,其实核心信息差不多。

教育领域也有应用,主要是帮学生改写作文初稿。有些工具能识别文章中的啰嗦表达,给出更简洁的说法,同时保持原意。但这也引发争议,有人担心学生会完全依赖工具,丧失原创能力。

企业内部文档处理也常用。比如把复杂的技术文档改写成通俗的用户手册,或者把英文资料改写成中文时,先用伪原创工具处理一遍,再人工校对,能节省不少时间。

不过要注意,不是所有场景都适合用。法律文书、学术论文这些对准确性和原创性要求极高的领域,用伪原创风险很大,很容易出问题。

⚠️ 技术局限与未来方向:别太迷信 AI 的 "原创力"

虽然 AI 伪原创越来越厉害,但它的局限也很明显,现在还做不到完美。最头疼的是原创性判定问题。有时候改得太像原文,会被查重系统抓住;改得太狠,又可能丢了核心信息。比如一篇讲 "电脑散热技巧" 的文章,要是把 "清理风扇灰尘" 这句关键信息改没了,那改写就失去意义了。

语义一致性也是个难题。长文本改写时,AI 可能前面说 "这款手机续航强",后面又写成 "电池容量小",自己前后矛盾。这是因为模型对长文本的全局把控能力还不够,经常顾此失彼。

还有个更麻烦的问题是知识准确性。如果原文本身有错误,AI 伪原创会照单全收,甚至把错误放大。比如原文错把 "维生素 C 不能和海鲜同吃" 写成 "维生素 E",AI 可能会改写成 "海鲜与维生素 E 同食有害",让错误传播得更广。

未来的技术会往这几个方向发展:一是更好的语境理解能力,尤其是长文本的逻辑连贯性;二是加入事实核查模块,减少错误信息传播;三是个性化改写,能模仿特定作者的写作风格,让伪原创更难被识别。

但说到底,AI 伪原创只是个工具,它不能替代真正的原创能力。好的内容还是需要人的创意和思考,AI 最多是个 "高效助手",而不是 "万能写手"。明白这一点,才能正确用好这项技术,既提高效率,又不丢了内容的灵魂。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】