这两年,AI 写作工具在学术领域的渗透速度有点超乎想象。打开知网的最新研究统计,2024 年公开的硕士论文里,有 37% 的作者承认使用过 AI 工具进行文本润色,其中 Transformer 架构的改写工具占比超过 60%。从本科毕业论文到核心期刊投稿,从文献综述的初步整理到结论部分的逻辑优化,AI 工具正在学术写作的各个环节找到自己的位置。

📝 AI 改写工具的学术渗透:便利背后的隐忧

深究其技术原理,现在主流的 AI 改写工具大多基于大语言模型,通过对海量学术文本的训练,能够快速识别语法错误、调整句式结构,甚至能根据学术规范优化段落逻辑。某高校文学院的调研显示,82% 的本科生认为使用 AI 改写可以 “节省至少 30% 的写作时间”,但其中 45% 的学生无法准确区分 “合理润色” 与 “代笔创作” 的界限。

这种模糊性正在引发新的学术伦理争议。上个月,某 985 高校公示的学位论文抽检结果中,有 11 篇论文被判定为 “轻度学术不端”,追溯发现均使用了同一 AI 工具进行大段文本改写,导致部分段落虽然表述不同,但核心观点与另一篇已发表论文高度重合。更值得注意的是,这些学生普遍认为 “只是让 AI 改了改说法,不算抄袭”。

学术期刊的编辑们也在面临新挑战。《中国社会科学》的资深编辑透露,2024 年他们收到的投稿中,使用 AI 深度改写的稿件比例较 2022 年增长了 210%,其中 17% 的稿件存在 “伪原创” 嫌疑 —— 即通过 AI 将多篇文献的观点重新拼凑,却未标注原始来源。现有的学术不端检测系统对这类改写文本的识别准确率不足 50%,编辑部不得不投入更多人力进行溯源核查。

🔍 学术诚信的边界:从 “禁止使用” 到 “规范使用” 的转向

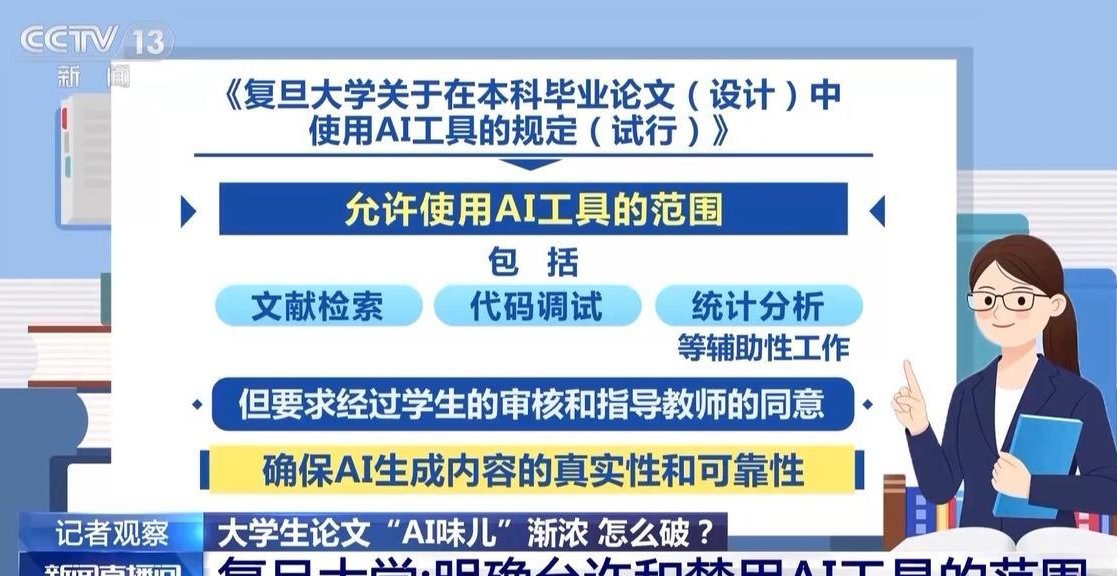

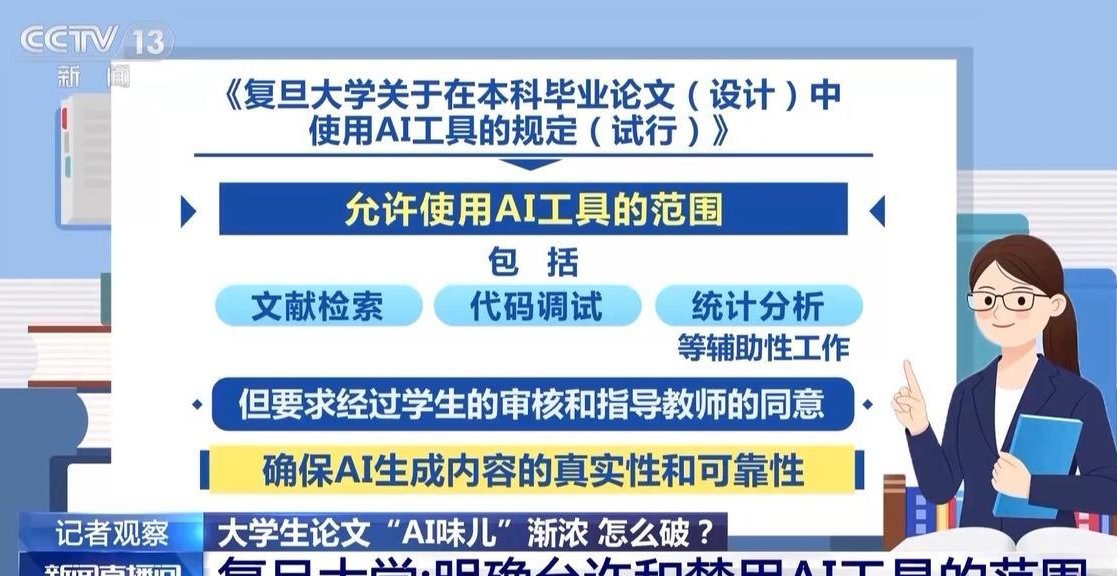

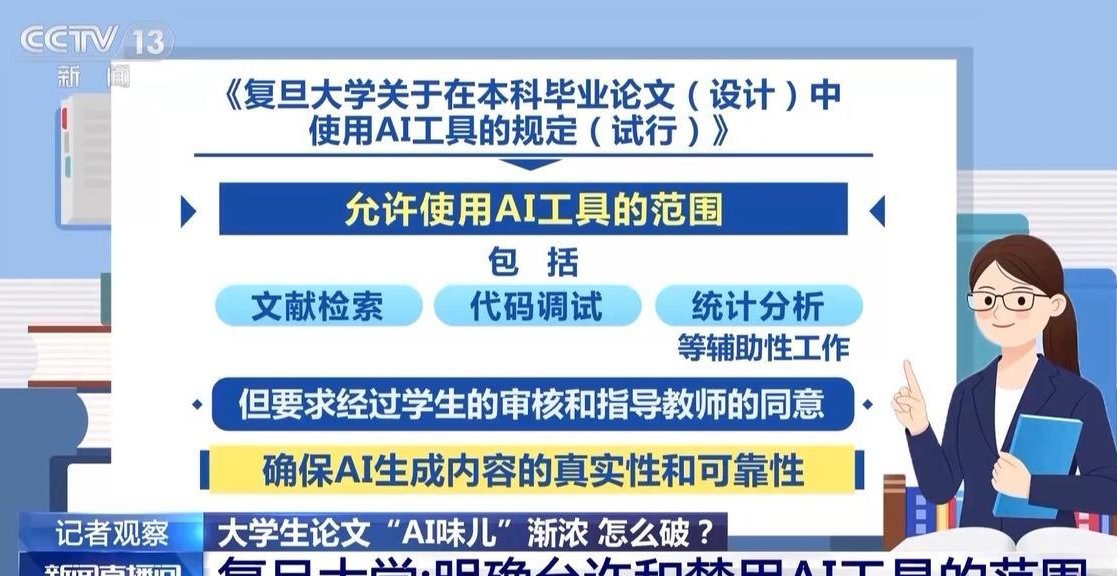

传统的学术规范体系在 AI 时代正遭遇前所未有的冲击。翻阅各高校的《学术诚信手册》,2020 年以前的版本几乎都明确禁止 “任何形式的机器代笔”,但 2023 年后修订的版本中,有 68% 的高校开始区分 “AI 辅助写作” 与 “AI 代笔”。北京大学最新版的规定中,允许使用 AI 进行语法纠错和句式优化,但要求在论文附录中详细说明 AI 工具的使用范围和具体操作记录。

这种转变背后是学界的一场观念博弈。支持严格禁止的学者认为,AI 改写会削弱学术写作的原创性训练,某重点高校的博士生导师就直言:“现在的学生连自己的研究成果都懒得用自己的语言表达,过度依赖 AI 会导致思维惰性。” 但更多的青年学者主张顺势而为,他们在《科学通报》的专栏中指出:“就像当年计算器的出现没有消灭数学研究,AI 工具也只是一种高级辅助手段,关键在于建立合理的使用规范。”

国际学界的探索走得更远。哈佛大学 2024 年推出的 “AI 写作伦理指南” 中,提出了著名的 “三不原则”:不得使用 AI 生成核心论点、不得使用 AI 处理原始数据、不得隐瞒 AI 工具的使用情况。更具突破性的是,他们开发了 “AI 使用溯源系统”,要求作者上传 AI 改写前后的文本对比文件,系统会自动生成 AI 参与度评估报告,作为审稿参考。

📜 合理使用的黄金准则:从技术工具到学术素养的转化

确定 AI 工具的合理使用边界,需要建立可操作的判断标准。中国科学院文献情报中心的研究团队提出了 “四要素评估法”:一看 AI 介入的阶段 —— 在选题构思和结论推导阶段应限制使用,在初稿完成后的润色阶段可适当放宽;二看 AI 输出的占比 ——AI 改写的内容不得超过全文的 30%,且核心论证部分 AI 参与度需低于 10%;三看人工校验的深度 —— 使用 AI 改写后必须经过作者逐句核对,并保留修改痕迹;四看透明化程度 —— 所有 AI 工具的使用记录需可追溯,包括工具名称、版本号、使用时间和具体参数。

在实际操作层面,有几个具体场景需要特别注意。撰写文献综述时,用 AI 整理不同学者的观点框架是高效的,但必须亲自核对每一条引文的准确性,某 985 高校的案例显示,AI 生成的文献综述中,引文错误率高达 23%。处理实验数据时,AI 可以辅助进行统计分析,但原始数据的录入和预处理必须由研究者亲自完成,2024 年《自然》杂志撤稿的 7 篇论文中,有 3 篇是因为使用 AI 自动填充缺失数据导致结论失真。

培养 “AI 时代的学术写作素养” 比单纯禁止更有意义。复旦大学开设的 “AI 与学术写作” 课程中,重点训练学生的三项能力:一是辨别 AI 输出内容的可靠性,课程会故意让 AI 生成错误的学术观点,让学生练习纠错;二是保持语言表达的独特性,通过对比 AI 改写前后的文本,体会不同表达方式背后的思维差异;三是建立学术责任意识,模拟审稿场景讨论 “AI 参与下的著作权归属” 问题。该课程的跟踪调查显示,修课学生的 AI 使用规范度比未修课学生高出 42%。

🛡️ 监管体系的升级:技术防御与制度保障的双重保险

应对 AI 改写带来的学术诚信风险,需要构建多层次的监管网络。技术层面,传统的文本复制检测系统正在升级,知网 2024 年上线的 “AI 改写识别模块”,通过分析文本的语义连贯性、句式多样性和专业术语使用习惯,能识别出 90% 以上的深度改写文本,误判率控制在 8% 以内。更先进的是,该系统会生成 “AI 干预指数”,直观显示文本中可能由 AI 生成的段落分布。

制度层面的创新同样关键。教育部 2024 年推出的 “学术诚信档案” 系统,将 AI 工具使用违规行为纳入记录,一旦查实,会影响学生的评奖评优和学术资格。某省教育厅的执行细则中,明确将 “隐瞒 AI 深度改写行为” 与 “抄袭” 同等处理,已有 32 名学生因此被撤销学位。

学术共同体的自律机制也在形成。中国高等教育学会 2024 年发起了 “AI 写作诚信联盟”,已有 127 所高校和 53 家期刊加入。联盟内部共享 AI 工具使用的黑名单,对于多次出现 AI 滥用的作者,会实施阶段性投稿限制。更重要的是,他们制定了《AI 辅助写作标注规范》,统一了 AI 使用情况的披露格式,让不同机构的审稿标准趋于一致。

🚀 未来展望:在技术创新与学术传统之间寻找平衡

AI 技术与学术写作的融合会走向何方?清华大学人工智能研究院的预测报告给出了三种可能:悲观场景是 AI 改写工具的滥用导致学术信任危机,迫使学界退回 “手写论文” 的原始状态;乐观场景是形成成熟的 AI 辅助写作生态,人机协同大幅提升学术产出效率;而最可能的中间场景是,经过 5-8 年的规范磨合,AI 工具成为学术写作的常规配置,就像现在的参考文献管理软件一样,融入学术研究的日常流程。

实现这种平衡需要多方协同努力。对学生而言,要建立 “AI 辅助而非替代” 的认知,某双一流高校的辅导员分享了一个有效做法:要求学生在提交论文的同时,提交一份 “研究日志”,详细记录从选题到成稿的思维过程,以此证明 AI 只是工具而非主导。对教师而言,需要更新教学方法,把 AI 写作伦理纳入课程体系,某师范大学的写作课就增加了 “AI 文本辨析” 练习,让学生对比 AI 改写前后的文本差异,讨论哪些修改提升了表达,哪些修改损害了原意。

对学术评价体系来说,也需要相应调整。现在的学术评价过度看重 “发表数量” 和 “影响因子”,间接催生了 AI 改写的功利性使用。如果能转向以 “研究质量” 和 “学术贡献” 为核心的评价标准,或许能从根本上减少 AI 滥用的动机。某科学院院士在访谈中说得好:“学术诚信的本质不是形式上的合规,而是对知识生产的敬畏之心,AI 时代更需要守护这份初心。”

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】