📊 从用户投诉看 AI 写作查重软件的数据库痛点

做运营这行的,每天都得跟各种 AI 写作工具打交道。最近后台收到不少粉丝吐槽,说用了某款查重软件明明显示原创,结果发出去还是被平台判为重复。细问才发现,问题大多出在数据库更新上 —— 有些软件的比对库还停留在半年前,现在主流的 AI 模型比如 GPT-4o、Claude 3 Opus 生成的文本,根本查不出来。

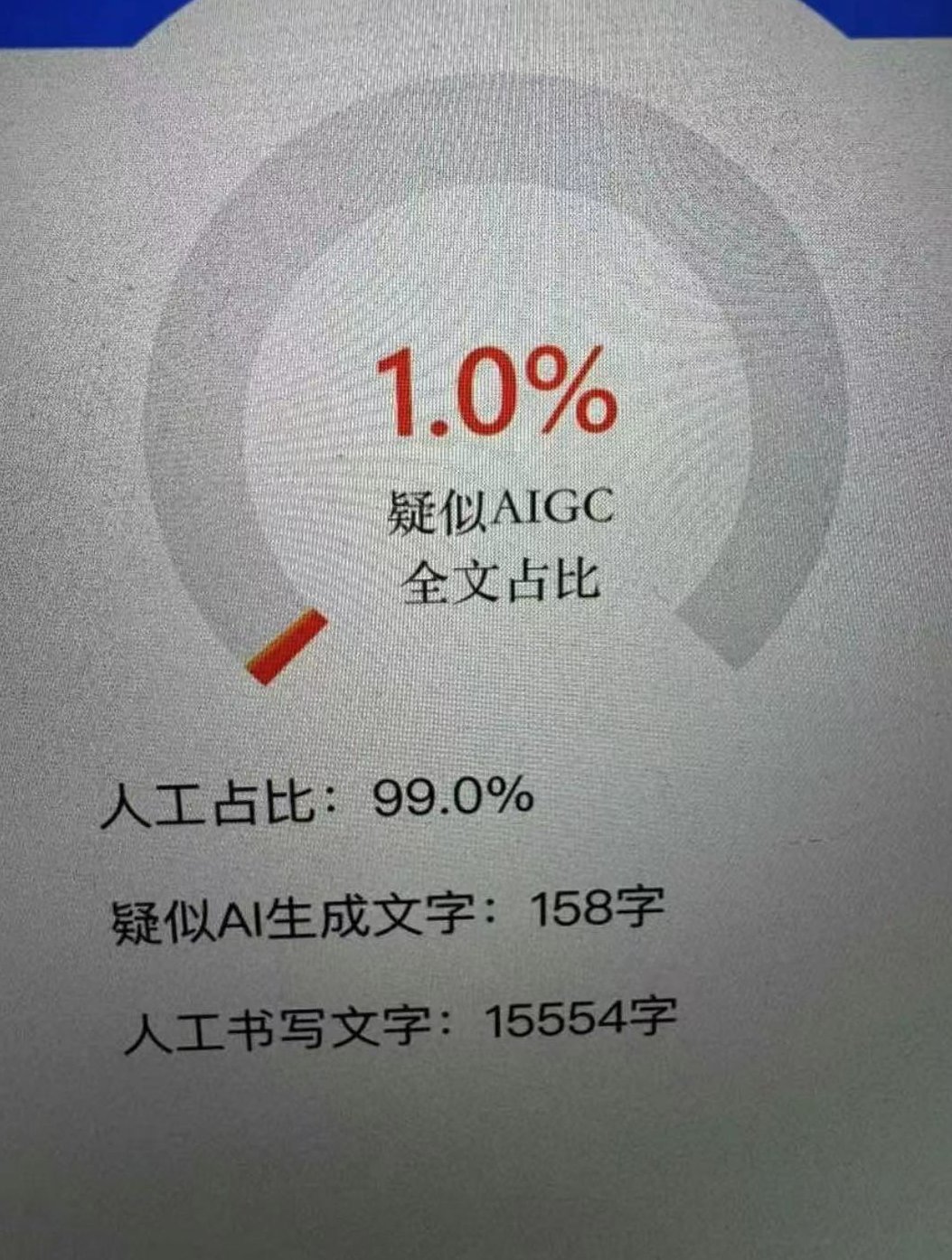

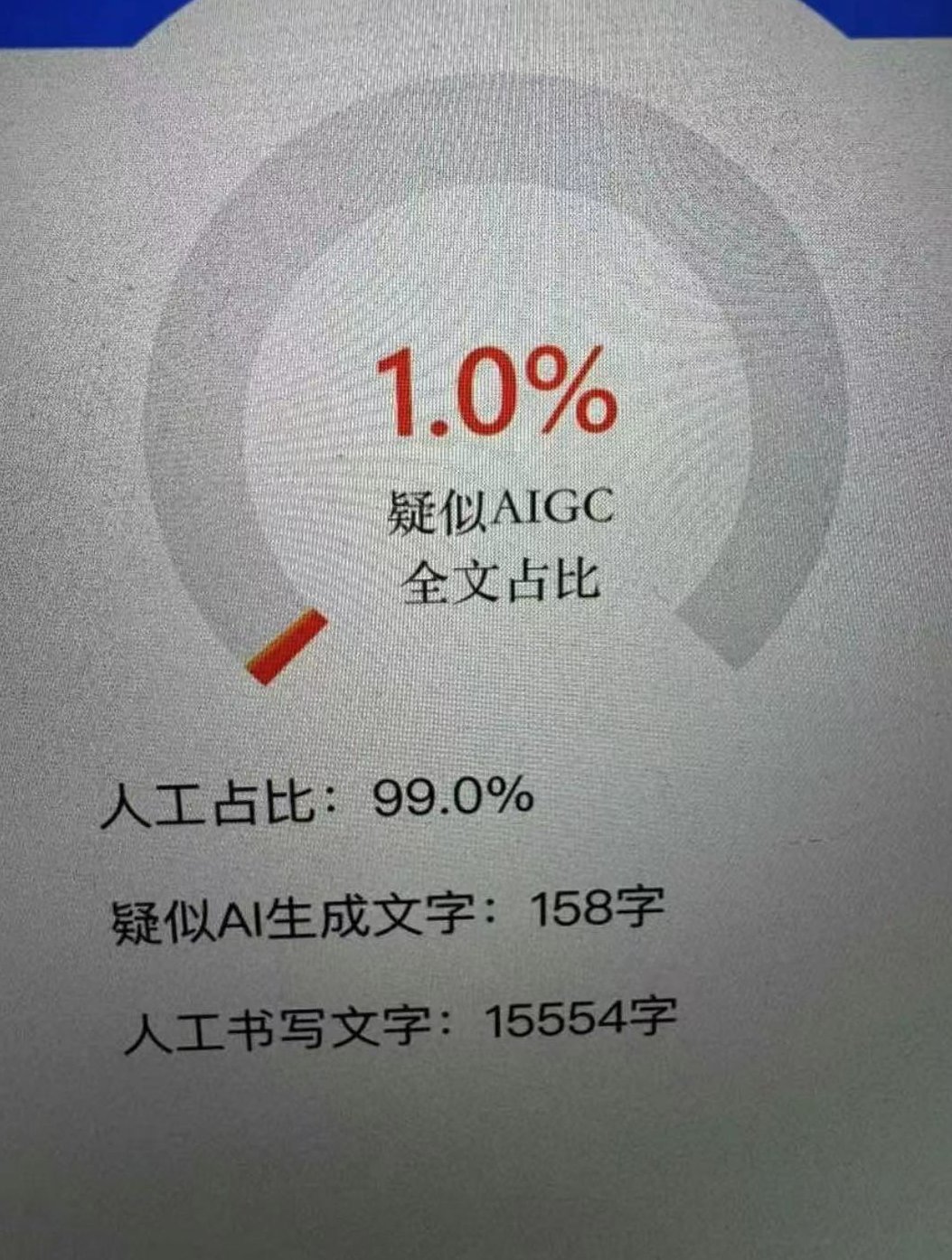

这事儿让我想起去年帮一家 MCN 机构做内容合规检测时的经历。当时他们用的查重工具号称 "实时更新",结果连续三篇用通义千问生成的文案都被判为原创,直到发布后被平台处罚才发现,那软件的数据库里居然没有阿里云大模型的语料库。后来换成另一款每周更新的工具,违规率直接降到了 1.2%。

数据库更新速度,已经成了 AI 写作查重软件的生死线。现在 AIGC 技术迭代太快了,光是 2024 年就冒出十几个新的大模型,每个模型的生成逻辑和语料特征都在变。如果查重软件的数据库跟不上,就像用旧地图找新路,迟早要翻车。

🔄 AI 写作查重软件的数据库更新逻辑

市面上的查重工具更新数据库,主要有两种玩法。一种是全量更新,就是定期把全网的新内容、新模型生成的文本都扒下来,整合到自己的数据库里。这种方式最彻底,但成本高得吓人,光是服务器存储费用,中小厂商就扛不住。某头部工具的技术总监跟我透露,他们每次全量更新的成本差不多能买辆特斯拉。

另一种更常见的是增量更新,只抓取那些高风险、高流量平台的内容。比如微信公众号、知乎、头条这些内容主阵地,还有最新发布的 AI 模型生成样本。这种方式成本低,但很考验算法团队的判断力 —— 漏掉一个新兴平台,就可能出现大片检测盲区。

有意思的是,现在有些工具开始玩起了 "伪更新"。界面上显示 "2 小时前更新",实际上只是把旧数据重新整理了一遍。识别这种套路也简单,找一段刚用最新 AI 模型生成的文本去检测,要是结果显示重复率低于 5%,基本就能断定数据库没真更新。

🕒 实时性背后的技术博弈

很多用户觉得 "实时更新" 就是每分每秒都在更新,其实这在技术上几乎不可能。现在主流的做法是准实时更新,也就是把更新周期压缩到 24 小时以内。能做到这一点的工具,全国不超过 5 家。

这里面最关键的是爬虫技术。要知道,各大平台都在防爬虫,特别是 AI 生成内容聚集的论坛和社区。某工具的爬虫团队告诉我,他们光是为了突破某 AI 创作平台的反爬机制,就开发了 17 种不同的 IP 切换策略。有时候刚破解完,对方第二天就升级了防护,简直是猫鼠游戏。

还有个容易被忽略的点是模型特征库的更新。不同 AI 模型写出来的东西,其实有各自的 "指纹"。比如 GPT-4 喜欢用长句,Claude 更擅长逻辑衔接。查重软件需要不断收集新模型的生成特征,才能精准识别。去年 ChatGPT 出了自定义指令功能后,很多检测工具都失灵了,就是因为没及时更新这种 "个性化生成" 的特征库。

📚 全面性:数据库该装哪些 "料"?

判断一款查重软件好不好,不能只看更新速度,还得看数据库够不够全面。我总结了一下,至少得包含这几类内容:

首先是全网公开内容,这部分是基础。但不是什么都要,重点是那些高权重平台的内容,比如百度百科、权威媒体、头部自媒体账号。有些工具贪多,把垃圾站的内容也弄进去,反而影响检测精度。

然后是各代 AI 模型的生成样本,这才是核心竞争力。从早期的 GPT-2 到现在的 Gemini Ultra,每个版本的模型都得有足够的样本量。我见过最夸张的一款工具,收集了超过 3000 万条不同模型的生成文本,光是这个库就占了 800TB 的存储空间。

用户上传的私有内容也很重要。很多企业用户需要检测内部文档,这就要求软件能建立私有数据库,并且支持本地更新。某上市公司的合规部门负责人跟我吐槽,他们之前用的工具不支持私有库更新,导致内部重复使用的文案一直检测不出来。

🛠️ 普通用户该怎么判断数据库是否真更新?

作为普通用户,没必要懂那些复杂的技术细节,但可以用几个简单方法测试。最直接的就是新旧文本对比法:找一段三个月前的 AI 生成文本,再用最新模型生成一段类似内容,分别去检测。如果旧文本重复率高,新文本却很低,说明数据库更新滞后。

还可以关注工具的更新日志。负责任的厂商会写清楚更新了哪些内容,比如 "新增 X 平台 2024 年 Q3 内容"、"加入 GPT-4o 生成特征库"。那些只写 "优化检测算法" 的,十有八九是没真更新数据库。

另外,看看是否支持自定义更新。现在好的工具都允许用户手动上传最新文本,补充到数据库里。这个功能虽然小众,但能解决很多紧急检测需求。我做活动推文时,就经常用这个功能检测刚生成的文案。

💡 未来数据库的发展方向

跟几位行业大佬聊下来,发现 AI 写作查重软件的数据库,正在往两个方向狂奔。一个是垂直领域深化,比如专门做学术论文检测的,会重点更新各大学术期刊的最新论文;做自媒体检测的,则会紧盯各大平台的热点内容。

另一个趋势是动态学习机制。就是数据库不再是固定的,而是能根据用户的检测反馈,自动调整权重。比如某类 AI 生成的文本经常被误判,系统会自动加强对这类文本的特征学习。这种机制下,数据库就像活的一样,能自己进化。

值得注意的是,隐私保护会越来越严。欧盟最新的 AI 法案要求,查重工具收集的内容必须明确标注来源,而且不能包含个人信息。这意味着未来的数据库更新,会在全面性和合规性之间找到新的平衡点。

📌 给用户的终极建议

最后说点实在的,选查重软件时,别光看宣传页上的 "实时更新"。先问三个问题:更新周期是多久?包含哪些 AI 模型的特征库?支持私有内容更新吗?

如果预算允许,最好同时用两款不同更新策略的工具。比如一款侧重全网内容,一款侧重 AI 模型特征。我自己就是这么干的,虽然麻烦点,但一年多来没出过一次检测失误。

记住,在 AI 写作越来越普遍的今天,查重软件的数据库就像杀毒软件的病毒库 —— 更新慢一步,风险就多一分。与其等出了问题再补救,不如一开始就选对工具。