✍️ 写作猫的核心优势:为什么学术圈开始依赖 AI 工具?

p9-flow-imagex-sign.byteimg.com

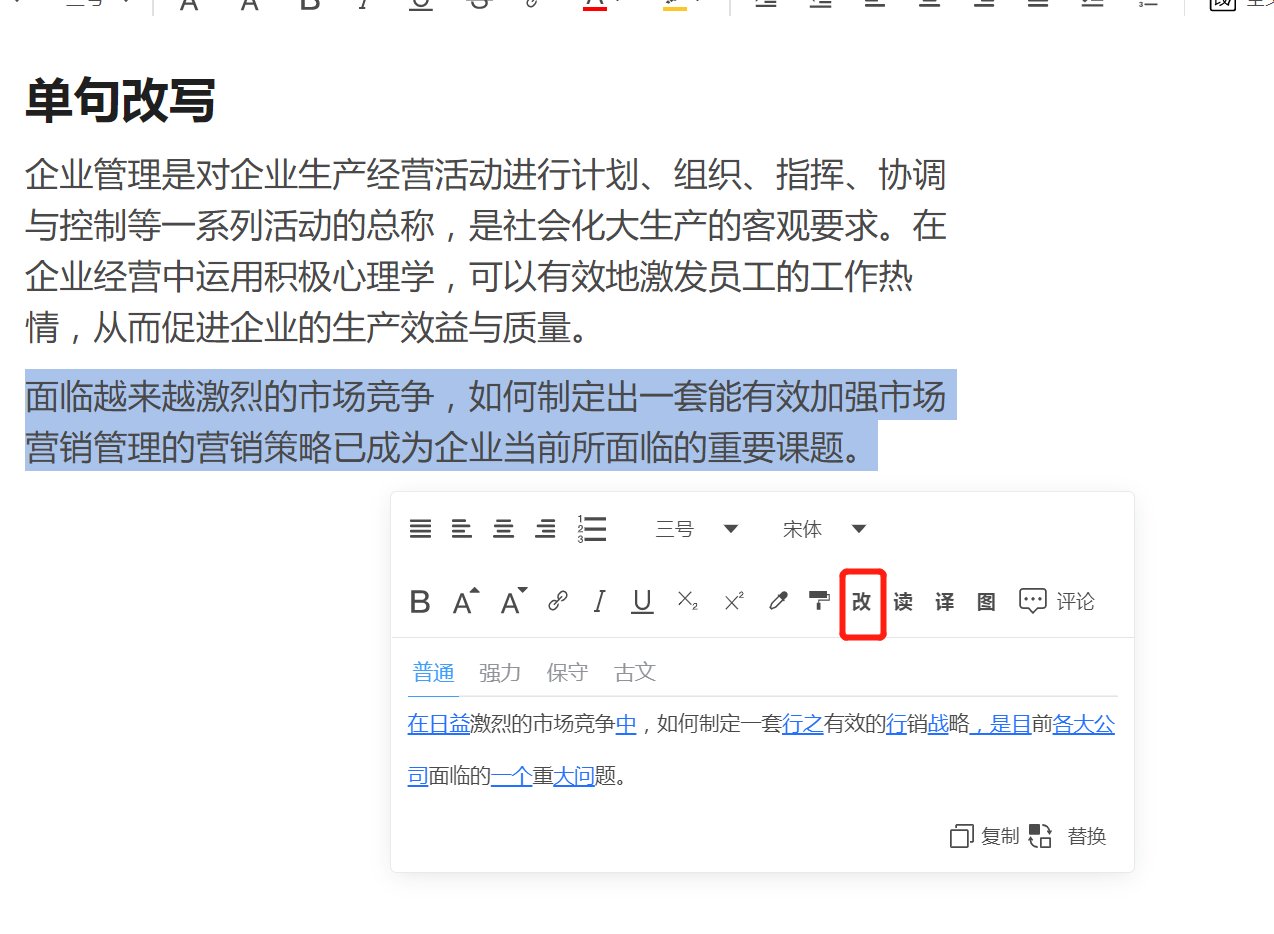

接触过写作猫的研究生大概都有同感 —— 它最让人上瘾的是 **“思维破冰” 能力 **。不少人写论文时会卡在引言部分,盯着空白文档两小时写不出一句话。这时候把研究主题输入写作猫,它能在 30 秒内生成 3 种不同的开篇思路,有的从研究背景切入,有的用数据对比引出问题,甚至能帮你梳理出 3-5 个潜在的研究缺口。这种 “先有框架再填肉” 的模式,对拖延症患者来说简直是救星。

文献综述是另一个重灾区。传统方法里,你得把 20 篇核心文献通读一遍,再手动提炼观点分类整理。写作猫的文献摘要功能能直接抓取 PDF 里的研究目的、方法和结论,还能自动生成可视化的观点矩阵 —— 比如把 10 篇关于 “人工智能伦理” 的论文按 “支持 / 反对 / 中立” 分类,甚至标出哪些研究用了相同的数据集。某 985 高校的博士生私下说,用这个功能能把文献综述的写作时间压缩 60%,但前提是你得自己先筛选出高质量文献,不能全靠 AI 抓瞎。

语言润色方面,它对非母语者特别友好。有个留学生分享过,自己初稿里 “this paper think” 这种低级错误,写作猫能直接标红并替换成 “this study argues”,还会标注学术写作中 “think” 和 “argue” 的使用场景差异。更贴心的是它能识别中式表达,比如把 “我们可以看到” 调整为 “由此可见”,既保留原意又符合学术语体。但要注意,它的润色风格偏美式英语,投国内期刊时最好再用中文润色功能过一遍。

数据可视化辅助是容易被忽略的亮点。当你输入一组实验数据,它能自动推荐最合适的图表类型 —— 比如对比数据用柱状图,趋势变化用折线图,还会生成图表标题和注释的参考文本。这对统计学基础薄弱的文科学生来说很实用,不过生成的图表格式往往需要手动调整才能符合期刊要求,毕竟每个刊物的图表规范都有细微差别。

⚠️ 被忽略的风险:学术写作中 AI 工具的雷区

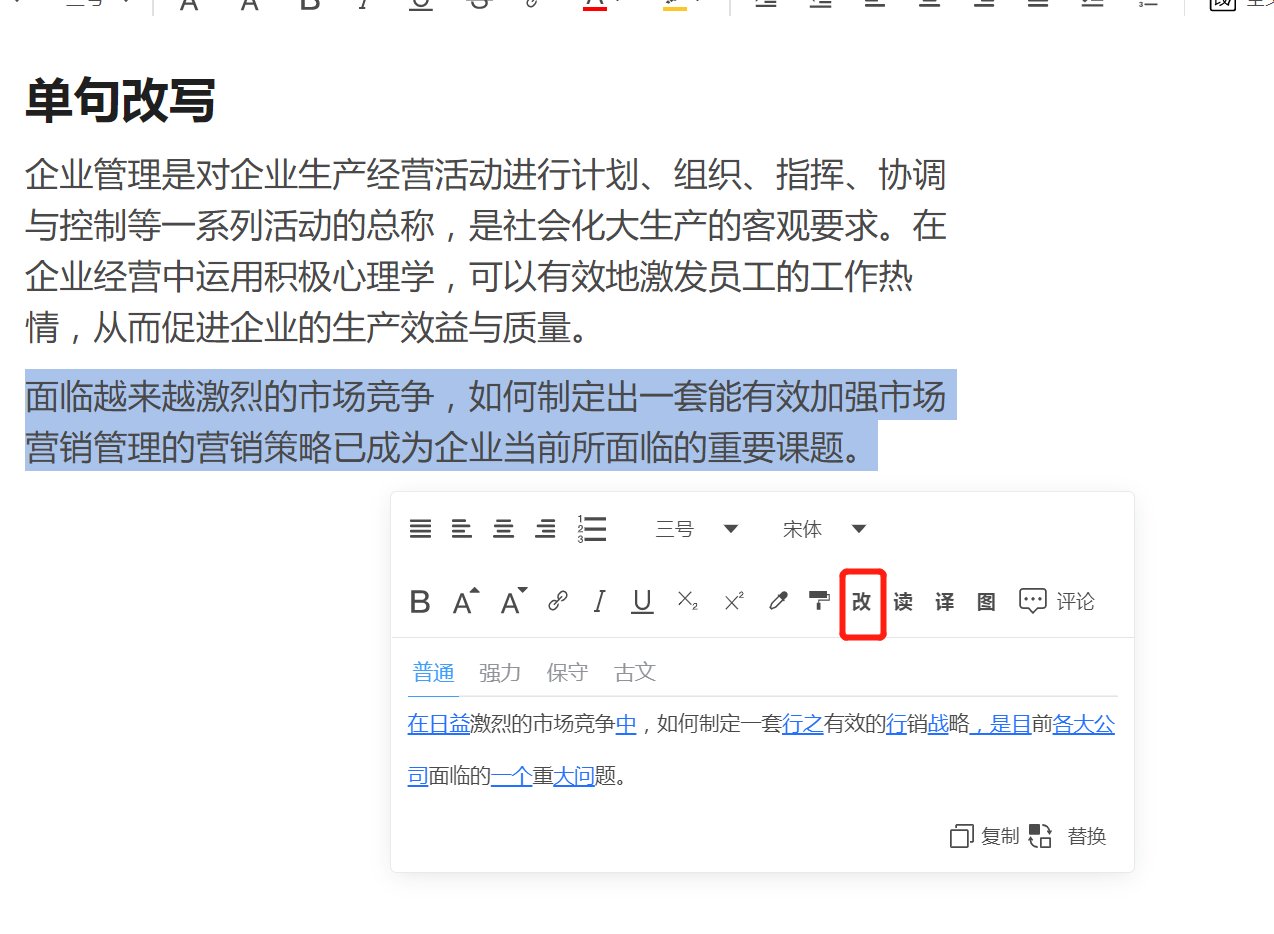

最致命的风险藏在原创性认定的灰色地带里。某 211 高校去年处理过一起案例:学生用写作猫生成了论文的理论框架部分,虽然自己补充了实证数据,但学校的查重系统把 AI 生成内容判定为 “疑似剽窃”—— 原因是写作猫的数据库里收录了大量已发表论文的结构模板,生成的文字和某篇十年前的论文框架高度相似。更麻烦的是,目前主流的学术不端检测系统(比如知网、Turnitin)对 AI 生成内容的识别率还不到 70%,这意味着你可能自己都不知道哪里踩了线。

过度依赖会导致 “学术肌肉萎缩”。有位导师发现,连续用写作猫写了三篇课程论文的学生,在毕业论文开题时居然说不出研究方法的具体操作步骤 —— 因为之前的方法论部分都是 AI 生成后稍作修改就提交的。学术写作的核心是论证逻辑的构建,而 AI 擅长的是语言组织而非深度思考。当你习惯了让 AI 替你衔接段落,久而久之会失去独立搭建逻辑链条的能力,这在答辩时很容易露馅 —— 老师随便追问一个论证细节,你可能就答不上来。

数据准确性是另一个大坑。写作猫生成的案例和数据有时会 “虚构来源”。比如有学生在论文里引用了写作猫提供的 “2023 年中国数字经济规模达 45 万亿”,结果被导师发现这个数据根本不存在 ——AI 是根据 2022 年的 39 万亿数据推算的,却标注了真实的统计机构名称。更隐蔽的是概念混淆,比如把 “用户留存率” 和 “复购率” 当作同义词使用,非专业审稿人可能看不出来,但内行一眼就能发现问题。

学术规范冲突越来越明显。现在至少有 38 所国内高校出台了 AI 写作管理规定,其中 12 所要求在论文致谢中明确标注 AI 工具的使用范围,7 所禁止在核心章节使用 AI 生成内容。但写作猫的 “无痕模式” 会自动删除使用记录,这就导致学生很容易抱着侥幸心理隐瞒使用情况。去年某学术期刊撤稿的 5 篇论文里,有 3 篇被证实是用 AI 生成后仅做少量修改,这些作者不仅面临论文撤稿,还可能影响后续的学术生涯。

📚 建立健康的 AI 使用模式:学术写作的 “辅助边界” 在哪里?

明确 AI 的 “三级辅助” 定位很关键。初级辅助是格式处理 —— 让写作猫统一调整字体、自动生成目录、核对参考文献格式(比如把 APA 格式转换成 GB/T 7714),这些机械性工作用 AI 效率最高,也不会涉及原创性问题。中级辅助是素材整理,比如用它提取访谈录音的关键词、归纳文献中的核心观点,但必须自己逐一核对原始资料。高级辅助才是内容生成,仅限用于初稿的思路启发,而且生成后必须逐句修改,替换成自己的表达方式。

“人工审核 + AI 辅助” 的双轨模式值得推广。有个师姐分享过她的做法:先用写作猫生成理论部分的初稿,然后把文本复制到 “原创性检测工具”(比如 Grammarly 的 AI 检测功能)里,标红的 AI 高风险句子全部重写。她还会把 AI 提到的每个观点都追溯到具体文献,确保论证有扎实的理论支撑。这种模式虽然比纯人工写作多花 20% 时间,但既能利用 AI 的效率优势,又能保证内容的可靠性。

保留完整的修改痕迹是自我保护的关键。现在很多高校要求提交论文的修改记录,如果你用写作猫生成初稿后,在 Word 里开启 “修订模式” 逐句修改,既能证明自己的创作过程,也方便导师追踪你的思路变化。更稳妥的是建立 “AI 使用日志”,记录每次用写作猫处理的内容、修改方式和最终版本,万一后期被质疑,这些记录就是最好的证据。

针对不同学科制定差异化策略。理工科论文里,实验步骤、数据计算部分绝对不能用 AI 生成,因为任何微小的误差都可能导致结论错误;但文献综述的结构梳理可以适当借助 AI。文科论文则相反,理论框架和论证逻辑必须自己搭建,但语言润色、案例归类等工作可以让 AI 帮忙。艺术类论文更特殊,创意性内容要完全原创,而文献引用格式的校对则适合交给 AI 处理。

📝 实操指南:学术写作中 AI 工具的正确打开方式

文献综述阶段,用写作猫的 “观点聚类” 功能时,一定要手动核对三个要素:每篇文献的发表时间是否最新(AI 有时会优先抓取高被引论文,可能错过近两年的新研究)、作者单位是否权威(避免引用低质量期刊的文章)、研究方法是否与你的选题匹配。有个简单的验证方法:把 AI 生成的观点摘要和原文摘要对比,发现表述差异超过 30% 的就得重新审视。

论文初稿写作时,建议用 “分段生成 + 即时修改” 法。比如写研究方法部分,先让 AI 生成问卷设计的基本框架,然后立刻停下来补充自己的具体调整 —— 样本量为什么定 200 人而不是 AI 建议的 500 人、问卷发放渠道有哪些特殊性。每段 AI 生成的内容不超过 200 字就手动介入,这样既能保持写作节奏,又能避免被 AI 的思路带偏。

数据处理环节,AI 可以帮你做初步分析,但必须自己验证。写作猫能生成 SPSS 的操作代码,但你得亲自运行一遍,检查是否有逻辑错误;它推荐的数据分析模型,要对照教材确认适用条件 —— 比如回归分析要求变量之间存在线性关系,这个前提 AI 不会帮你验证。有个统计学教授说,他每年都会遇到学生用错模型的情况,很多都是直接套用 AI 推荐的方法,根本没考虑数据是否符合前提假设。

语言润色要把握 “保留个人风格” 的原则。写作猫的润色功能会让文字变得更 “标准”,但也可能磨掉你的独特表达。修改时可以保留一些自己常用的连接词,在关键观点处用自己习惯的句式,甚至故意保留一两个不影响理解的 “小瑕疵”—— 过于完美的文字反而容易被怀疑是 AI 生成的。

🎯 未来趋势:学术 AI 工具的规范与进化

现在已经有高校在试点 “AI 写作白名单” 制度,只允许使用经过认证的学术辅助工具。这些工具和普通写作猫的区别在于:数据库仅包含公开的学术资源、生成内容会自动标注 AI 参与比例、定期向学校提交使用记录。这种模式既能满足学生的效率需求,又能让学校有效监管,可能会成为未来的主流方向。

学术期刊也在调整审稿机制。《中国社会科学》今年开始要求作者提交 “AI 使用声明”,详细说明哪些部分用了 AI 工具、用的是哪款产品、修改比例是多少。审稿人会重点检查 AI 参与度超过 30% 的章节,甚至会让作者现场解释相关内容。这种严格的审核机制,其实是在倒逼学生合理使用 AI,而不是走捷径。

AI 工具本身也在进化。最新版本的写作猫已经增加了 “学术规范提醒” 功能,生成内容时会自动标注 “此部分建议人工核对文献来源”“该表述可能不符合 XX 期刊要求”。未来可能会针对不同学科开发专属模型,比如针对医学论文的 AI 工具会自动规避伦理敏感内容,针对法学论文的则会重点检查法条引用的准确性。

对学生来说,适应这种变化最好的方式是把 AI 当作 “学术健身教练”—— 它可以帮你制定计划、纠正动作,但真正的肌肉增长还得靠自己练。与其纠结该不该用,不如花时间研究怎么用好,毕竟学术能力的核心永远是独立思考和严谨论证,AI 再智能也取代不了这些本质能力。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费