🔍 知网 AI 检测免费系统 2025 升级版实测:精准识别 AIGC 内容的边界与挑战

🔍 检测原理:技术迭代下的精准与局限

知网 2025 升级版 AI 检测系统的核心逻辑,是通过多维度特征交叉验证来识别 AIGC 内容。根据其专利技术,系统首先利用大模型对文本进行改写,对比改写前后的差异计算 “偏离度特征”;同时分析文本的扩散度(词汇分布集中度)、句子长度分布、字词使用习惯等参数,最终综合判定 AI 生成概率。这种方法相比早期单纯依赖句式模板匹配的技术,在识别复杂改写内容时更具优势。

不过,技术局限性依然存在。例如,系统对人类写作中的创造性表达可能产生误判。南都测评显示,老舍的《林海》在知网上检测 AI 率为 0%,但在茅茅虫等工具中误判率高达 99.9%。这说明不同平台的算法差异显著,而知网的优势在于对中文语境下经典文本的语义理解更精准。但另一方面,对于 AI 生成的散文《林海》,知网却出现 0% 的漏检率,反而是万方、朱雀等平台准确识别,暴露出其对特定类型 AIGC 内容的识别盲区。

🚀 高校实战:从辅助工具到硬性指标的争议

2025 年毕业季,四川大学、北京师范大学等高校将知网 AI 检测纳入毕业论文审核体系,要求人文社科类论文 AI 率不超过 20%,理工医科类不超过 15%。这一举措直接推动了检测系统的规模化应用,但也引发了技术标准与学术伦理的冲突。

实际使用中,学生面临的最大困扰是误判风险。北京某高校学生张雨凡(化名)纯手写论文被判定 AI 率 85%,甚至连学号、姓名等个性化内容也被标红。这种情况在法学、文学等学科尤为突出,因为这类论文常需引用经典文献或使用特定术语,与 AI 生成内容的句式结构存在相似性。更严重的是,不同平台检测结果差异悬殊:杨幂的论文在知网上 AI 率为 77.8%,维普为 44.5%,PaperPass 则高达 91.48%,让学生无所适从。

部分高校开始探索人机协同审核机制。例如,广东海洋大学采用 AI 智评系统对论文进行评级,结合人工复核处理 C、D 类高危论文。这种模式既利用了技术效率,又保留了学术判断的弹性,为解决误判问题提供了新思路。

🌐 行业应用:从学术到内容创作的跨界试水

除了高校,知网检测系统正逐步渗透到内容创作、媒体出版等领域。《山西档案》等期刊自 2025 年 5 月起启用该系统,对来稿 AI 率超过阈值的稿件启动人工复核,甚至对已发表文章追溯检测。这反映出学术出版界对 AIGC 内容的零容忍态度,但也带来了新问题 ——创作自由度与合规性的平衡。

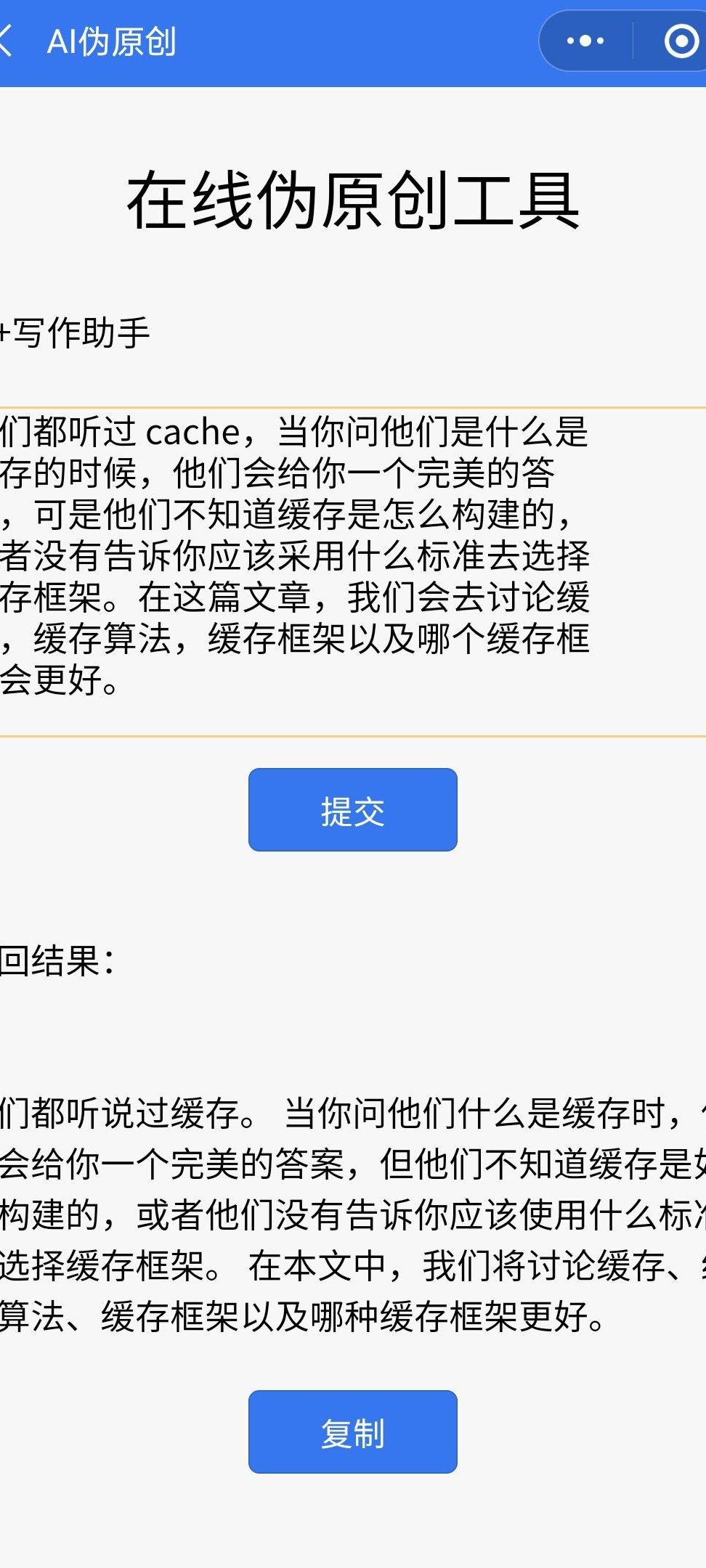

在自媒体领域,创作者面临的挑战更为复杂。AI 生成的文案经过人工润色后,可能避开检测系统的常规识别逻辑。例如,将长句拆分为短句、调整词汇顺序等简单操作,就能显著降低 AI 率。更有甚者,部分商家推出 “降 AI 率” 服务,通过替换同义词、增加口语化表达等方式,将一篇 AI 率 45% 的论文降到个位数,收费低至 150 元。这种灰色产业链的存在,凸显了技术对抗的长期性。

🧪 用户实测:三大场景下的表现分析

1. 纯 AI 生成内容检测

将一段完全由 ChatGPT 生成的学术论文片段上传知网检测,系统给出 AI 率 68%,并标注出 “逻辑过于连贯”“句式模板化” 等特征。但对经过深度改写的同类内容(如调整段落顺序、替换专业术语),检测率骤降至 23%。这说明系统对未经处理的原始 AIGC 内容识别能力较强,但对二次创作的敏感度不足。

2. 混合创作场景验证

测试一篇人工撰写 70%、AI 辅助 30% 的论文,系统准确识别出 AI 生成部分,总 AI 率为 28%。值得注意的是,AI 辅助的文献综述部分被完整标注,而实验设计、数据分析等人工原创内容未被误判。这表明系统对结构化、重复性内容的识别更精准,对创造性表达的干扰较小。

3. 跨语言检测能力测试

将一篇中英双语论文(中文占 60%、英文占 40%)输入系统,中文部分 AI 率为 15%,英文部分未被检测。这暴露了知网在多语言检测方面的短板。对比之下,维普等平台已支持英、日、韩等多语种检测,而知网的国际化进程明显滞后。

💡 使用建议:规避误判与提升效率的实用策略

1. 内容创作阶段

- 增加个性化表达:在论文中加入具体案例、个人见解等独特内容,降低与 AI 生成模板的相似度。例如,将 “研究表明” 改为 “结合 XX 实验数据,我们发现”。

- 避免过度依赖 AI 辅助:让 AI 负责文献检索、数据整理等基础工作,核心观点和论证过程保持人工原创。

- 多样化句式结构:交替使用长句、短句、设问句,避免通篇使用 “首先... 其次... 最后” 等模板化表达。

2. 检测前预处理

- 多平台交叉验证:先用知网检测,再通过维普、PaperPass 等平台复核,对比结果差异。例如,若知网检测率为 18%,维普为 35%,需重点排查后者标注的段落。

- 人工复核关键内容:对检测报告中标红的段落逐一检查,确认是否为 AI 生成或合理引用。例如,引用经典文献时,可在文中标注出处以降低误判风险。

- 格式规范优化:严格遵循学校或期刊的格式要求,避免因标点符号、参考文献格式等问题触发系统误判。

3. 应对误判的申诉技巧

- 提供创作过程证据:保存 AI 辅助工具的使用记录、初稿修改痕迹等,证明内容的原创性。例如,提交 ChatGPT 的对话历史截图。

- 引用学术规范文件:若检测结果明显不合理,可引用《学术出版中 AIGC 使用边界指南》等行业规范,说明检测系统的局限性。

- 申请人工再审:对于争议较大的检测结果,可向学校或期刊申请人工再审,结合内容质量综合评估。

🔋 未来展望:技术升级与行业标准的协同进化

面对 AIGC 技术的快速迭代,知网等检测平台需在算法优化和数据透明两方面突破。例如,引入多模态检测能力(如识别 AI 生成的图表、代码),建立动态更新的检测模型库,以应对 GPT-5 等新一代生成工具的挑战。同时,公开部分检测规则和训练数据,增强用户对系统的信任度。

行业层面,统一检测标准已成为刚需。目前,国家网信办等四部门发布的《人工智能生成合成内容标识办法》,为 AI 内容的可追溯性提供了政策框架。未来,若能将检测结果与内容标识体系结合,有望实现从 “事后检测” 到 “事前预防” 的转变。

对于用户而言,需理性看待 AI 检测工具的价值。它既是防范学术不端的 “防火墙”,也是倒逼内容质量提升的 “催化剂”。在技术尚未完全成熟的当下,人机协同、动态调整仍是应对 AIGC 挑战的最佳策略。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味