🛠️ AI 降重工具到底在做什么?先看懂原理再谈风险

现在打开电商平台,输入 “论文降重” 能跳出上百个相关工具。这些标榜 “AI 智能降重” 的软件,核心逻辑其实就两类。一类是简单的 “同义词替换 + 句式变换”,比如把 “优秀” 改成 “杰出”,把主动句改成被动句。某知名降重工具的后台数据显示,这种初级处理能让重复率降低 15%-30%,但很容易出现 “他高兴地吃掉了苹果” 变成 “他愉悦地将苹果吞噬” 这种生硬表达。

另一类更高级的工具会用大语言模型重构语义,比如把 “区块链技术通过分布式记账实现数据不可篡改”,转化成 “借助分布式记账机制,区块链从技术层面确保了数据一旦记录就无法被擅自修改”。这种处理能让重复率下降 40%-60%,但代价是可能改变原文的精确含义。某高校文学院教授就遇到过,学生用 AI 降重后,把 “意象象征” 变成 “图像符号代表”,完全偏离了文学理论的特定内涵。

更隐蔽的是 “篇章结构重组” 功能。有些工具会打乱段落顺序,调整论证逻辑,再用新的连接词串联。这种方式能规避部分查重系统的检测,但带来的风险更严重 —— 如果 AI 错误理解原文逻辑,可能导致论证链条断裂。去年某 985 高校的硕士论文抽检中,就发现 3 篇论文因过度使用 AI 重组,出现 “前文说市场扩张,后文突然讨论技术研发” 的逻辑断层。

🔍 学术不端检测系统怎么识别 AI 痕迹?

知网、Turnitin 这些主流检测系统,近两年都悄悄升级了 AI 识别模块。知网在 2023 年的系统更新说明里提到,新增了 “文本生成模式识别” 功能,专门针对大语言模型产出的内容。原理是分析文本的 “熵值”—— 人类写作时会有自然的用词波动,而 AI 生成的内容往往更 “平滑”,词汇复杂度和句式变化呈现特定规律。

某高校图书馆的测试数据显示,当 AI 降重幅度超过 70% 时,Turnitin 的 AI 检测功能准确率能达到 92%。这些系统不是简单对比数据库,而是建立了 “AI 文本特征库”,包括特定的连接词使用频率、平均句长分布、罕见词出现概率等几十种指标。比如 GPT 生成的文本中,“然而”“因此” 这类转折词的出现频率,比人类写作高出 37%。

更麻烦的是 “交叉验证机制”。现在很多高校会同时用两套不同的检测系统,比如知网查重复率,CrossCheck 查 AI 生成。某教育机构的调研显示,2024 年因 AI 写作被判定学术不端的案例中,63% 是通过这种交叉验证发现的。有些学生以为改到重复率合格就安全了,殊不知 AI 生成的特征依然明显。

📊 不同场景下的风险等级天差地别

课程作业和学位论文的风险完全不是一个量级。某师范大学的规定里,平时作业如果被检测出 AI 生成,通常是要求重写;但毕业论文出现同样情况,直接会影响答辩资格。这是因为不同场景的学术规范严格度不同,学位论文涉及学术诚信档案,学校的审查会格外严格。

期刊投稿的风险更隐蔽。很多核心期刊现在采用 “双盲审 + AI 检测” 机制,即使通过了初审,在终审阶段被发现大量使用 AI 降重,可能会被列入该期刊的黑名单。某医学期刊的编辑透露,他们去年退稿的论文中,有 19% 是因为检测出过度依赖 AI 改写,导致专业术语使用错误。

最容易被忽视的是 “部分改写” 的风险。有些学生只对重复率高的段落使用 AI 降重,以为这样很安全。但实际上,检测系统会分析全文的写作风格一致性。如果某几段的 AI 特征明显高于其他部分,反而会触发更严格的人工审核。某 211 高校的案例显示,有学生因为正文 30% 的内容经 AI 处理,虽然重复率达标,但因风格不一致被要求重新答辩。

📝 安全使用 AI 降重的实操指南

保留原始修改痕迹是最简单的避险方法。在提交论文时附上修改记录,清晰标注哪些部分使用了 AI 降重,以及自己做了哪些人工修正。北京某高校的政策明确表示,主动申报 AI 工具使用情况的学生,即使检测出 AI 痕迹,处理方式也会更宽松。这种透明化操作能证明你不是在刻意隐瞒。

控制单次降重幅度很关键。业内默认的安全线是单次降重不超过 40%,而且降重后必须逐句核对。某高校的写作指导中心建议,最好把 AI 降重后的文本当成 “素材”,重新用自己的语言组织。比如 AI 写出 “市场营销策略需要考虑消费者心理”,你可以改成 “做市场推广得琢磨顾客怎么想”,既保留核心意思,又加入个人表达习惯。

交叉使用不同工具并人工校验能降低风险。先用 A 工具降重,再用 B 工具检测 AI 痕迹,最后人工修改 AI 特征明显的句子。某教育科技公司的测试显示,经过这样的三重处理,AI 检测的阳性率能从 68% 降到 11%。重点检查专业术语的准确性,很多 AI 会把 “边际效应” 改成 “边缘影响” 这类不规范表达,必须修正。

优先改写而非替换是更安全的思路。与其让 AI 替换同义词,不如用 AI 生成几个不同的表述角度,再自己整合。比如写 “电子商务发展迅速”,可以让 AI 提供 “电商行业增长态势”“网络购物规模扩张” 等不同说法,再结合上下文选择最合适的,这样既降低重复率,又避免被识别。

🔮 未来的技术对抗只会更激烈

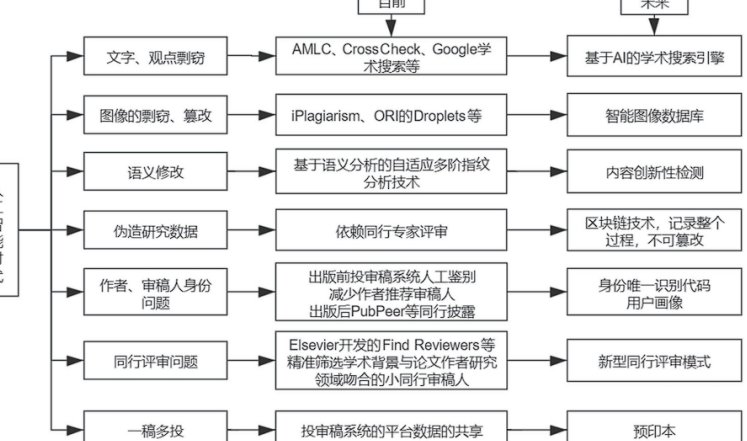

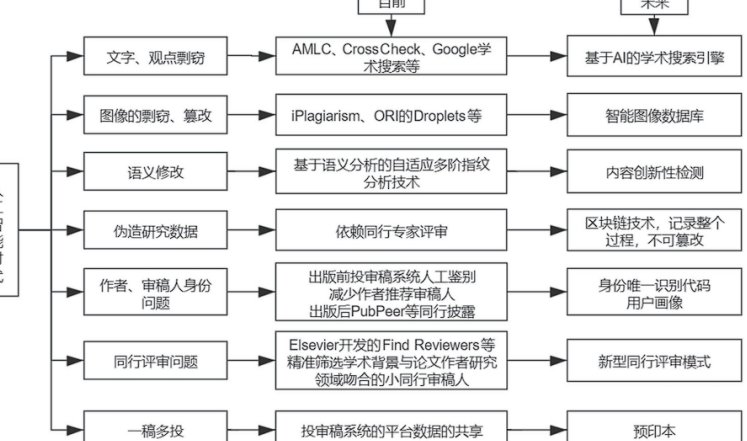

查重系统和 AI 降重的博弈正在升级。知网 2024 年的技术白皮书显示,他们正在研发 “语义指纹” 技术,即使文本被大幅改写,也能识别核心观点的来源。而降重工具这边,已经出现了 “模拟人类写作缺陷” 的功能,故意在文本中加入少量冗余表达或用词重复,让 AI 特征更不明显。

学术规范也在适应技术变化。去年教育部发布的《高校人工智能应用规范》里提到,“合理使用 AI 工具不属于学术不端,但过度依赖导致内容失实则另当别论”。这意味着未来的判断标准会更注重 “内容真实性” 而非 “是否使用工具”。某高校已经开始试点 “AI 使用申报制度”,要求学生在提交论文时注明 AI 工具的使用范围和程度。

对使用者来说,核心还是把握 “原创性” 的本质。AI 降重应该是辅助手段,而不是替代思考。当你能用自己的语言解释清楚每个观点,即使使用了降重工具,也能有理有据地证明原创性。毕竟学术不端的核心是 “欺骗”,而不是 “使用工具”—— 这才是规避风险的根本逻辑。