🔍 规则匹配时代(2000 年代初):从字符串比对到简单替换

2000 年代初期的 AI 降重技术,说好听点是 "起步阶段",说实在的更像个 "文字搬运工的监控器"。那时候的核心逻辑特别简单 —— 把两段文字拆成一个个词语,然后逐个比对。就像老师检查作业时,拿着红笔逐字逐句找错别字一样。

最早的商用系统比如 iThenticate(那时候还叫 Turnitin),原理就是建立一个巨大的论文库,然后把用户上传的文档拆成字符串,和库里的内容做精确匹配。一旦发现连续 5 个以上字符相同,就标红提示重复。这种方式对付直接复制粘贴确实有用,但稍微聪明点的学生改几个词,比如把 "优秀" 换成 "优良",系统就傻眼了。

那时候的降重工具也很初级。网上能找到的小软件,功能无非是替换同义词、调整句式。比如把 "我吃了饭" 改成 "饭被我吃了",或者把 "重要" 换成 "关键"。这种机械替换的问题很明显 —— 改完的句子常常不通顺,甚至闹出笑话。有用户试过用早期工具处理论文,结果出现 "太阳从西边升起,因为月亮在晚上睡觉" 这种逻辑混乱的句子。

当时行业里有个共识:这种规则匹配技术只能解决 "显性重复"。对于意思相同但表达方式不同的 "隐性重复",比如把 "张三打了李四" 改成 "李四被张三攻击",系统根本识别不出来。这也难怪,那时候的计算机连基本的语义理解都做不到,更别说判断两句话是不是一个意思了。

📊 统计机器学习阶段(2010 年代初):n-gram 模型的崛起与局限

2010 年代初,统计机器学习开始在降重领域崭露头角。这个阶段的技术核心是 n-gram 模型 —— 简单说就是把文字切成连续的 n 个词的组合,然后计算不同文本中这些组合的重复概率。比如 "人工智能" 是 2-gram,"机器学习技术" 是 3-gram。

最具代表性的是谷歌在 2011 年推出的基于 n-gram 的文本相似度检测工具。它能统计出 "在学术论文中,' 神经网络 ' 后面跟着 ' 算法 ' 的概率是 37%" 这种规律,然后用这些概率来判断文本是否存在改写式重复。这比单纯的字符串比对进步多了,至少能识别出 "换汤不换药" 的改写。

那时候的降重工具开始讲究 "平滑替换"。比如处理 "他跑得很快",系统会先分析 "跑" 和 "快" 的搭配频率,然后推荐 "他快步流星" 而不是机械地换成 "他移动得迅速"。这种基于统计的方法确实让改写后的句子通顺了不少,但依然跳不出 "只见树木不见森林" 的局限 —— 它能处理短语,却理解不了整个句子的意思。

2013 年有个很有名的案例:某高校用基于 n-gram 的系统检测一篇关于 "蜜蜂授粉" 的论文,把 "蜜蜂通过舞蹈传递信息" 和 "蜂群依靠肢体语言交流" 判定为不重复。这显然不合理,但系统没办法 —— 它算不出这两句话描述的是同一个生物学现象。这也暴露了统计方法的致命伤:没有真正的语义理解能力。

🧠 词向量革命(2013-2018):机器终于 "懂" 了词语意思

2013 年是个转折点。谷歌团队提出的 Word2Vec 模型,第一次让计算机能把词语转换成有意义的数字向量。简单说就是,意思相近的词在向量空间里的位置也相近。比如 "国王" 减去 "男人" 加上 "女人",结果居然和 "女王" 的向量很接近。

这个突破对降重技术来说太重要了。以前的系统看 "电脑" 和 "计算机" 是两个完全不同的词,现在通过向量计算,能直接得出它们的相似度高达 92%。基于这个原理,2015 年之后出现的降重工具,比如 CopyScape 的升级版,终于能识别同义词替换这种低级把戏了。

那时候业内出现了一种新的降重思路:先把原文转换成词向量,然后在向量空间里找 "近义表达"。比如要改写 "人工智能发展迅速",系统会先定位 "人工智能" 和 "发展迅速" 在向量空间的位置,然后找到 "机器学习进步飞快" 这样的表达 —— 意思相近但用词完全不同。

不过词向量也有短板。它处理不了一词多义的情况。比如 "苹果" 这个词,在 "我吃苹果" 和 "我用苹果手机" 里意思完全不同,但 Word2Vec 给出的向量是一样的。这就导致有些降重结果出现歧义,比如把 "他喜欢喝茅台" 改成 "他热爱饮五粮液" 没问题,但把 "他用苹果工作" 改成 "他拿华为劳动" 就很奇怪。

2017 年,百度推出的 ERNIE 模型尝试解决这个问题,通过加入上下文信息来调整词向量。比如 "苹果" 在 "吃" 后面时向量偏向水果,在 "用" 后面时偏向电子产品。这种改进让降重的准确性提升了不少,但离真正理解语义还有距离。

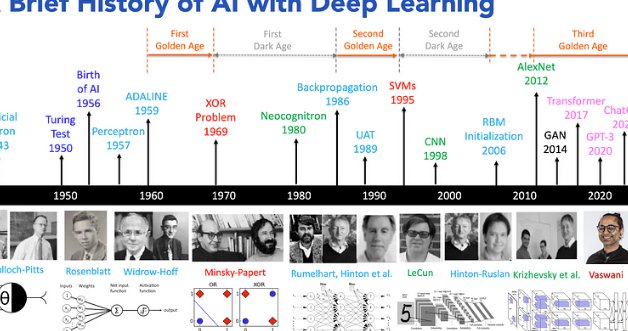

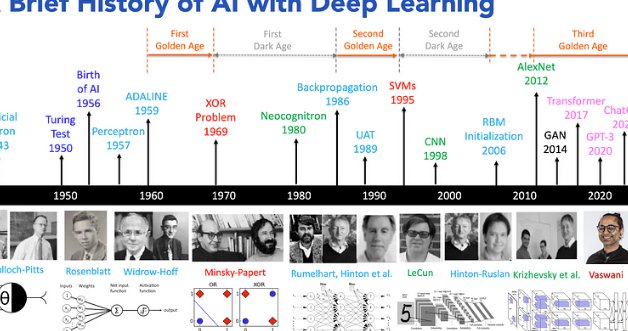

🤖 深度学习爆发(2018 至今):Transformer 架构改写游戏规则

2018 年是 AI 降重技术的 "成年礼"。谷歌提出的 BERT 模型采用了 Transformer 架构,第一次实现了对上下文的深度理解。简单说,以前的系统是 "瞎子摸象",摸到耳朵说像扇子,摸到腿说像柱子;现在的系统能 "看到" 整个大象了。

BERT 的厉害之处在于 "双向注意力机制"。它读一句话时,会同时关注前后所有词语的关系。比如 "他用银行的卡去银行取钱",系统能分清第一个 "银行" 是形容词,第二个是名词。这种理解能力让降重技术发生了质的飞跃。

最直观的变化是降重后的句子质量。以前改完的文字常常磕磕绊绊,现在用 GPT-2、BART 这些模型做降重,生成的句子几乎和人写的一样自然。2020 年之后出现的专业降重工具,比如 QuillBot,甚至能根据用户需求调整改写后的风格 —— 想要学术化还是口语化,一键切换。

这个阶段的检测技术也同步升级。知网的学术不端检测系统(AMLCLC)在 2021 年引入了 BERT 的改进版,不仅能识别同义词替换,连句式变换、段落重组都能检测出来。有高校老师反馈,以前能蒙混过关的 "伪原创" 论文,现在通过率下降了 60% 以上。

但深度学习也带来了新问题。有些降重工具用 GPT 类模型生成的内容,虽然和原文 wording 完全不同,但核心观点和逻辑结构一模一样。这种 "高级抄袭" 更难识别,也引发了学术界的争议 —— 到底什么程度的改写才算原创?

🚀 未来趋势:从 "降重" 到 "原创增强"

现在的 AI 降重技术已经不是简单的 "改文字" 了。最新的研究方向是 "原创增强"—— 不仅要避免重复,还要提升内容质量。比如 2023 年发布的 Claude 模型,在处理学术论文时,会主动建议补充实验数据、调整论证结构,而不只是替换词语。

行业里有个明显的分化:面向普通用户的工具越来越傻瓜化。比如某款 APP,用户上传文档后,系统会自动分析重复来源,然后给出 "轻度改写"" 中度改写 ""深度重构" 三个选项,小白也能轻松操作。而面向专业领域的工具则越来越细分,比如专门处理法律文书的降重系统,会严格遵守法律术语规范,不会随意替换专业词汇。

技术上,多模态降重开始萌芽。比如处理包含图表的论文时,系统不仅会改写文字说明,还能自动调整图表的呈现方式 —— 把柱状图改成折线图,同时保证数据信息不变。这在以前是完全不可想象的。

但有个问题一直没解决:过度降重可能导致内容失真。某高校曾做过测试,用顶级工具对一篇物理学论文进行深度降重,结果虽然重复率从 35% 降到了 5%,但有 3 处关键公式的表述出现了细微错误。这提醒我们,无论技术多先进,最终还是需要人来把控内容质量。

回头看这二十多年的发展,AI 降重技术其实反映了整个自然语言处理领域的进步轨迹 —— 从 "看字" 到 "懂词",再到 "理解句子",现在正在向 "把握篇章" 迈进。未来它会变成什么样?不好说,但可以肯定的是,它会越来越懂人类的语言,也越来越懂我们对 "原创" 的真正需求。