知网 AIGC 检测的底层逻辑:不止于 “文字比对” 🕵️♂️

知网的 AIGC 检测系统这两年迭代速度快得吓人。它早就不是简单比对文字重复率的老古董了,现在玩的是语义指纹识别。简单说,就是把文字拆成无数个语义单元,像拼图一样记录特征。哪怕你把 “人工智能” 换成 “机器智能”,系统也能通过上下文关联判断出这俩说的是一回事。

更狠的是它的跨库比对能力。不只是比对已收录的学术文献,连网络公开的博客、论坛帖子、甚至公众号文章都纳入了数据库。有高校的朋友告诉我,他们实验室做过测试,把十年前的冷门论文片段改写成现代汉语风格,照样能被揪出来 —— 因为系统能识别逻辑框架的相似性。

还有个容易被忽略的点:生成式特征捕捉。AI 写的文字和人写的有明显差异,比如句式的规律性、关联词的使用频率、观点推进的节奏。知网现在专门训练了模型识别这些 “AI 痕迹”,哪怕你把 AI 生成的内容改得面目全非,只要核心逻辑是机器的,就可能被标红。

第一批失效的伪原创手段:这些套路已被精准识别 🚫

同义词替换现在就是个笑话。前两年有人靠 “百度翻译 + 同义词典” 混过关,现在根本行不通。知网的词向量模型能识别近义词在特定语境下的等效性。比如把 “影响” 换成 “作用”“效果”,系统会通过前后文判断这些词在语义链中扮演的角色完全一致,照样算重复。

句式变换的漏洞也被堵死了。以前把主动句改成被动句,长句拆短句,就能蒙混过关。现在系统会分析句子的 “主谓宾核心框架”,不管你怎么调整语序,只要动作主体、动作对象、动作本身没变,就逃不过检测。某高校文学院的学生试过把一段文字拆成诗歌格式,结果重复率反而更高 —— 因为核心语义单元被孤立后更容易被锁定。

段落重组的失效更彻底。有些人为了躲检测,把几篇文章的段落打乱重排,再加点过渡句。但知网的逻辑流分析会追踪观点的发展脉络,比如 “提出问题 - 分析原因 - 给出对策” 这种经典结构,哪怕段落顺序颠倒,系统也能通过逻辑节点的关联性识别出拼凑痕迹。

翻译改写这条路也走不通了。先翻成英文再翻回中文,或者用小语种中转一下,曾经是伪原创的 “杀手锏”。现在知网接入了多语种语义库,能直接比对不同语言版本的核心语义。有个医学研究生告诉我,他把一篇德文文献翻译成中文,结果被检测出与另一篇中文综述 “高度语义相似”—— 因为两篇文章的实验数据和结论完全一致。

灰色地带正在收窄:看似可行的 “擦边球” 实则风险极高 ⚠️

低频次词汇替换还能撑多久?有人发现用生僻词替换常用词能降低重复率,比如把 “研究” 换成 “探究”“研讨”,把 “结果” 换成 “结论”“成效”。但这种方法的风险越来越大。知网的动态词库每周都在更新,一些被高频使用的替换词已经被标记为 “可疑词汇”。某期刊编辑透露,他们发现某篇论文里 “剖析” 这个词出现了 17 次,明显超出正常使用频率,最终认定为刻意规避检测。

领域术语伪装算不算漏洞?在非专业领域的论文里夹杂大量专业术语,比如在教育学论文里插入量子物理术语,试图干扰语义分析。这种方法短期内可能有效,因为系统对跨领域术语的关联识别还不够完善。但最近有案例显示,某篇艺术学论文因滥用计算机领域术语,被系统判定为 “语义混乱”,反而触发了人工审核,最终被认定为学术不端。

跨语言混合改写的空间在缩小。有人尝试在中文句子里夹杂英文短语或日文假名,比如 “这项研究的 key finding 是……”。这种混合文本以前能迷惑基础检测算法,但现在知网的多模态语义分析能剥离语言外壳,直接提取核心信息。某留学生的论文里用了大量中英混杂的句子,结果重复率比纯中文版本还高 —— 系统把这些句子拆解后,分别比对了中英文数据库。

用户实测反馈:那些被误判与漏检的真实案例 📝

某 985 高校的博士生分享了他的经历:自己原创的论文被检测出与一篇十年前的会议论文 “部分语义相似”。仔细比对后发现,两篇文章都用了 “问卷调查 + SPSS 分析” 的研究方法,虽然研究对象和结论完全不同,但系统还是标红了方法论部分。这说明研究方法的雷同性可能触发误判,尤其是一些经典研究范式更容易被盯上。

有自媒体作者透露,他们团队用 AI 生成的营销文案,故意加入大量口语化表达和网络热词,比如 “家人们”“绝绝子”,结果还是被知网旗下的自媒体检测工具识别为 AIGC 内容。后来分析发现,这些热词的分布规律和人类写作有明显差异 ——AI 会在段落开头集中使用热词,而人类更倾向于自然穿插。

相反,也有漏检的案例。某高校教师发现,把多篇外文文献的观点用自己的话重新转述,同时保留原作者的核心论点,这种 “深度改写” 目前漏检率较高。但他强调这只是暂时的,去年他有篇论文就是这么写的,今年再检测时重复率从 5% 飙升到 28%—— 系统的数据库和算法都在升级,以前没被收录的外文文献现在可能已经入库了。

破局之道:合规写作如何规避检测雷区 ✅

真正的原创从来不怕检测。与其钻研伪原创技巧,不如建立自己的 “观点数据库”。每次阅读文献时,用自己的语言记录核心观点,并标注与自己研究的关联性。比如读一篇关于人工智能的论文,不要只记结论,要写下 “这个观点可以支撑我的 XX 论点,但忽略了 XX 因素”—— 这种带有个人思考的记录,在写作时能自然融入自己的逻辑体系,从根本上避免重复。

引用格式的规范性比你想的更重要。很多人不知道,知网会专门识别引用标记是否规范。正确使用 “[1]”“参见 XX(2023)” 等引用格式,系统会自动剔除这些部分的重复率计算。但如果引用格式混乱,比如有的加标注有的不加,系统会把整段文字纳入比对范围。某期刊的查重报告显示,规范引用能让重复率降低 8-15 个百分点。

分段写作时保持 “语义唯一性”。每段只表达一个核心观点,并且用独特的论据支撑。比如写 “气候变化对农业的影响”,一段聚焦 “降水变化”,用某省的具体数据;下一段讲 “温度升高”,引用国际研究报告。这种结构清晰、论据独特的写作方式,即使观点与他人重合,也会被判定为独立思考的结果。

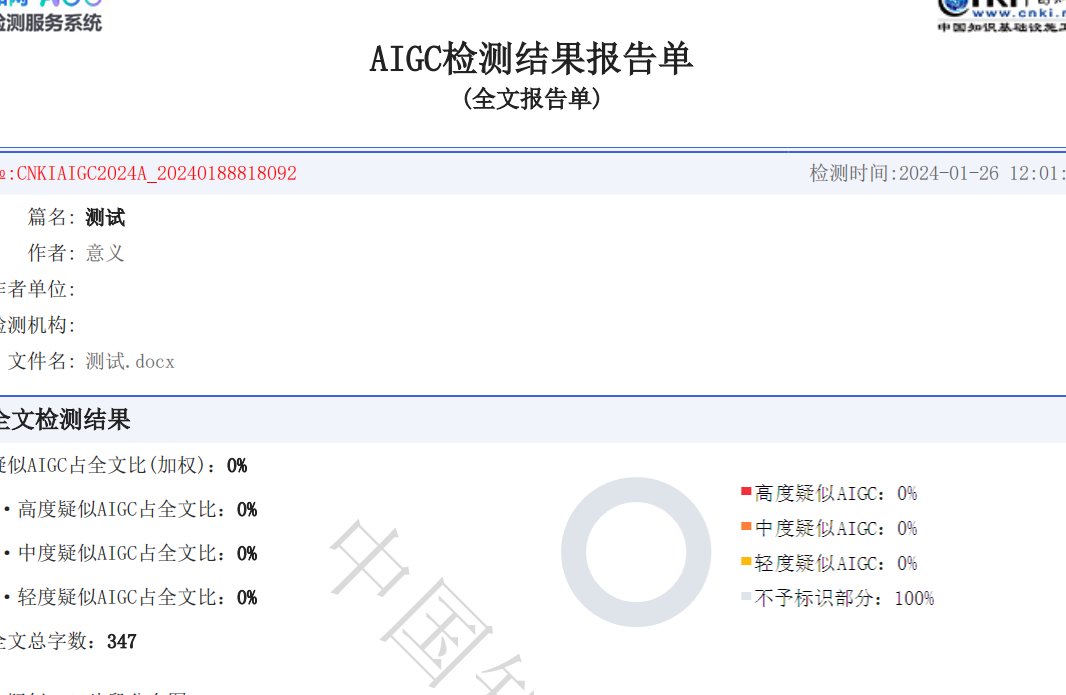

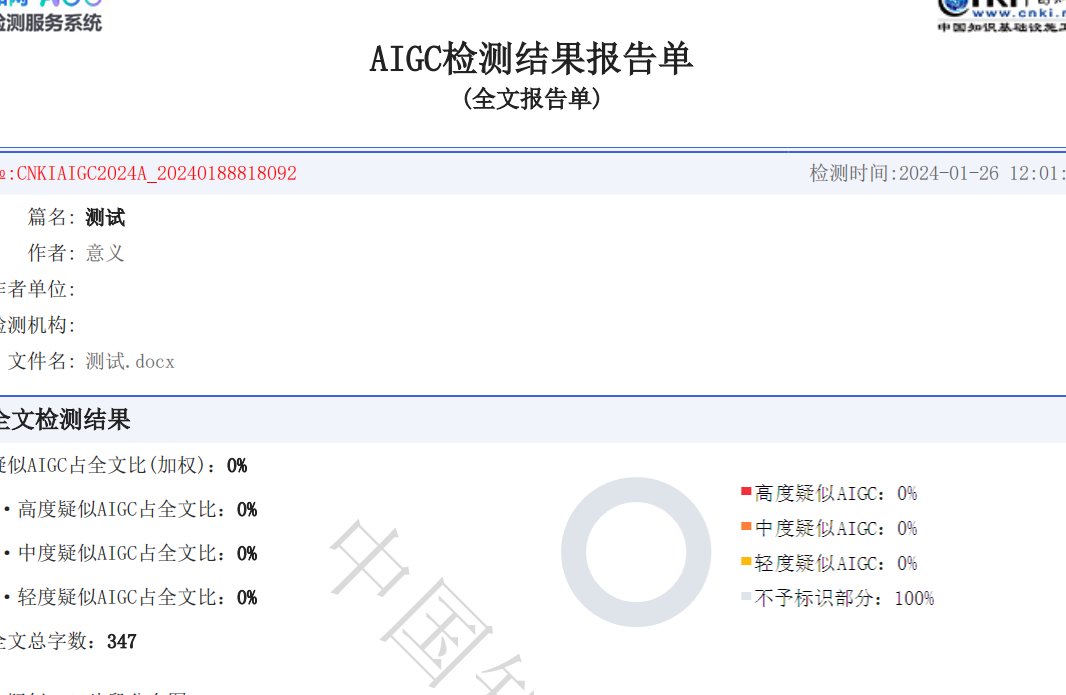

定期自查很关键。现在有很多第三方检测工具能模拟知网的检测逻辑,虽然准确率不如官方系统,但能帮你发现明显的伪原创痕迹。建议完成初稿后,先用第三方工具检测,重点查看标红部分的语义关联,而不是只看重复率数字。如果某段话被标红,试着用完全不同的角度重新表达,比如把 “原因分析” 改成 “现象描述”,再对比检测结果。