📊 知网 AIGC 检测报告里的 “疑似度”,到底指什么?

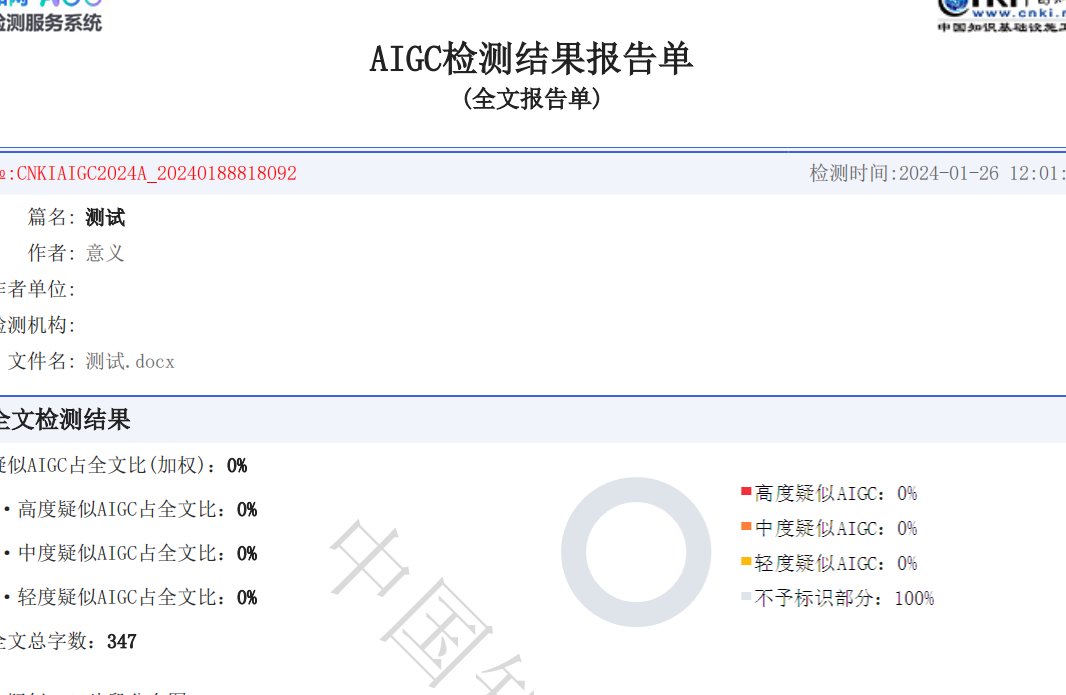

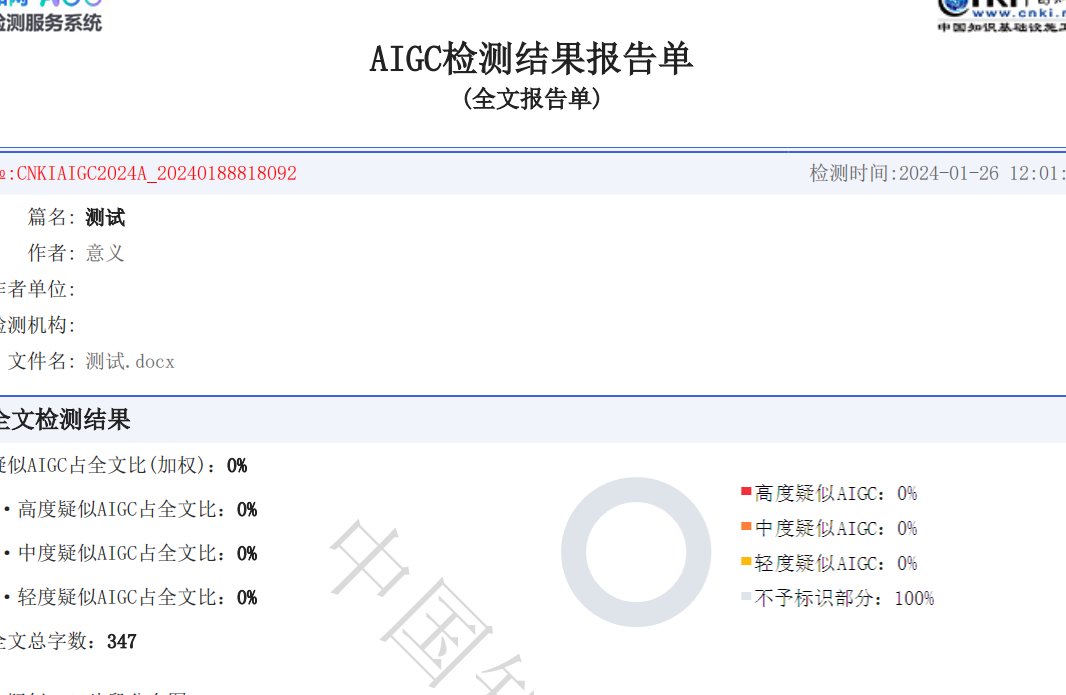

咱们先搞清楚这个核心概念。知网的 AIGC 检测系统,本质是通过比对文本特征与已知 AI 生成内容的共性,来判断某段文字 “可能由人工智能创作” 的概率。这里的 “疑似度”,就是这个概率的量化体现。

具体来说,它会用百分比显示,比如 “疑似度 60%”,意思是系统认为这段内容有 60% 的可能性是 AI 写的。这个数值越高,说明文本的 AI 生成特征越明显。但要注意,这不是绝对结论,只是系统基于算法模型的推测。

不同场景下,这个数值的意义不太一样。对学生来说,毕业论文里如果某部分疑似度过高,可能会被导师要求修改;对期刊投稿而言,超过一定阈值(通常是 30%-50%,不同期刊标准不同)的内容,大概率会被拒稿。

你可能会问,系统是怎么判断的?其实主要看文本的 “人工特征” 是否充足。比如人类写作时常见的口语化表达、个性化案例、逻辑跳跃甚至偶尔的笔误,这些在 AI 生成内容里比较少见。AI 写的东西往往结构过于规整,用词偏书面化,还容易出现 “模板化句式”,这些都会推高疑似度。

🔍 哪些因素会让 “疑似度” 飙升?

想降低疑似度,得先知道哪些坑容易踩。首当其冲的是句式的单一性。AI 生成内容很容易陷入 “主谓宾” 的固定结构,比如反复出现 “随着... 的发展,我们应该...”“综上所述,... 的重要性不言而喻” 这类句式,系统一抓一个准。

然后是词汇的重复率。AI 对高频词的依赖比人类高得多。比如写学术论文时,AI 可能反复用 “研究表明”“数据显示”“综上所述”,而人类写作时会不自觉换用 “根据调研结果”“从数据来看”“总的来说” 等不同表达,这种差异会被系统捕捉到。

还有逻辑的 “过度严谨”。人类写东西时,偶尔会有思路跳转,比如在论述 A 观点时,突然插入一个相关的小案例再拉回主线。但 AI 生成的内容,逻辑链往往过于顺畅,甚至有点 “刻板”,这种 “完美感” 反而会提高疑似度。

引用内容的处理也很关键。如果大段直接搬运 AI 生成的文献综述,或者用 AI 改写已有研究成果,系统会通过比对数据库,发现这些内容与已知 AI 产出的重合特征,直接导致疑似度上升。

最容易被忽略的是情感表达的缺失。人类写作时,哪怕是学术论文,也会在字里行间带点隐性的个人倾向,比如 “该方法在实际应用中可能存在一定局限” 比 “该方法存在局限” 更像人类表达。AI 写的内容往往过于中立,缺乏这种细微的情感倾向,也会被扣分。

✍️ 降低疑似度的核心思路:让文本 “更像人写的”

抓住一个原则就行 —— 强化文本的 “人类创作特征”。怎么强化?从 “表达习惯” 入手最有效。

先说说用词的 “去模板化”。写完一段后,把里面的书面语换成口语化表达。比如把 “在当前社会背景下” 改成 “现在咱们身边”,把 “具有重要意义” 换成 “其实挺重要的”。别担心不够严谨,学术写作也允许适度的口语化,只要不影响逻辑就行。

再就是加入个性化案例。AI 很难写出具体的、带有个人经历的案例。比如论述 “乡村振兴的难点” 时,与其让 AI 写 “部分地区存在基础设施薄弱的问题”,不如改成 “我去年在 XX 村调研时发现,村里的水泥路只修到村口,下雨天运肥料都得靠人力扛”。具体的地名、细节描述,能大幅降低疑似度。

还有个技巧是制造 “合理的不完美”。人类写作时偶尔会有重复或修正,比如 “这个政策的效果 —— 哦对了,这里说的效果主要指短期影响 —— 其实比预期好”。这种小停顿、补充说明,AI 很少会出现,加进去能让文本更 “像人写的”。

逻辑上可以适当 “松绑”。不用刻意追求每段开头都有中心句,偶尔让段落之间的过渡自然一点。比如写完 A 观点后,不用非得说 “接下来讨论 B 观点”,直接讲 “说到这,其实 B 方面的问题也挺关键”,这种自然的跳转更符合人类思维习惯。

📝 实操步骤:从初稿到低疑似度,分三步改

第一步,逐段 “拆解重组”。拿到 AI 生成的初稿后,别直接用。把每段话拆成几个核心信息点,再用自己的话重新串联。比如 AI 写 “人工智能在医疗领域的应用包括疾病诊断、药物研发等,这些应用能提高效率”,拆成信息点是 “人工智能 + 医疗”“应用场景:诊断、研发”“作用:提高效率”,重组后可以写成 “现在人工智能在医院里用得挺多,比如帮医生看片子、研究新药,这么一弄,干活确实快多了”。

第二步,针对性替换 “高危词汇”。系统对某些 AI 高频词特别敏感,比如 “赋能”“抓手”“闭环”“迭代” 这些近几年被 AI 滥用的词,尽量换成通俗说法。“赋能” 改成 “帮上忙”,“抓手” 换成 “突破口”,“闭环” 说成 “形成循环”,看似简单,对降低疑似度作用很大。

第三步,加入 “个人化标记”。在文本里适当插入自己的 “专属印记”,比如学术论文里可以写 “根据笔者在 2023 年的实验数据”“结合本团队的研究经验”;散文类写作里加一句 “记得小时候奶奶总说...”。这些带有个人属性的内容,AI 很难模仿,能有效拉低疑似度。

改完后可以用 “反向检查法”:把修改后的段落读出来,如果听起来像你平时说话的语气,那基本就没问题;如果还是觉得 “太书面”“太规整”,那就再调整。

🚫 这些误区,千万别踩!

很多人觉得 “把 AI 生成的内容打乱顺序就行”,这是大错特错。知网的检测系统不只是看句子结构,更会分析上下文逻辑关联。单纯打乱段落顺序,反而会让逻辑变得混乱,既不符合人类写作习惯,还可能被判定为 “刻意规避检测”,结果疑似度更高。

还有人喜欢 “大段删除再补充废话”,比如在 AI 生成的内容里硬塞一些无关的句子。这种做法很容易被识破,系统会识别出 “有效信息密度低” 的段落,反而增加怀疑。补充内容必须和主题相关,最好是能支撑观点的细节或案例。

也别迷信 “同义词替换工具”。很多人用工具把 “重要” 换成 “关键”,“研究” 换成 “探究”,以为这样就能瞒过系统。但 AI 生成内容的核心问题是 “句式和逻辑特征”,不是单个词汇,这种表层修改作用微乎其微。

最危险的是 “直接用 AI 生成后只改几个字”。现在知网的算法已经能识别 “AI 初稿 + 少量人工修改” 的文本,这种 “半 AI” 内容的疑似度往往在 50%-70% 之间,刚好卡在 “需要重点审查” 的区间,反而更麻烦。

💡 长期降低疑似度的 3 个好习惯

平时写作时多积累 “个人语料库”。比如把自己常说的口头禅、独特的案例、甚至是一些 “不规范但合理” 的表达记下来,写的时候有意识地用进去。比如你总说 “说实话啊...”“我感觉吧...”,这些表达在论文里适当用,既不影响严谨性,又能增加人工特征。

写完后一定要 “出声朗读”。人类的耳朵对 “AI 感” 很敏感,读的时候如果觉得某句话 “不像自己说的”,那大概率就是 AI 特征明显的地方,直接改掉。这个方法比单纯看文字有效得多。

多引用 “非数字化来源” 的内容。比如引用访谈记录、田野调查笔记、个人实验数据这些 AI 很难获取的信息,系统会因为这些 “独特数据源” 的存在,降低对文本的 AI 嫌疑判断。就像你在论文里写 “根据对 XX 村民的访谈,他们更关心的是...”,这种内容 AI 几乎写不出来,疑似度自然就低了。

最后提醒一句,疑似度只是参考,不是最终结论。哪怕数值稍高,只要内容是自己的真实研究成果,通过合理修改和说明,完全可以通过审查。关键是别抱着 “钻空子” 的心态,踏踏实实强化文本的 “人类特征”,这才是最稳妥的办法。