🧠 先搞懂 AI 写作的「命门」:为什么直接用会被抓?

现在的 AI 检测工具,比如 Turnitin、Grammarly,甚至学校自建的系统,核心逻辑都是抓「文本指纹」。什么是文本指纹?就是 AI 生成内容里那些藏不住的特征 —— 比如句式过于规整,学术词汇堆砌得生硬,甚至段落结构都带着算法味儿。

你随便让 ChatGPT 写一段关于「市场经济」的论述,十有八九会出现「综上所述」「此外」这类连接词,段落长度也惊人地一致。这就像机器生产的零件,精准但缺少人工打磨的瑕疵。老师或者系统一眼就能看出不对劲。

更要命的是,现在的检测技术已经能识别「AI 思维链」。比如论证某个观点时,AI 会严格按照「定义 - 现状 - 原因 - 对策」的线性逻辑推进,而人类写作常常会有跳跃、补充甚至自我修正。这种思维模式的差异,就是检测系统的重点盯防对象。

所以,想用 AI 写论文不被发现,核心不是找「更厉害的 AI」,而是要学会给 AI「换脑子」,让它模仿你的写作习惯,甚至故意留下一些「人类才会有的小毛病」。

📝 高级指令设计:让 AI 写出「像你写的」初稿

很多人用 AI 写作,只会发一句「帮我写一篇关于 XX 的论文」。这就等于直接告诉 AI:「按你最擅长的方式写,越标准越好」。结果自然是一查一个准。

真正有用的指令,得包含三个维度:

学科特征植入

给 AI 贴上你专业的「标签」。比如历史专业可以说:「用年鉴学派的视角分析,多引用布罗代尔的理论,论述时带点时间刻度的模糊性,像人类回忆历史细节那样偶尔重复关键词」。计算机专业则可以说:「加入代码调试时的思考痕迹,比如先提出一个方案,再指出漏洞,最后修正,保留 20% 的口语化表述」。

个人写作习惯描述

把你的「写作人设」喂给 AI。比如:「我写论文喜欢先抛出反常识观点,再用案例反驳,最后回归正题。段落开头经常用短句,比如‘但这里有个问题’‘数据显示相反’。参考文献格式偶尔会出错,尤其是年份标注可能差 1-2 年」。

反检测提示

直接告诉 AI 要规避哪些雷区。比如:「避免连续使用三个以上长句,每段故意出现 1-2 处轻微的逻辑跳跃,学术词汇和日常表达的比例控制在 7:3,不要用‘综上所述’‘因此’这类总结性词汇」。

举个实际案例:用这些指令让 AI 写一篇关于「城市更新」的论文,初稿里会出现「但老城区的改造,其实藏着个容易被忽略的点 —— 居民的隐性需求」这种带点口语化的转折,甚至会在数据引用后加一句「这个数字和我上次调研时看到的差不多,只是统计口径略有不同」。这种「不完美」,反而让文本更像人类手笔。

🔍 第一层修改:撕毁 AI 的「标准面具」

拿到 AI 初稿,先别急着通读。第一步是「拆结构」—— 把段落打乱重排。AI 写的内容,段落顺序往往太「合理」,比如一定是先理论后案例,先国内后国外。你要做的,就是故意制造「合理的混乱」。

比如 AI 写「乡村振兴」时,可能会按「经济 - 文化 - 生态」的顺序展开。你可以把文化部分拆成两段,一段插在经济论述中间,另一段放在生态之后。这种跳跃性,反而符合人类写作时想到哪写到哪的特点。

然后是「换词手术」。但不是简单替换同义词 ——AI 已经会用同义词库了。你要做的是「降维替换」:把学术化表达换成半学术半日常的说法。比如把「城市化进程加速导致的社会结构变迁」改成「城市扩得太快,底下的社会架子都跟着变了」。再把「政策执行过程中存在的边际效应递减」换成「政策推到后面,效果慢慢就弱下去了」。

还要注意「句式整形」。AI 写长句特别溜,主谓宾定状补一应俱全。你可以把长句拆成短句,甚至故意留一两个不影响理解的「病句」。比如把「根据 2023 年国家统计局发布的城镇居民可支配收入数据,我们可以清晰地观察到区域间存在的显著差异」改成「2023 年统计局的数据,城镇居民收入,区域差得还挺明显。看那个表就知道」。

最后是「加杂质」。在段落里插入一两个看似多余的细节,比如「我导师上次在课上提到,这个理论最早是在一次学术沙龙上被提出来的,当时还引起了不小的争论」,或者「查资料的时候发现,这个案例在 2019 年有过一次补充报道,只是很少有人注意到」。这些「个人化痕迹」,是 AI 最难模仿的。

✂️ 第二层修改:植入「人类独有的论证逻辑」

AI 的论证过程,就像走直线 —— 从 A 到 B 到 C,一步都不会错。但人类写作不是这样,我们会绕弯、会回头、会突然想到另一个角度。这正是你要在修改中加入的「灵魂」。

可以试试「反证法插花」。在 AI 写的正向论证里,突然插入一段自我反驳。比如论述「线上教育的优势」时,AI 可能会一路夸效率高、资源丰富。你可以加一句「不过这里有个矛盾 —— 我表弟用线上课程时,反而比线下更容易走神。这说明技术优势能不能落地,还得看使用者的自控力」。这种「看似跑题」的思考,反而让论证更真实。

还有「数据本土化」。AI 引用的数据往往是宏观的、通用的,比如「全国范围内 XX 率达到了 X%」。你可以把它换成更具体的、甚至带点个人体验的数据。比如「我在 XX 市调研时,随机访谈的 20 个商户里,有 17 个都提到了类似的问题」,或者「翻学校图书馆的旧报纸,发现 2015 年本地就出现过类似案例,当时的解决办法是……」。

另外,要「暴露思考过程」。AI 给出的结论总是斩钉截铁,而人类会犹豫、会留有余地。比如把「因此该政策必须立刻推行」改成「从数据来看,推行这个政策确实有必要。但我总觉得,是不是该先在小范围试试?毕竟每个地区的情况不太一样」。这种「不彻底性」,恰恰是人类思维的特征。

最关键的是「加入学术史痕迹」。在论述某个理论时,不要像 AI 那样直接用「某某提出了 XX 理论」,而是写成「最早接触这个理论是在大三的选修课上,当时老师还和我们争论过它的适用边界。后来查了 XX 的论文,才发现这个理论在近几年有过三次重要修正」。这种带有个人学习轨迹的表述,几乎不可能被 AI 模仿。

🕵️ 第三层修改:用「学术规范」掩盖 AI 痕迹

论文的格式规范,反而是藏住 AI 痕迹的好地方。很多人只改内容,却忽略了注释、参考文献这些细节,结果栽在这些「小地方」。

注释部分,AI 通常只会简单标注出处。你可以在注释里加入「个人批注」,比如「这段话出自 XX 的《XX》第 35 页,这里的观点和我之前看到的 XX 论文有点冲突,不过角度不同,可以互补」。或者「这个案例在原著里其实有更详细的描述,限于篇幅我做了精简,有兴趣的话可以去看原文第三章」。

参考文献列表,AI 经常会给出格式完美但实际不存在的文献,或者年份、卷号出错。你要做的是:第一,把 AI 列出的文献逐一核实,确保真实存在;第二,故意加入 1-2 篇「边缘文献」,比如某个地方期刊的论文,或者会议摘要;第三,在文献排序上制造一点「混乱」,不要严格按字母顺序或发表年份排列,偶尔穿插一两篇按主题关联的文献。

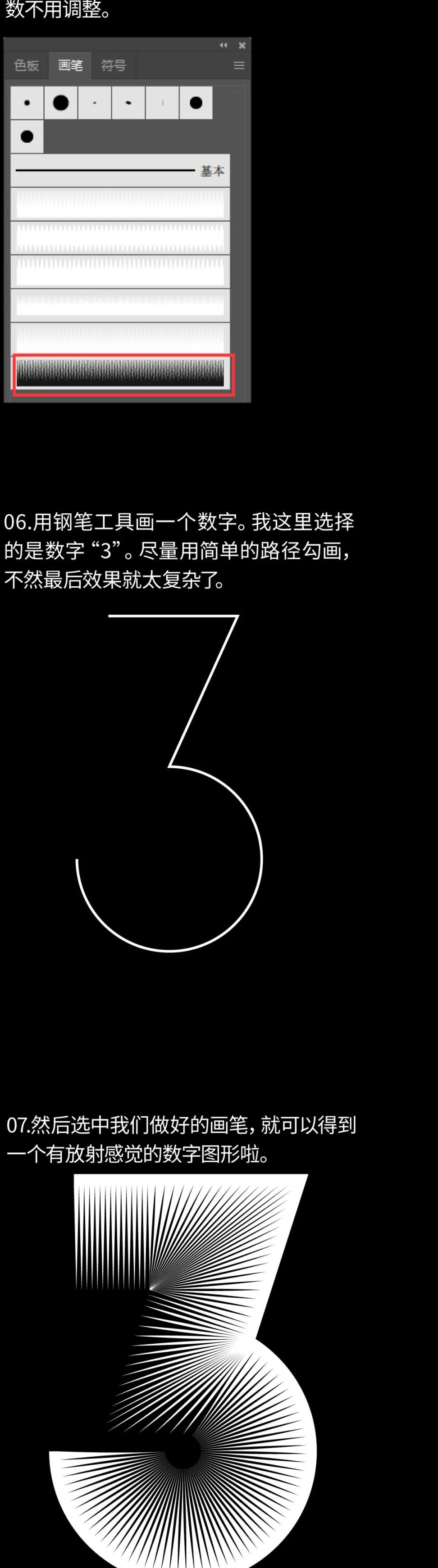

图表部分,如果 AI 生成了数据图表,不要直接用。你可以手动调整数据的呈现方式,比如把柱状图改成折线图,或者在图表下方加一句「数据来源是 XX 数据库,我对原始数据做了微小调整,主要是剔除了明显异常的两个样本」。这种「不完美的处理」,反而更可信。

还有致谢部分,这是最容易被忽略的地方。AI 写的致谢总是千篇一律。你可以写成「感谢导师在论文修改过程中提出的三次关键意见,尤其是第二次讨论时,他让我重新审视了研究方法的合理性。也谢谢实验室的师兄,帮我找了很多外文文献的原文」。具体到细节的感谢,能大大增加论文的「人工感」。

🚨 最后的检测:别信「AI 检测工具」的一面之词

改完之后,一定要自己先做检测。但要注意,没有任何工具是 100% 准确的。Turnitin 的「AI 检测」功能,对中文论文的识别率其实不高;Grammarly 更擅长抓语法错误,对 AI 痕迹的判断经常误报。

我的建议是,用 2-3 个不同的工具交叉检测,比如 CopyLeaks、Originality.ai,再加上学校可能会用的系统(如果能提前知道的话)。如果其中某个工具提示「疑似 AI 生成」的比例超过 30%,就重点修改那部分内容。

更重要的是「人工自查」。把论文打印出来,逐句朗读。读的时候,如果你觉得某句话「不像自己说的」,或者「太顺了」,就标记出来重点修改。人类的语感,有时候比机器检测更靠谱。

另外,可以找同学互相检查。让他们挑出「读起来不舒服」的地方 —— 这些地方往往就是 AI 痕迹最重的地方。毕竟,老师也是用「阅读感受」作为第一判断的。

最后记住,控制 AI 的使用比例。最好的办法是,用 AI 写初稿的 30%-50%,剩下的部分自己写,再把两者揉合在一起。完全依赖 AI,哪怕改得再好,也难免露出马脚。

AI 是个好帮手,但论文终究是要体现你的思考和研究。与其费尽心机藏住 AI 的痕迹,不如学会让 AI 成为你的「学术助理」—— 帮你查资料、列提纲、整理数据,最后用你自己的语言和思维把这些素材重新组织起来。这样写出来的论文,既高效又安全。