🔍 先搞懂 AI 痕迹的 “罪魁祸首” 是什么

想消除 AI 痕迹,得先明白机器写出来的东西到底露了什么马脚。现在主流的 AI 检测工具,比如 Originality.ai 或者 GPTZero,其实都是靠分析文本的 “模式规律” 来判断的。机器写东西有个通病 —— 太 “规整” 了。

你有没有发现,AI 生成的句子往往长度相近,主谓宾结构几乎不变,甚至连连接词的使用频率都很平均。就像排队整齐的士兵,一眼就能看出是刻意训练过的。人类写作可不是这样,有时候突然蹦出个超长句,有时候又用三五个字甩个短句,这种 “不规律” 恰恰是真人的标志。

还有个更隐蔽的点,AI 特别怕 “冗余信息”。比如人类写论文时,可能会在定义后面加一句 “这个概念在 XX 学者的研究里其实有另一种表述,但本文更倾向于前者”,这种看似多余的补充,反而让文字有了 “思考的温度”。机器可不会这么干,它永远追求最简洁的逻辑链条,少了这些 “废话”,反而显得假。

最后得提一嘴学术论文里的 “观点倾斜”。真人写东西,哪怕再客观,字里行间总会藏着自己的倾向。可能是一句 “值得注意的是”,也可能是对某个数据的特殊解读。AI 呢?它只会中立到冷漠,这种 “绝对客观” 在学术界反而显得反常。

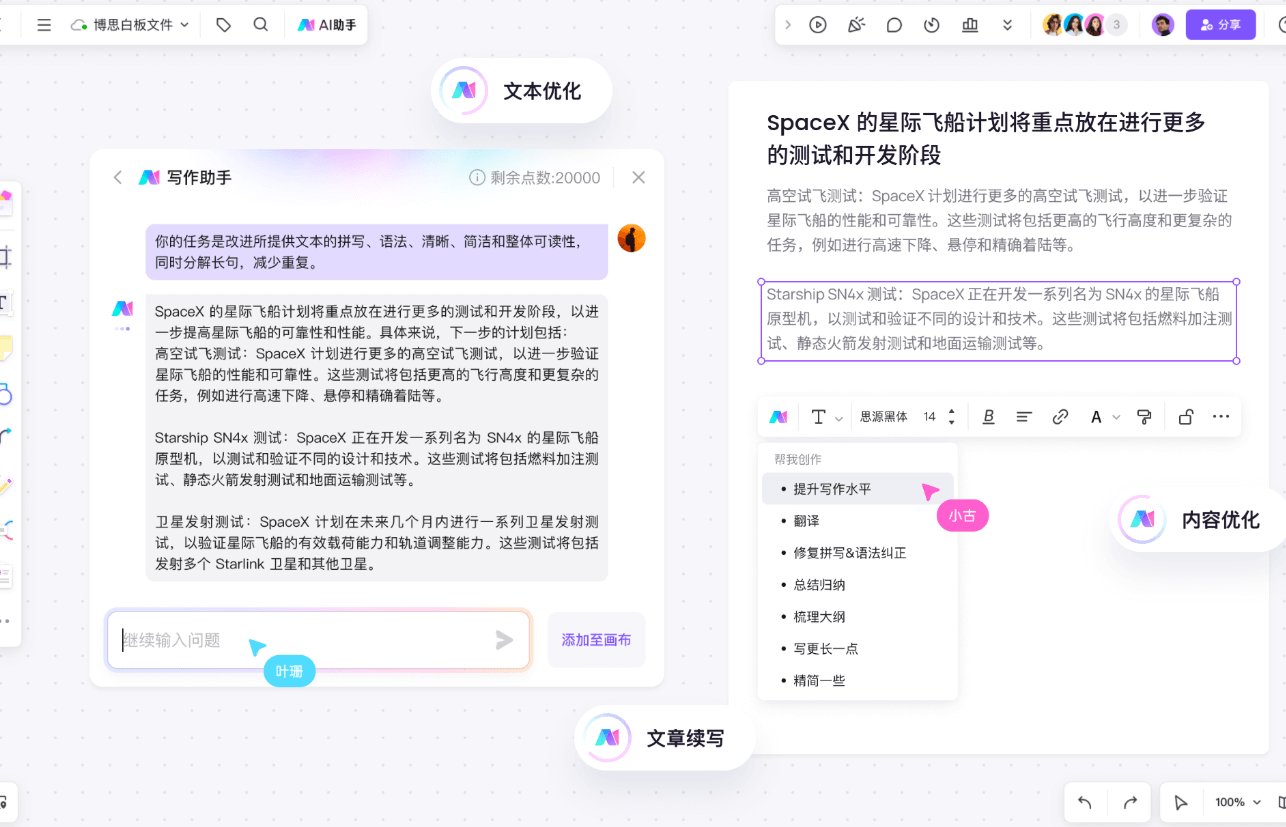

✍️ 语言风格改造:从 “机器腔” 到 “人声”

改语言风格,第一步就得跟 “完美句式” 说再见。AI 写的句子太工整了,主谓宾定状补一个不缺,读起来像教科书里的例句。但真人写作哪有这么讲究?

试试把长句拆碎了重新拼。比如 AI 可能写 “基于上述分析,我们可以得出在特定条件下该理论具有一定适用性的结论”,你改成 “这么看来,这个理论在某些情况能用 —— 但得满足几个前提”。是不是一下子就有那味儿了?多加点破折号、括号里的补充说明,甚至偶尔来个半截话,比如 “这个数据对比…… 嗯,其实能看出另一个问题”,这种 “不完美” 反而更真实。

学术论文里的专业术语用法也很关键。AI 爱堆专业词,好像不用够分量就显得不专业。但真人用术语时,总会不自觉地 “留一手”。比如提到 “路径依赖理论”,后面可能会补一句 “就是诺斯那套关于制度变迁的说法”,这种 “生怕读者不懂” 的细节,恰恰是消除 AI 感的好办法。

还有个小技巧 —— 加 “个人印记”。在论述里插入具体的案例来源,比如 “我在去年做的 XX 实验里也观察到类似现象”,或者 “导师曾经提过,这个变量的影响其实被高估了”。这些带有个人经历的表述,机器很难模仿,因为它没有 “经历” 可言。

🧠 逻辑链条重构:让论证带着 “思考温度”

AI 写的论证过程,就像铺好的铁轨,从 A 到 B 再到 C,严丝合缝但毫无意外。但人类思考的时候,哪有这么顺畅?总会有岔路、有犹豫、有突然的灵光一闪。

想让逻辑链条带点 “人气”,可以在关键节点加 “转折性思考”。比如论证到某个结论时,故意插入一句 “这里其实有个漏洞 —— 如果换个样本会不会结果相反?” 然后自己回答这个问题,再继续往下说。这种 “自问自答” 的模式,能让读者感觉到 “哦,这人是真的在思考,不是在念稿子”。

段落之间的过渡也很重要。AI 爱用 “此外”“然而” 这种硬邦邦的连接词,你可以换成更自然的说法。比如上一段讲了实验方法,下一段要讲结果,不用 “实验结果如下”,改成 “按这个方法做下来,拿到的数据还挺有意思”。这种像聊天一样的过渡,比任何连接词都更像真人。

还有个反常识的技巧 —— 适当 “跑题”。当然不是真跑题,而是在论证主线里加一点相关的 “题外话”。比如讨论数据分析时,突然提一句 “说到这个统计方法,我想起之前看的一篇论文用了更复杂的模型,但结果反而不如这个简单的准”,然后很快拉回主题。这种小小的思维跳跃,反而能打破 AI 的 “线性思维” 痕迹。

最后得检查逻辑的 “松紧度”。机器写的东西,每个论据都严丝合缝地指向结论,密得像块铁板。但人类论证时,总会留一些 “弹性空间”。比如用 “可能”“或许”“在一定程度上” 这些词时,不是为了模糊,而是体现思考的严谨。就像说 “这个结论可能成立”,比 “该结论成立” 更有真人味儿 —— 毕竟学术研究哪有绝对的事。

📚 学术细节填充:用 “专业冗余” 打败算法

AI 写论文,特别爱 “抓大放小”,把框架搭得很完美,但细节里全是窟窿。人类恰恰相反,总在不经意间加入很多 “没必要但很真实” 的细节。

比如引用文献的时候,AI 可能只写 “Smith (2020) 提出了类似观点”。但真人会怎么写?“Smith 在 2020 年那篇发在《XX 期刊》的论文里,其实是用另一个案例论证的,不过核心逻辑跟我们这个研究能对上 —— 有意思的是,他当时的数据样本比我们小一半”。多出来的这些细节,就是 “专业冗余”,既能体现你真的读过那篇文献,又能打破 AI 的模板化引用。

数据呈现也是个突破口。机器报数据喜欢干巴巴的 “实验组均值为 3.2±0.5”,真人可能会加一句 “这个均值看起来不算高,但比对照组高出近 40%,而且我们重复测了三次都是这个趋势”。这种对数据的 “二次解读” 和补充说明,是 AI 很难模仿的 —— 它能算出 40%,但想不到强调 “重复测了三次” 这种体现实验严谨性的细节。

还有个小窍门是 “暴露研究过程”。AI 写方法部分,总是把步骤写得像说明书,一步接一步。但实际做研究哪有这么顺利?你可以加一句 “这里其实试了三种提取方法,最后选的这种虽然耗时,但数据稳定性最好”,或者 “最初的样本量是 50,但有 8 个因为仪器故障作废了,所以最终用了 42 个”。这些 “不完美的过程” 反而让论文显得更可信,也更像真人写的。

术语的 “生活化转译” 也很重要。比如解释 “内生性问题” 时,别只说 “变量间存在相互影响导致估计偏差”,可以说 “就是你想研究 A 对 B 的影响,结果发现 B 其实也在影响 A,这种绕圈子的问题特别麻烦”。这种把专业概念 “掰开揉碎” 的说法,既体现专业度,又带着人的温度。

🔬 终极检测:用工具 + 人工双重校验

改完之后别着急提交,得用工具先扫一遍。现在靠谱的 AI 检测工具有不少,比如 Turnitin 新出的 AI 检测功能,或者专门测学术文本的 Copyscape,都能给个参考值。但记住,工具只是辅助,别被数值绑架了。

一般来说,AI 概率降到 15% 以下就比较安全了,但更重要的是看 “可疑片段”。检测报告里标红的部分,往往是句式最规整、最像机器的地方。对着这些片段再改一遍,重点改句式 —— 把被动句改成主动句,把长句拆短,加个口语化的连接词。

光靠工具不够,还得用 “人类视角” 读一遍。最好是打印出来,或者换个字体颜色,模拟审稿人的阅读场景。读的时候问自己:这句话像不像我平时跟导师讨论时说的话?这个论证过程有没有 “卡壳” 的地方?如果某一段读起来特别顺,顺到不像自己写的,那大概率还有 AI 痕迹。

可以找个同行帮你看一眼,不用细说改了什么,就问他 “读着有没有哪里不对劲”。有时候自己改多了会麻木,别人一眼就能看出 “这不像你平时的调子”。真人的直觉,往往比算法更准。

最后还有个笨办法 —— 隔两天再看。改完放两天,等对文本的敏感度恢复了再读,那些隐藏的 AI 痕迹会更容易冒出来。就像看自己拍的照片,当时觉得挺好,过几天再看,总能发现表情不自然的地方。论文润色也是一个道理,时间能帮你找出很多细节问题。

其实消除 AI 痕迹的核心,不是模仿机器的 “完美”,而是接纳人类的 “不完美”。学术写作本来就该带着思考的温度和过程的真实,机器再厉害,也学不会人在研究中那些犹豫、试错和灵光一闪。把这些 “人的痕迹” 写进去,不仅能躲过算法检测,更能让论文本身更有价值。