🔍 告别 AI 胡说时代,这份 2025 版 prompt 编写圣经值得收藏

AI 胡说八道的问题,现在真的太让人头疼了。你让它写个产品推广文案,它能给你整出一堆不存在的技术参数;你让它分析数据,它又能编造出一些虚假的统计结果。不过别担心,今天就给大家带来一份 2025 版的 prompt 编写圣经,帮你彻底告别 AI 胡说时代。

📌 CO-STAR 框架:搭建高效 prompt 的基石

在 prompt 编写中,结构真的太重要了。新加坡政府科技局的数据科学与 AI 团队提出的 CO-STAR 框架,就是一个非常实用的工具。这个框架考虑了影响 LLM 响应的多个方面,能让你得到更符合需求的结果。

先来说说场景(Context)。你得让 AI 清楚知道它所处的具体环境,这样它的响应才会更相关。比如说你是社交媒体管理者,要宣传公司的新产品,你就得把公司名称、产品特点等信息告诉 AI。

目标(Objective)也很关键。你得明确告诉 AI 你希望它执行的任务,是写一篇宣传文案,还是分析一份数据报告。明确的目标能让 AI 把重点放在完成具体任务上。

风格(Style)和语气(Tone)能让 AI 的输出更符合你的要求。你可以指定 AI 使用某种名人的写作风格,或者某种职业专家的风格,也可以让它保持正式、幽默等不同的语气。

受众(Audience)也不能忽视。你得考虑 AI 的输出是给领域专家看,还是给初学者看,或者是给孩童看。针对不同的受众,AI 的表达和用词都要有所调整。

最后是格式(Format)。你得告诉 AI 你希望的输出格式,是列表、JSON,还是专业报告等。特别是对于需要程序化处理的任务,合适的格式能让后续工作更顺利。

举个例子,如果你只是简单地让 AI 写一篇 Facebook 帖文宣传产品,它可能只会给出一些泛泛而谈的内容。但如果你使用 CO-STAR 框架,把场景、目标、风格、语气、受众和格式都明确告诉 AI,它就能生成更有针对性、效果更好的内容。

🛠️ Claude 3.5 编码 prompt:技术用户的福音

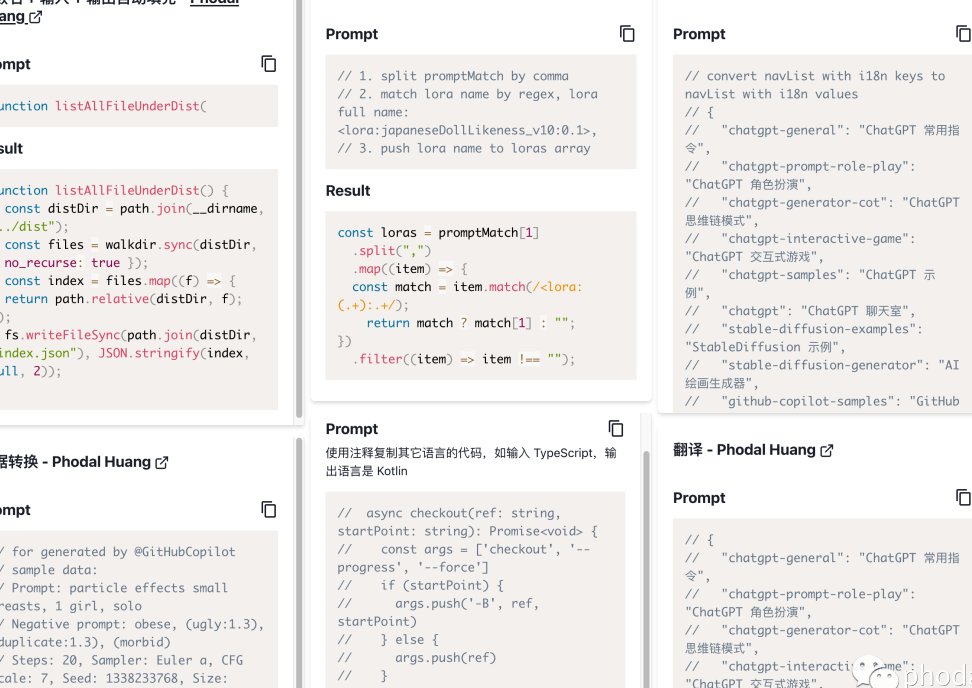

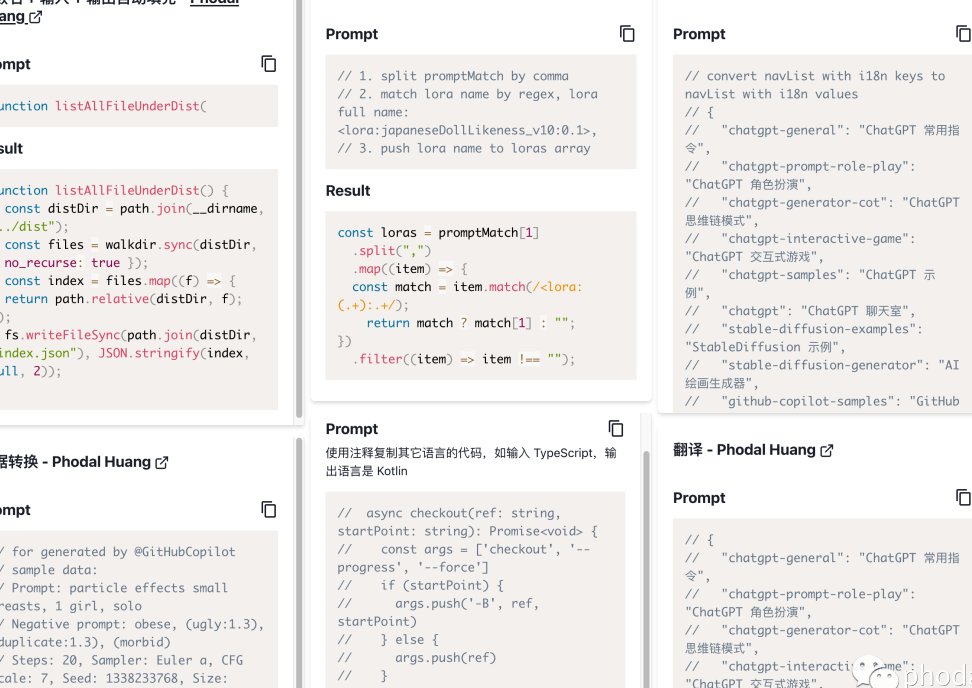

对于技术用户来说,Claude 3.5 的编码 prompt 技巧非常实用。它包括代码审查、规划、输出和安全审查四个步骤。

代码审查是第一步。在编写或建议代码之前,你得让 AI 对现有代码进行全面的审查,并描述其工作原理。这样可以避免 AI 在不考虑更广泛上下文的情况下,对代码进行局部更改。

规划阶段,AI 会生成一个高层次的设计和实施规划。你可以在这个阶段深入探讨规划的细节,进一步完善方案。如果还没有达成一致,就可以在这个阶段停止,避免生成不需要的代码。

输出阶段,当规划得到一致后,AI 就会生成代码。在这个过程中,要注意变量名、标识符、字符串字面量的准确性,保持现有的代码风格,使用适合该语言的习惯用法。

安全审查是最后一步。特别是对于敏感的更改,如输入处理、货币计算、身份验证等,要进行彻底的审查,确保代码的安全性。

使用这个提示,你可以让 Claude 3.5 在编码任务中表现得更加出色,减少错误和幻觉的出现。

🚫 为什么 AI 会胡说:揭示幻觉背后的真相

AI 产生幻觉的原因其实和它的工作原理密切相关。AI 大模型本质上是一个庞大的语言概率预测和生成模型,它通过分析互联网上的海量文本,学习词语之间的关联规律,然后逐字逐句生成回答。

训练数据的问题是导致 AI 幻觉的一个重要原因。互联网上的信息鱼龙混杂,不乏虚假信息、虚构故事和偏见性观点。这些信息一旦成为 AI 训练的数据源,就会出现数据源污染。当某个领域专业数据不足时,AI 便可能通过模糊性的统计规律来 “填补空白”,从而产生幻觉。

奖励机制也有一定的影响。在训练过程中,为了使 AI 生成满足用户需求的内容,训练者会设置奖励机制。对于数学题等需要逻辑推理的问题,往往通过确认答案的正确与否给予奖励;对于写作等开放式命题,则更多关注语言的逻辑性和内容格式等指标,忽略了事实的核查。这就导致 AI 可能会编造一些虚假的例证或看似科学的术语来支撑自己的 “假说”。

此外,AI 缺乏辨别真伪的能力。它擅长模仿人类的语言风格,但有时无法判断内容的真实性。这就使得它在面对一些超出其 “知识储备” 的问题时,会编造一些不存在的细节。

🧩 修辞提示法:让 AI 成为你的写作伙伴

拉奥提出的修辞提示法,是一种将提示工程作为批判性思维和体裁意识延伸的方法。它参照了写作教学法的最佳实践,是一个有受众意识的递归过程。

在使用修辞提示法时,你可以指导学生修改写作,也可以指导他们修改提示词,帮助他们获得表达更清晰、修辞效果更佳的输出。学生们不再依赖于初始输出内容,而是学习撰写目标导向的提示词,分析 AI 的回应,并带着意图进行迭代。

配套的伦理提示轮是一个可视化决策工具,用以评估 AI 生成的输出是否符合有用性、相关性、准确性和无害性四项基本标准。这个框架确保了人类始终处于创作行为的中心,并对结果承担全部责任。

无论是修改电子邮件、起草文章还是确立研究大纲,修辞提示法和伦理提示轮都能帮助你训练自己成为在 AI 支持的环境下高效且具备伦理意识的写作者。

🔄 预测偏差:优化 prompt 的新视角

一项最新的研究从预测偏差的角度,提出了 prompt 搜索策略。研究发现,一个给定的 prompt 的质量取决于它的内在偏差。基于这个现象,文章提出了一个基于预测偏差的替代标准来评估 prompt 的质量,该度量方法能够在不需要额外开发集的情况下通过单个前向过程来评估 prompt。

研究提出了两种新颖的策略:T-fair-Prompting 和 G-fair-Prompting。T-fair-Prompting 使用一种直观的方式,首先计算每个示例单独组成 prompt 的偏差,然后选择 Top-k 个最公平示例组合成最终 prompt。G-fair-Prompting 则遵循贪心搜索的常规过程,通过在每个步骤上进行局部最优选择来找到最优解。

通过实验验证,G-fair-Prompting 与 SOTA 方法相比,在不同的下游任务上获得了超过 10%的相对改进。这种方法可以为未来的自然语言处理研究提供启示,帮助我们找到更优的 prompt。

💡 prompt 的价值:从魔法到商业化应用

Prompt 在 AI 时代的价值已经越来越被人们所认可。它就像童话故事里的魔法一样,拥有它就拥有 “巫师” 一样的能力。在图像生成类应用中,如 Midjourney,prompt 的重要性更是不言而喻。一个好的 prompt 可以让 AI 生成出令人惊叹的图像,而一个差的 prompt 则可能导致结果不尽人意。

Prompt 的商业化应用也越来越广泛。国外已经出现了 PromptBase 等明码标价的平台,涉及多个模型和细分场景。国内也有商家在电商平台上兜售 Prompt,或者将其做成面向垂直任务场景的应用,吸引刚需用户按月付费使用。

此外,prompt 还可以作为吸引流量的工具。在小红书、B 站、抖音等平台上,分享 Prompt 的笔记和教程越来越多,通过教用户使用 Prompt,吸引了大量的粉丝群体。

不过,随着 AI 技术的不断发展,未来 Prompt 可能会逐渐消失。当 AI 能够更好地理解语境和连贯性,具备丰富的常识和推理能力,理解和处理情感信息,并且有主动学习和适应能力时,我们就不再需要精确的提示词,用自然语言进行提问就能得到满意的结果。

总之,掌握有效的 prompt 编写技巧,是告别 AI 胡说时代的关键。无论是 CO-STAR 框架、Claude 3.5 的编码 prompt,还是修辞提示法和预测偏差优化策略,都能帮助你更好地与 AI 沟通,让 AI 为你所用。这份 2025 版 prompt 编写圣经,值得你收藏和实践。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味