写 prompt 最头疼的是什么?就是 AI 顺着你的问题开始 “一本正经地胡说八道”。明明问的是具体数据,它能编出一串看起来像模像样的数字;让它分析专业领域,却冒出一堆常识性错误。想要避免这种情况,关键就在 prompt 的设计上。这篇内容就拆解几个核心技巧,帮你写出真正能 “防胡说” 的 prompt。

🎯 第一个关键:指令必须 “窄而具体”,拒绝宽泛表述

很多人写 prompt 喜欢用 “帮我分析一下 XX 行业”“讲讲 XX 历史” 这种大而化之的说法。这种指令等于给了 AI 无限发挥的空间,它很容易在信息不全的时候开始 “脑补”。

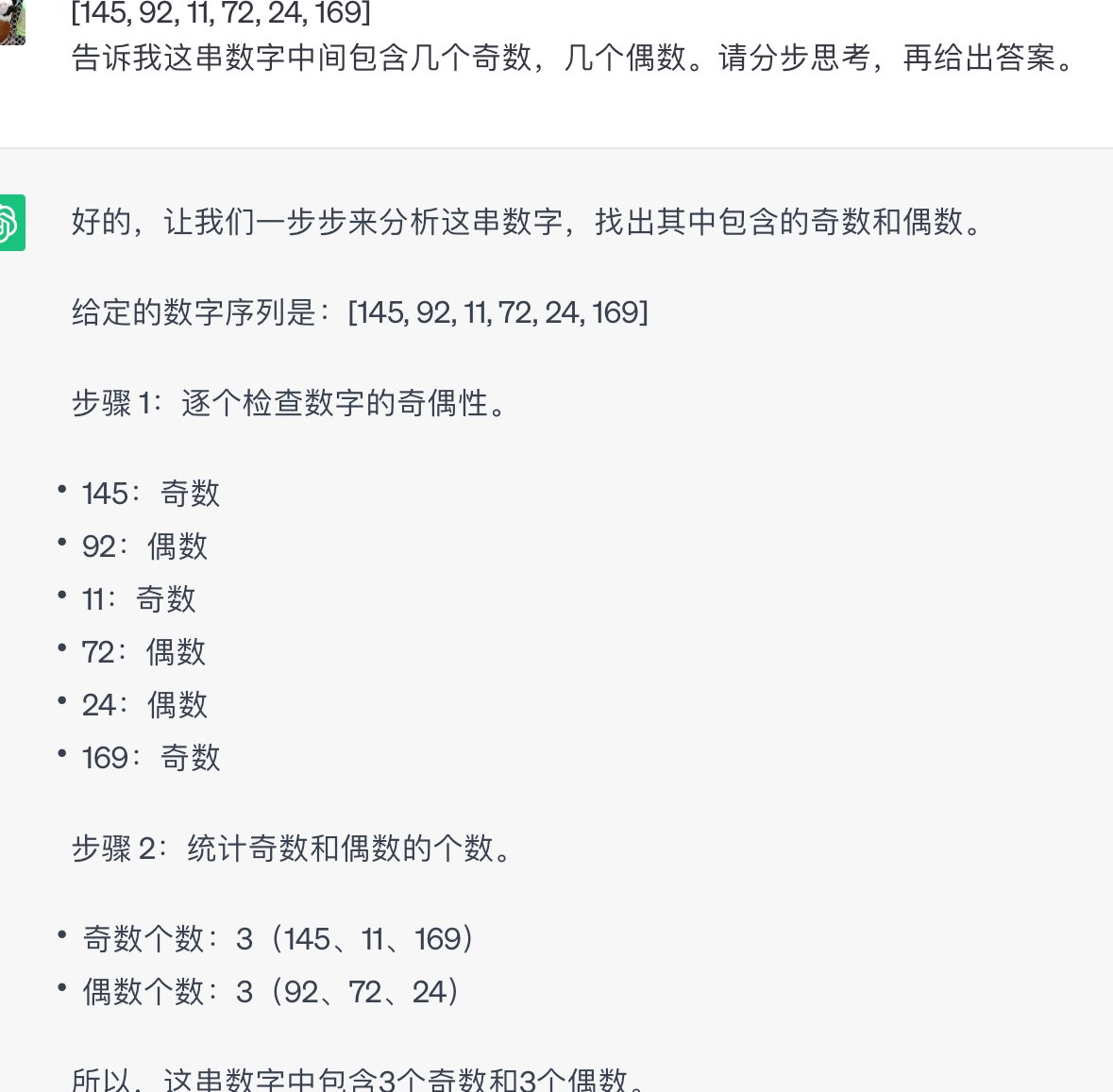

比如你想了解 “2024 年中国新能源汽车的出口数据”,如果只说 “告诉我 2024 年中国新能源汽车出口情况”,AI 可能会把 2023 年的数据改改年份就发给你,甚至编一个看起来合理的增长率。但如果换成 “列出 2024 年中国新能源汽车月度出口量,需注明数据来源为海关总署或工信部公开报告,若无法提供确切数据请说明‘暂无官方数据’”,情况就会好很多。

核心在于把 “要什么” 和 “不要什么” 都说清楚。你可以在 prompt 里加入具体的维度限制,比如时间范围、数据来源、信息层级等。举个例子,问法律问题时,不说 “解释一下劳动合同法”,而是 “根据 2023 年修订版《劳动合同法》,说明试用期最长不得超过几个月,引用具体条款编号”,AI 就很难乱编了。

还有个小技巧,在指令末尾加一句 “所有表述需可验证,对于不确定的信息用‘可能’‘疑似’等词标注”。亲测这个约束能让 AI 的 “胡说阈值” 提高不少。

📌 第二个关键:给足 “信息锚点”,让 AI 有据可依

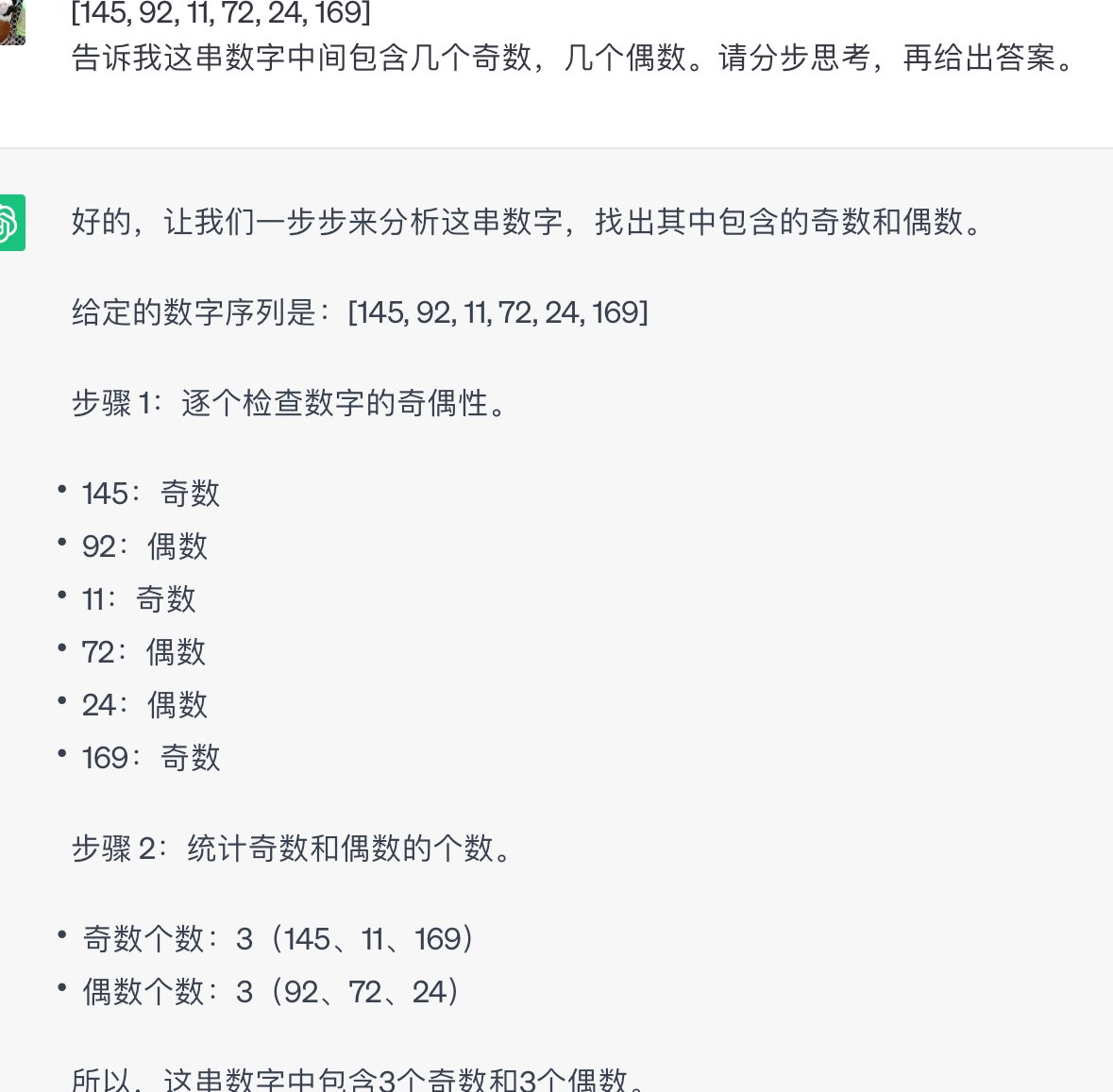

AI 胡说的根源往往是 “信息不足但必须回答”。解决这个问题的办法,就是在 prompt 里提供足够的 “锚点信息”,让它只能在你给的框架内发挥。

比如你想让 AI 分析某款产品的市场反馈,不要只说 “分析 A 产品的用户评价”。可以改成 “基于以下 3 条 A 产品的用户评论:1.‘续航比宣传少 2 小时’;2.‘客服响应很慢’;3.‘价格偏贵但质感不错’,总结用户对产品的 3 个核心反馈,不得添加评论中未提及的内容”。

这里的 “锚点” 就是你提供的具体信息,加上 “不得添加额外内容” 的约束,AI 就很难凭空捏造。再举个例子,做历史事件分析时,你可以先给出几个确定的时间节点和事件,然后让 AI 基于这些信息梳理脉络,比如 “已知 1945 年 8 月 15 日日本宣布投降,1945 年 9 月 2 日签署投降书,请据此说明抗日战争胜利的标志性事件,不得涉及上述时间点之外的内容”。

信息锚点越具体,AI 发挥的空间就越小。如果你担心 AI 会忽略锚点,可以在 prompt 里重复强调 “所有结论必须基于上述提供的信息”,这种重复约束往往很有效。

🚫 第三个关键:划定 “能力边界”,提前堵住漏洞

AI 经常会在自己不擅长的领域强行回答,导致胡说。所以在 prompt 里明确它的 “能力边界”,告诉它哪些情况应该 “认怂”,反而能提高内容可信度。

比如问一些专业领域的问题时,可以加上 “若涉及医学、法律等专业建议,需注明‘以下内容仅供参考,不构成专业指导’;若无法确定答案,请直接回复‘该问题超出我的知识范围’”。

还有一种情况是 AI 会 “假装知道” 最新信息。你可以在 prompt 里加入时间限制,比如 “基于 2023 年 10 月前的公开信息回答,对于 2023 年 10 月后的事件,若无法确认请说明‘暂无最新数据’”。现在很多 AI 模型的训练数据截止到某个时间点,这种时间边界的设定能有效避免它编造未来的信息。

另外,对于一些容易混淆的概念,提前在 prompt 里做区分也很有用。比如 “解释‘定金’和‘订金’的区别时,需明确指出二者在法律层面的不同,不得混淆概念,若无法准确区分请说明”。这种提前 “打预防针” 的方式,能减少很多常识性错误。

🔍 第四个关键:加入 “校验机制”,让 AI 自我审核

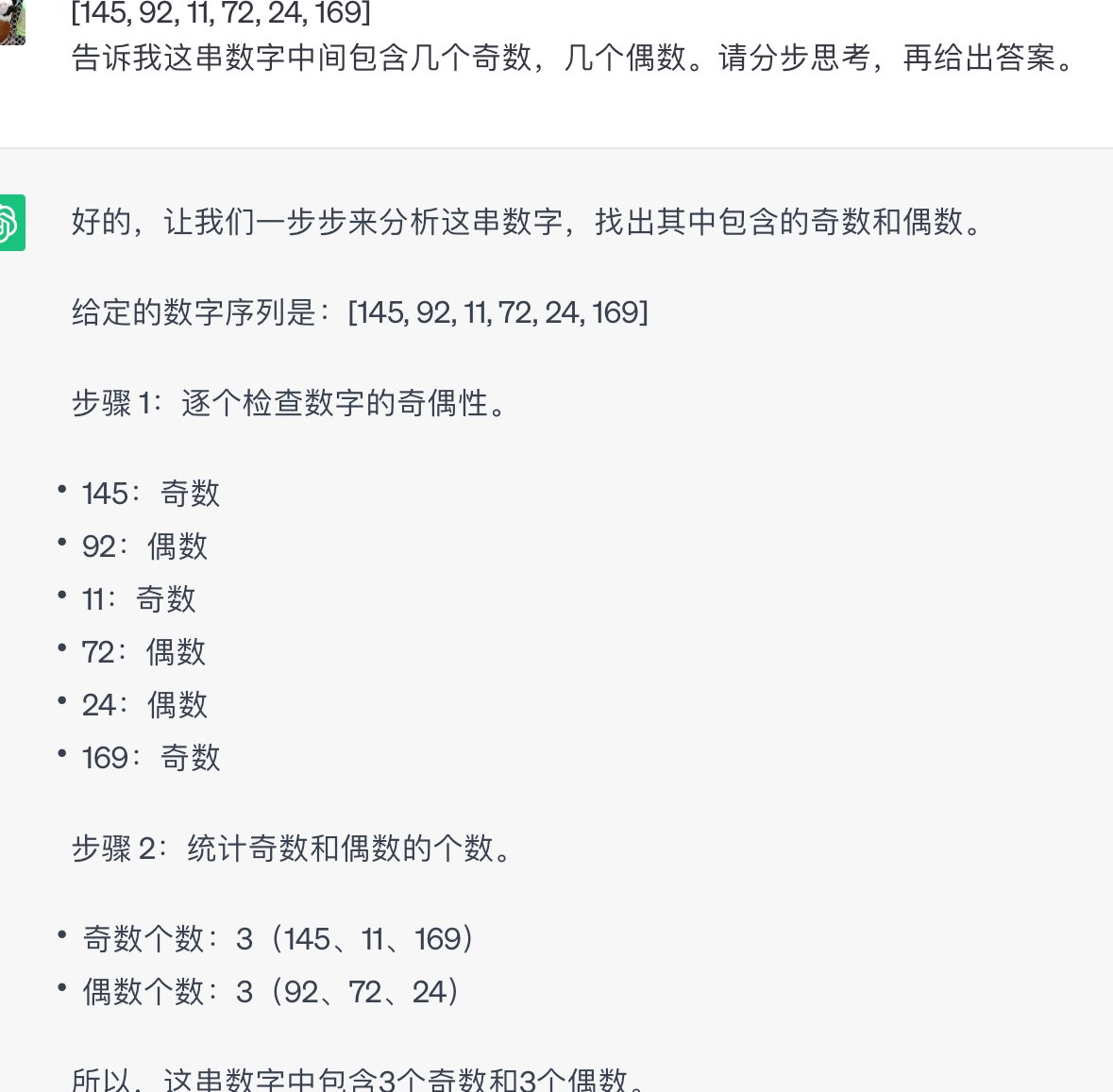

光是约束还不够,最好能在 prompt 里加入让 AI “自我验证” 的环节,相当于给它加一道 “自查工序”。

比如让 AI 写一篇行业报告时,可以在结尾加上 “完成后请检查内容是否存在以下问题:1. 是否有无法验证的数据;2. 是否有模糊的表述(如‘可能’‘大概’未说明原因);3. 是否涉及未提及的行业术语。若存在上述问题,请修改后再提交”。

这种自我校验的要求,能让 AI 在输出内容前多一层审视。再举个例子,做数据计算时,你可以说 “计算 2023 年某公司的利润率(已知营收 1000 万,成本 600 万),计算过程需分步展示,并在最后核对‘利润 = 营收 - 成本,利润率 = 利润 / 营收’的公式是否正确”。

校验机制的核心是让 AI 暴露思考过程。当它需要展示 “为什么这么说” 时,就很难凭空捏造。比如让 AI 推荐一本书,不说 “推荐一本心理学书籍”,而是 “推荐一本心理学入门书,说明推荐理由,并解释这本书适合入门的 3 个原因,每个原因需对应书中的具体章节或内容”。这种要求具体依据的表述,能有效减少 AI 的 “信口开河”。

❌ 第五个关键:避开 “无效约束”,这些表述等于白说

很多人写 prompt 时喜欢加一些看似有用的约束,其实对防胡说毫无作用,甚至会起反效果。

比如 “请认真回答”“务必保证准确” 这种话,AI 根本不会因为你说了就更认真。它的输出只取决于指令的具体性,而不是你的 “态度”。还有 “不能胡说” 这种表述,太模糊了,AI 根本不知道什么叫 “胡说”,不如换成 “所有数据需注明来源”“观点需有事实支撑” 这种具体要求。

另外,不要在 prompt 里加入过多无关信息。比如问 “如何提高睡眠质量”,前面加一堆 “我最近工作很忙,压力很大,晚上总睡不着,有时候还会做梦……” 这种铺垫,反而会让 AI 抓不住重点,更容易偏离核心问题。简洁直接的指令往往效果更好。

还有一个误区是 “过度开放”。比如 “随便说说对 XX 的看法”,这种开放式的指令等于在鼓励 AI 自由发挥,自然容易出现不靠谱的内容。哪怕你想让 AI 自由表达,也要加上 “基于公开报道的信息”“结合 XX 领域的常识” 这种限制条件。

总结一下,写出 “防胡说” prompt 的核心就是:把指令变具体,把边界划清晰,把依据说明白。记住这三个 “把”,再结合上面的技巧,就能大幅减少 AI 胡说的概率。试几次你就会发现,同样的问题,换个 prompt 写法,得到的答案质量会天差地别。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】