🔍 判断 AI 生成内容原创度的 3 个核心维度

很多人以为看一段文字是不是 AI 写的,只要用检测工具扫一下就行。其实没那么简单。真正判断原创度得从几个角度交叉验证,单靠一个指标下结论很容易出错。

语义连贯性是第一个要盯的点。人类写作时,哪怕是闲聊,句子之间的逻辑跳转有规律,会有自然的思维断点或者突然的联想。AI 生成的内容呢?往往太 “完美” 了,段落衔接处过度平滑,甚至有点刻意。比如写一篇关于旅行的文章,人类可能会突然插入一句 “那天突然下雨,幸好带了伞” 这种看似无关的细节,AI 却会严格按照预设的逻辑推进,少了这种 “意外感”。检查时可以刻意找段落转折处,看看有没有这种自然的思维跳跃。

信息密度是第二个关键指标。AI 生成内容容易出现 “稀释感”,就是看起来写了很多,实际有效信息没多少。比如描述一个产品功能,人类可能会直接说 “这个按钮点三次会崩溃”,AI 可能绕一圈说 “该交互元素在多次触发后,存在一定概率出现响应异常的情况”。这种冗余表达不是绝对的,但高频出现时就得警惕。可以把内容复制到 Word 里,统计核心观点出现的频率,再对比同主题的人类创作,差距很明显。

风格一致性也不能忽略。人类写作会有风格波动,比如写专业内容时突然冒出一句口语化的吐槽,或者在严肃分析里加个比喻。AI 如果没特别设置,风格会保持高度统一,像个精准的机器。特别是长文里,段落之间的语气、用词习惯变化极小,这时候就要打个问号了。

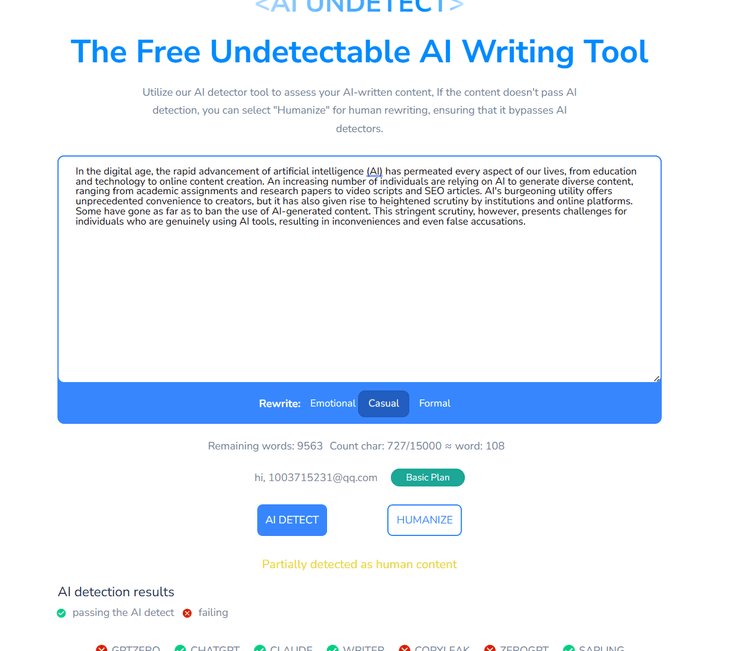

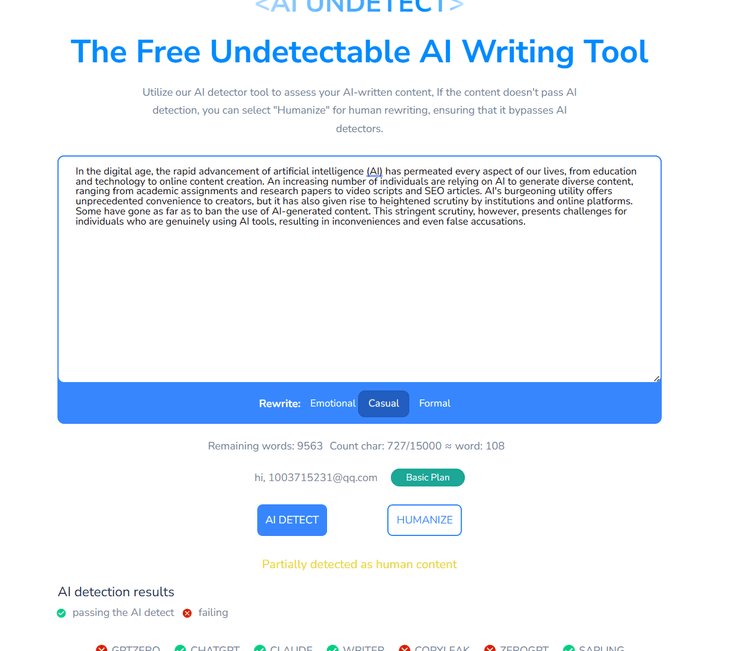

🛠️ 5 款实用 AI 原创度检测工具深度测评

市面上检测工具不少,各有各的脾气。选对工具能省很多事,选错了可能白忙活。

Originality.ai 适合对精准度要求高的场景。这款工具的核心算法是分析文本的 “预测熵值”—— 简单说就是看句子接下来的用词是不是符合人类的 “不可预测性”。它对 GPT 系列模型的识别率能到 95% 以上,尤其是 GPT-4 生成的内容,很少误判。但缺点也明显,每次检测都要付费,按字数收费,长期用成本不低。适合自媒体团队或者内容工作室,偶尔需要批量检测时用。

Copyscape 更侧重 “查重 + AI 检测” 双重验证。很多人知道它是查重神器,其实新版加入了 AI 识别功能。它的优势是能同时告诉你内容有没有抄袭,以及是不是 AI 生成的。对于担心 “AI 洗稿 + 抄袭” 双重问题的用户很友好。不过对国内的大模型识别一般,比如文心一言、讯飞星火这些,有时候会漏判。

Grammarly 的 AI 检测插件 适合日常轻量使用。作为老牌写作辅助工具,它的 AI 检测功能藏在 “风格” 分析里。虽然不如专业工具精准,但胜在方便,写完直接在编辑器里看结果。它更擅长识别那些 “过度优化” 的 AI 内容 —— 就是那种刻意模仿人类语气,但细节处露马脚的文本。免费版能看个大概,付费版才有详细分析报告。

第五 AI 的朱雀检测 对中文内容更友好。国内团队开发的工具,专门针对中文 AI 生成内容优化过。像百度文心、阿里通义千问这些模型写的东西,它的识别准确率比国外工具高 30% 左右。最大的亮点是能给出 “降 AI 味建议”,不只是判断是不是 AI 写的,还告诉你哪句话太机械,怎么改更像人类表达。适合做公众号、头条号的创作者,毕竟中文表达的细微差别,还是本土工具更懂。

Writer.com的 AI Content Detector 适合团队协作场景。它能集成到 Google Docs、Notion 这些协作工具里,多人编辑时自动标红可能是 AI 生成的段落。还能设置团队专属的 “风格库”,把人类作者的写作习惯录入系统,作为比对基准。对于有固定风格要求的企业内容团队来说,这个功能很实用。但免费版限制多,每月只能检测 5000 字。

💡 提升检测准确率的 4 个实用技巧

光靠工具不够,得结合人工判断。有时候工具会把人类写的东西误判成 AI,特别是那些逻辑清晰、结构严谨的文章。这时候就得靠自己多留个心眼。

交叉使用 2-3 款工具是避免误判的关键。比如先用 Originality.ai 测一遍,再用朱雀检测复核。如果两款工具结果一致,可信度就高。要是一个说 “90% AI 生成”,另一个说 “大概率人类创作”,就得仔细看具体标红的段落。通常这种情况是因为文本里混合了人类和 AI 写的内容,比如开头自己写,中间用 AI 扩写,结尾再修改。

关注 “低概率” 标记的部分。很多工具会给每个句子标上 AI 生成概率,那些显示 “30%-60%” 的段落最值得注意。完全人类写的内容,概率一般低于 20%;纯 AI 生成的常高于 80%。中间这段模糊地带,往往是 “人类修改过的 AI 内容”,这时候要手动读一遍,看有没有逻辑断层。比如一句复杂的分析后面,突然接了个简单的总结,风格不搭,可能就是改了一半的 AI 文本。

结合内容主题判断。有些主题本身就容易被 AI 写得 “模板化”,比如产品说明书、新闻通稿。这些内容哪怕是人类写的,也可能被工具误判。这时候要看细节:人类写的说明书会加具体案例,比如 “按电源键 3 秒开机(注意不要长按超过 5 秒,否则会进入安全模式)”,AI 写的可能只说 “长按电源键即可开机”。这种细节差异,工具可能忽略,得靠人来识别。

建立自己的 “检测样本库”。如果经常处理某类内容,比如科技评测、情感散文,可以收集一些确定是人类写的优质文章,和 AI 生成的同主题文章,对比它们在检测工具里的表现。慢慢就能摸出规律,知道哪些特征是工具最敏感的,判断时心里更有底。

📌 不同场景下的工具选择指南

不是所有工具都适合所有情况。根据自己的使用场景挑,效率会高很多。

个人创作者预算有限的话,优先用 Grammarly 免费版 + 朱雀检测的免费额度。Grammarly 日常写作时实时检查,遇到拿不准的段落,复制到朱雀检测里深度分析。这两个工具的免费功能加起来,足够应付大多数自媒体文章的检测需求。每月花不了几块钱,性价比很高。

企业内容团队最好配Originality.ai+Writer.com。前者保证检测精准度,后者方便团队协作时实时监控。特别是有外部撰稿人的团队,用Writer.com能快速筛查投稿里的 AI 生成内容,避免发布后被平台处罚。预算充足的话,再加上 Copyscape,防止既用了 AI 又抄了别人的内容。

做中文内容的一定要试试朱雀检测。国外工具对中文的 “语气词”“方言表达” 识别很差,比如 “咋整”“为啥” 这种词,人类写很自然,AI 生成时会显得生硬,但很多工具抓不到这个点。朱雀检测在这方面做了专门优化,能识别出这些细微差别。

学术论文检测别只依赖 AI 工具。学术场景更看重 “原创性” 而非 “是否 AI 生成”。可以先用 Turnitin 查抄袭,再用 Originality.ai 看 AI 比例。现在很多高校对 AI 写作的规定是 “可以用但要注明”,所以检测的目的不是判断对错,而是掌握使用比例,避免过度依赖。

🚫 检测工具的 3 个常见误区

别把工具当成万能的。现在 AI 生成技术更新太快,检测工具的算法永远慢一步。知道这些误区,能避免踩坑。

认为 “AI 检测率 100% 准确” 是最大的错。上个月有个案例,某科技博主用 ChatGPT 写了篇手机评测,自己修改了 80%,结果用 3 款工具检测,一个说 “全 AI 生成”,一个说 “50% 人类创作”,还有一个说 “纯人类写的”。这说明工具的判断受文本修改程度影响极大,不能盲从结果。

忽略 “AI 生成 + 人工深度修改” 的灰色地带。现在很多人用 AI 写初稿,然后逐句修改,这种内容很多工具都测不出来。这时候判断原创度,就得看内容有没有 “独特观点”。AI 生成的内容大多是整合现有信息,人类修改时如果加入了自己的经历、数据或独家分析,哪怕用了 AI 初稿,原创度也很高。

过分追求 “零 AI 检测率” 没必要。有些人为了让工具显示 “100% 人类创作”,刻意写得颠三倒四,牺牲了可读性。其实平台更在意的是内容质量,只要观点独特、有价值,即使有少量 AI 辅助痕迹也没关系。检测工具只是参考,不是最终标准。

🔄 未来 AI 原创度检测的发展趋势

随着大模型不断进化,检测技术也在跟着变。了解这些趋势,能提前做好准备。

多模态检测会成为主流。以后不只是检测文字,还会结合图片、视频里的文字信息一起分析。比如一篇文章配了 AI 生成的图片,文字也是 AI 写的,工具能综合判断整体原创度,而不是分开检测。

个性化基准线会普及。就像现在的指纹识别,每个人的写作风格也会被工具记录,作为判断基准。比如你平时写作喜欢用 “首先”“不过” 这些词,突然某篇文章里一个不用,工具就会提醒 “风格异常”,可能有 AI 参与。

和创作工具深度融合。未来的 Word、石墨文档里,可能会实时显示 “当前段落 AI 生成概率”,边写边提醒,就像现在的拼写检查一样。你刚写完一句,工具就告诉你 “这句话 70% 像 GPT 生成的,建议修改”,从源头降低 AI 痕迹。

检测 AI 生成内容的原创度,说到底是为了保证内容质量,而不是为了 “反 AI”。毕竟工具是死的,内容的价值才是活的。哪怕全是 AI 生成的,只要观点独特、信息有用,一样有存在的意义。关键是找到人类智慧和 AI 工具的平衡点,既不被技术绑架,也不排斥技术进步。