做内容的朋友肯定都遇到过这种情况:辛辛苦苦写了篇稿子,查重时发现和网上某篇文章撞了思路,甚至连某些句子都高度相似。这时候多数人的第一反应是 "赶紧改改,把重复率降下去"。但你有没有想过,AI 文本相似度检测工具的作用,其实远不止 "降重" 这么简单?

现在的 AI 文本相似度技术,早就不是简单比对关键词重复率的年代了。它能通过语义分析,判断两篇文章在核心观点、论证逻辑甚至情感倾向上的相似度。这意味着什么?它能帮你发现内容的 "隐性重复"—— 那些看起来用词不同,但表达的意思、传递的价值几乎一样的内容。对创作者来说,这其实是个提升内容质量的绝佳契机。

🧠 先搞懂:AI 文本相似度检测的技术核心是什么?

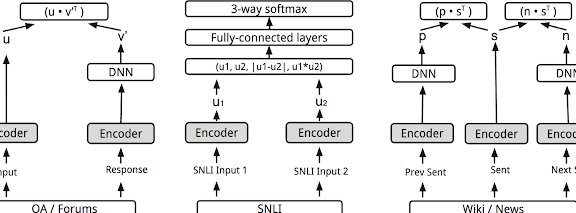

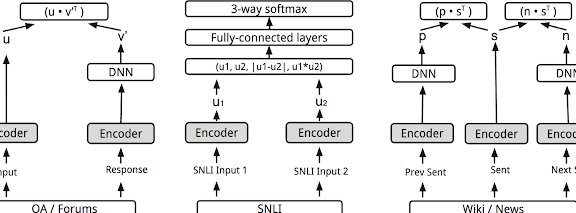

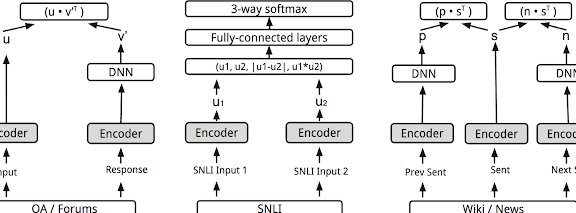

很多人以为文本相似度检测就是数数两个句子里有多少相同的词,这种理解早就过时了。现在主流的 AI 解决方案,比如基于 BERT、GPT 系列的模型,用的是语义向量比对技术。简单说,就是把文字转换成计算机能理解的 "数字向量",通过计算这些向量的夹角来判断语义相似度。

举个例子,"这本书很有趣" 和 "这本读物十分吸引人",关键词重复率很低,但 AI 能识别出它们在语义上高度相似。反过来,"他打了一场球" 和 "他参与了一场诉讼",虽然都有 "一场",但语义向量的夹角很大,AI 会判定为低相似度。这种技术进步,让检测结果终于跳出了 "文字表面",触及了 "内容本质"。

更厉害的是,现在的工具还能做层级化相似度分析。它不只会告诉你两篇文章整体像不像,还能指出是论点相似、论据相似,还是案例相似。比如你写一篇关于 "短视频运营技巧" 的文章,AI 可能会告诉你,你的第三段论点和某篇爆款文高度相似,但案例部分原创度很高。这种精细化的分析,才是对创作真正有价值的信息。

🚫 别被误导:这些关于 "降重" 的认知都是错的

最常见的误区就是把 "重复率低于某个数值" 当成终极目标。很多人拿到检测报告,就开始疯狂替换同义词、打乱句子顺序,结果改出来的文章读起来磕磕绊绊,逻辑都乱了。这根本是本末倒置 —— 内容的核心价值是传递信息、打动读者,而不是满足某个冰冷的数字指标。

还有人觉得,只要检测不到重复,就是好内容。这就更离谱了。我见过不少洗稿文章,把别人的观点换个说法重新排列,重复率确实很低,但本质上还是在炒冷饭,没有任何新东西。这种内容就算通过了查重,也不会有好的传播效果,搜索引擎也不会给好排名。

更危险的是对 "原创" 的误解。有些创作者认为,原创就是 100% 和别人不一样。但实际上,任何领域的知识都有传承性,完全脱离现有研究和观点的内容,要么是胡说八道,要么是曲高和寡。真正的高质量原创,是在吸收现有成果的基础上,加入自己的独特视角、新鲜案例或者深度分析—— 这恰恰是优秀的 AI 相似度工具能帮你识别的地方。

🔄 如何让 AI 相似度检测成为创作的 "辅助工具",而不是 "紧箍咒"?

把检测环节提前,放在初稿完成后、打磨优化前,效果最好。这时候你对内容还有清晰的掌控力,能根据 AI 的分析结果做针对性调整。比如 AI 提示某部分内容和多篇文章语义重合度高,你就可以思考:是不是这个观点太常见了?能不能换个角度说?或者补充一些别人没提到的细节?

重点看 "相似度来源"。如果相似的部分是行业常识、基础概念,其实不用太在意 —— 总不能每次提到 "SEO" 都要发明一个新说法。但如果是你的核心论点、关键论证和别人高度相似,就得警惕了。这时候可以做个小实验:把相似的原文和你的内容都找出来,对比着读,看看能不能清晰地说出你的内容有什么独特价值。说不出来,就必须改。

用 AI 的 "差异分析" 功能找优化方向。现在好的工具不仅能告诉你哪里相似,还能指出差异点。比如它可能会提示:"与参考文本相比,你的内容缺乏数据支撑" 或者 "此处情感表达较弱"。这些其实就是现成的优化建议,照着补全,内容质量自然就上去了。

🛠️ 主流 AI 文本相似度工具横向对比:选对工具才能事半功倍

市场上的工具大致分两类:一类是专注于学术场景的,比如知网的 AI 检测系统、Turnitin;另一类是面向内容创作的,比如 CopyScape、原创度检测大师,还有一些大厂推出的 API 接口。它们的核心区别在于语义理解的侧重点不同。

学术类工具对 "表述相似度" 更敏感,因为学术写作讲究严谨性,哪怕是同一个观点,用词稍有不同都可能被标红。但这类工具对 "观点创新性" 的判断比较弱,它没法告诉你这个研究是不是真的有新意。

创作类工具更看重 "语义相似度",能容忍合理的引用和表述重合,但对观点抄袭、逻辑模仿更敏感。比如某篇爆款文用 "三个阶段" 分析某个现象,你也用同样的结构、同样的阶段划分,只是换了例子,这类工具就会给出较高的相似度评分 —— 这恰恰是内容平台最忌讳的 "套路化抄袭"。

另外要注意工具的 "数据库覆盖范围"。有些工具只收录了中文内容,检测英文内容就不准;有些侧重新闻资讯,对专业领域的内容识别能力弱。选工具的时候,最好先看看它的数据库说明,或者用已知的相似文本做个测试,确保它能覆盖你的创作领域。

📈 如何评估 AI 相似度解决方案的实际效果?别只看数字

看它能不能识别 "改写型抄袭"。有一种常见的抄袭手段,就是把别人的文章拆成短句,逐句替换同义词,再重新拼接。低级的检测工具会认为这是原创,但好的 AI 应该能识破这种把戏,因为句子的逻辑关系、语义流向没变。可以用这种改写后的文本测试工具,能识别出来的才是真本事。

看 "误判率" 高不高。有些工具太敏感,把正常的引用、通用表述都标为高相似,用起来特别费劲。判断误判率的简单方法:找一篇你确定是原创的文章,用工具检测,如果它标出的高相似部分大多是常识性内容或者合理引用,说明误判率太高,不适合长期用。

看有没有 "建设性反馈"。只给一个相似度百分比的工具价值有限,好的工具应该能告诉你:相似内容分布在哪些段落?主要相似点是什么?和哪些类型的文本相似?甚至给出修改建议。这些信息才是能帮你提升内容质量的关键。

🔮 未来趋势:AI 文本相似度解决方案会往哪个方向发展?

多模态相似度检测肯定是重要方向。以后的内容不会局限于文字,图文、视频脚本、音频转写文本之间的相似度也需要检测。比如有人把别人的视频文案改成图文,或者把一篇爆款文章做成视频脚本,这种跨形式的 "搬运",未来的 AI 应该能识别出来。

结合 "内容价值评估" 是必然趋势。单纯的相似度检测只能告诉你 "像不像",但不能告诉你 "好不好"。下一代工具应该能把相似度分析和内容质量评分结合起来,比如:"这段内容与已有文本相似度 30%,但补充了新数据,整体价值提升 20%"—— 这样的反馈才真正有指导意义。

个性化阈值设置会更灵活。不同平台、不同领域对相似度的容忍度本来就不一样。比如新闻报道,对事实陈述的重合度容忍度高;而观点评论,对论点相似度的要求就更严格。未来的工具应该能让用户根据自己的场景,自定义相似度的判断标准和权重。

说到底,AI 文本相似度解决方案的终极价值,不是给内容套上枷锁,而是帮创作者打开思路。它就像一面镜子,让你清楚地看到自己的内容在整个信息生态中的位置 —— 哪些地方是重复的噪音,哪些地方是独特的亮点。

用好这面镜子,你就不会再为 "重复率" 焦虑,而是会专注于创造真正有价值的内容。毕竟,内容的生命力从来不是来自 "和别人不一样",而是来自 "对别人有价值"。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】