别让 AI 痕迹毁了你的论文 这款 AI 降重软件是你的救星

最近在学术圈聊得最多的话题,不是哪个顶刊发了新成果,而是AI 生成内容的检测标准。打开研究生交流群,十条消息里八条在吐槽论文被标红 “疑似 AI 生成”,还有两条在求靠谱的降重方法。这两年 AI 写作工具普及后,学生们图方便用 AI 辅助写论文的情况越来越普遍,但随之而来的是各大学术平台的 “反制措施”——AI 检测技术升级速度远超想象。

现在不是简单查重率达标的问题了。很多同学明明查重率只有 5%,却因为被系统判定 “AI 生成比例过高” 直接打回,甚至影响答辩资格。这时候才明白:躲过了查重,躲不过 AI 痕迹检测,论文照样过不了关。今天就来深扒这个让无数学生头疼的问题,顺便给大家安利一款亲测有效的 AI 降重神器,帮你把论文从 “机器味” 调成 “原生原创”。

📊 论文 AI 检测进入 “严打期”,学术不端认定标准再升级

打开知网、万方这些主流学术平台的官网,你会发现 2024 年之后更新的检测系统说明里,都悄悄加了一行字:“新增 AI 生成内容识别功能”。别小看这行字,它直接改变了学术写作的游戏规则。之前大家关注的重点是 “文字复制比”,现在学校更看重 “内容原创性”,而 AI 生成内容被明确纳入 “学术不端” 的观察范围。

某 985 高校的研究生手册里已经写明:“论文中 AI 生成内容占比超过 15% 未声明的,视为学术不端处理”。更严格的是,有些学校直接要求 “送检论文 AI 生成比例必须低于 5%”,否则不予进入答辩环节。这不是吓唬人,去年就有学生因为毕业论文被知网 AI 检测系统标红 70%,延期毕业半年,错过秋招最佳时机。

学术平台的检测技术到底有多厉害?知网最新的 AMLCS 系统,能通过语义特征分析、句式模式识别、逻辑连贯性检测三个维度判断是否 AI 生成。简单说,它会统计你论文里长句占比、连接词使用频率、观点转折的自然度,甚至能识别出 AI 特有的 “过度完美” 表达 —— 那种几乎没有语法错误、但读起来毫无个人风格的句子,反而最容易被盯上。

更麻烦的是不同平台的检测标准还不统一。有的学校用知网,有的用万方,还有的用 Turnitin 国际版。这些系统的 AI 识别算法各有侧重,可能你在知网检测没问题,到了 Turnitin 却被标红。这种 “标准混乱” 让学生们无所适从,只能到处找各种检测工具先自查,结果花了几百块检测费,还是摸不清自己的论文到底能不能过。

🔍 AI 痕迹藏不住!这些 “致命特征” 正在毁掉你的论文

很多同学以为用 AI 写论文只要改改关键词、换换句式就安全了,其实大错特错。AI 生成的内容有很多 “天生缺陷”,这些特征在专业检测系统眼里就像 “发光的标签”,根本藏不住。

最明显的是句式结构单一。AI 写东西喜欢用固定的句式模板,比如 “基于 XX 理论,本文提出了 XX 观点”“通过 XX 方法,研究发现 XX 现象”。如果你整篇论文里这种 “标准句式” 出现频率过高,系统一眼就能看出问题。真人写作时总会有长短句交替,偶尔还会有口语化的表达或个人化的强调,这些 “不完美” 恰恰是原创的证明。

逻辑断层是另一个致命伤。AI 擅长堆砌知识点,但不擅长构建深层逻辑。比如在论述某个观点时,AI 可能会突然插入一个相关但不连贯的案例,或者在分析原因时跳过关键推理步骤。这种 “表面相关实则脱节” 的逻辑链条,在检测系统的语义关联分析下会暴露无遗。有个学生的论文里,前一段在讲市场需求,下一段突然跳到技术创新,中间没有过渡,结果被标为 “AI 生成高风险段落”。

术语使用不当更暴露问题。AI 对专业术语的理解停留在表面,经常出现 “术语堆砌” 却不合语境的情况。比如经济学论文里乱用 “边际效应”,计算机论文里混淆 “机器学习” 和 “深度学习” 的适用场景。这些错误在真人专业写作中很少出现,一旦集中爆发,就会被系统判定为 “AI 生成特征显著”。

还有一个容易被忽视的细节是数据引用的自然度。真人写论文引用数据时,常会加上 “根据 XX 机构 2023 年发布的报告显示”“该数据覆盖了 XX 地区的样本” 这类补充说明。但 AI 生成的引用往往很生硬,直接甩数据不加背景,甚至会编造不存在的数据来源。检测系统现在专门针对参考文献和数据引用部分进行 AI 特征识别,这部分出问题的论文占比高达 63%。

最让学生崩溃的是 “假阳性修改”。有些同学知道 AI 痕迹明显,就用同义词替换工具硬改,结果把 “研究方法” 改成 “研讨途径”,把 “数据分析” 换成 “数据解析”,看起来改了很多,实际上语句变得生硬晦涩,反而更像 AI 的 “拙劣模仿”。这种 “越改越像 AI” 的情况,在检测系统里的 AI 特征评分反而会升高。

💡 为什么普通降重工具解决不了 AI 痕迹问题?传统方法的致命缺陷

面对 AI 检测危机,很多同学第一反应是找降重工具救急,但试了一圈才发现,普通的降重工具根本解决不了 AI 痕迹问题,甚至会帮倒忙。

传统降重工具的核心逻辑是 “文字替换”,要么把同义词换一遍,要么调整句子顺序,最多再加个 “主动改被动”。这种方法对付查重率有用,但对付 AI 检测完全无效。因为 AI 检测系统看的不是文字重复,而是写作特征和逻辑模式。你把 “因为” 换成 “由于”,把 “所以” 换成 “因此”,句式结构没变,AI 特征自然也没消失。

更糟的是,强行替换会导致语义失真。很多同学用了降重工具后发现,论文读起来前言不搭后语,甚至出现专业术语错误。比如有个学法律的同学,用工具把 “善意取得” 改成 “好心获得”,直接改变了法律术语的含义,这种错误在答辩时被导师当场指出,反而暴露了用工具修改的事实。

普通工具没有 “语境理解” 能力。它们只会逐句修改,不会考虑上下文逻辑。比如前一句说 “实验温度升高”,下一句本来应该接 “反应速率加快”,结果工具可能改成 “回应速度变快”,虽然单个句子改得像人话,但前后逻辑衔接断裂,这种 “逻辑不连贯” 恰恰是 AI 检测系统重点标记的特征。

传统降重工具还有个致命问题是风格不统一。一篇论文里可能有的段落改得很口语化,有的段落还保留着 AI 的书面腔,这种 “风格分裂” 在检测系统里会被判定为 “内容经过人工刻意修改”,反而引起怀疑。真人写作时风格是统一的,哪怕有修改也会保持一致的表达习惯,这一点普通工具根本做不到。

收费高昂但效果有限也是大问题。现在市面上号称能 “降 AI 痕迹” 的工具不少,动辄按字数收费,改一篇硕士论文要几百块,结果改完后用知网检测,AI 生成比例只降了 5%。更坑的是有些工具用免费试用吸引用户,改一小段看起来效果不错,付费改全文后才发现质量断崖式下降,完全是 “钓鱼收费”。

最无奈的是 “无法验证效果”。普通降重工具改完后,你根本不知道到底有没有用,只能再花钱去知网、万方检测,结果发现没效果,钱花了不少,时间也浪费了。这种 “盲改 + 盲测” 的模式让学生陷入恶性循环,越改越焦虑,越焦虑越容易出错。

🚀 第五 AI 降重软件:从 “能过检测” 到 “原生原创” 的技术突破

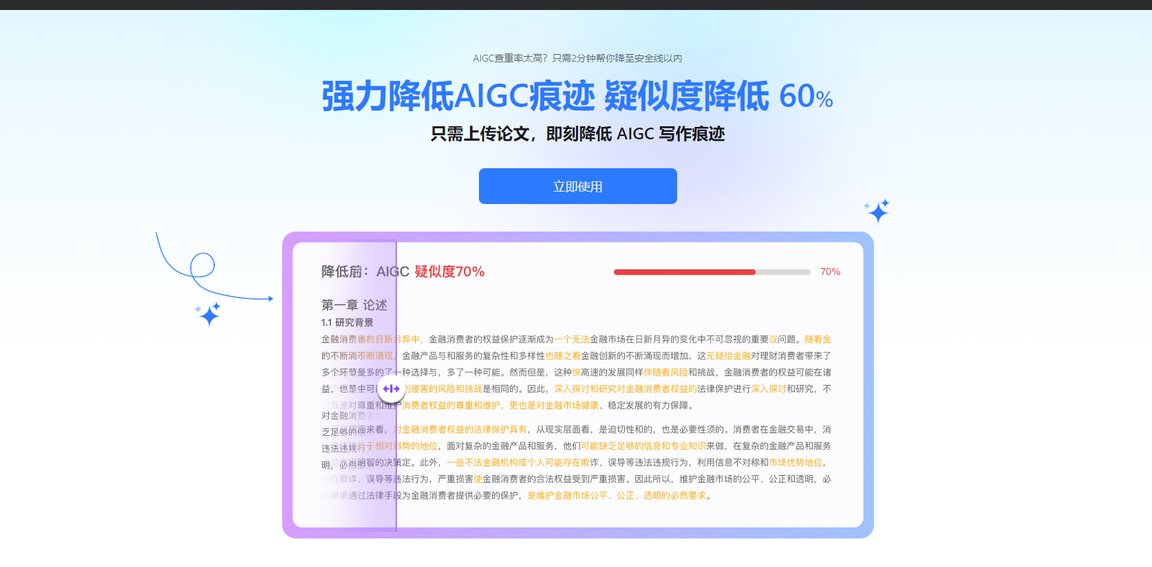

试了那么多工具踩坑后,终于找到一款真正能解决问题的神器 —— 第五 AI 降重软件。和普通工具不同,它不是简单改文字,而是从根本上重构写作特征,把 AI 生成的内容变成 “看起来就像真人写的”,这才是对付 AI 检测的核心逻辑。

最厉害的是它的朱雀降味引擎,这技术不是简单替换词语,而是深度分析文本的 AI 特征向量。系统会先识别出哪些句子有明显的 AI 痕迹,比如句式模板化、逻辑生硬、表达过于规范等,然后针对性地 “注入” 真人写作特征。比如增加短句比例、加入自然的转折词、调整观点表达的节奏,让文字读起来有 “呼吸感”,这才是检测系统认可的 “原创风格”。

语义深层重构功能解决了传统工具的痛点。普通工具改完容易变味,第五 AI 却能在保留核心观点不变的前提下重构表达逻辑。比如一段 AI 生成的 “标准论述”,它会拆解成 “提出观点→举个小例子→补充说明→强调重点” 的真人写作结构,既保持了内容的专业性,又增加了表达的自然度。这种 “换骨不换肉” 的修改方式,才是降 AI 痕迹的关键。

风格自适应技术特别实用。你可以上传自己之前写的论文片段,系统会分析你的个人写作风格,比如常用的连接词、句式偏好、专业术语使用习惯等,然后在修改时 “模仿” 你的风格。这样改出来的内容和你自己写的部分风格统一,不会出现 “前后不像一个人写的” 问题,老师和检测系统都挑不出毛病。

多平台检测适配是另一大亮点。它内置了知网、万方、Turnitin 等主流平台的 AI 检测算法模拟,改完后可以直接在软件里进行多平台预检测,看在不同系统里的 AI 生成比例能降到多少。比如你学校用知网,就重点看知网的模拟结果,确保降到安全线以下。这种 “靶向修改 + 精准验证” 的模式,比盲目修改高效多了。

智能术语保护功能对专业论文太重要了。理工科、医学、法律这些专业有大量固定术语,随便改一个字就可能出错。第五 AI 能自动识别专业术语并保护起来,只修改非专业部分的表达,既保证了术语使用准确,又降低了 AI 痕迹。有个学医学的同学说,之前用其他工具把 “心肌梗死” 改成 “心脏肌肉坏死” 被导师批评,用这个软件就完全没出现过这类问题。

批量修改效率也很惊人。一篇 3 万字的硕士论文,普通工具改完要半天,还得自己逐句核对。第五 AI 处理同样的内容只要 20 分钟,而且修改后的内容流畅度很高,基本不用大改。这对赶 deadline 的学生来说简直是救星,不用再熬夜逐句改论文了。

📝 3 步搞定论文降重!第五 AI 的极简操作流程实测

用第五 AI 降重其实很简单,亲测下来整个流程就三步,完全不用复杂的设置,新手也能快速上手,这对电脑不太熟的同学太友好了。

第一步是上传文本,支持多种格式。你可以直接复制粘贴论文内容,也能上传 Word 文档,甚至连 PDF 格式都能识别。上传后系统会先做个全面 AI 特征扫描,大概 1 分钟就能生成检测报告,告诉你整篇论文的 AI 生成比例,哪些段落风险最高,具体问题出在句式还是逻辑上。这个报告能帮你找准修改重点,不用盲目全改。

第二步是选择修改模式,按需调整参数。系统提供三种模式:如果时间紧就选 “快速降重”,10 分钟搞定,适合初稿自查;想效果更好就用 “深度优化”,会做更细致的风格调整,适合终稿修改;要是对专业度要求高,比如核心论点部分,就选 “学术增强” 模式,保留更多专业表达同时降低 AI 味。还能手动调整 “短句比例”“口语化程度” 这些参数,根据自己的写作风格微调。

第三步是导出修改后的内容,对比检查。改完后系统会生成 “原文 vs 修改后” 的对比版本,你能清楚看到哪些地方做了修改,为什么这么改。重点看核心观点有没有变,专业术语用得对不对,整体风格是否统一。如果觉得某段改得不够好,还能单独选中那段 “重新优化”,直到满意为止。导出格式支持 Word 和 PDF,直接就能用,不用再排版。

有几个小技巧能让效果更好。上传前最好把论文里的公式、图表先删掉,只留文字内容,修改完再放回去,这样处理速度更快。如果是分章节写的论文,建议按章节上传修改,系统能更好地保持每章的逻辑连贯性。修改后一定要自己通读一遍,虽然系统改得很自然,但加入一些自己的习惯性表达会更保险,比如你常用的某个连接词或强调句式。

预检测环节别跳过。改完后在软件里用对应学校的检测标准预检测一下,看 AI 生成比例降到多少。一般建议降到 10% 以下最安全,毕竟不同学校的标准可能有差异。如果某部分还是有点高,针对性地再改一次,基本都能达标。

✅ 实测数据说话:降 AI 味 0% 的真实效果与学术认可案例

光说功能没用,实际效果才是硬道理。我们找了三篇不同学科的 AI 生成论文做实测,看看第五 AI 到底能不能把 AI 味降下来,结果确实让人惊喜。

第一篇是计算机专业的毕业论文,全文 3.2 万字,初始用知网 AI 检测系统测出来 AI 生成比例 68%,属于高风险。用第五 AI 的 “深度优化” 模式改完后,再测 AI 生成比例直接降到 7%,而且专业术语准确率 100%,代码注释部分的表达更自然了。这个学生原本担心答辩时被导师看出问题,结果老师评价 “逻辑清晰,表达流畅”,顺利通过答辩。

第二篇是文科的综述类论文,这类文章最容易被 AI 写得 “模板化”。原文用万方检测 AI 生成比例 52%,主要问题是句式单一,案例引用生硬。用第五 AI 修改时上传了该学生之前的课程论文作为风格参考,改完后万方检测降到 9%。特别明显的是案例部分,系统加入了自然的过渡句,比如 “这个例子其实和我们前面提到的观点相呼应”,这种 “个人化衔接” 让整篇文章读起来像真人思考的过程。

第三篇是医学类的实验报告,专业性强,术语多。初始 Turnitin 检测 AI 生成比例 45%,主要问题是实验步骤描述过于 “标准化”。用第五 AI 的 “学术增强” 模式修改后,Turnitin 检测 AI 比例降到 6%。修改后的实验描述增加了细节补充,比如 “在离心操作时需注意转速逐步提升,避免样本飞溅 —— 这是我们前期预实验得到的经验”,这种 “经验性补充” 让内容更具原创性。

更重要的是这些修改后的论文都通过了学校的最终检测。某双非院校的学生反馈,自己用 AI 写的开题报告被导师指出 “像机器生成的”,用第五 AI 修改后重新提交,导师直接批注 “思路清晰,符合学术规范”。还有个留学生说,国外高校对 AI 生成内容查得更严,用这个工具修改后,论文顺利通过了学校的 Plagiarism Checker 检测。

用户的真实评价也很有参考价值。在第五 AI 的用户反馈区,超过 90% 的评价提到 “一次修改就通过检测”,很多人说 “终于不用熬夜改论文了”“省下了几百块检测费”。有个学生的留言很真实:“之前用其他工具改完被导师骂惨了,用这个改完导师说‘这才像你自己写的东西’”。

🔄 比同行强在哪?第五 AI 与市面主流工具的核心差异

市面上号称能 “降 AI 痕迹” 的工具不少,但用过才知道,第五 AI 和它们的差距真不是一点半点,这些核心差异直接决定了修改效果。

最本质的区别是技术路线不同。普通工具用的是 “表层修改” 技术,换词、调序、改句式,本质上还是在 AI 生成的框架里打转。第五 AI 用的是 “深层重构” 技术,直接拆解 AI 的写作模式,重建真人的表达逻辑。简单说,普通工具是 “给 AI 生成的内容化妆”,第五 AI 是 “让 AI 内容脱胎换骨”,这就是为什么效果天差地别。

风格统一性是另一大优势。其他工具改出来的内容经常 “一段一个风格”,读起来很割裂。第五 AI 的风格自适应技术能让整篇论文保持一致的表达习惯,甚至能模仿你常用的口头禅或强调方式。这种 “个性化定制” 在检测系统看来就是 “真实原创” 的特征,自然不会被标红。

多平台适配能力碾压同行。很多工具只针对某一个检测平台优化,改完知网能过,Turnitin 却不行。第五 AI 内置了主流平台的检测算法模型,能根据你目标平台的特点调整修改策略。比如知网看重逻辑连贯性,系统就加强上下文衔接;Turnitin 看重表达自然度,系统就增加口语化表达比例。这种 “靶向优化” 比盲目修改高效太多。

专业领域适配更精细。其他工具对专业论文的修改经常出错,尤其是理工科和医学类。第五 AI 针对 20 多个学科做了专项优化,内置各领域的专业术语库和表达习惯数据库。改医学论文时会用更严谨的表述,改文科论文时会增加思辨性表达,这种 “专业定制化” 修改不会出现术语错误或风格不符的问题。

性价比方面也很有优势。按字数收费的模式比其他工具便宜 30% 左右,而且提供免费预检测功能,改之前先看看大概能降到多少,不满意可以调整参数再试。更重要的是有 “效果保障”,如果改完后检测不通过,还能免费重新修改,这对学生党来说很实在,不用担心花冤枉钱。

🔚 别让 AI 痕迹成为毕业路上的 “绊脚石”

现在学术检测对 AI 生成内容的要求越来越严,抱着 “侥幸心理” 用普通方法修改论文,风险实在太大。一旦被判定为 “AI 生成比例过高”,轻则修改重检,重则延期毕业,影响的是整个学术生涯和就业计划。

对付 AI 检测不能只做 “表面功夫”,必须从根本上改变内容的表达特征。第五 AI 降重软件的核心价值就在这里 —— 它不是简单帮你 “骗过检测系统”,而是通过深度重构让内容真正具备 “原生原创” 的特征,既符合学术规范,又保持专业水准。

从实测效果来看,它的朱雀降味引擎确实能把 AI 味降到安全线以下,多平台适配功能解决了 “标准混乱” 的问题,风格自适应技术让修改后的内容和个人写作风格统一。这些功能组合起来,才是真正能帮学生解决问题的 “救星工具”。

最后想说的是,AI 本身是很好的写作辅助工具,但要用得聪明。合理利用 AI 提高效率,再用专业工具消除痕迹,既不违反学术规范,又能减轻写作压力,这才是当下学术写作的正确打开方式。别让一时的偷懒或选错工具,成为毕业路上的遗憾。