🔍 金融 AIGC 应用现状:创新与风险并存

🛡️ 伦理风险的核心挑战

- 数据安全与隐私困境

金融数据涉及大量个人敏感信息,AIGC 训练若使用未授权数据或防护机制存在漏洞,可能导致隐私泄露。比如某银行曾因模型被恶意诱导,意外暴露了用户交易记录中的关键数据。此外,数据要素产权不明晰,平台通过模糊授权获取用户信息的现象普遍,用户对数据缺乏掌控权。

- 算法偏见与决策不透明

大模型的 “黑箱” 特性使其决策逻辑难以解释,这在信贷审批等场景中尤为致命。若训练数据存在偏差,模型可能系统性歧视特定群体。某消费金融公司的风控模型就曾因过度依赖历史违约数据,导致小微企业主通过率异常偏低。这种偏见不仅损害用户权益,还会削弱公众对金融机构的信任。

- 合规风险与责任界定

现有监管体系难以跟上 AIGC 的快速演进。当生成内容引发争议时,平台常以 “技术中立” 推诿责任。例如某 AI 客服因错误解答金融政策被投诉,平台却声称无法控制算法输出。此外,跨境数据流动、算法备案等问题也增加了合规复杂度。

- 社会认知与滥用风险

多数用户对 AIGC 技术原理缺乏了解,难以识别虚假信息。某诈骗团伙曾利用 AI 克隆名人声音推荐理财产品,导致数百人受骗。更隐蔽的是,AIGC 可能通过情绪操控诱导消费,形成新型 “数字剥削”。

📜 治理框架:从制度到技术的立体防御

- 监管层:构建全链条治理体系

中国率先建立的 AIGC 标识制度,要求对生成内容添加隐式、显式标识,从源头提升透明度。欧盟 AI 法案则将金融信用评分系统列为高风险应用,强制要求模型具备可解释性并接受第三方审计。监管沙盒机制也被广泛采用,允许金融机构在受控环境中测试创新应用,平衡探索与风险。

- 企业层:嵌入伦理基因

浙商银行建立了涵盖数据治理、算法审查、应用监控的全流程机制,在信贷模型开发前先进行伦理影响评估。德意志银行与 Kodex Al 合作的白皮书提出,金融机构应建立 “可组合生成式 AI” 战略,通过模块化设计降低技术依赖风险。具体操作上,可引入 SHAP、LIME 等工具解析模型决策逻辑,结合联邦学习实现跨机构数据协同而不泄露隐私。

- 技术端:强化安全边界

度小满的攻防对抗框架值得借鉴,通过模拟恶意攻击不断迭代伪造检测系统。在模型训练环节,使用公共语料库替代自有数据可减少偏见,同时引入因果推断技术优化决策逻辑。蚂蚁集团的多智能体协同范式,则通过任务拆分降低单一模型的风险敞口。

- 用户侧:提升数字素养

金融机构需主动科普 AIGC 风险,例如在 APP 中设置 “AI 提示” 标签,明确告知用户哪些内容由算法生成。某银行的 “智能客服使用指南” 就详细解释了 AI 的能力边界,使投诉率下降 30%。监管部门也应推动将 AI 伦理纳入金融从业资格考试,从人才培养端筑牢防线。

🌐 国际经验与中国实践的碰撞

🚀 平衡之道:创新与合规的动态共生

- 风险可控:在智能投顾等关键场景,设置人工复核强制节点,避免算法独断决策。

- 价值导向:将普惠金融、绿色金融等目标嵌入模型优化指标,而非单纯追求商业利益。

- 敏捷治理:建立伦理委员会定期评估技术演进,及时更新治理策略。例如当多模态 AIGC 兴起时,某保险公司迅速修订了反欺诈规则,将视频双录纳入检测范围。

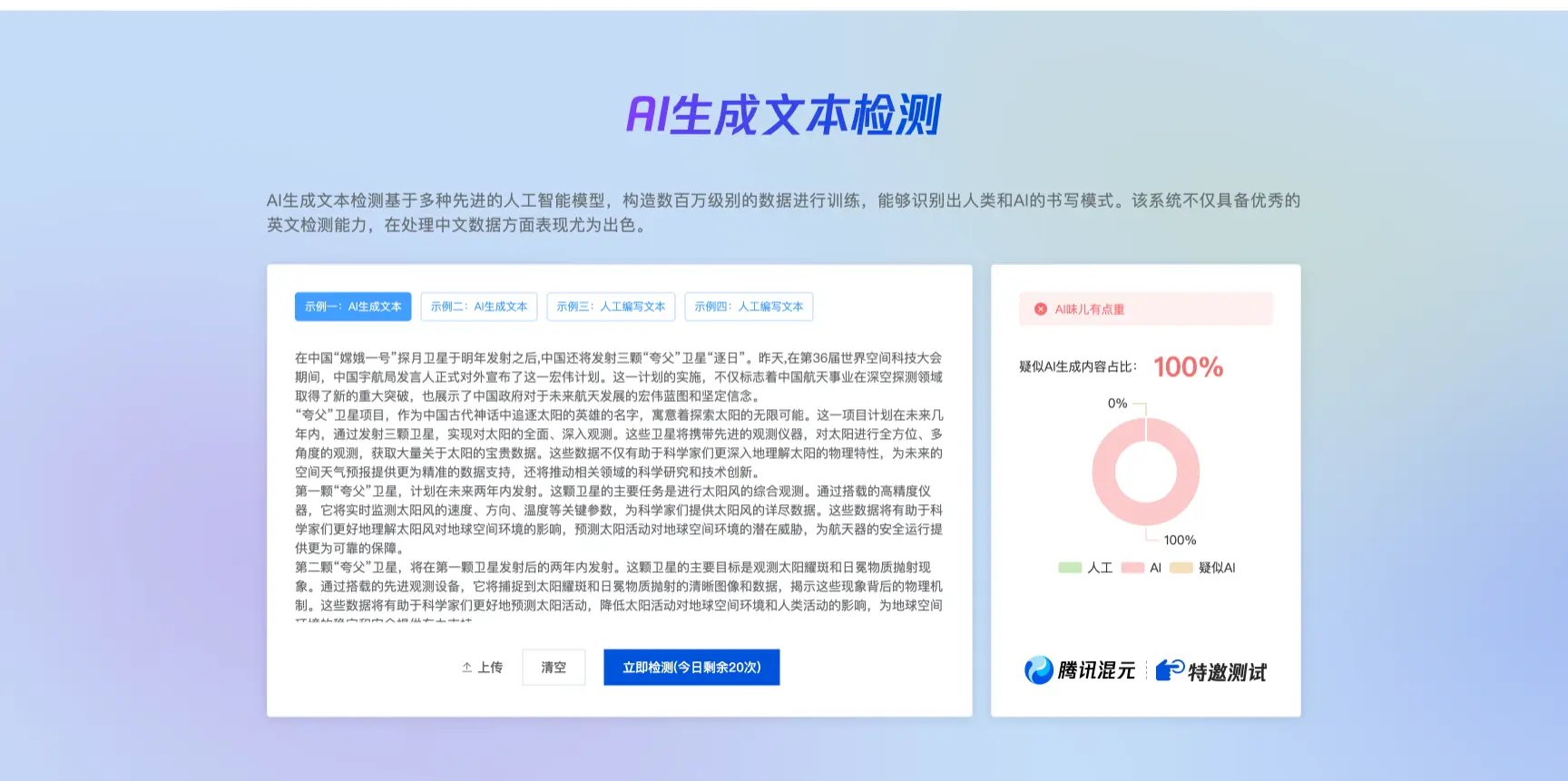

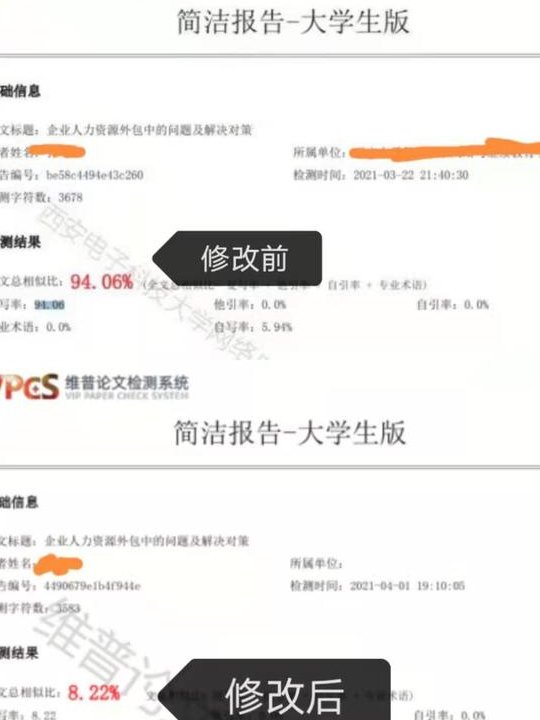

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】