传统 AI 训练依赖固定网络结构,导致计算资源浪费。2025 年的新方法引入动态网络架构,例如 Unsloth 通过动态 4bit 量化技术,在单 GPU 上实现 Llama-3 模型训练速度提升 10 倍,内存占用减少 70%。这种技术通过自动调整模型参数精度,在不损失性能的前提下大幅降低计算量。相比之下,传统模型蒸馏需要手动设计教师 - 学生架构,且压缩率通常不超过 50%。

以医疗影像分析为例,传统方法需在 32 位浮点精度下训练 ResNet-50,耗时 21 小时且占用 48GB 显存。而 Unsloth 的动态量化方案可将模型压缩至 4 位,训练时间缩短至 2.1 小时,显存需求降至 14GB。这种优化不仅适用于大模型,在边缘设备上同样有效 —— 某智能手表厂商通过动态量化将语音识别模型体积缩小 80%,推理速度提升 3 倍。

LoRA(低秩自适应)技术在 2025 年成为主流,通过冻结大部分模型参数,仅训练新增的低秩矩阵,使微调成本降低 90%。例如,MiniMind 项目利用 LoRA 在 3090 显卡上训练 7B 参数模型,总成本仅 3 元,耗时 2 小时。反观传统全量微调,同等规模模型需 512 块 H100 GPU 集群,成本超 2000 万元。

量子计算在 2025 年取得突破性进展,Quantinuum H3 量子计算机将 LLaMA-7B 模型的训练能耗从 78.2 MWh 降至 0.07 MWh,耗时从 21 天缩至 0.3 天。这种 “量子变分电路” 技术通过量子比特的叠加态处理高维数据,使模型复杂度降低 90%。字节跳动的广告推荐模型经量子优化后,训练成本从 370 万元降至 28 万元。

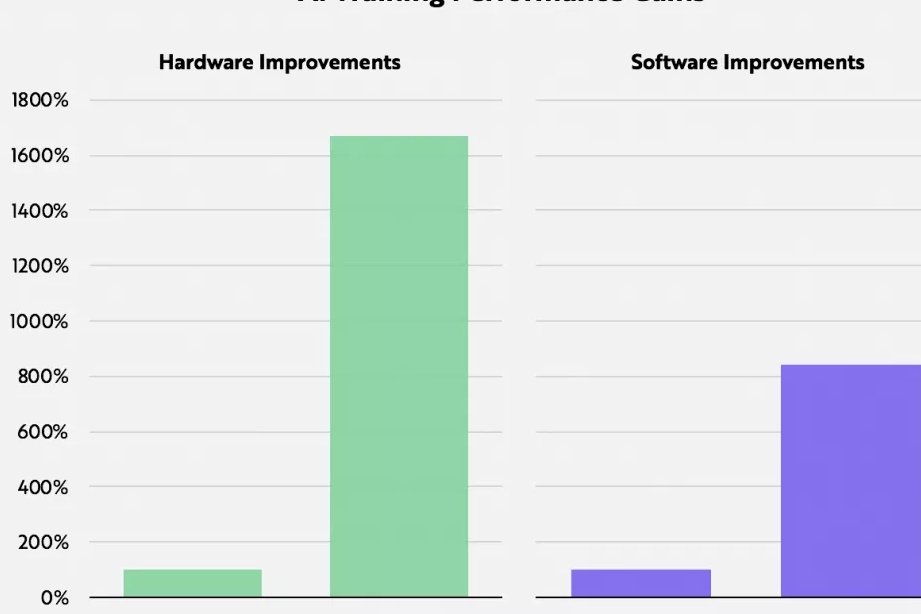

英伟达 Blackwell GB200 计算平台采用 4 纳米工艺,推理性能比前代 H100 提升 30 倍,成本和能耗降至 1/25。华为昇腾 910B 芯片通过异构计算架构,在自动驾驶 BEV 感知模型训练中,使 GPU 利用率从 30% 提升至 65%,总训练成本降低 44%。这些硬件革新与传统 GPU 集群相比,不仅速度更快,还能适应更多复杂场景。

蓝耘智算云平台通过 “按 Token 计费” 模式,将千亿参数模型训练成本降低 42%。其动态资源调度系统可根据任务需求自动分配 GPU/CPU/TPU 混合算力,较纯 GPU 方案节省 23% 成本。这种模式特别适合中小型企业 —— 某中医团队利用该平台训练智能问诊助手,成本仅为自建集群的 1/10。

传统数据预处理依赖人工特征工程,耗时占比超 70%。2025 年的新方法通过自动化数据增强和动态缓存技术,将数据加载延迟从 3.2 秒 /epoch 降至 0.4 秒。例如,蓝耘平台的分布式缓存系统可并行处理多模态数据,使图像 - 文本对齐任务的训练效率提升 41%。

在金融风控场景中,传统方法需遍历全量数据进行特征提取,耗时长达 5 天。而 Search-R1 框架通过强化学习动态筛选关键数据,将反欺诈模型训练时间缩短至 8 小时,准确率提升 12%。这种 “按需检索” 机制使小模型也能实现复杂推理,7B 参数的 Search-R1 在数学问题集上的准确率超过 680B 参数的 R1 模型。

Gemini 2.5 Pro 的 “思维内置” 架构支持 100 万 token 上下文窗口,可同时处理文本、图像和视频数据。在多模态推理任务中,其跨模态准确率达 89.5%,比 GPT-4o 高 3.4 个百分点。这种技术革新使传统单一模态训练的局限性被彻底打破,例如某电商平台通过跨模态训练,商品推荐准确率提升 28%。

传统优化方法(如模型剪枝、混合精度训练)在 2025 年已触及瓶颈。例如,ResNet-50 经 8 位量化后,移动端推理速度提升 3.2 倍,但准确率下降 4.7%。而 Unsloth 通过手写 GPU 内核和动态量化的结合,在提升速度的同时保持 98% 的原始准确率。

以千亿参数模型训练为例,传统方案需 512 块 H100 GPU 集群,耗时 14 天,总成本约 2100 万元。而采用蓝耘平台的动态 Token 计费 + 量子加速方案,成本降至 92 万元,耗时仅 0.3 天。这种差距在中小型项目中更为显著 —— 个人开发者使用 MiniMind 训练 25.8M 参数模型,成本不足一杯奶茶钱。

传统模型因架构固定,每次迭代需重新训练,累计维护成本高昂。而新方法支持增量训练,例如 Search-R1 框架可通过强化学习自动优化推理策略,模型迭代周期从周级缩短至小时级。某教育机构的智能题库系统采用该技术后,每月维护成本降低 70%。

2025 年的 AI 训练正从 “算力垄断” 转向 “普惠化”。MiniMind 等开源项目使普通人也能在个人电脑上训练专属模型,而 Unsloth 的多平台兼容(包括 Windows WSL)进一步降低了技术门槛。与此同时,量子计算与经典计算的混合架构(如英伟达量子加速平台)正在重塑训练范式,使复杂任务的处理效率提升数十倍。

TensorFlow 2.9 和 PyTorch 2.7.1 的更新均强化了分布式训练和模型编译能力,例如 PyTorch 的 torch.compile 功能解决了 HF 大模型的过度录制问题,使训练稳定性提升 35%。这些框架的优化与硬件厂商的深度合作(如 TensorFlow 与 Intel 的 oneDNN 集成)形成了从底层到应用的全栈效率革新。

对于资源有限的企业,蓝耘平台的 “按 Token 计费” 和蜂巢式资源调度提供了灵活选择。某初创公司利用该平台训练个性化推荐模型,成本仅为自建方案的 1/5,且支持随时扩缩容。这种模式正在推动 AI 技术从大型企业向中小微企业渗透,加速行业智能化转型。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味