训练自己的 AI 绘画模型,听起来是不是有点高大上?其实没那么玄乎。只要找对方法,普通人也能玩转。今天就把我踩过的坑、总结的经验全分享出来,手把手教你从 0 开始训练出专属的 AI 绘画模型。

🖥️ 基础硬件与软件准备,别让设备拖后腿

想训练 AI 绘画模型,硬件配置是第一道坎。GPU 性能直接决定训练速度和效果,这不是开玩笑的。入门级至少得有 8GB 显存的 NVIDIA 显卡,比如 RTX 3060;要是想玩得顺溜,RTX 3090(24GB 显存)或者 RTX 4090(24GB 显存)会更舒服。别迷信 CPU,AI 绘画训练主要靠 GPU 算力,CPU 只要不是太老旧就行,内存建议 16GB 以上,避免数据加载卡顿。

软件方面,操作系统选 Windows 10/11 或者 Linux 都行。Linux 在命令行操作上更顺手,适合有一定技术基础的人;Windows 用户可以用 WSL2 模拟 Linux 环境,兼容性还不错。必备工具里,Python 是基础,建议安装 3.9 或 3.10 版本,太新的版本可能和某些库不兼容。然后是 PyTorch,这是深度学习框架,安装时记得选带 CUDA 的版本,才能调用 GPU 加速。

还有个关键工具是 Git,用来拉取开源项目代码。比如 Stable Diffusion 的开源仓库,用 Git clone 就能快速下载到本地。对了,别忘了安装一些依赖库,像 transformers、diffusers 这些,用 pip install 命令就能搞定,不过最好指定版本,避免版本冲突。

📊 数据集的收集与预处理,数据决定模型上限

训练数据就像模型的 “教科书”,质量越高,模型学得越好。首先得明确你想训练的模型风格,是写实人像、二次元插画,还是风景摄影?然后围绕这个主题收集图片。可以从自己拍摄的照片、创作的画作中挑选,也可以从一些免费图库网站找,比如 Unsplash、Pexels,但要注意版权,别用有版权争议的图片。

图片数量不是越多越好,但至少得有几十张,越多模型泛化能力可能越强。不过每张图片都得保证清晰,分辨率建议至少 512x512 像素,模糊的图片会误导模型学习。拿到图片后,预处理步骤不能省。先把图片统一尺寸,用 PS 或者 Python 的 PIL 库批量处理,切成正方形或者固定比例,避免模型学习到奇怪的构图。

然后是打标签,这步很关键。标签要准确描述图片内容,比如 “a girl with long hair, blue dress, standing in a garden, sunny day”。可以用一些工具辅助打标签,像 WD14 Tagger,能自动识别图片内容生成标签,然后自己再手动修改完善。标签越详细,模型越能理解图片的关键特征。另外,要把重复或相似度过高的图片删掉,避免模型过度学习某一类特征,出现过拟合。

还有个小技巧,要是想让模型重点学习某个物体或风格,可以在数据集中多放一些该类别的图片,或者在标签里用括号强调,比如 “(red rose:1.2)”,告诉模型这个元素的重要性更高。预处理完的数据要按比例分成训练集和验证集,一般 8:2 就行,验证集用来监控训练效果。

🧩 模型选择与训练框架搭建,站在巨人肩膀上

没必要从零开始训练模型,现在有很多成熟的开源模型可以微调,比如 Stable Diffusion、Midjourney 的开源替代方案等。Stable Diffusion 是目前最火的,社区活跃,教程多,插件丰富,新手建议从它入手。它的模型文件比较大,基础版 v1.5 大概 4GB 左右,需要提前下载好,放到指定文件夹。

如果硬件配置一般,可以考虑用 LoRA(Low-Rank Adaptation)方法微调,这种方法参数量小,训练速度快,对 GPU 显存要求低,8GB 显存就能跑起来。LoRA 是在原有大模型基础上训练一个小型适配层,既能保留大模型的能力,又能融入新的风格特征,效果很好。

搭建训练框架可以用一些现成的工具,比如 Automatic1111 的 WebUI,里面集成了 LoRA 训练功能,图形化界面操作简单,适合新手。安装好 WebUI 后,在设置里配置好模型路径、数据集路径,选好训练参数就能开始。也可以用更专业的训练脚本,比如 diffusers 库提供的训练示例,通过修改 Python 脚本来自定义训练过程,这种方式更灵活,但需要一点编程基础。

框架搭建好后,先别急着正式训练,找几张图片跑个测试,看看能不能正常加载数据、调用 GPU,输出的中间结果有没有问题。比如训练前先让模型生成一张图片,作为基准,方便和训练后的结果对比。

⚙️ 训练参数设置与过程监控,细节决定训练成败

参数设置是训练的核心,直接影响最终效果。先看学习率,这就像模型学习的 “步长”,太大容易跳过最优解,太小训练速度慢。LoRA 训练的话,学习率一般设在 2e-4 到 5e-4 之间,具体可以根据数据集大小调整,数据少就用小一点的学习率。

批次大小(batch size)取决于 GPU 显存,显存大可以设大一点,比如 4 或 8,显存小就设 1 或 2。迭代次数(epochs)根据数据集大小来,一般几十到几百次不等,可以看验证集的效果来决定,别训练过度。还有图像裁剪尺寸,通常设 512x512 或 768x768,和预处理的图片尺寸保持一致。

训练过程中要实时监控,WebUI 里能看到生成的样本图片,每隔一定步数就会输出一张,通过这些图片能直观判断模型学习情况。如果生成的图片越来越像训练数据的风格,说明训练有效;要是图片越来越模糊或者出现奇怪的噪点,可能是学习率太大或者数据有问题,得及时停下来调整。

另外,要设置检查点(checkpoint),每隔一定步数保存一次模型,万一训练中断,还能从最近的检查点继续,不用从头再来。训练时 GPU 利用率最好保持在 80% 以上,太低说明资源没充分利用,可以调整批次大小;要是利用率 100% 还经常出现显存溢出,就得减小批次大小或者降低图片分辨率。

🔧 模型优化与调试,让你的模型更 “懂” 你

训练完的模型可能不是完美的,需要优化调试。先看看生成的图片有没有明显问题,比如人物五官扭曲、物体比例失调,这可能是数据集里有这类图片,或者训练时学习率没调好。这时候可以检查数据集,删掉有问题的图片,然后降低学习率重新训练几轮。

如果生成的图片风格不稳定,有时候像训练数据,有时候不像,可能是数据集多样性不够,或者训练次数太少。可以增加一些同类风格的图片到数据集,延长训练时间,或者加大正则化力度,比如增加 dropout 参数,防止模型过度拟合。

还有个常见问题是模型 “记混” 特征,比如把猫的耳朵安在人头上,这可能是标签不准确,或者数据集中有混淆的元素。重新检查标签,确保每个标签都准确对应图片内容,把容易混淆的图片分开标注,再重新训练试试。

训练好的模型可以导出成 LoRA 文件,体积小,方便分享和使用。导出后,在生成图片时加载这个 LoRA 模型,调整权重,一般 0.6-0.8 效果比较好,太高可能会让图片失去多样性。多生成几张不同 prompt 的图片,测试模型在不同场景下的表现,不断微调参数,直到达到满意的效果。

🚀 模型的应用与拓展,让个性化创作落地

训练好的模型怎么用?在 Stable Diffusion 的 WebUI 里,加载自己训练的 LoRA 模型,然后输入 prompt,就能生成带有你训练风格的图片了。比如你训练了一个二次元风格的 LoRA,输入 “a cute girl, anime style”,生成的图片就会带有你训练的那种二次元特征。

还可以把多个 LoRA 模型组合使用,创造出更独特的风格。比如把写实人像 LoRA 和油画风格 LoRA 结合,生成油画质感的写实人物。调整每个 LoRA 的权重,能得到不同比例的风格融合效果。

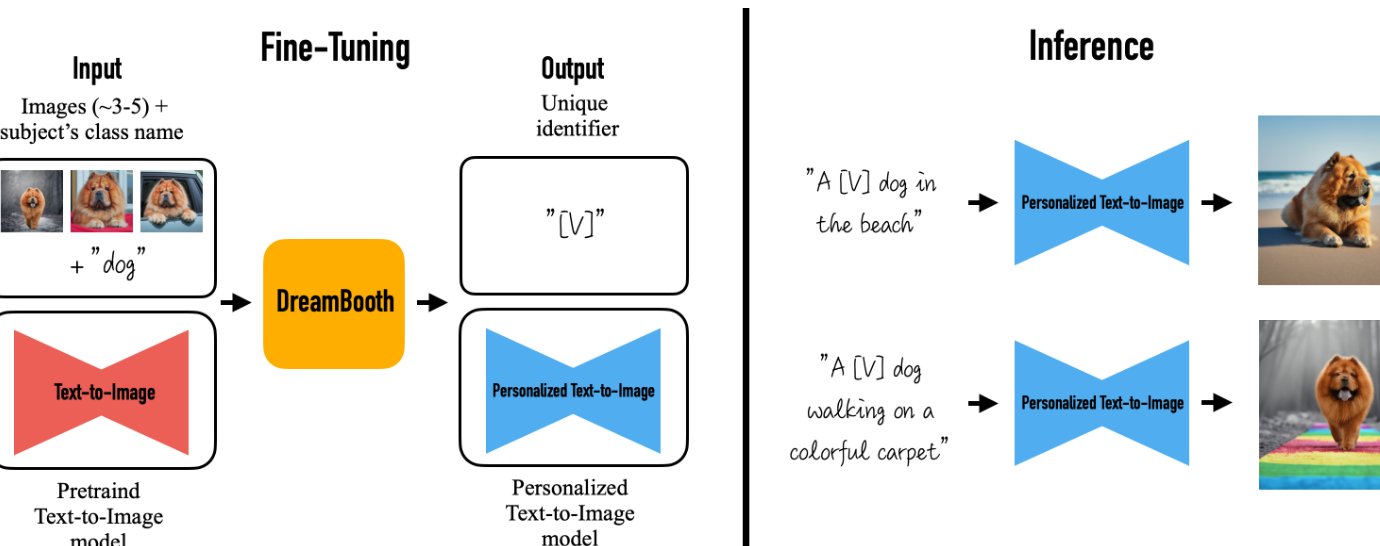

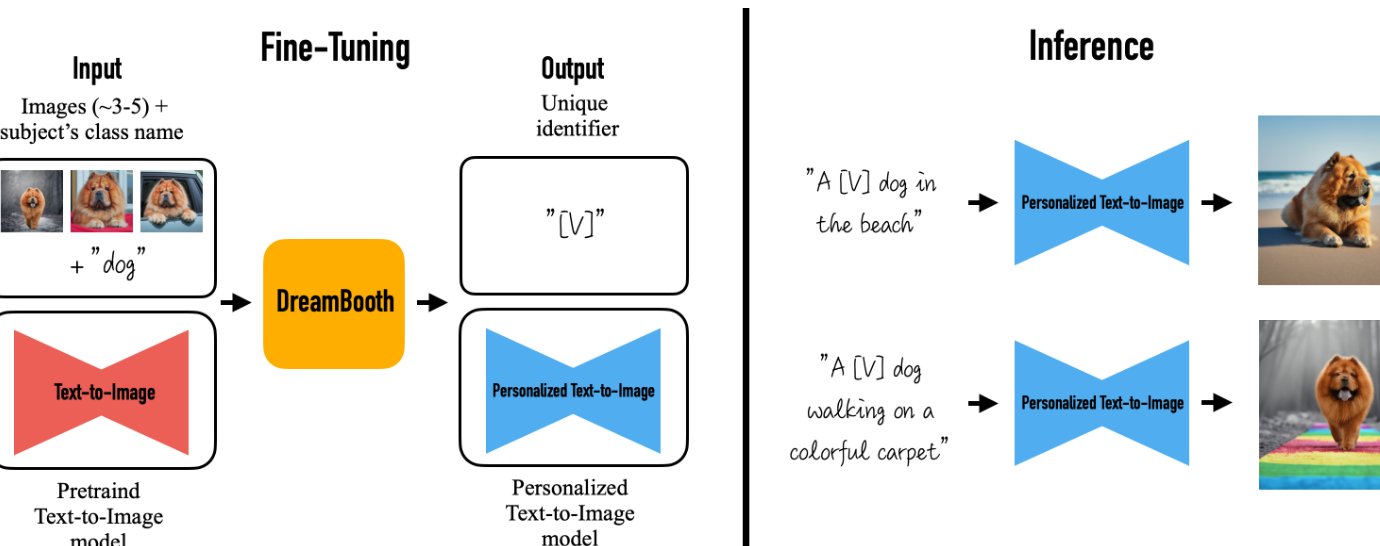

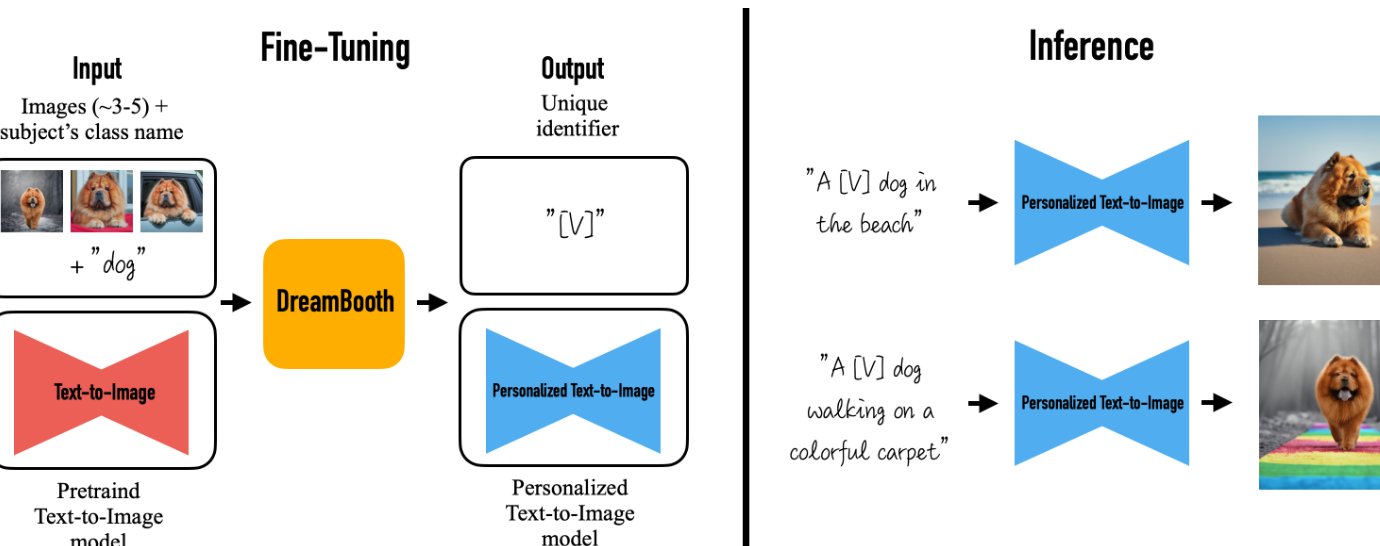

要是想进一步提升模型,还可以进行二次训练。用第一次训练生成的图片作为新的数据集,加上更精细的标签,再训练一次,模型会学得更深入。或者尝试不同的训练方法,比如 DreamBooth,这种方法适合用少量图片训练出特定物体或人物的模型,比如让模型能精准画出你的宠物。

另外,也可以把模型部署到自己的网站或者小程序上,方便随时调用。用 Flask 或 FastAPI 搭建一个简单的 API 接口,接收 prompt 请求,调用模型生成图片后返回,这样就能实现个性化的 AI 绘画服务了。

训练自己的 AI 绘画模型确实需要花点时间和精力,但当看到生成的图片完美呈现出自己想要的风格时,那种成就感是无可替代的。从硬件准备到模型应用,每一步都有技巧,多尝试、多调试,你也能拥有属于自己的个性化 AI 绘画模型。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库