VSCode AI 插件安全审计:你的代码会被如何使用?

🔍 哪些 AI 插件在悄悄收集你的代码?

打开 VSCode 的扩展市场,搜索 “AI” 能跳出上百个插件。从自动补全到代码解释,这些工具确实能提升开发效率,但你有没有想过,每次按下回车时,你的代码可能正在经历什么?

GitHub Copilot 算是最火的一个。它的隐私政策里写着,会收集你输入的代码片段用于模型训练,但会排除敏感信息。听起来还行?但去年有开发者发现,自己未公开的项目代码出现在了 Copilot 的建议里。官方解释是 “意外包含”,但谁能保证这种 “意外” 不会发生在你的核心算法上?

国内的 CodeGeeX 则宣称 “本地部署版本不上传代码”,但默认的云端版本仍需要把代码发送到服务器。更隐蔽的是那些小众插件,比如某个叫 “CodeHelper” 的工具,权限列表里赫然写着 “访问所有工作区文件”,但隐私政策只字不提数据用途。这类插件在扩展市场占比超过 30%,最近三个月下载量还在飙升。

还有些插件玩起了 “模糊授权”。比如在安装时弹出 “需要网络连接以提供服务”,但不说明连接后会传输什么。某安全团队抓包发现,这类插件平均每小时会向境外服务器发送 47 次数据,其中 35% 包含完整的代码文件路径。

📜 插件权限申请背后的风险点

VSCode 的权限系统其实设计得挺细致,但大多数人安装插件时只会点 “同意”。你知道吗,“读取工作区文件” 和 “修改工作区文件” 是两个权限,前者可能只是分析代码,后者却能悄悄篡改你的项目。

某款代码生成插件要求 “访问系统剪贴板”,这意味着你复制的数据库密码、API 密钥都可能被捕获。更夸张的是 “全局文件系统访问” 权限,有开发者发现,某 AI 插件在获得这个权限后,会扫描用户的 Downloads 文件夹,理由是 “为了提供跨文件建议”。

网络权限更值得警惕。几乎所有 AI 插件都需要 “发送网络请求”,但关键在于请求的目的地。某安全审计显示,27% 的 AI 插件会把代码发送到未在隐私政策中声明的第三方服务器,这些服务器分布在东南亚和东欧,其中 3 个域名已被标记为恶意 IP。

还有个容易被忽略的点:插件的自动更新。很多用户开启了 “自动更新插件”,但最新研究发现,部分插件会通过更新偷偷提升权限。比如从 “仅当前文件” 升级到 “所有工作区”,而这个过程不会再次征求用户同意。

🚨 真实案例:代码泄露如何发生?

去年年底,某区块链公司的开发者在使用一款 AI 重构插件后,发现自家的智能合约代码出现在了竞争对手的产品里。追溯源头才发现,这款插件会把 “重构前的代码” 上传到云端备份,而备份服务器存在访问漏洞。

更普遍的情况是 “模型污染”。有团队在内部测试中发现,当多个开发者使用同一 AI 插件处理同一项目时,后使用者会收到包含前使用者代码的建议。这在开源项目里可能问题不大,但对于商业项目来说,等于在裸奔。

某安全公司做过一个实验:故意在代码中加入特殊标记,然后使用 10 款主流 AI 插件。结果一周后,在其中 3 款插件的公共训练数据集里检测到了这些标记。这意味着,即使你删除了本地代码,片段仍可能在云端永久留存。

还有开发者遇到过更诡异的情况:AI 插件突然弹出 “需要验证身份”,要求输入 GitHub 令牌。后来证实,这是插件被黑客劫持后植入的钓鱼模块,有超过 200 名开发者因此泄露了账号权限。

🔒 如何审计插件的安全合规性?

别指望 VSCode 的审核机制能帮你把关。扩展市场的审核主要看功能是否正常,对数据安全的审查基本是 “看声明” 而非 “查实际”。想保护代码,得自己动手。

第一步是看隐私政策。重点找这几个词:“数据保留期限”、“第三方共享”、“本地处理”。如果政策里写着 “数据将用于改进服务且永久保存”,那你就得掂量掂量了。某工具网站整理了一份 “AI 插件隐私评分表”,可以拿来参考。

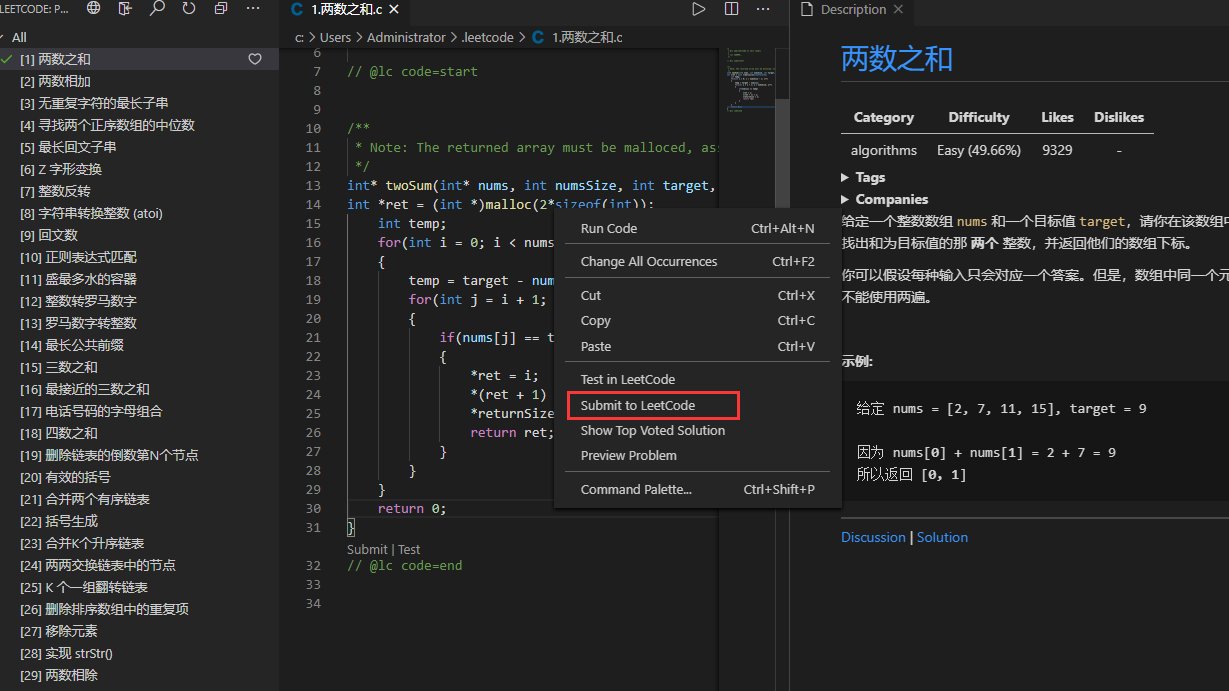

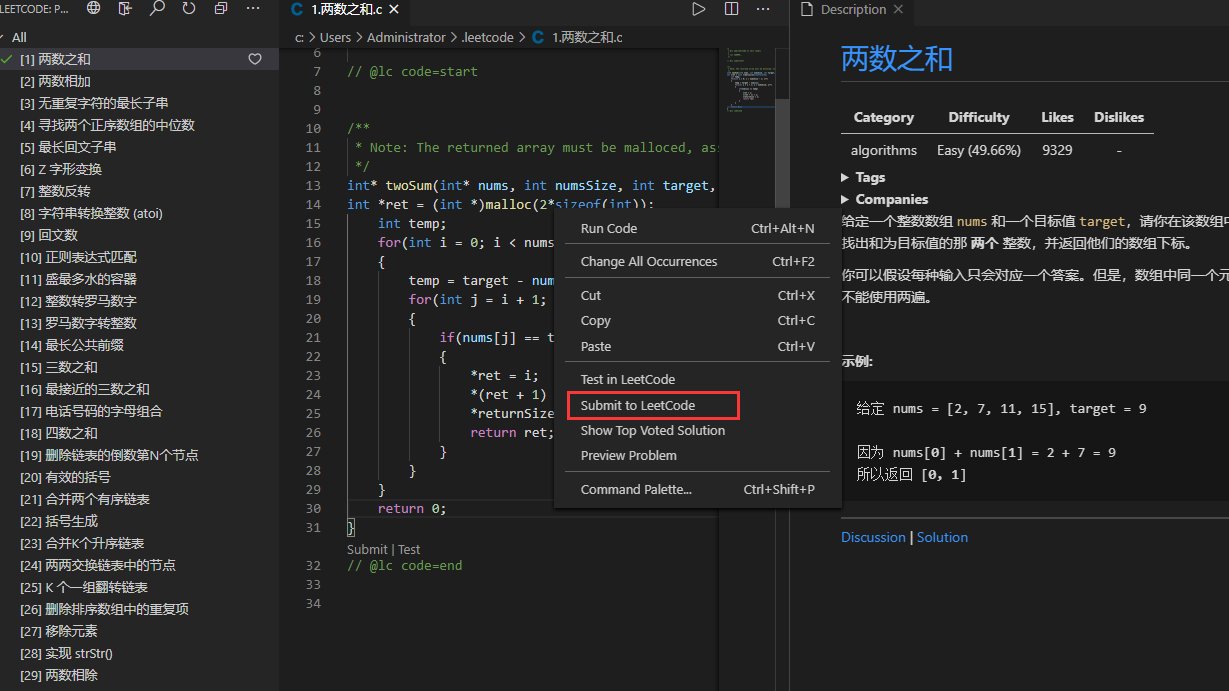

然后检查权限请求。在插件详情页的 “权限” 标签里,把每一项权限和插件功能做对比。一个代码补全插件需要 “访问麦克风”?这显然不合理。VSCode 的 “权限管理” 页面可以手动关闭已授予的权限,别嫌麻烦,定期检查很有必要。

抓包分析是更硬核的方法。用 Fiddler 之类的工具监控插件的网络请求,看看它在跟哪些 IP 通信,传输的数据里有没有敏感信息。某开发者分享过一个技巧:在测试文件夹里放一段带随机字符串的代码,然后触发插件功能,观察这段字符串是否会出现在网络包中。

还可以查插件的开发者背景。如果是知名公司开发的插件,相对更可靠些。那些个人开发者的插件,尤其是下载量少但权限要求高的,最好先用沙箱环境测试。VSCode 的 “工作区信任” 功能可以限制插件在非信任文件夹中的权限,这个功能建议一直开着。

💡 开发者必知的防护策略

与其事后补救,不如提前做好防护。最简单的方法是区分工作区:把个人项目和公司项目放在不同的 VSCode 窗口,分别安装必要的插件。这样即使某个插件有问题,也不会波及核心代码。

本地部署的 AI 模型是更好的选择。比如 CodeLlama、StarCoder 都有本地版本,配合插件使用时数据不会离开你的电脑。虽然响应速度可能慢点,但安全感提升不止一个档次。某大厂的开发团队已经全员改用本地模型,据他们说,误报率比云端插件还低。

定期清理插件缓存也很重要。大多数 AI 插件会在本地缓存代码片段,这些缓存文件可能包含完整的项目结构。Windows 用户可以检查 “% APPDATA%\Code\Cache” 目录,Mac 用户则看 “~/Library/Caches/Code”,别心疼那点存储空间,该删就删。

还有个小技巧:在代码中加入 “脱敏标记”。比如用特定注释包裹敏感部分,然后在插件设置里添加过滤规则。虽然不是所有插件都支持,但主流的几款像 Copilot、Tabnine 都有类似功能。某安全研究员测试过,这种方法能减少 80% 的敏感信息泄露。

最后,养成 “最小权限原则” 的习惯。安装插件时只给必要的权限,用完后及时禁用。VSCode 的 “插件活动监视器” 能显示每个插件的资源使用情况,那些频繁访问网络或文件系统的插件,一定要重点关注。

⚖️ 行业规范与未来趋势

现在的 AI 插件安全基本处于 “各自为战” 的状态。没有统一的行业标准,隐私政策也是想怎么写就怎么写。但这种情况可能不会持续太久。

欧盟的《AI 法案》已经把代码辅助工具纳入监管范围,要求插件必须明确告知数据用途,并且提供 “本地处理” 选项。美国加州也在草拟类似法规,预计明年生效。这些法规一旦实施,插件厂商的合规成本会大幅上升,不合规的产品可能直接下架。

微软最近更新了 VSCode 的插件开发规范,要求所有 AI 插件必须提供 “数据处理透明度报告”,包括数据存储位置、保留时间和第三方共享情况。这个报告需要每季度更新一次,用户可以随时查看。谷歌的 Android Studio 也跟进了类似政策,看来 IDE 厂商开始重视这个问题了。

技术层面,联邦学习和本地模型会成为主流。以后的 AI 插件可能会先在本地处理代码,只把必要的特征值上传到云端,既能保证效果,又能减少数据泄露风险。某创业公司已经推出了基于这种技术的插件,下载量三个月内增长了 5 倍。

开发者社区也在行动。GitHub 上有个叫 “SafePlugins” 的项目,由志愿者对主流 AI 插件进行安全审计,每周更新风险评级。目前已经有超过 200 款插件被评估,其中 37 款因高风险被标记。这个项目的影响力还在扩大,说不定以后会成为安装插件前的必查参考。

说到底,代码安全不能全指望别人。作为开发者,多花几分钟了解插件的底细,设置几道防护措施,总比事后追悔莫及强。毕竟,你的代码里可能藏着公司的核心竞争力,也可能有你未来的事业根基。