🛠️ 各工具的核心能力到底差在哪?

现在市面上的 AI 代码助手看着功能差不多,实际用起来差距能差出一个版本迭代。GitHub Copilot 背靠 OpenAI 的 GPT 模型,对主流编程语言的支持确实没话说,Python、JavaScript 这类热门语言的补全准确率能到 85% 以上。但遇到 Rust、Go 这类相对小众的语言,有时候会出现 “强行补全” 的情况 —— 代码能跑,但冗余得厉害。

GitLab Duo 的优势不在单一语言能力,而在全流程集成。它能直接关联 GitLab 的 CI/CD 流水线,写完代码自动提示测试用例,甚至能生成部署脚本。这对习惯在 GitLab 生态里工作的团队来说,效率提升是肉眼可见的。但它的短板也明显,脱离 GitLab 环境后,补全质量会下降 30% 左右,这点用过的人都有体会。

Amazon CodeWhisperer 最让人惊喜的是AWS 服务的深度适配。调用 S3、Lambda 这些服务时,它给出的代码片段几乎不用改,连权限配置都能帮你考虑到。但它对非 AWS 生态的支持就一般了,比如要对接 Azure 的服务,生成的代码经常缺参数。另外它的免费版有每月 50 次的代码扫描限制,对高频使用者来说不够用。

Tabnine 走的是另一条路,主打本地部署和隐私保护。企业版可以把模型部署在自己的服务器上,代码数据不会上传到云端。这对金融、医疗这类对数据敏感的行业来说是刚需。但代价是模型更新慢,最新的框架特性往往要滞后一两个月才能支持,比如最近很火的 Next.js 14 新特性,它的补全建议还停留在旧版本的写法。

Cursor 编辑器自带的 AI 助手算是后起之秀,基于 GPT-4 训练的模型在上下文理解上很突出。写长函数时,它能记住前面定义的变量和逻辑,补全的代码连贯性比其他工具好。但它的问题是太依赖网络,离线状态下基本没法用,而且对大型项目的支持不如 Copilot 流畅,打开超过 10 个文件后就容易卡顿。

🎯 选工具前必须想清楚的三个场景问题

个人开发者和企业团队的需求简直是两条平行线。自己写代码图个爽,GitHub Copilot 的个人版每月 10 美元不算贵,尤其是学生还能免费领,配合 VS Code 用起来顺手。但要是企业用,就得考虑合规性 ——Copilot 的条款里写着 “可能使用用户代码训练模型”,这对有知识产权要求的公司来说就是个雷区。

前端和后端开发者的偏好也差很远。前端常用的 React、Vue 这些框架,Copilot 和 Cursor 的支持都不错,连 JSX 语法的补全都很精准。后端开发者特别是用 Java、C# 的,可能更倾向于 JetBrains 家的 AI 助手,它能和 IntelliJ IDEA 深度集成,连 Spring 框架的注解都能智能提示。我见过好几个后端团队宁愿多花点钱,也要用对自家技术栈适配更好的工具。

初创公司和大厂的选择逻辑完全不一样。初创公司人少,工具能快速上手最重要,CodeWhisperer 的免费版对小团队很友好,而且和 AWS 的服务搭着用能省不少事。大厂更看重定制化能力,Tabnine 的企业版可以用公司内部代码库训练专属模型,生成的代码风格能和团队现有代码保持一致,这一点是其他工具很难做到的。

还有个容易被忽略的场景是开源项目贡献者。给开源项目提 PR 时,用 Copilot 生成的代码可能会涉及版权问题 —— 去年就有个知名项目明确拒绝接受 Copilot 生成的代码,担心侵犯第三方专利。这种情况下,GitLab Duo 反而更稳妥,它生成的代码会附带开源许可提示,能帮你避开不少麻烦。

💰 定价表背后的那些坑

千万别只看表面价格。GitHub Copilot 个人版 10 美元 / 月,企业版 19 美元 / 月,看似清晰,实际上企业版要额外付管理员账号的费用,算下来 10 人团队每月得 200 多美元。CodeWhisperer 的企业版按用户数收费,每人 19 美元 / 月,但它包含了代码安全扫描功能,这部分在 Copilot 里是要单独买的,算下来未必更贵。

免费版的限制比你想的多。CodeWhisperer 免费版每月能生成代码建议,但高级功能比如安全漏洞检测、自定义模型训练都不能用。Tabnine 的免费版更离谱,只能在一个 IDE 上用,换个编辑器就得重新登录,而且代码补全的长度被限制在 50 个字符以内,写长点的函数根本不够用。

年度订阅和月度订阅的差别不止是价格。Copilot 年度付能省 20%,但中途退订只退剩余月份的 30%,这点在条款里写得很隐蔽。GitLab Duo 是绑定在 GitLab 订阅里的,要想用它的高级功能,至少得买 GitLab Premium,一年下来比单独买代码助手贵不少,但对已经在用 GitLab 的团队来说反而划算。

隐藏成本才是大头。企业用 Copilot 需要自己搭合规审查流程,因为它的训练数据可能包含受版权保护的代码,万一生成的代码侵权,平台可不负责任。这就意味着公司得额外请法务或者买第三方审查工具,这笔钱往往比工具本身的订阅费还高。CodeWhisperer 在这方面好点,亚马逊承诺对生成的代码提供版权保障,但只限于企业版用户。

👥 团队协作里看不见的麻烦

多人协作时,工具的一致性比单个功能强更重要。团队里一半人用 Copilot,一半人用 Cursor,生成的代码风格能差出两代人 —— 一个喜欢用箭头函数,一个习惯用 function 声明,光统一代码格式就得花不少时间。这种情况我建议选能支持团队配置同步的工具,比如 GitLab Duo 可以统一设置代码补全的风格偏好,减少无谓的争论。

权限管理是企业团队的必考题。Tabnine 的企业版能按项目设置不同的 AI 模型,核心项目用私有模型,普通项目用公共模型,数据隔离做得很到位。Copilot 在这方面就比较粗放,要么全公司用一个模型,要么就得单独付费买多实例,对部门多的大公司来说不太友好。

离线协作场景最能看出工具的短板。有时候团队出去团建,在没有网络的地方想改代码,Copilot 直接歇菜,CodeWhisperer 离线模式下只能用基础补全功能,而 Tabnine 因为是本地部署,完全不受影响。我之前带团队在客户现场做交付,就因为网络不好,被迫临时换成 Tabnine,那次之后就把它列为备选工具了。

代码审查时的 AI 痕迹也很麻烦。现在很多团队的 PR 审查流程里,会特意检查 AI 生成的代码 —— 不是反对用,而是怕过度依赖导致逻辑漏洞。GitLab Duo 这点做得贴心,能自动给生成的代码标上注释,审查时一眼就知道哪些部分是 AI 写的,重点检查这些地方就行,比 Copilot 全靠人工识别省事多了。

📊 四步帮你做出不后悔的选择

第一步,先列清楚非妥协项。比如金融行业必须选支持本地部署的(Tabnine),做 AWS 生态的优先考虑 CodeWhisperer,小团队预算有限就从免费版里挑(CodeWhisperer 免费版或 Copilot 学生版)。把这些硬指标列出来,能排除 80% 的选项。

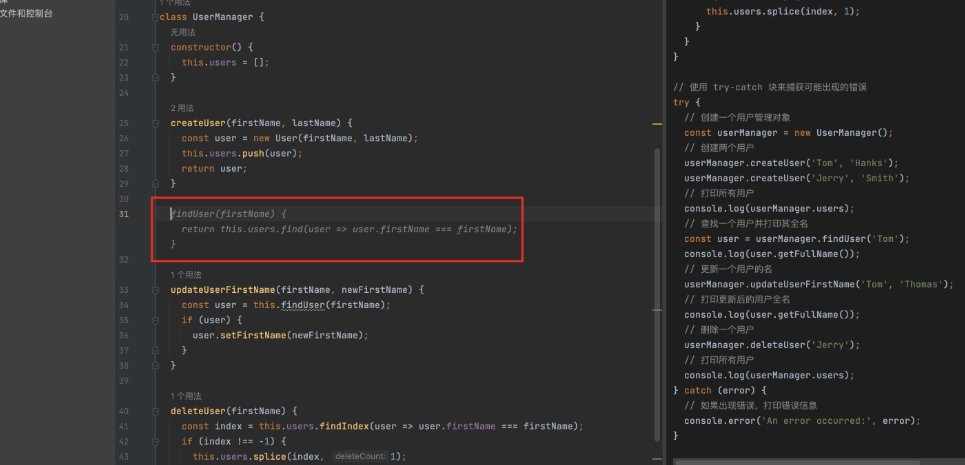

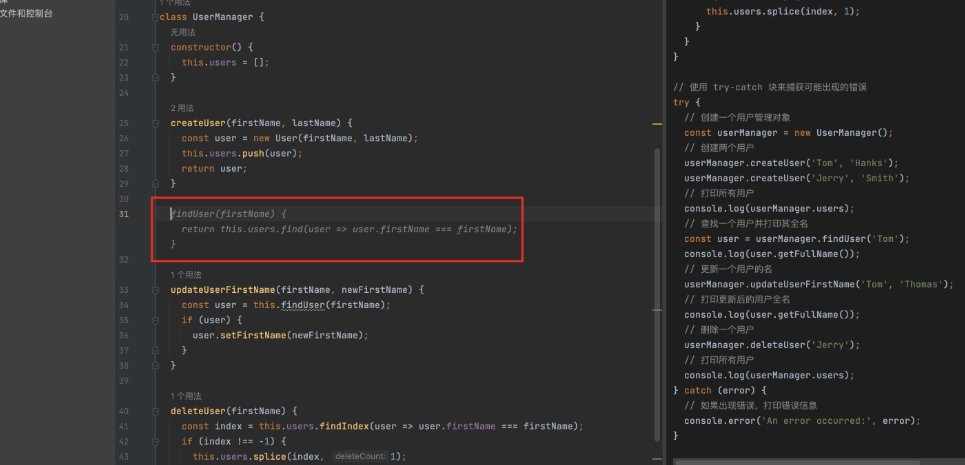

第二步,拿实际项目测试三天。别光看评测,自己写段真实业务代码试试。比如用你常用的框架写个用户登录模块,看看哪个工具生成的代码需要改的地方最少。我之前帮朋友测试时发现,同样写一个 Django 的视图函数,Copilot 要改 3 处,而 Cursor 只需要微调 1 处,但处理复杂的 SQL 查询时,Copilot 反而更精准。

第三步,算清楚三年总成本。不只是订阅费,还要加上培训成本(比如团队适应新工具的时间)、集成成本(和现有系统对接的开发量)、合规成本(数据安全审查的人力)。有个做电商的客户算过一笔账,虽然 Copilot 单价低,但他们为了合规请外部顾问花了三万多,最后反而选了初期投入高但合规性好的 Tabnine。

第四步,留好退路。永远别把宝押在一个工具上,最好主工具之外备一个兼容的备选。比如主用 Copilot 的团队,可以同时装个 Tabnine,万一某天 Copilot 的 API 出问题,还能无缝切换。我见过更稳妥的做法是,核心模块用人工写,重复性代码用 AI 生成,这样就算换工具,影响也有限。

其实选工具就像选 IDE,没有绝对的好坏,只有合不合适。GitHub Copilot 功能全但有合规风险,CodeWhisperer 性价比高但依赖 AWS,Tabnine 安全但更新慢。想清楚自己最缺什么、最怕什么,答案自然就出来了。毕竟工具是为了提高效率,要是选个工具比自己写还累,那才是真的亏了。