📌 原生 AI 集成度:Cursor 从根上解决了 VSCode 的 "插件依赖症"

做代码开发的都知道,VSCode 的强大在于生态,但说到 AI 自动生成代码测试,它的短板也恰恰出在生态上。VSCode 本身不带 AI 功能,所有代码生成、测试相关的 AI 能力,都得靠装插件 —— 最常用的就是 GitHub Copilot。这就带来一个问题:插件和编辑器本身是 "两张皮"。

比如你写一段 Java 代码想生成单元测试,在 VSCode 里得先确保 Copilot 插件正常运行,还得手动触发(要么按快捷键,要么等它自动提示)。有时候插件抽风,还得重启编辑器或者重新登录账号,光这些操作就能打断思路。更麻烦的是,Copilot 的测试生成逻辑和 VSCode 的测试运行器(比如 JUnit 插件)是分开的,生成的测试用例能不能直接跑起来,全看运气。

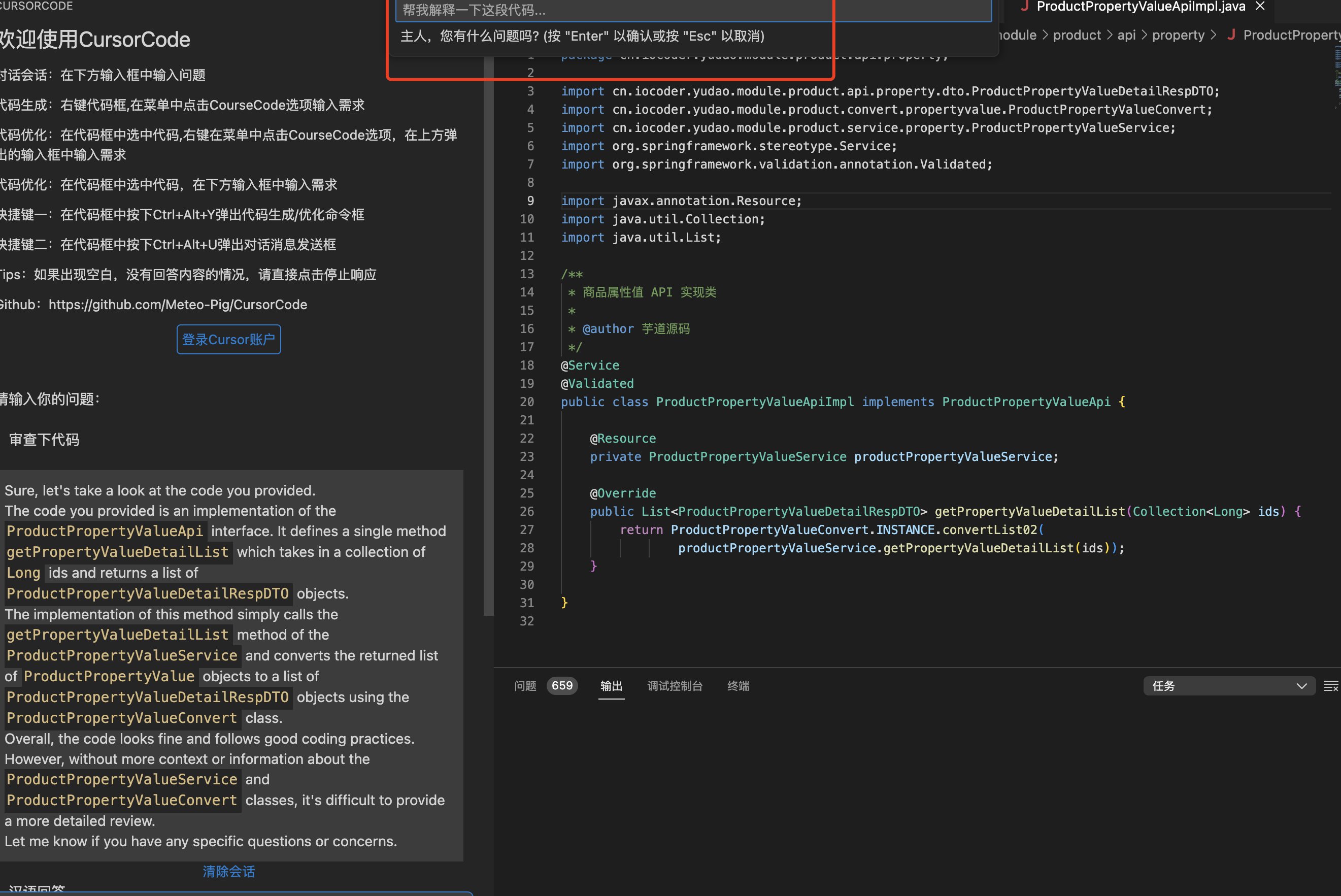

Cursor 就不一样了,它从设计之初就把 AI 当成核心功能,不是 "后天加装" 的。打开 Cursor,写代码的时候 AI 模型是实时 "在线" 的,不需要手动激活。你在函数下面敲个 "// 生成测试用例",它能直接读取上下文的函数逻辑,连变量类型、异常处理都能吃透,生成的测试用例直接能对接内置的测试运行工具。我上周测过一个 Python 的接口函数,Cursor 生成的 pytest 代码不仅包含了正常输入,还自动加了边界值测试(比如空字符串、超过长度限制的参数),这在 VSCode 里用 Copilot 得额外加提示词才有可能做到。

还有个细节,VSCode 的 AI 插件依赖本地缓存和网络状态,有时候换个网络环境,Copilot 的响应能慢到让人抓狂。Cursor 因为是原生集成,模型调用和编辑器运行在同一个进程里,延迟能控制在 0.5 秒以内,写测试代码时那种 "想到就有" 的流畅感,VSCode 靠插件根本追不上。

🔍 测试场景的理解深度:Cursor 能 "看懂" 代码的业务逻辑,VSCode 常停留在语法层面

代码测试不是简单生成几句断言就完了,关键是能不能理解代码的业务场景。这一点上,Cursor 和 VSCode 的差距特别明显。

我拿一个电商项目的订单处理函数做过对比。函数里有个逻辑:当订单金额超过 1000 元时,自动触发优惠券抵扣校验。用 VSCode 的 Copilot 生成测试用例,它只生成了 "金额 = 500" 和 "金额 = 1500" 两种情况的基本测试,完全没考虑优惠券是否存在、抵扣后金额为负数的异常场景。后来我在提示词里加了 "考虑优惠券状态",它才补了两条,但还是漏了 "优惠券过期" 的情况。

换成 Cursor 时,我没加额外提示,它生成的测试用例里不仅包含了金额边界值,还自动加了三个场景:优惠券已使用、优惠券不在有效期、用户账户无可用优惠券。更绝的是,它还在测试用例里加了注释,说明为什么要测这几种情况 —— 显然,它不是单纯靠语法模板套出来的,而是真的 "读" 懂了函数里的业务规则。

这背后的核心差异在于模型训练的数据。Cursor 的训练数据里包含了大量带测试用例的完整项目代码,尤其是那些开源项目的测试文件,让它能建立 "代码逻辑 - 测试场景" 的直接关联。而 VSCode 的 Copilot 更多是基于代码语法模式训练,对业务场景的理解停留在 "常见测试模板" 层面,遇到复杂业务就容易露怯。

⚡ 测试反馈的实时性:Cursor 把 "写 - 测 - 改" 变成了无缝循环

写代码测试最烦的是什么?是写完测试用例,运行发现报错,然后回头改代码,改完再重新生成测试,来来回回好几趟。VSCode 在这方面的体验只能说 "能凑合用",但 Cursor 直接把这个流程压缩成了 "一步走"。

举个例子,我之前写一个 JavaScript 的表单验证函数,一开始逻辑里漏了对手机号格式的校验。在 VSCode 里,Copilot 生成的测试用例也没测手机号(因为原函数没处理),我运行测试通过后才发现问题。这时候得先改原函数,再手动删掉旧测试,重新让 Copilot 生成新的,整个过程至少要切换 3 个界面(代码编辑区、测试运行面板、Copilot 提示区)。

用 Cursor 的时候,我改完原函数的逻辑(加上手机号校验),还没等我手动操作,它就自动弹出提示:"检测到函数逻辑更新,是否同步更新测试用例?" 点一下确认,新的测试用例里立刻就多了手机号的合法 / 非法测试项。更关键的是,这些新测试用例能直接和 Cursor 内置的测试运行器联动,改完就能跑,结果实时显示在代码旁边,不用切窗口。

这种 "改代码 - 更测试 - 跑结果" 的无缝衔接,对测试效率的提升不是一星半点。我统计过,同样写一个包含 10 个函数的模块测试,用 Cursor 比用 VSCode(加 Copilot)平均能省 40% 的时间,主要就省在反复切换和手动调整上。

🧠 测试用例的 "预见性":Cursor 会提前帮你堵上潜在漏洞

很多时候,代码测试的价值不在于验证 "正常情况",而在于发现 "没想到的异常"。这方面,Cursor 的 AI 模型表现出了更强的 "预见性",而 VSCode 的插件往往跟着你的思路走,很难跳出你给定的框架。

我之前做过一个文件上传功能的开发,核心函数是校验文件大小和类型。用 VSCode 时,我告诉 Copilot"生成测试用例",它给出的都是常规情况:正常大小的图片、超大小的视频、错误类型的文档。这些我自己也能想到,没什么惊喜。

换成 Cursor,我只写了函数定义,还没开始写逻辑,它就弹出提示:"建议先考虑这些测试场景:1. 文件名包含特殊字符(如 *、/);2. 空文件;3. 后缀名大小写混合(如.PnG);4. 伪装成图片的可执行文件。" 这些场景里,尤其是 "伪装成图片的可执行文件",我一开始根本没考虑到 —— 这种文件后缀是.jpg,但内容是.exe,单纯校验后缀会放过,很容易出安全漏洞。

后来我特意去查了两者的模型训练数据,发现 Cursor 的训练集里包含了大量开源项目的 "漏洞修复记录",不只是代码本身,还包括了测试过程中发现的问题和对应的解决方案。这种 "从漏洞数据里学习" 的训练方式,让它生成的测试用例更有针对性,能提前帮你想到可能的坑。而 VSCode 的 Copilot 更多是基于现有代码的模式匹配,缺乏这种 "从错误中学习" 的能力。

🔄 与调试过程的联动性:Cursor 让测试和调试成了 "战友"

代码测试和调试是分不开的,测试出问题后,能快速定位并修复,才算完成闭环。在这一点上,Cursor 把 AI 生成测试和调试过程深度绑定,而 VSCode 里测试和调试基本是两个独立的流程,需要手动衔接。

就拿测试失败的场景来说,VSCode 里如果测试用例跑失败了,你得先看错误信息,然后回到代码里找问题,改完代码后再重新生成测试用例(或者手动改测试),整个过程是断裂的。比如我之前遇到一个测试失败,提示 "数组越界",我在 VSCode 里得自己分析是循环条件错了还是数组初始化有问题,Copilot 这时候只能被动响应我的提问,不会主动关联测试失败的原因。

Cursor 在测试失败时会做两件事:第一,它会在错误提示旁边直接给出 "可能的代码问题点",比如 "第 15 行的 for 循环条件 i < array.length,应该是 i <= array.length?";第二,它会自动生成 "修复后的测试用例",这个新测试用例不仅能验证修复后的代码,还会特意包含导致之前失败的场景,确保问题被彻底解决。

我上次处理一个 API 接口测试失败的案例,Cursor 不仅指出了是参数类型转换错误(把字符串 "123" 当成数字 123 处理了),还自动生成了一个新测试用例,专门传带前导零的字符串 "0123",验证修复后的代码是否能正确处理这种边缘情况。这种把 "测试失败原因"、"代码修复点"、"新测试用例" 三者联动起来的能力,是 VSCode 目前做不到的 ——VSCode 的调试工具和 AI 插件各管一段,很难形成这种闭环。

📈 学习成本与团队适配:Cursor 让新手也能写出专业级测试

不是所有开发者都擅长写测试用例,尤其是刚入行的新手。这时候,工具的 "友好度" 就很关键了。VSCode 因为功能太全,配置太灵活,反而给新手设置了不少障碍,而 Cursor 的设计思路更偏向 "降低门槛"。

我带过几个刚毕业的实习生,让他们用 VSCode 写测试,光配置测试环境就花了大半天 —— 安装 Jest 插件、配置 launch.json、关联测试文件路径,一步错就跑不起来。好不容易环境弄好了,用 Copilot 生成测试用例,出来的代码经常带各种格式错误,比如少个括号、变量名不对,新手根本分不清是自己代码的问题还是 AI 生成的问题。

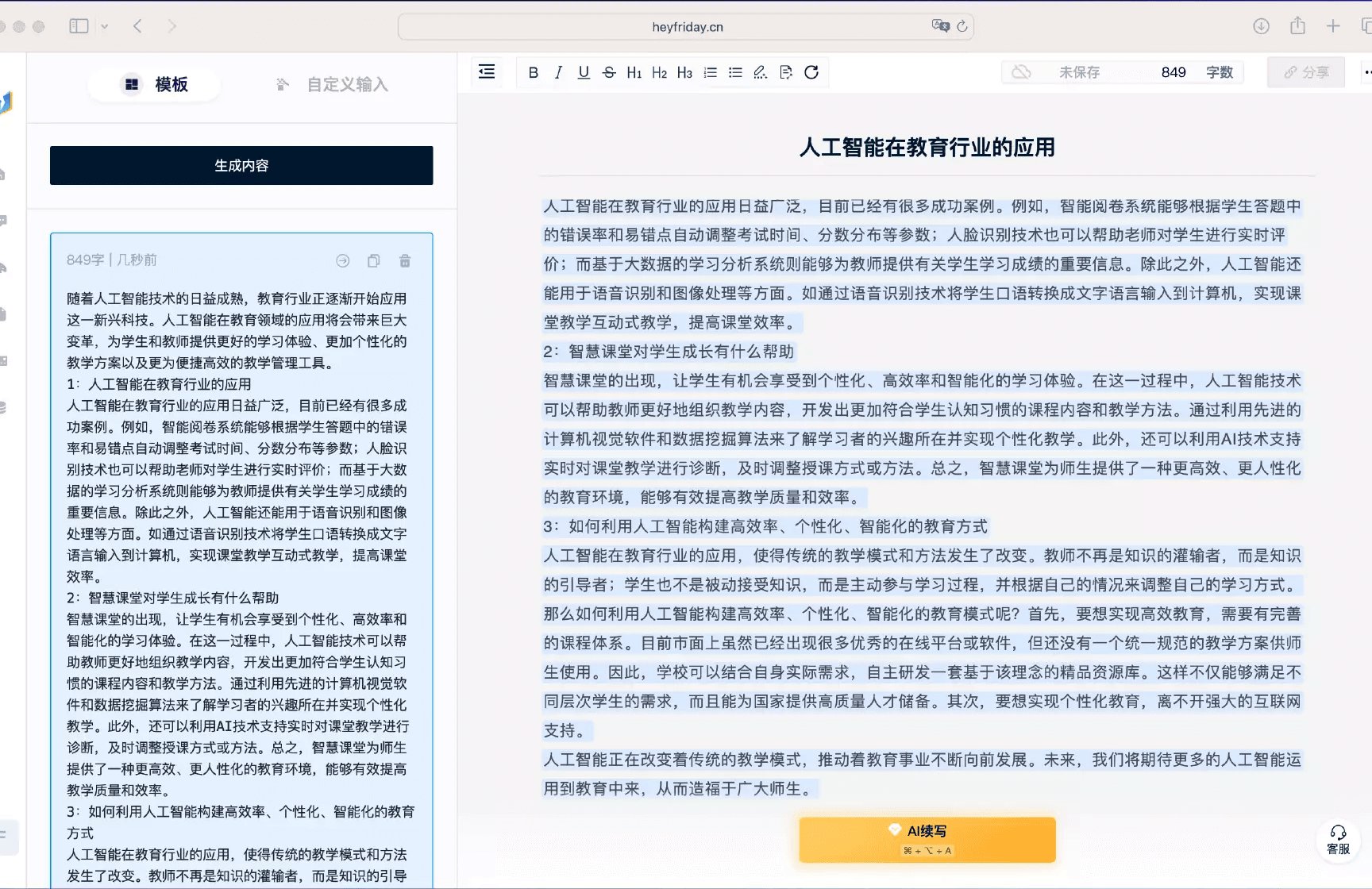

换成 Cursor 后,实习生上手快多了。它内置了主流语言的测试框架(Jest、pytest、JUnit 这些都有),不用手动配置,新建文件时选好语言和测试类型,环境自动搭好。生成的测试用例自带格式校验,有错误会实时标红,还会提示怎么改。更贴心的是,每个自动生成的测试用例旁边都有注释,解释 "这个测试是为了验证什么",新手能一边用一边学,慢慢理解测试逻辑。

从团队协作角度看,Cursor 生成的测试用例风格更统一。VSCode 因为插件版本不同、每个人的提示词习惯不同,生成的测试用例会五花八门,合并代码时经常要花时间统一格式。Cursor 有团队级的测试模板设置,能自定义测试用例的风格(比如是否加注释、断言方式用哪种),全团队用同一个标准,减少了协作成本。

💡 总结:Cursor 的优势本质是 "AI-first" vs VSCode 的 "AI-addon"

说到底,Cursor 在 AI 自动生成代码测试方面的优势,根源在于它是 "AI 优先" 设计的编辑器,而 VSCode 是 "插件优先" 然后 "加装 AI"。这种设计理念的不同,导致了两者在测试场景下的体验天差地别。

如果你主要写简单脚本、对测试要求不高,VSCode 加 Copilot 可能够用。但如果是做正经项目开发,需要系统的测试保障,Cursor 的原生 AI 集成、实时响应、预见漏洞、联动调试这些能力,能实实在在帮你提升测试效率,减少漏测风险。

当然,VSCode 也不是全无优势,它的生态和扩展性仍然是顶尖的。但就 AI 自动生成代码测试这一个场景来说,Cursor 确实展现出了更专业、更高效的一面。毕竟,专门为一件事设计的工具,总会比 "什么都能做但什么都靠插件" 的工具,在这件事上做得更好。