🚨 为什么要揪出 AI 写的论文?学术圈快炸锅了

最近审稿子,连续三篇硕士论文都带着一股诡异的 "完美感"—— 逻辑顺得不像话,遣词造句挑不出错,但就是少了点真人思考的 "毛刺"。后来用工具一查,果然都是 AI 深度参与的产物。

这事儿不是个案。某 985 高校去年撤销了 12 篇学位论文,其中 8 篇被证实存在 AI 代写嫌疑。学术诚信这根弦,现在被 AI 技术绷得快要断了。

期刊编辑部现在是真头疼。以前对付抄袭有知网查重,现在 AI 生成的内容能轻松绕过传统查重系统。更要命的是,有些作者会把 AI 生成的内容改改语序、换换同义词,让机器更难识别。

读者可能会问,AI 写的论文只要内容对,有什么关系?错了。学术研究的核心是原创思考,AI 本质是对已有知识的重组,它没法产生真正的学术突破。允许 AI 代写,等于让学术界陷入 "重复制造" 的怪圈。

📜 期刊论文的 AI 检测标准:各有各的规矩

不同期刊对 AI 写作的态度,现在能看出明显的阵营分化。

顶刊态度最坚决。《自然》《科学》这些顶级期刊,去年就更新了作者指南:只要论文中使用了 AI 工具(哪怕只是润色),必须在方法部分详细说明使用的工具名称、使用场景和修改幅度。隐瞒不报的,直接按学术不端处理。

社科类期刊更灵活。《中国社会科学》的新规是:允许使用 AI 辅助收集数据,但禁止 AI 生成核心论点和分析部分。他们的检测重点放在 "论证过程是否符合人类认知逻辑" 上。

行业期刊标准最模糊。很多科技类期刊还在观望,既没明确禁止也没细化规范。这种模糊地带最容易出问题,上个月就有本工程学期刊因为刊登了 AI 生成的虚假实验数据,被迫公开道歉。

值得注意的是,所有期刊都强调 "人工终审" 的必要性。就算通过了 AI 检测工具的筛查,编辑仍有权根据经验判断论文是否存在 "非人类写作特征"。

🔍 主流 AI 论文检测工具对比:谁真有用,谁在忽悠?

现在市面上的 AI 检测工具少说有二十种,实测下来能打的没几个。

GPTZero:老牌选手但误判率高。作为最早火起来的 AI 检测工具,它的原理是分析文本的 "混乱度" 和 "突变率"。优点是免费版就能测 3000 字,缺点是经常把严谨的学术写作误判为 AI 生成。我试过把一篇结构清晰的综述论文放进去,居然给出 85% 的 AI 概率。

Originality.ai:收费但专业。按字数收费,10 美元能测 50000 字。它的优势是能识别 ChatGPT、Claude、文心一言等 10 多种主流大模型的输出。测过一篇混合写作的论文 —— 前半部分人工写,后半部分用 AI 补全,它能精准标出 AI 段落,准确率在 85% 左右。

Copyscape:查重出身,AI 检测是副业。它更擅长找文本相似度,对 AI 生成内容的识别能力一般。但胜在能同步比对全网已发表文献,适合同时查抄袭和 AI。适合预算有限的中小期刊。

Turnitin:学术圈最爱,价格也最贵。很多高校图书馆采购了它的服务,单篇检测费用要几十美元。最新版本加入了 "AI 写作概率" 指标,能和查重报告联动。实测对 0.5 万字以上的长文本识别效果最好,短篇容易出错。

国产工具:知网 AI 检测。今年刚上线,优势是对中文语境的理解更准。试过一篇用 ChatGPT 翻译后修改的论文,国外工具没测出来,它直接标红了 70% 的段落。但数据库更新速度不如国外工具。

💡 实战派检测技巧:光靠工具不够,这些细节才致命

工具只是辅助,真正的高手靠人工就能看出破绽。

看逻辑跳跃点。AI 写东西喜欢 "平滑过渡",但学术论文经常需要 "跳跃式论证"。比如从实验数据到结论,正常作者可能会有 2-3 个推理步骤,AI 则倾向于一步到位,中间缺少必要的 "为什么"。

查专业术语的使用密度。真正的研究者会在关键概念上反复推敲,同一术语的使用频率会有波动。AI 则会平均分配术语,显得很 "均匀" 但不自然。比如一篇讨论 "认知失调" 的论文,某段突然连续 5 句都用这个词,大概率是 AI 写的。

注意参考文献的匹配度。AI 经常编造不存在的参考文献,或者引用的文献和正文内容不相关。有次审稿发现,论文引用了某篇 2025 年的文献,但现在才 2024 年 —— 这种低级错误,真人很少犯。

读开头和结尾。AI 写的开头喜欢用 "随着... 发展" 这类套话,结尾爱说 "未来研究可以..."。真人作者往往会在开头点明研究动机,结尾坦诚不足,这些 "个性化表达" 是 AI 最难模仿的。

检查图表与文本的对应性。AI 生成的文本和图表描述经常 "两张皮"。比如图表显示数据有显著波动,正文却写 "数据保持稳定"。这是因为大模型对图表的理解还很弱。

🤔 学术界的应对:堵不如疏,但底线不能破

现在越来越多的期刊开始采取 "透明化" 策略,而不是一刀切禁止。

强制声明制度。《公共科学图书馆・综合》(PLOS ONE)要求作者在投稿时填写 "AI 工具使用清单",包括工具名称、使用阶段、修改比例。隐瞒的话,轻则撤稿,重则禁投 3 年。

分阶段检测机制。初审用工具快速筛查,复审由领域专家人工复核,终审还要交叉比对作者过往的写作风格。某核心期刊用这种方法,AI 代写检出率提高了 40%。

培养编辑的 "AI 嗅觉"。很多学会开始组织培训,教编辑识别 AI 写作的典型特征。比如 AI 生成的讨论部分,经常过度强调研究的 "普适性",忽视局限性。

调整审稿标准。不再只看 "写得好不好",更看重 "研究过程是否扎实"。要求作者提供原始数据、实验记录、甚至研究日志,从源头上减少 AI 代写的空间。

🔮 未来趋势:检测与生成的猫鼠游戏,我们能赢吗?

这事儿没那么简单,技术迭代太快了。

听说某大模型公司正在测试 "反检测" 功能,生成的文本能模仿人类的 "思维漏洞"。这边检测工具刚升级,那边生成技术就跟着变。

但学术界也不是没招。有期刊开始尝试 "动态检测"—— 同一篇论文在审稿期间要经过 3 次不同工具的检测,防止作者针对性规避。还有高校在探索 "区块链存证",把研究过程的关键节点上链,让 AI 没法凭空捏造。

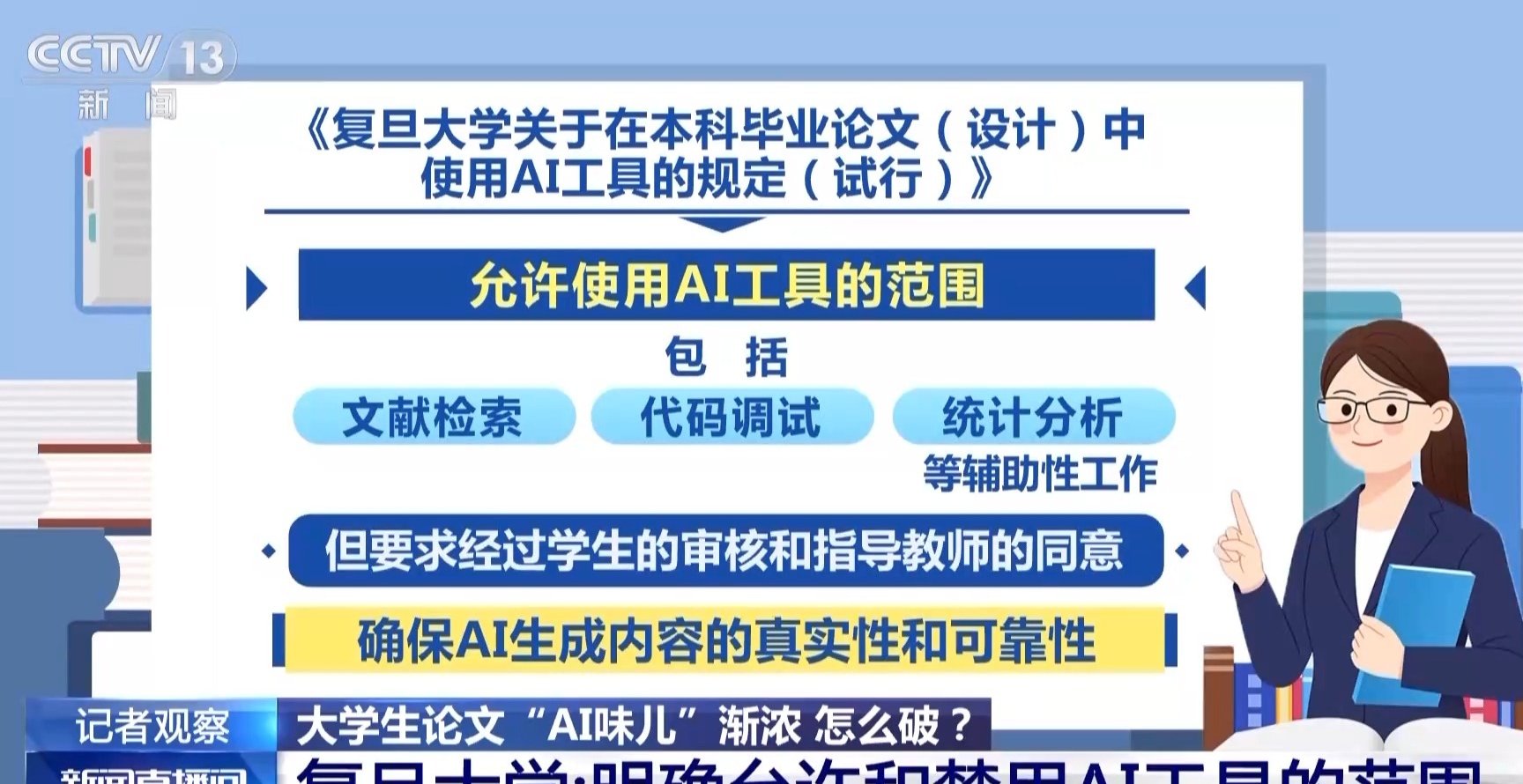

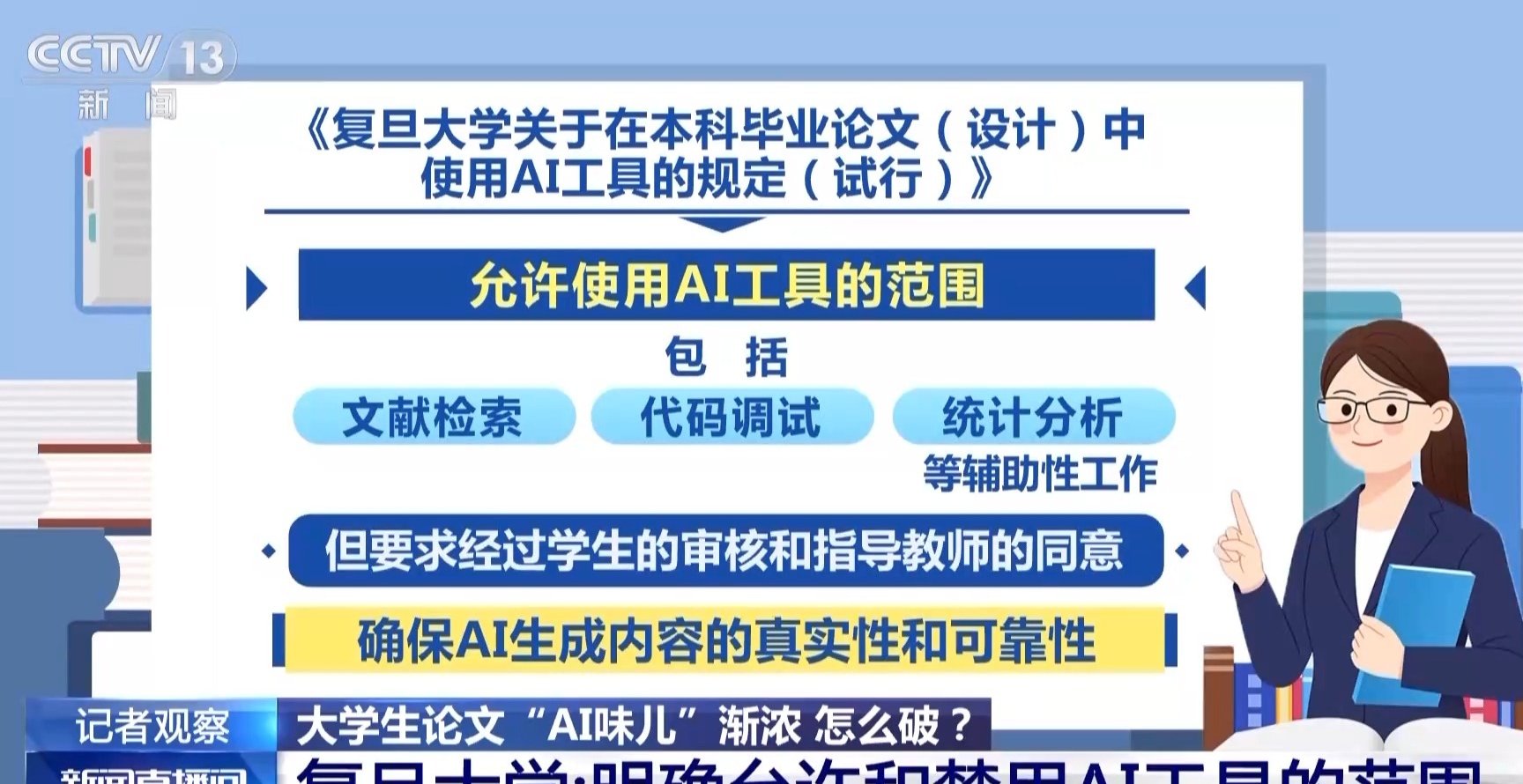

长远看,完全禁止 AI 不现实。就像当年的计算器、Grammarly 一样,AI 最终会成为学术写作的辅助工具。关键是划清红线:哪些能让 AI 做(格式排版、文献初筛),哪些必须人工来(提出问题、设计实验、得出结论)。

作为审稿人,我的原则是:不怕用 AI,就怕藏着掖着。学术的本质是求真,诚实永远比完美更重要。