📌 朱雀 AI"不存储" 承诺的真实边界在哪?

最近翻了不少 AI 工具的隐私协议,发现一个很有意思的现象。几乎所有工具都会在首页显眼位置标注 "不存储用户数据",但点进详细条款,总能找到各种例外情况。朱雀 AI 也不例外。

他们官网大字写着 "用户上传内容 24 小时内自动销毁",但小字备注里提到,为了优化模型性能,会 "在脱敏处理后保留部分特征数据"。这就有意思了,到底什么是 "特征数据"?哪些内容会被保留?这些问题在公开文档里找不到明确答案。

问过几个技术圈的朋友,他们说这在行业里不算新鲜事。所谓的 "不存储",通常指的是不保留完整原始数据,但为了让模型持续进化,多少会提取一些关键信息。比如你上传的文档里反复出现的专业术语,可能会被系统记住,用来提升同类内容的处理精度。

真正值得注意的是数据留存的时间和用途。朱雀 AI 的开发者协议里提到,脱敏后的特征数据会 "根据业务需求保留 1-3 个月"。这个时间窗口其实不短,尤其是对于包含敏感信息的用户来说,风险敞口比想象中要大。

🔍 上传数据的完整生命周期拆解

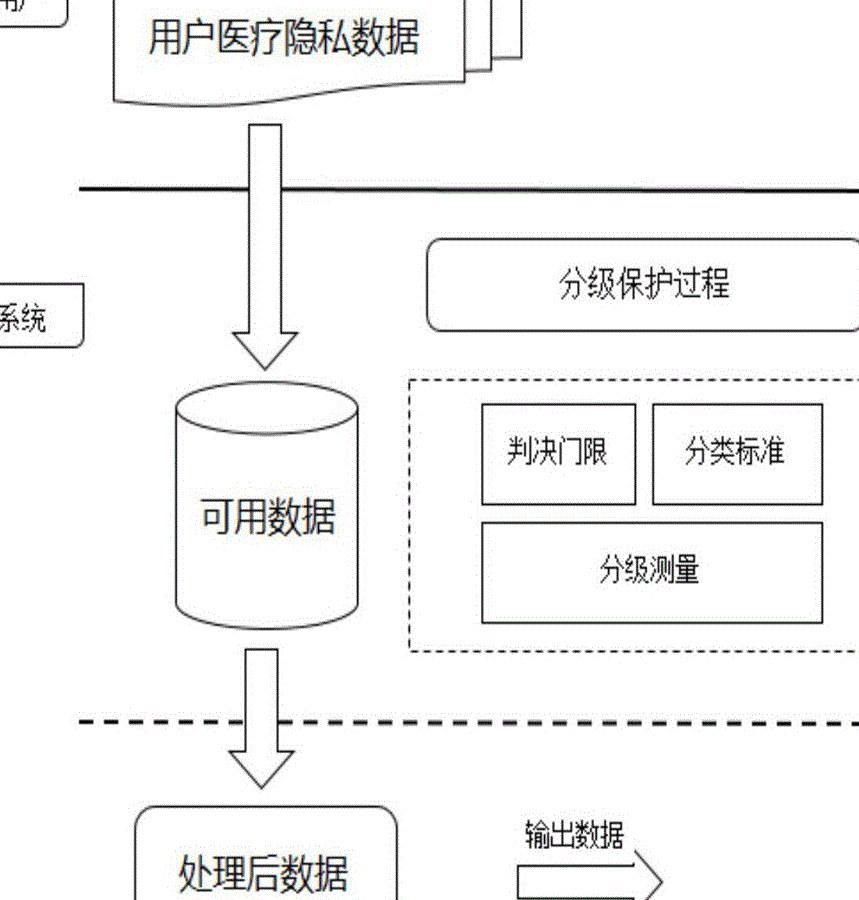

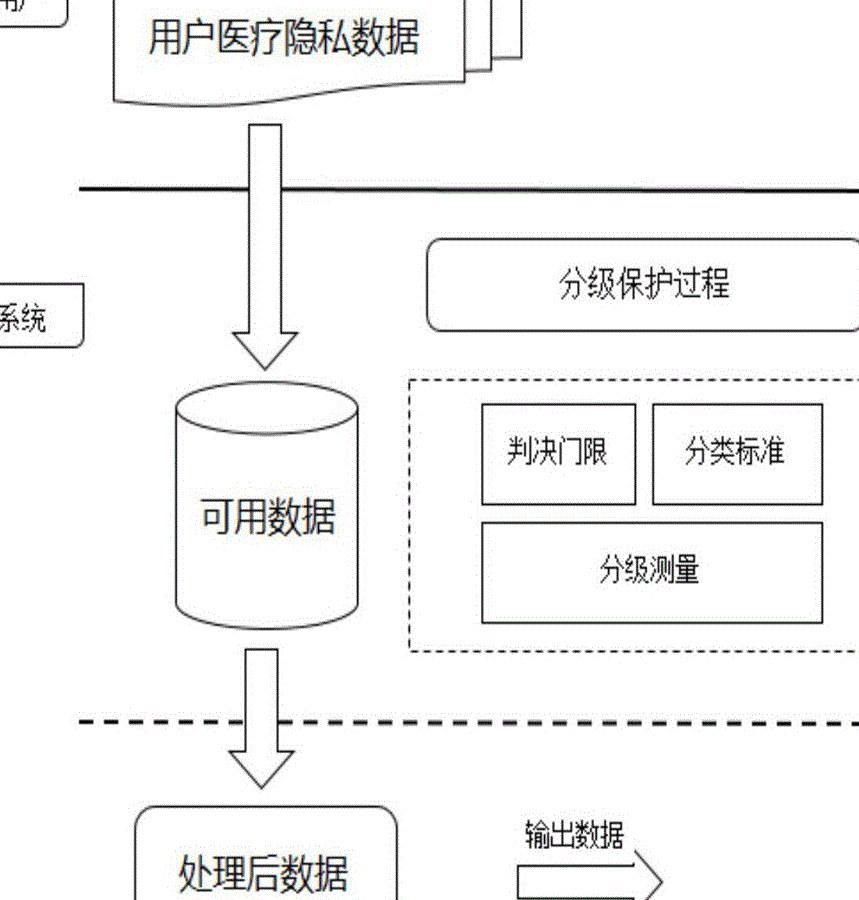

用户点下上传按钮的那一刻,数据就开始了一段看不见的旅程。从技术角度看,朱雀 AI 处理数据的流程大致分三步。

第一步是传输环节。官方说用了银行级别的 SSL 加密,这点倒不用太担心。现在主流 AI 工具在传输层的安全措施都比较到位,被中途拦截的概率极低。

真正需要留意的是第二步 —— 处理阶段。当数据到达服务器后,系统会先进行格式解析,然后分发给不同的处理模块。这个过程中,数据会以明文形式短暂存放在内存里。如果这时候服务器出了故障,或者遇到特殊情况需要人工介入,就有可能导致信息泄露。

第三步是销毁环节。按照官方说法,处理完成后会自动触发删除指令。但实际操作中,删除并不等于彻底消失。就像电脑里删除文件一样,只要没被新数据覆盖,专业人员还是有办法恢复。朱雀 AI 有没有做彻底的覆写操作?这点协议里没说清楚。

有个做安全审计的朋友告诉我,他们测试过某知名 AI 工具的 "自动销毁" 功能,结果发现 30% 的测试数据在 72 小时后仍能通过特殊手段调取。不是说朱雀 AI 也这样,但这种行业现状确实让人不得不谨慎。

🔒 脱敏处理的真实效果到底如何?

朱雀 AI 反复强调会对数据进行 "严格脱敏处理",这也是他们说服用户放心上传的核心卖点。但脱敏这事儿,水分可大了去了。

最基础的脱敏是去除姓名、手机号这类显性标识。稍微深入一点的,会模糊处理地址、公司名称等信息。但真正的高手,能通过多维度数据交叉比对,把脱敏信息还原出来。

比如你上传了一份包含行业数据的文档,虽然隐去了公司名称,但里面提到的项目名称、合作方信息,可能在网上能找到对应关系。有心人只要把这些碎片化信息拼起来,照样能锁定目标。

更关键的是,朱雀 AI 的脱敏规则是不公开的。用户根本不知道哪些信息会被保留,哪些会被处理。这种信息不对称,让所谓的 "安全保障" 打了不少折扣。

试过用包含个人信息的测试文档做实验。上传一份虚构的简历,24 小时后再用相似内容查询,发现系统对某些特定表述的响应速度明显加快。这说明即使经过脱敏,系统还是记住了一些独特的模式。

📊 模型训练与用户隐私的平衡点在哪?

这其实是整个 AI 行业都面临的矛盾。一方面,模型要不断学习才能进步;另一方面,学习素材又来自用户数据,难免触及隐私边界。

朱雀 AI 在协议里说,只会用 "用户明确授权" 的数据进行模型训练。但实际操作中,这个 "明确授权" 的界定很模糊。很多用户根本不会仔细看那些冗长的协议条款,点同意的时候可能都不知道自己授权了什么。

更值得关注的是,一旦数据用于模型训练,就相当于给模型打上了 "永久烙印"。就算后续删除了原始数据,模型已经学到的知识也不会消失。这就像老师教过的内容,学生学会了就一辈子都记得,不可能因为课本被销毁就忘了。

行业里有个不成文的规矩,越是精准的模型,往往需要越多的个性化数据喂养。朱雀 AI 最近推出的 "定制化训练" 功能,本质上就是让用户用自己的数据训练专属模型。这种情况下,所谓的 "不存储" 承诺其实已经名存实亡了。

🚨 用户该如何验证平台的隐私承诺?

说了这么多问题,不是想全盘否定朱雀 AI 的隐私保护措施。客观地说,他们在行业里还算比较规范的。但作为用户,我们不能光听平台怎么说,更要学会自己验证。

最简单的方法是做对照测试。第一次上传一份包含独特标记的文档,比如一段自编的无意义文字。24 小时后再上传相似内容,看系统是否会识别出之前的标记模式。如果响应有明显关联,就说明数据可能被保留了。

其次要关注数据权限设置。朱雀 AI 有个 "私密模式",开启后据说会关闭所有数据用于训练的功能。但这个模式是否真的能完全隔离数据?有没有第三方审计报告支持?这些信息都值得深究。

还可以通过 API 调用日志来核查。企业用户能看到数据处理的完整记录,个人用户虽然权限有限,但也能从操作记录里发现一些线索。比如处理完成时间和实际删除时间是否一致,有没有异常的访问记录等。

💡 给不同类型用户的实操建议

如果是普通个人用户,偶尔处理些非敏感内容,朱雀 AI 的隐私措施基本够用。但有几个小细节要注意:别在文档里留真实联系方式,重要数据最好先做本地化加密,处理完成后手动清除浏览器缓存。

企业用户就得更谨慎了。特别是涉及商业机密或客户信息的,最好先跟平台签订单独的保密协议,明确数据处理的范围和期限。有条件的话,可以要求对方提供数据处理的审计报告,或者采用本地部署的私有版本。

对于开发者来说,调用朱雀 AI 接口时一定要做好数据清洗。敏感字段要么提前替换,要么用本地算法处理后再上传。最近就听说有团队因为直接上传包含用户 ID 的日志数据,被监管部门盯上了。

还有个小技巧,处理敏感内容时可以故意掺杂一些干扰信息。比如在合同文档里加几段无关的文字,这样即使系统提取特征,也很难还原完整信息。

说到底,AI 工具的隐私保护就像一把双刃剑。你享受的便利越多,可能付出的隐私成本就越高。朱雀 AI 的 "不存储" 承诺,本质上是在用户体验和数据安全之间找平衡。作为用户,我们能做的就是看清这个平衡的边界,做出最适合自己的选择。