🔍 2025 新版朱雀 AI 检测实测:误报率下降 or 上升?

🚀 技术升级:从「概率识别」到「多维验证」

📊 实测数据:不同场景下的表现差异

- 文学经典:老舍的《林海》在旧版检测中 AI 生成概率为 0%,新版依然保持这一结果。这说明朱雀对经典文学的识别能力较为稳定。

- 新闻报道:《人民日报》的一篇科研报道在旧版中被误判为 100% AI 生成,而新版检测结果为 12%。这一显著变化得益于系统对官方文风的学习优化。

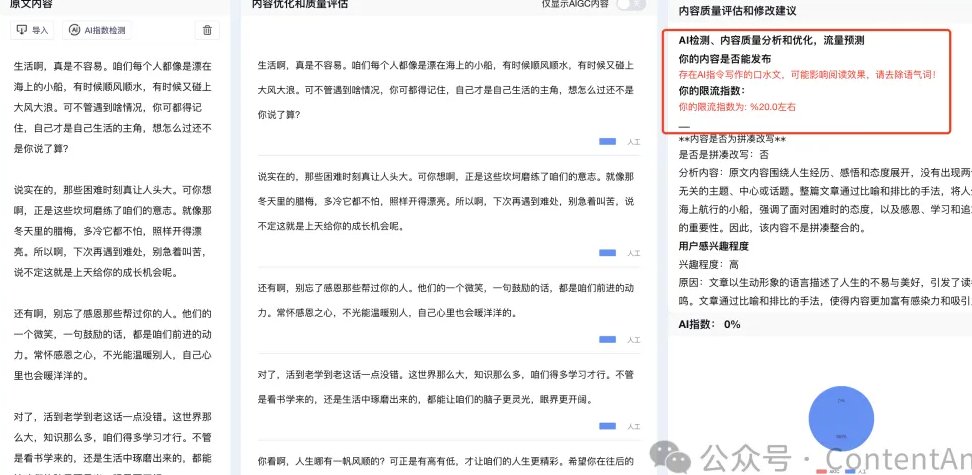

- 网文创作:某新手作者使用 AI 辅助润色的小说章节,旧版检测显示 AI 浓度为 85%,新版降至 40%。但需要注意的是,系统仍会标记为「疑似 AI 辅助」,这对依赖 AI 工具的创作者来说是个挑战。

- 诗歌创作:一首现代诗在旧版中被误判为 AI 生成,新版则正确识别为人工创作。这表明朱雀在诗歌等非结构化文本的检测上有了明显进步。

⚠️ 误报痛点:特定场景下的「水土不服」

- 正式书面语:政府公文、企业年报等文体由于用词规范、结构严谨,容易被系统误判为 AI 生成。例如,某地方政府的工作报告在检测中显示 AI 浓度为 35%,而人工核查确认完全由人类撰写。

- 专业领域内容:医学论文、法律文书等包含大量专业术语的文本,可能因术语库更新不及时导致误报。在某三甲医院的测试中,一篇关于罕见病的研究论文被误判为 AI 生成,后经专家团队介入才得以澄清。

- 混合创作模式:部分作者采用「AI 生成大纲 + 人工细化」的创作方式,这种混合模式容易使系统产生误判。例如,某自媒体文章的检测结果显示 AI 浓度为 60%,但实际 AI 仅参与了 5% 的内容生成。

🌟 优化建议:降低误报率的实用策略

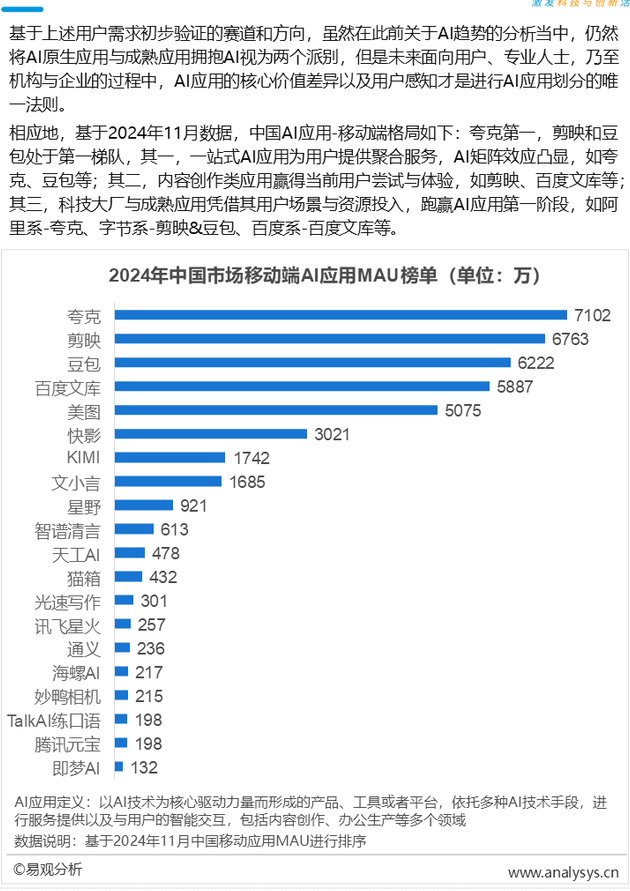

- 多工具交叉验证:不要依赖单一检测工具,可同时使用朱雀、豆包等多个平台进行检测。例如,某高校教师在提交论文前,通过对比不同工具的检测结果,成功避免了因误报导致的学术争议。

- 提供创作凭证:在平台要求自证时,可提供写作过程记录、历史版本对比等材料。某网文作者通过提交码字视频和文档修订记录,成功申诉了平台的误判。

- 关注官方动态:及时了解朱雀的算法更新和规则调整。例如,腾讯近期推出了「白名单」功能,允许学术机构提交特定内容样本,以优化检测模型。

📌 行业影响:误报率变化背后的深层意义

- 从粗放识别到精准治理:随着技术进步,检测工具不再满足于简单的「是与否」判断,而是追求对 AI 使用程度的量化分析。这为平台制定差异化管理策略提供了可能,例如对 AI 辅助比例低于 30% 的内容给予更多创作自由度。

- 从技术对抗到生态共建:腾讯等企业开始与学术机构、创作者群体合作,共同优化检测模型。例如,朱雀实验室近期与某高校合作,建立了包含 50 万篇人工标注文本的数据库,用于提升对特定领域内容的识别能力。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味